自动驾驶大模型---预测&决策&规划的可解释性

Hint-AD提出了一种新型端到端自动驾驶语言系统,通过自然语言增强模型可解释性。该框架整合感知-预测-规划模块的中间查询token,经整体令牌混合器处理后输入语言解码器,实现与AD模型的整体对齐。实验表明,在驾驶解释、3D密集描述等任务中性能显著提升(CIDEr指标最高提升185%),同时发布了Nu-X标注数据集。尽管该方案在可解释性方面取得突破,但量产部署面临算力消耗增加的挑战。研究为平衡模型

1 前言

截止到目前为止,端到端模型的可解释性仍然是一个待解决的问题(当前更多企业通过LLM的思维链来表征推理过程)。因此有些模型在设计时考虑使用BEV Feature作为解码器的输入,这样其实有点像两段式的模型,但可解释性经过BEV Feature的那一层,也增加了不少。

本篇博客笔者介绍一篇论文,旨在增加模型的可解释性。端到端的感知-规划架构在自动驾驶(AD)和通用具身智能领域中至关重要,因为它具有使用大量数据进行自监督训练的潜力。然而,这些系统面临着重大的可解释性挑战,尤其是在具身智能问题(如自动驾驶)中。当AD系统直接输出控制信号时,人类乘客很难信任这些决策。为了解决这一问题,自然语言作为一种高度用户友好的沟通媒介,被用于通过驾驶解释、3D密集描述和视觉问答(VQA)等任务来增强可解释性。

2 Hint-AD

可解释性问题在像 AD 这样的具身智能问题中尤为突出。 当 AD 系统直接输出控制信号时,人类乘客很难信任这些决定。 为了解决这个问题,自然语言作为一种高度用户友好的交流媒介,已被探索用于通过驾驶解释、3D 稠密字幕和视觉问答 (VQA) 等任务来增强可解释性。 虽然人类驾驶员认识到鸟瞰图 (BEV) 轨迹作为对 WHAT 正在发生解释的价值,但语言提供了对 WHY 正在发生的补充视角。 这些方法可以根据一个标准分为 声明式 可解释性和 对齐 可解释性:生成的语言是否与 AD 系统的中间输出对齐。

论文介绍了一种新的端到端自动驾驶(AD)语言系统,名为Hint-AD。这个系统旨在通过自然语言提高自动驾驶模型的可解释性,从而增强人类对AI的信任。

2.1 模型架构

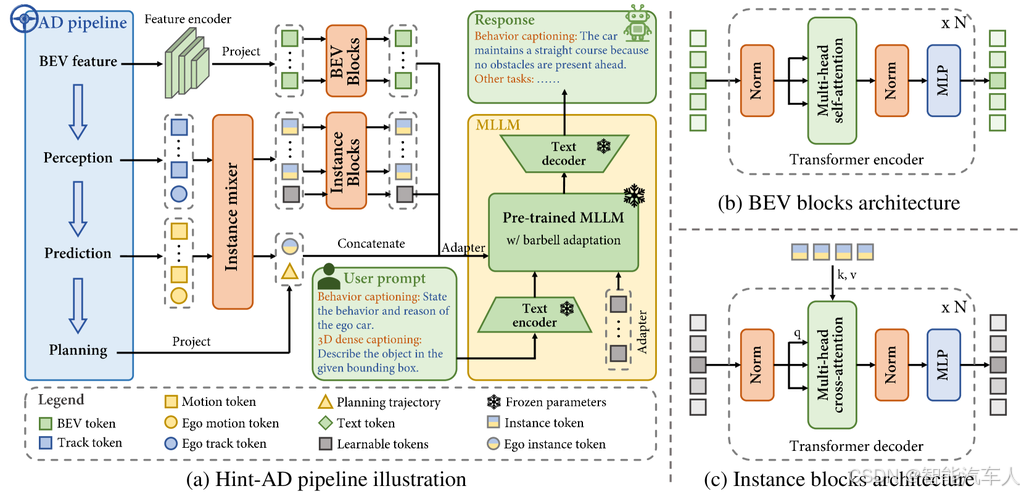

首先,从感知 - 预测 - 规划架构的现有自动驾驶模型中提取中间查询 token,得到轨迹 token、运动 token 和规划 token。其次,整体 token 混合器模块会对这些 token 进行调整,以作为语言解码器的输入。在该模块中,设计了实例混合器,用于融合每个检测实例的实例级轨迹和运动信息。还引入了鸟瞰图(BEV)块和实例块,用于进一步提取特征,并将长度可变的实例 token 转换为固定长度。所有处理后的 token 会被拼接为上下文 token,用于文本生成。最后,上下文 token 会被构造成提示 token,并与文本提示一起输入到语言解码器中。我们采用杠铃适配范式,以帮助语言解码器有效理解上下文。

Hint-AD框架包括三个主要模块:整体令牌混合器、语言解码器和AD框架。其中主要的两个特点如下:

- 提出了Hint-AD框架,它与AD模型的感知-预测-规划过程进行整体对齐,以提高语言生成的准确性并促进自动驾驶的可解释性。

- 开发了两种方法来实现语言与AD模型的整体对齐和语言输出的准确性:(a) 整体令牌混合器模块,适配AD模型的中间输出token,为语言解码器提供输入,专注于稳健的特征提取和融合;(b) 引入了一项对齐任务作为在线数据集,使语言解码器在训练过程中解释AD模型推理过程中的中间token。

2.2 实验结果

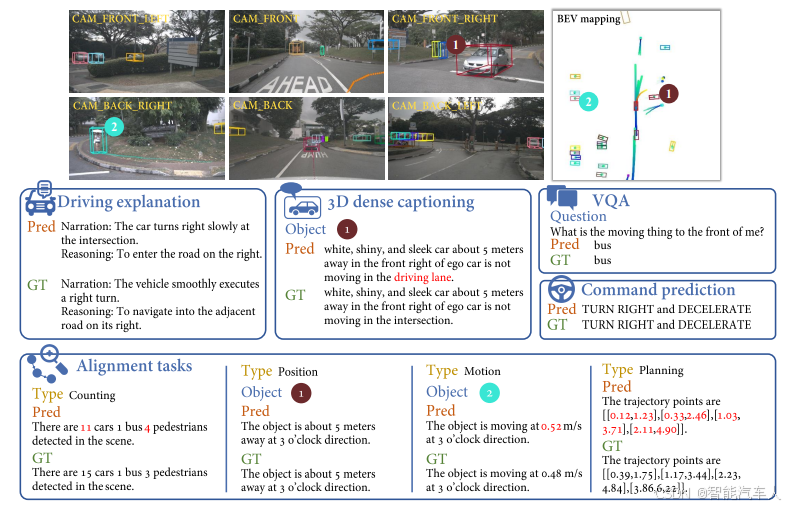

Hint-AD在多个语言任务中取得了最先进的性能,包括驾驶解释(在CIDEr上比基线提高了20.4%)、3D密集字幕(在CIDEr上比基线提高了185%)、视觉问答(准确率提高了1.2%)和驾驶命令预测(准确率提高了1.2%)。对齐任务显著提高了语言输出与AD模型中间表示之间的一致性。

3 总结

Hint-AD通过整合中间输出和有效的特征适配,实现了高精度的语言生成,从而促进了自动驾驶的可解释性。此外,研究者还为nuScenes数据集贡献了一个人工标注的驾驶解释数据集Nu-X,以支持进一步的研究。

从量产的角度来看,这种思路不太实用,现有的头部主流自动驾驶框架已经是一个大模型,如果再增加一个解释性模型,将消耗更多的算力。如果研究人员能在现有模型的基础之上,增加每一个环节的可解释性也是一项不错的工作。

参考论文:

《Hint-AD: Holistically Aligned Interpretability in End-to-End Autonomous Driving》

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)