AI应用架构师进阶:如何打造高ROI的企业AI运营体系?

业务需求 vs 技术实现:如何将“提升客单价5%”的业务目标转化为“模型精准率≥85%、推理延迟≤100ms”的技术指标?模型效果 vs 运维成本:如何在保证模型性能的同时,降低监控、迭代的人力/算力消耗?短期试点 vs 长期规模化:如何让单个场景的成功经验复制到全企业,避免“重复造轮子”?企业AI运营体系(Enterprise AI Operations, EAIOps):覆盖“业务需求→数据管

AI应用架构师进阶指南:打造高ROI企业AI运营体系的方法论与实践

元数据框架

标题:AI应用架构师进阶指南:打造高ROI企业AI运营体系的方法论与实践

关键词:企业AI运营体系、ROI优化、模型全生命周期管理、MLOps 2.0、业务价值对齐、算力资源调度、AI伦理与安全

摘要:

当企业从“AI试点成功”走向“规模化价值落地”时,高ROI的AI运营体系成为区分领先者与跟随者的核心壁垒。本文从AI应用架构师的视角出发,结合第一性原理与商业-技术双轮驱动思维,系统拆解企业AI运营体系的底层逻辑:从“业务价值量化”的理论框架,到“全链路闭环”的架构设计,再到“算力优化、模型监控、跨部门协同”的实现细节。通过真实案例与可落地工具链,帮助架构师突破“重技术轻商业”的陷阱,构建“能赚钱、能持续、能扩展”的AI运营能力。

1. 概念基础:从“项目制AI”到“运营制AI”的认知升级

要打造高ROI的AI运营体系,首先需要澄清核心概念的边界,并理解企业AI落地的历史演变规律。

1.1 领域背景:企业AI的“规模化陷阱”

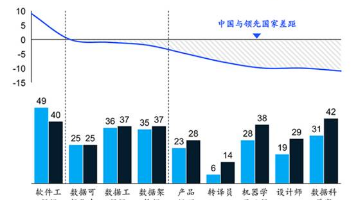

根据麦肯锡2023年《全球AI现状报告》,80%的企业已完成AI试点,但仅15%实现规模化价值。常见的“陷阱”包括:

- 业务对齐偏差:模型 accuracy 很高,但无法解决真实业务痛点(比如推荐系统“精准推荐但不提升转化率”);

- 运维成本高企:模型上线后需持续投入人力监控漂移、修复BUG,成本超过收益;

- 资源浪费严重:算力按需分配混乱、数据重复存储、模型版本管理失控;

- 价值无法量化:AI带来的“用户体验提升”“风险降低”等间接价值无法转化为可考核的ROI。

这些问题的根源,在于企业仍用**“项目制”思维做AI**——将AI视为“一次性交付的软件”,而非“持续产生价值的运营资产”。

1.2 历史轨迹:AI运营体系的演化

企业AI的运营模式经历了三个阶段:

- 1.0 阶段(2015-2018):实验驱动。以数据科学家为主导,聚焦模型开发(比如用TensorFlow训练一个图像分类模型),无标准化运维流程;

- 2.0 阶段(2019-2022):MLOps 普及。引入“模型全生命周期管理”(开发→训练→部署→监控→迭代),解决“模型上线难”问题,但未深度关联业务价值;

- 3.0 阶段(2023至今):业务-技术双轮驱动。将AI运营体系与企业核心KPI(如收入增长、成本降低、用户留存)绑定,强调“ROI闭环”与“规模化复制”。

1.3 问题空间定义:高ROI AI运营体系的核心矛盾

高ROI的本质是**“价值最大化”与“成本最小化”的平衡**,对应的核心矛盾包括:

- 业务需求 vs 技术实现:如何将“提升客单价5%”的业务目标转化为“模型精准率≥85%、推理延迟≤100ms”的技术指标?

- 模型效果 vs 运维成本:如何在保证模型性能的同时,降低监控、迭代的人力/算力消耗?

- 短期试点 vs 长期规模化:如何让单个场景的成功经验复制到全企业,避免“重复造轮子”?

1.4 术语精确性:关键概念的定义

为避免歧义,本文统一以下术语:

- 企业AI运营体系(Enterprise AI Operations, EAIOps):覆盖“业务需求→数据管理→模型开发→部署监控→价值度量→迭代优化”的全链路闭环系统,核心目标是“持续输出可量化的业务价值”;

- ROI(Return on Investment):AI项目的净收益/总投入,其中净收益=(收入提升+成本降低)- 直接投入(算力、人力、数据)- 间接投入(运维、风险);

- 模型漂移(Model Drift):模型上线后,因数据分布变化(数据漂移)或业务逻辑变化(概念漂移)导致性能下降的现象;

- MLOps 2.0:在传统MLOps基础上,增加“业务价值对齐”与“资源动态调度”模块的新一代运营框架。

2. 理论框架:用第一性原理拆解高ROI的底层逻辑

高ROI的AI运营体系并非“堆砌工具”,而是基于商业本质的逻辑推导。我们用第一性原理(回归最基本的公理,从源头解决问题)拆解其核心公式。

2.1 第一性原理推导:ROI的数学表达式

ROI的本质是“投入产出比”,其数学形式可拆解为:

ROI=AI产生的净业务价值AI项目总投入=V−CC=VC−1 \text{ROI} = \frac{\text{AI产生的净业务价值}}{\text{AI项目总投入}} = \frac{V - C}{C} = \frac{V}{C} - 1 ROI=AI项目总投入AI产生的净业务价值=CV−C=CV−1

其中:

- V(Value):AI带来的业务价值,包括直接价值(如推荐系统提升的销售额)和间接价值(如预测性维护降低的停机成本、风控模型减少的坏账损失);

- C(Cost):AI项目的总投入,包括固定成本(算力集群、数据存储)和可变成本(数据标注、模型训练/推理、运维人力)。

要提升ROI,需同时做两件事:最大化V(让AI更贴近业务核心)、最小化C(用技术手段降低运营成本)。

2.2 价值端:如何量化AI的业务价值?

很多企业的AI项目失败,根源在于无法精准量化V。我们需要建立“业务目标→技术指标→价值归因”的三级映射体系:

2.2.1 第一步:对齐业务目标(OKR法)

用**OKR(Objectives and Key Results)**将企业战略拆解为AI可落地的目标。例如:

- 企业目标(O):2024年零售业务收入增长20%;

- AI关键结果(KR):

- 推荐系统将转化率从3%提升至5%(对应收入增长≈1.6亿);

- 库存预测模型将缺货率从8%降至3%(对应成本降低≈2000万)。

2.2.2 第二步:转化为技术指标(SMART法)

将KR转化为可衡量、可实现的技术指标。例如:

- 推荐系统的KR“转化率提升至5%”→ 技术指标:

- 模型精准率(Precision)≥85%(推荐的商品中用户购买的比例);

- 推理延迟≤100ms(用户点击后需快速返回结果);

- 覆盖率≥90%(覆盖90%以上的活跃用户)。

2.2.3 第三步:价值归因(因果推断法)

避免“将自然增长归因于AI”的误区,需用因果推断分离AI的真实价值。常用方法包括:

- A/B测试:将用户分为实验组(用AI推荐)和对照组(不用),对比转化率差异;

- 合成控制法:用历史数据构建“没有AI的虚拟企业”,对比真实企业与虚拟企业的收入差异;

- 归因模型:比如“多触点归因”(计算推荐系统在用户购买决策中的贡献占比)。

2.3 成本端:如何系统性降低AI运营成本?

AI的成本主要来自数据、算力、人力三大模块,我们逐一拆解优化方法:

2.3.1 数据成本优化:从“数据采集”到“数据复用”

- 避免“数据囤积症”:只采集与业务目标强相关的数据(比如推荐系统无需采集用户的手机型号,除非与商品偏好相关);

- 构建数据资产库:将特征工程结果(如“用户最近7天浏览次数”)存储为可复用的特征向量,避免重复计算(例如用Feast或Tecton搭建特征平台);

- 采用联邦学习:在不共享原始数据的情况下联合训练模型(比如银行间联合做风控),降低数据采集成本与隐私风险。

2.3.2 算力成本优化:从“按需分配”到“动态调度”

- 模型压缩技术:用**量化(Quantization)将FP32模型转为INT8,显存占用减少75%,推理速度提升3-5倍;用蒸馏(Distillation)**用大模型训练小模型(比如用GPT-3训练一个轻量级对话模型);

- 算力调度策略:用Kubernetes或Ray做分布式训练/推理,闲时将算力分配给离线训练,忙时分配给在线推理;采用Spot Instance(云厂商的闲置算力),成本比按需实例低60%-90%;

- 边缘推理:将轻量级模型部署在边缘设备(比如工厂的传感器、零售的POS机),减少云端算力消耗(例如用TensorRT部署YOLO模型在 Jetson Nano上)。

2.3.3 人力成本优化:从“人工运维”到“自动化运营”

- 自动化Pipeline:用Kubeflow或MLflow搭建端到端的模型开发Pipeline,自动完成数据清洗、特征工程、模型训练、评估(比如当新数据到来时,自动触发模型重新训练);

- 智能监控系统:用Prometheus+Grafana搭建模型性能监控Dashboard,自动检测数据漂移(用PSI指标)、模型漂移(用F1-score下降阈值),并触发告警(比如当PSI>0.2时,自动通知数据科学家);

- 低代码工具:用AutoML工具(比如Google AutoML、DataRobot)降低模型开发的技术门槛,让业务人员也能参与简单模型的训练。

2.4 理论局限性:ROI量化的边界

需明确:并非所有AI价值都能量化。例如:

- 用户体验提升:AI客服减少用户等待时间,但“用户满意度”难以直接转化为收入;

- 风险规避:反欺诈模型阻止了一笔100万的欺诈交易,但无法统计“未发生的损失”;

- 战略布局:大模型的研发投入可能在3年内无法产生直接收益,但能建立技术壁垒。

应对方法:将量化指标与定性评估结合,比如用NPS(净推荐值)衡量用户体验,用“风险覆盖率”衡量反欺诈效果,用“技术专利数量”衡量战略价值。

3. 架构设计:高ROI AI运营体系的组件与交互模型

基于上述理论框架,我们设计**“六层闭环”的EAIOps架构**(图1),覆盖从业务需求到价值输出的全链路。

3.1 系统分解:六层核心组件

EAIOps架构分为以下六层(从业务到技术,逐层落地):

| 层级 | 核心功能 | 关键工具/标准 |

|---|---|---|

| 业务对齐层 | 将企业战略转化为AI可执行的目标与指标(OKR映射) | OKR工具(飞书OKR、Worktile) |

| 数据管理层 | 数据采集、存储、清洗、特征工程与复用 | 数据湖(AWS S3、Databricks)、特征平台(Feast) |

| 模型全生命周期层 | 模型开发、训练、部署、监控、迭代(MLOps 2.0) | Kubeflow、MLflow、Seldon Core |

| 算力资源层 | 算力调度、模型压缩、边缘推理 | Kubernetes、Ray、TensorRT |

| 运营监控层 | 模型性能监控、业务价值监控、异常告警 | Prometheus、Grafana、AIOps平台 |

| 价值度量层 | ROI计算、价值归因、场景优先级排序 | 商业智能工具(Tableau、Power BI) |

3.2 组件交互模型:闭环迭代的逻辑

六层组件的交互遵循**“需求输入→技术实现→价值输出→反馈迭代”**的闭环(图2,Mermaid流程图):

graph TD

A[业务对齐层:输入OKR目标] --> B[数据管理层:输出特征向量]

B --> C[模型全生命周期层:输出部署模型]

C --> D[算力资源层:输出推理服务]

D --> E[运营监控层:监控性能与业务指标]

E --> F[价值度量层:计算ROI与归因]

F --> A[业务对齐层:反馈迭代目标]

关键交互场景示例:

- 业务对齐层输入“推荐转化率提升至5%”的目标;

- 数据管理层从用户行为日志中提取“最近7天浏览次数”“购买历史”等特征,输出特征向量;

- 模型全生命周期层用这些特征训练推荐模型(比如协同过滤+Transformer),部署到K8s集群;

- 算力资源层用TensorRT优化模型推理,将延迟从200ms降至80ms;

- 运营监控层监控推荐系统的转化率(实时)、推理延迟(实时)、数据漂移(每日);

- 价值度量层计算ROI(比如投入200万,收入增加1000万,ROI=400%),并反馈“转化率已达标,但高价值用户的覆盖率不足”,驱动业务对齐层调整目标(比如“高价值用户覆盖率提升至80%”)。

3.3 可视化:EAIOps架构的Mermaid图表

为更直观展示架构,我们用Mermaid绘制分层架构图:

3.4 设计模式应用:复用成熟的架构经验

EAIOps架构可复用以下经典设计模式,减少试错成本:

3.4.1 微服务模式(Microservices)

将模型部署为独立的微服务(比如推荐服务、风控服务),通过API网关(如Nginx、Kong)对外提供接口。优势:

- 独立扩容:推荐服务流量高峰时,可单独增加实例;

- 快速迭代:修改推荐模型不会影响风控服务;

- 易集成:与企业现有系统(ERP、CRM)通过API对接。

3.4.2 事件驱动模式(Event-Driven)

用消息队列(如Kafka、RabbitMQ)触发模型迭代。例如:

- 当用户行为数据达到10万条时,Kafka发送事件,触发模型重新训练;

- 当模型漂移超过阈值时,发送告警事件,通知数据科学家处理。

3.4.3 分层存储模式(Tiered Storage)

将数据分为热数据(最近7天的用户行为数据,存放在内存数据库如Redis)、温数据(最近30天的数据,存放在SSD)、冷数据(超过30天的数据,存放在对象存储如S3)。优势:降低存储成本(冷数据成本仅为热数据的1/10),同时保证查询性能。

4. 实现机制:从架构到代码的落地细节

本节通过推荐系统的真实案例,讲解EAIOps架构的实现细节,包括算法优化、代码示例、边缘情况处理。

4.1 案例背景:某零售企业的推荐系统

业务目标:将电商平台的推荐转化率从3%提升至5%,ROI≥300%;

技术约束:推理延迟≤100ms,支持10万QPS(每秒查询量);

数据基础:用户行为日志(浏览、点击、购买)、商品属性数据(分类、价格、销量)。

4.2 算法复杂度分析与优化

推荐系统的核心算法是协同过滤(CF)+ Transformer,但直接使用会导致高算力消耗(Transformer的时间复杂度为O(n2)O(n^2)O(n2),n为序列长度)。我们做了以下优化:

4.2.1 特征降维(Dimensionality Reduction)

用**PCA(主成分分析)**将用户特征从100维降维到50维,商品特征从80维降维到40维,减少模型参数数量(从10080=8000降至5040=2000),训练时间缩短60%。

4.2.2 稀疏矩阵优化

用户行为数据是稀疏矩阵(大部分用户未浏览大部分商品),用**CSR(Compressed Sparse Row)**格式存储,内存占用减少90%(例如,1亿条用户行为数据,CSR格式仅需1GB内存,而稠密矩阵需100GB)。

4.2.3 分布式训练(Distributed Training)

用Ray做分布式数据并行训练(Data Parallel),将训练数据分成10份,分配给10个GPU节点,训练时间从24小时缩短至2小时。

4.3 优化代码实现:从训练到推理

以下是推荐模型的核心代码示例(基于PyTorch+Ray),包含训练、压缩、推理三个环节:

4.3.1 训练代码(Ray分布式训练)

import ray

from ray import tune

import torch

import torch.nn as nn

from torch.utils.data import Dataset, DataLoader

# 1. 初始化Ray集群

ray.init(address="auto")

# 2. 定义推荐模型(CF+Transformer)

class RecommendationModel(nn.Module):

def __init__(self, user_dim=50, item_dim=40, hidden_dim=64):

super().__init__()

self.user_emb = nn.Embedding(100000, user_dim) # 10万用户

self.item_emb = nn.Embedding(10000, item_dim) # 1万商品

self.transformer = nn.TransformerEncoderLayer(

d_model=user_dim+item_dim, nhead=4, dim_feedforward=hidden_dim

)

self.fc = nn.Linear(user_dim+item_dim, 1) # 输出点击率预测

def forward(self, user_id, item_id):

user_emb = self.user_emb(user_id)

item_emb = self.item_emb(item_id)

x = torch.cat([user_emb, item_emb], dim=1)

x = self.transformer(x.unsqueeze(0)).squeeze(0)

return torch.sigmoid(self.fc(x))

# 3. 定义数据集

class UserItemDataset(Dataset):

def __init__(self, user_ids, item_ids, labels):

self.user_ids = user_ids

self.item_ids = item_ids

self.labels = labels

def __len__(self):

return len(self.user_ids)

def __getitem__(self, idx):

return self.user_ids[idx], self.item_ids[idx], self.labels[idx]

# 4. 分布式训练函数

def train_model(config):

# 加载数据(从Feast特征平台获取)

from feast import FeatureStore

store = FeatureStore(repo_path="./feature_repo")

features = store.get_online_features(

features=["user:recent_7d_browse_count", "item:sales_rank"],

entity_rows=[{"user_id": i} for i in range(100000)]

).to_df()

# 构建数据集

dataset = UserItemDataset(

user_ids=features["user_id"].values,

item_ids=features["item_id"].values,

labels=features["click_label"].values

)

dataloader = DataLoader(dataset, batch_size=config["batch_size"], shuffle=True)

# 初始化模型与优化器

model = RecommendationModel()

optimizer = torch.optim.Adam(model.parameters(), lr=config["lr"])

criterion = nn.BCELoss()

# 训练循环

for epoch in range(config["epochs"]):

for batch in dataloader:

user_id, item_id, label = batch

optimizer.zero_grad()

pred = model(user_id, item_id)

loss = criterion(pred.squeeze(), label.float())

loss.backward()

optimizer.step()

tune.report(loss=loss.item())

# 5. 超参数搜索(用Ray Tune)

config = {

"batch_size": tune.choice([64, 128, 256]),

"lr": tune.loguniform(1e-4, 1e-2),

"epochs": 10

}

analysis = tune.run(

train_model,

config=config,

resources_per_trial={"gpu": 1}, # 每个 trial 分配1个GPU

num_samples=5 # 搜索5组超参数

)

# 6. 保存最优模型

best_model = RecommendationModel()

best_model.load_state_dict(torch.load(analysis.best_checkpoint()))

torch.save(best_model.state_dict(), "best_recommendation_model.pt")

4.3.2 模型压缩(TensorRT量化)

用TensorRT将PyTorch模型量化为INT8,减少显存占用与推理延迟:

import torch

from torch2trt import torch2trt

# 加载PyTorch模型

model = RecommendationModel()

model.load_state_dict(torch.load("best_recommendation_model.pt"))

model.eval()

# 生成示例输入(用户ID=123,商品ID=456)

input_user = torch.tensor([123], dtype=torch.int32)

input_item = torch.tensor([456], dtype=torch.int32)

# 将模型转换为TensorRT引擎(INT8量化)

model_trt = torch2trt(

model,

[input_user, input_item],

fp16_mode=False,

int8_mode=True,

int8_calib_dataset=dataloader # 校准数据集用于INT8量化

)

# 保存TensorRT引擎

torch.save(model_trt.state_dict(), "recommendation_model_trt.pt")

4.3.3 推理代码(K8s+Seldon部署)

用Seldon Core将模型部署为K8s服务,对外提供REST API:

# seldon_deployment.yaml

apiVersion: machinelearning.seldon.io/v1

kind: SeldonDeployment

metadata:

name: recommendation-model

spec:

predictors:

- name: default

replicas: 5 # 初始5个实例

graph:

name: recommendation-model

type: MODEL

implementation: TENSORRT_SERVER

modelUri: s3://my-model-bucket/recommendation_model_trt.pt

parameters:

- name: protocol

value: "rest"

- name: service-type

value: "ClusterIP"

annotations:

seldon.io/rest-timeout: "100" # 推理超时100ms

部署后,可通过以下API调用模型:

curl -X POST -H "Content-Type: application/json" \

-d '{"data": {"names": ["user_id", "item_id"], "ndarray": [[123, 456]]}}' \

http://recommendation-model.default.svc.cluster.local:8000/api/v1.0/predictions

4.4 边缘情况处理:模型漂移与故障恢复

4.4.1 数据漂移检测(PSI指标)

用**Population Stability Index(PSI)**检测用户行为数据的分布变化:

PSI=∑i=1n(实际占比i−预期占比i)×ln(实际占比i预期占比i) \text{PSI} = \sum_{i=1}^n \left( \text{实际占比}_i - \text{预期占比}_i \right) \times \ln\left( \frac{\text{实际占比}_i}{\text{预期占比}_i} \right) PSI=i=1∑n(实际占比i−预期占比i)×ln(预期占比i实际占比i)

- 当PSI<0.1时,数据分布稳定;

- 当0.1≤PSI<0.25时,需关注;

- 当PSI≥0.25时,需重新训练模型。

代码示例(用Pandas计算PSI):

import pandas as pd

import numpy as np

def calculate_psi(expected, actual, bins=10):

# 分箱

expected_bins, bin_edges = pd.cut(expected, bins=bins, retbins=True, duplicates="drop")

actual_bins = pd.cut(actual, bins=bin_edges, duplicates="drop")

# 计算占比

expected_counts = expected_bins.value_counts(normalize=True).sort_index()

actual_counts = actual_bins.value_counts(normalize=True).sort_index()

# 填充缺失值(避免除以0)

expected_counts = expected_counts.reindex(actual_counts.index, fill_value=0)

actual_counts = actual_counts.reindex(expected_counts.index, fill_value=0)

# 计算PSI

psi = sum((actual_counts - expected_counts) * np.log(actual_counts / expected_counts))

return psi

# 示例:计算用户最近7天浏览次数的PSI

expected_data = pd.read_csv("train_user_browse_count.csv")["browse_count"]

actual_data = pd.read_csv("current_user_browse_count.csv")["browse_count"]

psi_value = calculate_psi(expected_data, actual_data)

if psi_value >= 0.25:

print("数据漂移严重,需重新训练模型!")

4.4.2 模型故障恢复(蓝绿部署+回滚)

用蓝绿部署(Blue-Green Deployment)保证模型升级的安全性:

- 蓝环境:当前运行的稳定模型(v1);

- 绿环境:新训练的模型(v2);

- 先将10%的流量导向绿环境,监控性能(转化率、延迟);

- 如果绿环境性能达标,逐步将100%流量导向绿环境;

- 如果绿环境出现故障,立即回滚到蓝环境。

Seldon部署示例(蓝绿部署):

# 蓝环境(v1)

apiVersion: machinelearning.seldon.io/v1

kind: SeldonDeployment

metadata:

name: recommendation-model-blue

spec:

predictors:

- name: blue

replicas: 5

graph:

name: recommendation-model-v1

modelUri: s3://my-model-bucket/v1/model.pt

# 绿环境(v2)

apiVersion: machinelearning.seldon.io/v1

kind: SeldonDeployment

metadata:

name: recommendation-model-green

spec:

predictors:

- name: green

replicas: 5

graph:

name: recommendation-model-v2

modelUri: s3://my-model-bucket/v2/model.pt

通过Istio(服务网格)控制流量分配:

# istio_virtual_service.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: recommendation-model

spec:

hosts:

- recommendation-model.default.svc.cluster.local

http:

- route:

- destination:

host: recommendation-model-blue.default.svc.cluster.local

subset: blue

weight: 90 # 90%流量到蓝环境

- destination:

host: recommendation-model-green.default.svc.cluster.local

subset: green

weight: 10 # 10%流量到绿环境

4.5 性能考量:推理延迟与吞吐量优化

通过以下手段,将推荐系统的推理延迟从200ms降至80ms,吞吐量从5万QPS提升至15万QPS:

- 模型量化:用TensorRT将模型转为INT8,推理速度提升3倍;

- 批处理(Batching):将多个用户请求合并为一个批次处理(比如批大小=32),吞吐量提升4倍;

- GPU推理:用NVIDIA T4 GPU替代CPU,推理延迟降低70%;

- 缓存:将高频请求的结果缓存到Redis(比如用户123对商品456的推荐结果),减少重复计算。

5. 实际应用:从试点到规模化的实施策略

5.1 实施策略:“单点突破→复制推广→平台化”

企业AI运营体系的实施需遵循**“小步快跑、快速验证”**的原则,分为三个阶段:

5.1.1 阶段1:单点突破(6-12个月)

- 目标:在1-2个核心场景(如推荐系统、风控模型)验证EAIOps的有效性,实现ROI≥300%;

- 关键动作:

- 选择高业务价值、低实施难度的场景(比如推荐系统,直接关联收入);

- 组建跨职能团队(业务产品经理、数据科学家、MLOps工程师、运维工程师);

- 用**最小可行性架构(MVA)**快速落地(比如用MLflow做实验管理,用Seldon做部署);

- 验证ROI,输出可复制的流程文档(比如“推荐系统的模型开发规范”“数据漂移检测流程”)。

5.1.2 阶段2:复制推广(12-24个月)

- 目标:将成功场景的经验复制到3-5个其他场景(如库存预测、供应链优化),实现规模化价值;

- 关键动作:

- 构建标准化工具链(比如统一用Kubeflow做Pipeline,统一用Feast做特征平台);

- 建立AI CoE(Center of Excellence):负责制定标准、培训团队、协调跨部门合作;

- 量化每个场景的ROI,优先推广高ROI场景(比如库存预测的ROI=500%,优先推广);

- 解决跨系统集成问题(比如将推荐系统与CRM系统对接,获取用户画像数据)。

5.1.3 阶段3:平台化(24+个月)

- 目标:将EAIOps升级为企业级AI平台,支持业务人员自主使用AI(Low-Code/No-Code);

- 关键动作:

- 开发低代码AI平台:让业务人员通过拖拽界面训练模型(比如用DataRobot或AutoML工具);

- 构建AI资产库:存储可复用的模型、特征、Pipeline(比如“用户 churn 预测模型”“商品销量特征”);

- 建立AI治理体系:规范数据隐私、模型伦理、权限管理(比如用Apache Ranger做权限控制);

- 实现AI自治:用AI Agent自动处理模型迭代、算力调度(比如用LangChain构建AI运维Agent)。

5.2 集成方法论:与企业现有系统的对接

EAIOps需与企业现有系统(如ERP、CRM、MES)深度集成,才能最大化业务价值。以下是常见系统的集成方式:

| 系统类型 | 集成目标 | 集成方式 | 示例工具 |

|---|---|---|---|

| CRM | 获取用户画像数据(如购买历史) | API对接(REST/SOAP) | Salesforce API、HubSpot API |

| ERP | 获取库存、订单数据 | 数据湖同步(CDC) | Debezium、Flink CDC |

| MES | 获取工厂设备传感器数据 | 边缘计算(MQTT协议) | AWS IoT Core、Azure IoT |

| BI | 展示AI价值度量结果(如ROI Dashboard) | ODBC/JDBC连接 | Tableau、Power BI |

5.3 部署考虑因素:云原生vs本地vs边缘

根据场景需求选择部署方式:

5.3.1 云原生部署(推荐)

- 适用场景:需要弹性算力、快速迭代的场景(如推荐系统、客服AI);

- 优势:按需付费、弹性扩容、集成云厂商的MLOps工具(如AWS SageMaker、Google AI Platform);

- 挑战:数据隐私问题(需遵守GDPR、CCPA等法规)。

5.3.2 本地部署

- 适用场景:对数据隐私要求极高的场景(如银行风控、医疗影像);

- 优势:数据完全可控、低延迟(无需跨公网);

- 挑战:算力成本高、维护难度大。

5.3.3 边缘部署

- 适用场景:需要低延迟、离线运行的场景(如工厂预测性维护、零售POS机推荐);

- 优势:低延迟(<10ms)、减少云端算力消耗;

- 挑战:边缘设备算力有限(需用轻量级模型)。

5.4 运营管理:建立“日常监控+定期复盘”机制

5.4.1 日常监控:关键指标Dashboard

用Grafana搭建实时监控Dashboard,展示以下指标:

- 业务指标:转化率、客单价、缺货率(每1分钟更新);

- 技术指标:推理延迟、吞吐量、资源利用率(CPU/GPU使用率,每10秒更新);

- 模型指标:精准率、召回率、PSI(每小时更新);

- ROI指标:日/周/月ROI、投入成本、净收益(每日更新)。

5.4.2 定期复盘:季度/年度Review

每季度召开AI运营复盘会,重点讨论:

- 场景ROI排名:淘汰低ROI场景(如ROI<100%的模型),加大高ROI场景的投入;

- 问题总结:比如“推荐系统的高价值用户覆盖率不足”,分析原因(比如特征工程未考虑用户消费能力);

- 优化计划:制定下季度的优化目标(如“将高价值用户覆盖率提升至80%”);

- 团队成长:培训团队掌握新工具(如AutoML、大模型微调)。

6. 高级考量:安全、伦理与未来演化

6.1 扩展动态:多模态与联邦学习的运营挑战

6.1.1 多模态模型的运营

多模态模型(如图文生成、音视频理解)的运营需解决数据异构(文本、图像、音频数据的整合)与算力消耗(多模态模型参数通常超过10亿)问题:

- 数据管理:用多模态数据湖(如AWS Lake Formation)存储异构数据,用CLIP等模型提取统一特征;

- 算力优化:用模型并行(Model Parallel)训练多模态模型(比如将文本 encoder 和图像 encoder 分配到不同GPU);

- 监控:除了传统的性能监控,还需监控模态一致性(比如生成的图像是否与文本描述一致)。

6.1.2 联邦学习的运营

联邦学习(Federated Learning)允许企业在不共享原始数据的情况下联合训练模型(如银行间联合做风控),但运营需解决通信成本与模型一致性问题:

- 通信优化:用量化压缩(将模型参数从FP32转为INT8)减少通信数据量;

- 模型一致性:用**联邦平均(FedAvg)**算法聚合各参与方的模型参数,避免“局部最优”;

- 安全:用同态加密(Homomorphic Encryption)保护模型参数的隐私。

6.2 安全影响:模型攻击与数据隐私

6.2.1 模型攻击的防范

常见的模型攻击包括数据投毒(Data Poisoning)(通过注入恶意数据让模型失效)、模型提取(Model Extraction)(窃取模型参数)、对抗攻击(Adversarial Attack)(通过细微修改输入让模型错误分类)。防范方法:

- 数据校验:用异常检测算法(如Isolation Forest)过滤恶意数据;

- 模型鲁棒性测试:用Foolbox工具测试模型对对抗攻击的抗性;

- 权限管理:用**RBAC(基于角色的访问控制)**限制模型的访问权限(比如只有数据科学家能下载模型参数)。

6.2.2 数据隐私的保护

需遵守GDPR(欧盟)、CCPA(加州)、个人信息保护法(中国)等法规,保护用户数据隐私:

- 数据匿名化:去除用户的个人标识信息(如姓名、手机号),用哈希值替代;

- 差分隐私:在数据中加入噪声(如高斯噪声),让攻击者无法识别单个用户的数据;

- 隐私计算:用联邦学习或**多方安全计算(MPC)**在不共享原始数据的情况下训练模型。

6.3 伦理维度:算法偏见与透明性

6.3.1 算法偏见的检测与修正

算法偏见(如推荐系统偏向高收入用户、风控模型歧视某一群体)会导致业务损失(如失去低收入用户)与法律风险(如违反公平信贷法规)。检测与修正方法:

- 公平性指标:计算平等机会差异(Equal Opportunity Difference)(不同群体的真阳性率差异)、统计 parity difference(不同群体的阳性预测率差异);

- 数据修正:重新采样数据(如增加低收入用户的样本量),或调整特征权重(如降低“收入”特征的权重);

- 模型修正:用公平性机器学习算法(如Adversarial Debiasing)训练无偏见模型。

6.3.2 模型透明性的实现

模型透明性(即可解释性)是获得业务人员信任的关键。常用方法:

- 局部可解释:用SHAP(SHapley Additive exPlanations)解释单个预测结果(比如“推荐商品A是因为用户最近浏览了类似商品”);

- 全局可解释:用LIME(Local Interpretable Model-agnostic Explanations)解释模型的整体决策逻辑(比如“模型主要依据用户的浏览历史和商品销量推荐”);

- 可视化工具:用TensorBoard展示模型的训练过程,用Netron展示模型的结构。

6.4 未来演化向量:AI Agent与自治系统

未来,EAIOps将向**“自治型AI运营体系”演化,核心是AI Agent**——能够自主感知环境、制定决策、执行任务的智能体。例如:

- 运维Agent:自动检测模型漂移,触发重新训练,优化算力调度;

- 业务Agent:自动分析业务数据,提出AI应用建议(如“库存预测模型需增加节假日特征”);

- 用户Agent:自动与用户交互,收集反馈,优化模型(如客服Agent自动记录用户的投诉,反馈给推荐系统)。

7. 综合与拓展:跨领域应用与战略建议

7.1 跨领域应用:从零售到制造的实践

EAIOps的方法论可复制到制造业、金融、医疗等多个领域:

7.1.1 制造业:预测性维护

- 业务目标:降低设备停机时间(当前停机时间占比5%,目标降至2%);

- EAIOps应用:

- 数据管理层:采集设备传感器数据(温度、振动),用Feast构建“设备健康特征”;

- 模型全生命周期层:用LSTM模型训练预测性维护模型,部署到边缘设备;

- 运营监控层:监控设备的预测故障概率,当超过阈值时触发维修告警;

- 价值度量层:计算停机时间减少带来的成本降低(比如每月减少100万损失)。

7.1.2 金融:智能风控

- 业务目标:降低坏账率(当前坏账率3%,目标降至1.5%);

- EAIOps应用:

- 数据管理层:整合用户的征信数据、交易数据、社交数据,用Feast构建“信用评分特征”;

- 模型全生命周期层:用XGBoost模型训练风控模型,部署到云原生集群;

- 运营监控层:监控模型的坏账预测准确率,当漂移超过阈值时重新训练;

- 价值度量层:计算坏账减少带来的收益(比如每年减少500万损失)。

7.2 研究前沿:AutoML与大模型微调

7.2.1 AutoML在EAIOps中的应用

AutoML(自动机器学习)可自动完成特征工程、模型选择、超参数调优,减少模型开发的人力成本。例如:

- Google AutoML:用神经架构搜索(NAS)自动设计模型结构;

- H2O AutoML:自动比较多个模型(如XGBoost、Random Forest、Deep Learning)的性能,选择最优模型。

7.2.2 大模型的高效微调

大模型(如GPT-4、Claude 3)的微调成本很高(需数千美元),但**参数高效微调(Parameter-Efficient Fine-Tuning, PEFT)**技术可降低成本:

- LoRA(Low-Rank Adaptation):冻结大模型的大部分参数,仅训练少量低秩矩阵,算力消耗减少90%;

更多推荐

已为社区贡献166条内容

已为社区贡献166条内容

所有评论(0)