计算机相关专业研究生如何找到大模型实习?

当前大模型领域的实习岗位呈现特征,不同岗位对研究生的知识结构要求差异显著。研究生在求职中的核心优势在于(如熟悉注意力机制数学原理)和(论文复现能力),但普遍存在(如分布式训练实战不足)。据 Hugging Face 2025 年开发者调查,78% 的实习生因缺乏工业级项目经验被拒。

计算机专业研究生如何高效获取大模型实习机会:全流程策略与技术准备指南

一、大模型实习岗位全景与核心能力要求

当前大模型领域的实习岗位呈现技术分层特征,不同岗位对研究生的知识结构要求差异显著。基于 2025 年头部企业(OpenAI、谷歌 DeepMind、商汤、字节跳动等)的招聘数据,核心岗位可分为三大类:

| 岗位类型 | 核心职责 | 典型技能要求 | 目标人群 |

|---|---|---|---|

| 算法研发岗 | 模型架构创新、训练策略优化 | Transformer 变体、分布式训练、调优算法 | 理论扎实的学术型研究生 |

| 工程落地岗 | 模型部署、推理加速、系统搭建 | 量化压缩、TensorRT、K8s 容器化 | 工程能力强的实践型研究生 |

| 数据处理岗 | 多模态数据清洗、标注体系设计 | 数据增强、标注工具开发、质量评估 | 熟悉数据 pipeline 的学生 |

能力矩阵分析:

研究生在求职中的核心优势在于理论深度(如熟悉注意力机制数学原理)和科研方法(论文复现能力),但普遍存在工程经验断层(如分布式训练实战不足)。据 Hugging Face 2025 年开发者调查,78% 的实习生因缺乏工业级项目经验被拒。

二、系统性准备策略与技术栈构建

1. 知识储备:从理论到工具的闭环体系

-

基础理论(3-6 个月):

- 核心课程:斯坦福 CS224N(自然语言处理)、DeepLearning.AI 的《Large Language Models Specialization》

- 必读书籍:《Attention Is All You Need》精读(掌握 Scaled Dot-Product Attention 公式推导)、《大模型训练与推理》(李沐等著)

- 论文跟踪:关注 NeurIPS/ICML 顶会的大模型专题,使用 Papers With Code 构建个人论文库

- 工具链掌握(2-3 个月):

| 工具类别 | 核心技能点 | 实践项目示例 |

|---|---|---|

| 训练框架 | PyTorch 分布式训练(torch.distributed) | 用 8 卡 GPU 复现 LLaMA 训练过程 |

| 模型优化 | LoRA 微调(peft 库)、INT4 量化 | 基于 QLoRA 微调 Llama 3-70B |

| 部署工具 | ONNX Runtime、TensorRT 转换 | 将 7B 模型部署至 Jetson 设备 |

代码示例:Llama 3 模型的 LoRA 微调

from peft import LoraConfig, get_peft_model

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-3-8B")

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-3-8B")

配置LoRA参数(仅训练0.1%的参数)

lora_config = LoraConfig(

r=16, # 低秩矩阵维度

lora_alpha=32,

target_modules=["q_proj", "v_proj"], # 针对注意力层微调

lora_dropout=0.05,

bias="none"

)

model = get_peft_model(model, lora_config)

model.print_trainable_parameters() # 输出:trainable params: 19,968,000 (0.10%)

2. 项目经验:从复现到创新的进阶路径

- 入门级(1-2 个月):复现经典论文

推荐《LoRA: Low-Rank Adaptation of Large Language Models》,在 GitHub 发布带注释的复现代码,需包含:

-

- 不同秩参数(r=8/16/32)的性能对比

- 与全量微调的精度损失分析(用 GLUE 基准测试)

-

进阶级(2-3 个月):参与开源生态

- Hugging Face 贡献:为 Transformers 库提交模型转换脚本(如将商汤模型适配至 Transformers 接口)

- 模型优化实战:使用 DeepSpeed ZeRO-3 优化 7B 模型训练,记录显存占用从 24GB 降至 8GB 的调参过程

- 可参考案例:LLaMA Factory 项目的 PR 贡献指南(github.com/hiyouga/LLa…)

- 高阶(3-6 个月):校企合作项目

例如:

-

- 与本地 AI 企业合作优化智能客服模型(如将响应延迟从 500ms 降至 200ms)

- 参与导师的横向课题(如基于大模型的工业质检缺陷检测)

3. 学术背书:论文与竞赛的增值效应

- 顶会参与:投递大模型专题(如 EMNLP 的 Workshop on Large Language Models),即使未中稿也可加入 Open Review 获取反馈

-

竞赛实战:

- Kaggle 的 LLM 相关赛事(如 "LLM Efficiency Challenge")

- 国内 "智源悟道" 大模型挑战赛,获奖团队获直通面试资格

三、求职渠道与策略优化

1. 高效渠道对比与优先级排序

| 渠道类型 | 优势 | 劣势 | 操作要点 |

|---|---|---|---|

| 企业官网内推 | 简历直达 Hiring Manager | 依赖人脉资源 | 通过 LinkedIn 联系目标团队工程师 |

| 学术合作 | 匹配度高,导师背书加成 | 机会有限 | 关注导师参与的产学研项目 |

| 招聘平台 | 信息量大 | 竞争激烈,筛选效率低 | 用 "大模型""LLM""多模态" 精准检索 |

| 会议社交 | 面对面交流,留下深刻印象 | 时间成本高 | 在 ICML/NeurIPS 的 Career Fair 提前准备 30 秒电梯 pitch |

内推技巧:通过 GitHub 寻找目标企业开源项目的活跃贡献者,提交有质量的 PR 后附上实习意向,响应率可达 30% 以上(据 2025 年 LinkedIn 调查)。

2. 简历与作品集优化

-

技术简历黄金结构:

- 项目经验(3-4 个):按 "问题 + 方案 + 量化成果" 描述,如 "使用 AWQ 量化技术将 7B 模型压缩至 2.8GB,推理速度提升 2.3 倍"

- 技术栈关键词:需包含具体工具版本(如 PyTorch 2.2、DeepSpeed v0.10.0)

- 学术成果:突出与大模型相关的论文、专利(如 "提出基于动态路由的 MoE 优化算法,在 C4 数据集上加速训练 15%")

-

作品集建设:

- GitHub 仓库:含复现论文代码(带性能对比图表)、模型优化工具(如自动量化脚本)

- 技术博客:在 Medium / 知乎发布《Llama 3 微调全流程》《大模型部署踩坑指南》等实战文章

四、面试准备与高频问题解析

1. 技术面试核心考察维度

- 算法基础:实现 Transformer 的自注意力层(需处理 mask 机制)、计算 FLOPs 的复杂度

-

理论深度:

- 为什么 Transformer 比 RNN 更适合长序列?(考察对并行计算的理解)

- 如何解决大模型训练中的灾难性遗忘?(考察持续学习知识)

- 工程能力:

代码面试示例:

实现一个简单的 LoRA 适配器(要求支持前向 / 反向传播):

import torch

import torch.nn as nn

class LoRALayer(nn.Module):

def init(self, in_features, out_features, rank=8):

super().init()

self.A = nn.Linear(in_features, rank, bias=False)

self.B = nn.Linear(rank, out_features, bias=False)

nn.init.normal_(self.A.weight, std=0.01)

nn.init.zeros_(self.B.weight)

def forward(self, x):

# 原始输出x形状:(batch, seq_len, out_features)

return x + self.B(self.A(x)) # 低秩残差

-

- 给定 100GB 文本数据,如何构建高效的预训练数据 pipeline?(考察分布式处理能力)

- 如何排查模型推理时的显存溢出问题?(考察调试经验)

2. 行为面试与实习规划

- 高频问题:"如何平衡科研与实习任务?"(需体现时间管理能力)

- 准备策略:提前研究目标团队的技术博客,阐述 "希望参与 XX 项目,因为我的 XX 研究与此方向契合"

五、不同类型机构的实习特点对比

| 机构类型 | 典型代表 | 优势 | 劣势 | 适合人群 |

|---|---|---|---|---|

| 科技大厂 | 谷歌、微软、字节 | 资源丰富,流程规范 | 可能接触边缘模块 | 目标明确的职业规划者 |

| 创业公司 | Anthropic、Mistral | 核心模块参与度高 | 风险高,培训体系弱 | 抗压能力强的创新者 |

| 科研机构 | FAIR、智源研究院 | 学术氛围浓,适合读博 | 工程实践机会少 | 计划深造的学术型学生 |

| 传统企业 | 银行、制造业 AI 部 | 场景落地性强 | 技术迭代慢 | 关注行业应用的学生 |

六、时间规划与长期发展建议

- 研一阶段(基础建设期):

完成 CS224N 等课程,复现 1 篇顶会论文,参与 1 个开源项目的 issue 讨论

- 研二上学期(能力强化期):

主导 1 个完整项目(如模型压缩工具开发),发表技术博客 3-5 篇

- 研二下学期(求职冲刺期):

每周投递 5-8 份简历,针对性准备 3 家目标企业的面试

- 实习期间(转化期):

重点参与 1-2 个核心项目,争取产出技术专利或会议投稿,为转正 / 读博积累资本

-

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

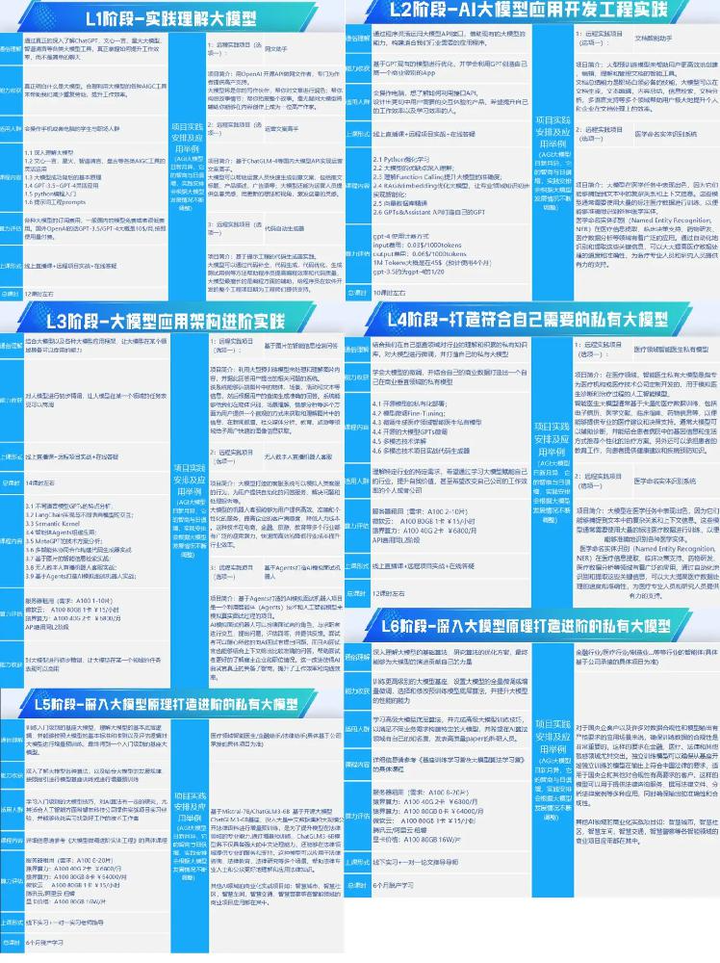

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

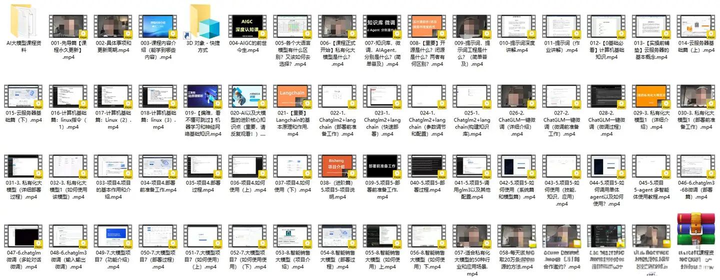

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

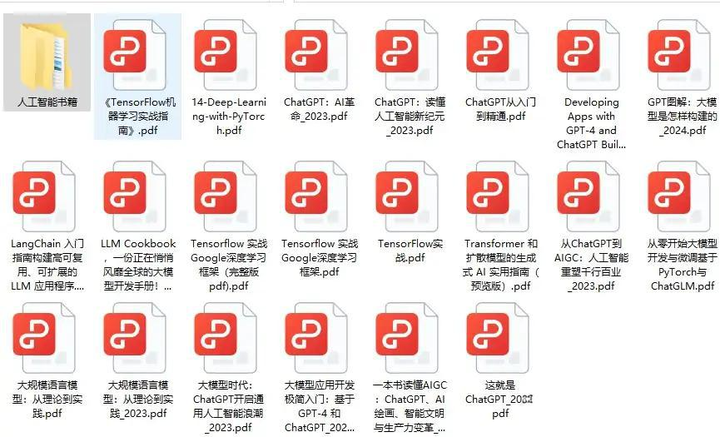

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

更多推荐

已为社区贡献83条内容

已为社区贡献83条内容

所有评论(0)