深度学习入门Day10:深度强化学习原理与实战全解析

马尔可夫决策过程是强化学习的数学基础,它描述了一个智能体在环境中做决策的完整框架。MDP包含五个核心要素:1. 状态(State):环境当前情况的描述2. 动作(Action):智能体可以执行的操作3. 奖励(Reward):环境对智能体动作的反馈4. 状态转移概率:执行动作后状态转换的规律5. 折扣因子(γ):权衡即时奖励与未来奖励的重要性马尔可夫性质:当前状态包含所有历史信息,未来只依赖于当前

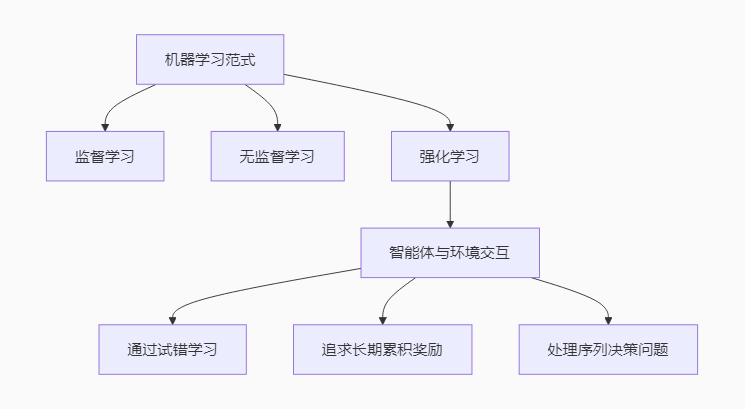

一、开篇:智能决策的科学与艺术

在前九天的学习中,我们掌握了处理各种数据类型的深度学习方法,但这些都属于"被动学习"——模型从静态数据中学习模式。今天,我们将进入一个全新的领域:强化学习(Reinforcement Learning, RL)。这是一种让智能体通过与环境交互来学习最优决策的范式,更接近人类和动物的自然学习方式。

从AlphaGo战胜世界冠军到自动驾驶汽车的决策系统,从游戏AI到机器人控制,强化学习正在创造着一个又一个突破。

二、强化学习基础:理解MDP框架

2.1 什么是马尔可夫决策过程(MDP)?

马尔可夫决策过程是强化学习的数学基础,它描述了一个智能体在环境中做决策的完整框架。MDP包含五个核心要素:

1. 状态(State):环境当前情况的描述

2. 动作(Action):智能体可以执行的操作

3. 奖励(Reward):环境对智能体动作的反馈

4. 状态转移概率:执行动作后状态转换的规律

5. 折扣因子(γ):权衡即时奖励与未来奖励的重要性

马尔可夫性质:当前状态包含所有历史信息,未来只依赖于当前状态而不依赖于过去的状态序列。这是MDP的核心假设。

2.2 关键概念详解

价值函数(Value Function):衡量在某个状态(或状态-动作对)下,智能体能够获得的期望累积奖励。分为状态价值函数V(s)和动作价值函数Q(s,a)。

贝尔曼方程:价值函数的递归定义,表达了当前价值与后续状态价值之间的关系。这是强化学习算法的理论基础。

探索与利用的权衡:智能体需要平衡尝试新动作(探索)和选择已知好动作(利用)之间的矛盾。这是强化学习独有的挑战。

三、深度Q学习:价值学习的革命

3.1 从Q-Learning到Deep Q-Network

Q-Learning是一种传统的强化学习算法,它通过维护一个Q表格(状态-动作值表)来学习最优策略。但在复杂环境中,状态空间可能非常大,表格方法不再可行。

Deep Q-Network (DQN):2015年DeepMind提出的革命性算法,用神经网络近似Q函数,解决了高维状态空间的问题。DQN的核心创新:

1. 经验回放(Experience Replay):存储转移样本并在训练时随机采样,打破数据间的相关性

2. 目标网络(Target Network):使用独立的网络计算目标Q值,提高训练稳定性

3.2 DQN实现详解

神经网络架构:

import torch

import torch.nn as nn

import torch.nn.functional as F

class DQN(nn.Module):

def __init__(self, state_size, action_size):

super(DQN, self).__init__()

# 输入层:状态维度,输出层:动作维度

self.fc1 = nn.Linear(state_size, 64) # 第一全连接层

self.fc2 = nn.Linear(64, 64) # 第二全连接层

self.fc3 = nn.Linear(64, action_size) # 输出每个动作的Q值

def forward(self, x):

# 前向传播过程

x = F.relu(self.fc1(x)) # 第一层+ReLU激活

x = F.relu(self.fc2(x)) # 第二层+ReLU激活

return self.fc3(x) # 输出Q值,不需要激活函数经验回放缓冲区:

from collections import deque

import random

class ReplayBuffer:

def __init__(self, capacity=10000):

self.buffer = deque(maxlen=capacity) # 固定大小的循环队列

def push(self, state, action, reward, next_state, done):

# 存储转移样本:(s, a, r, s', done)

self.buffer.append((state, action, reward, next_state, done))

def sample(self, batch_size):

# 随机采样一批经验

return random.sample(self.buffer, batch_size)

def __len__(self):

return len(self.buffer)目的:解决数据相关性和数据效率问题

- 打破相关性:在在线学习中,相邻的经验样本

(s_t, a_t, r_t, s_{t+1})是高度相关的。直接用它们顺序训练网络会导致训练不稳定且容易陷入局部最优。通过随机采样一批过去的经验,可以打破这种相关性,使训练过程更加平滑稳定。 - 提高数据效率:每一个经验样本都可以被多次使用,而不是用一次就丢弃,极大地提高了数据的利用效率。

实现细节:

-

使用

deque并设置maxlen实现了一个固定大小的循环队列(FIFO)。当缓冲区满时,最旧的经验会被自动移除。 -

sample(batch_size)方法是我们从缓冲区中随机抽取一个小批量经验用于训练的关键。

3.3 完整训练算法

def train_dqn(env, agent, target_net, optimizer,

episodes=1000, batch_size=64, gamma=0.99,

update_target_every=100):

"""

DQN训练循环

env: Gym环境

agent: 在线Q网络

target_net: 目标Q网络

"""

replay_buffer = ReplayBuffer()

epsilon = 1.0 # 初始探索率

eps_min = 0.01 # 最小探索率

eps_decay = 0.995 # 探索率衰减

for episode in range(episodes):

state = env.reset()

total_reward = 0

done = False

while not done:

# ε-greedy探索策略

if random.random() < epsilon:

action = env.action_space.sample() # 随机探索

else:

with torch.no_grad():

state_tensor = torch.FloatTensor(state).unsqueeze(0)

q_values = agent(state_tensor)

action = q_values.argmax().item() # 选择最优动作

# 执行动作并观察结果

next_state, reward, done, _ = env.step(action)

replay_buffer.push(state, action, reward, next_state, done)

total_reward += reward

state = next_state

# 经验回放更新

if len(replay_buffer) >= batch_size:

batch = replay_buffer.sample(batch_size)

states, actions, rewards, next_states, dones = zip(*batch)

# 转换为张量

states = torch.FloatTensor(states)

actions = torch.LongTensor(actions).unsqueeze(1)

rewards = torch.FloatTensor(rewards)

next_states = torch.FloatTensor(next_states)

dones = torch.BoolTensor(dones)

# 计算当前Q值

current_q = agent(states).gather(1, actions)

# 计算目标Q值(使用目标网络)

with torch.no_grad():

next_q = target_net(next_states).max(1)[0]

target_q = rewards + gamma * next_q * (~dones)

# 计算损失并更新

loss = F.mse_loss(current_q.squeeze(), target_q)

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 更新目标网络

if episode % update_target_every == 0:

target_net.load_state_dict(agent.state_dict())

# 衰减探索率

epsilon = max(eps_min, epsilon * eps_decay)

print(f"Episode {episode}, Reward: {total_reward}, Epsilon: {epsilon:.3f}")四、策略梯度方法:直接优化策略

4.1 从价值学习到策略学习

与DQN等价值学习方法不同,策略梯度方法直接学习策略函数π(a|s),即状态到动作的映射。这类方法的优势:

1. 更适合连续动作空间

2. 能学习随机策略

3. 更好的收敛特性

4.2 REINFORCE算法

REINFORCE是最基础的策略梯度算法,使用蒙特卡洛方法估计梯度:

class PolicyNetwork(nn.Module):

def __init__(self, state_size, action_size):

super(PolicyNetwork, self).__init__()

self.fc1 = nn.Linear(state_size, 64)

self.fc2 = nn.Linear(64, 64)

self.fc3 = nn.Linear(64, action_size)

def forward(self, x):

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

return F.softmax(self.fc3(x), dim=-1) # 输出动作概率

def compute_returns(rewards, gamma=0.99):

"""计算累积回报"""

returns = []

G = 0

for r in reversed(rewards):

G = r + gamma * G

returns.insert(0, G)

return returns4.3 演员-评论家架构

演员-评论家(Actor-Critic)方法结合了策略梯度和价值学习的优点:

- 演员(Actor):学习策略函数,决定执行什么动作

- 评论家(Critic):学习价值函数,评估动作的好坏

class ActorCritic(nn.Module):

def __init__(self, state_size, action_size):

super(ActorCritic, self).__init__()

# 共享特征提取层

self.fc1 = nn.Linear(state_size, 64)

self.fc2 = nn.Linear(64, 64)

# 演员网络(策略)

self.actor = nn.Linear(64, action_size)

# 评论家网络(价值)

self.critic = nn.Linear(64, 1)

def forward(self, x):

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

policy = F.softmax(self.actor(x), dim=-1)

value = self.critic(x)

return policy, value五、实战应用:OpenAI Gym环境

5.1 CartPole平衡任务

CartPole是一个经典的强化学习测试环境:控制小车保持杆子平衡。

import gym

def run_cartpole():

env = gym.make('CartPole-v1')

state_size = env.observation_space.shape[0]

action_size = env.action_space.n

# 初始化网络

agent = DQN(state_size, action_size)

target_net = DQN(state_size, action_size)

target_net.load_state_dict(agent.state_dict())

optimizer = torch.optim.Adam(agent.parameters(), lr=1e-3)

# 开始训练

train_dqn(env, agent, target_net, optimizer, episodes=500)

# 测试训练效果

test_agent(env, agent)

def test_agent(env, agent):

state = env.reset()

total_reward = 0

while True:

env.render() # 显示环境

with torch.no_grad():

state_tensor = torch.FloatTensor(state).unsqueeze(0)

action = agent(state_tensor).argmax().item()

state, reward, done, _ = env.step(action)

total_reward += reward

if done:

break

print(f"测试得分: {total_reward}")

env.close()5.2 训练效果分析

在CartPole环境中,成功标准通常是连续100回合平均得分达到195以上。通过调整超参数和训练策略,我们可以观察到:

1. 探索率衰减:初期高探索率帮助发现好策略,后期低探索率稳定性能

2. 目标网络更新频率:影响训练稳定性的关键参数

3. 批大小和学习率:需要仔细调优以获得最佳性能

六、学习总结与明日计划

6.1 今日核心成果

✅ 理解马尔可夫决策过程的基本概念

✅ 掌握价值函数、贝尔曼方程等理论基础

✅ 实现深度Q网络及其关键组件(经验回放、目标网络)

✅ 了解策略梯度方法和演员-评论家架构

✅ 在CartPole环境中成功训练智能体

6.2 关键问题记录

❓ 如何设计合适的奖励函数引导智能体学习

❓ 超参数调优的系统性方法

❓ 从仿真环境到真实应用的迁移挑战

6.3 明日学习重点

- 元学习基础概念与算法框架

- 模型无关元学习(MAML)原理与实现

- 少样本学习在实际任务中的应用

- 快速适应新任务的能力构建

七、资源推荐与延伸阅读

1. OpenAI Spinning Up:最好的强化学习入门教程,包含理论解释和代码实现

2. 强化学习导论:Richard Sutton的经典教材,被誉为"强化学习圣经"

3. DeepMind强化学习课程:DeepMind研究人员的视频讲解

4. Stable Baselines3:基于PyTorch的强化学习算法库,包含多种先进算法实现

八、工程实践建议

1. 奖励设计原则:

- 奖励应该与最终目标一致

- 避免稀疏奖励问题(提供中间奖励)

- 适当缩放奖励数值范围

2. 超参数调优指南:

| 参数 | 推荐范围 | 作用 |

|---|---|---|

| 学习率 | 1e-4 ~ 1e-3 | 控制参数更新步长 |

| 折扣因子γ | 0.9 ~ 0.99 | 未来奖励的重要性 |

| 回放缓冲区大小 | 1e4 ~ 1e6 | 经验存储容量 |

| 目标网络更新频率 | 100 ~ 1000步 | 控制训练稳定性 |

3. 调试与监控指标:

# 关键监控指标

- 回合奖励(Episode Reward)

- Q值损失(Q-value Loss)

- 探索率(Epsilon)

- 平均Q值(Average Q-value)

- 策略熵(Policy Entropy)- 对于策略梯度方法

下篇预告:《Day11:元学习入门—让模型学会如何学习》

将探索如何让机器学习模型具备快速适应新任务的能力,实现真正的"学会学习"!我们将学习MAML等元学习算法,并实现少样本学习系统。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)