Agent实战教程:LangGraph关于智能体的架构模式与核心概念

本文介绍了智能体架构及其在大型语言模型(LLM)应用中的实现方式。智能体是利用LLM决定应用程序控制流程的系统,包括路由器、工具调用智能体等类型。路由器通过结构化输出让LLM做出单一决策,而工具调用智能体则支持多步骤决策和外部工具访问。文章还探讨了记忆管理、规划功能以及人机协作、并行化等定制化智能体架构的实现方法。最后提供了AI大模型学习路线,包括基础认知、RAG实践、Agent架构设计、模型微调

智能体架构

许多大型语言模型(LLM)应用在调用 LLM 之前或之后,都会遵循特定的控制流程。例如,检索增强生成(RAG)会检索与用户问题相关的文档,并将这些文档传递给 LLM,以便模型根据提供的文档上下文生成响应。

然而,有时我们不仅仅是硬编码一个固定的控制流程,而是希望 LLM 系统能够自主选择控制流程,以解决更复杂的问题。这便是“智能体”的定义之一:智能体是利用 LLM 来决定应用程序控制流程的系统。 LLM 可以通过多种方式控制应用程序的流程:

- LLM 可以在两条潜在路径之间进行路由。

- LLM 可以决定调用哪些工具。

- LLM可以判断生成的答案是否足够,或者是否需要进一步工作。

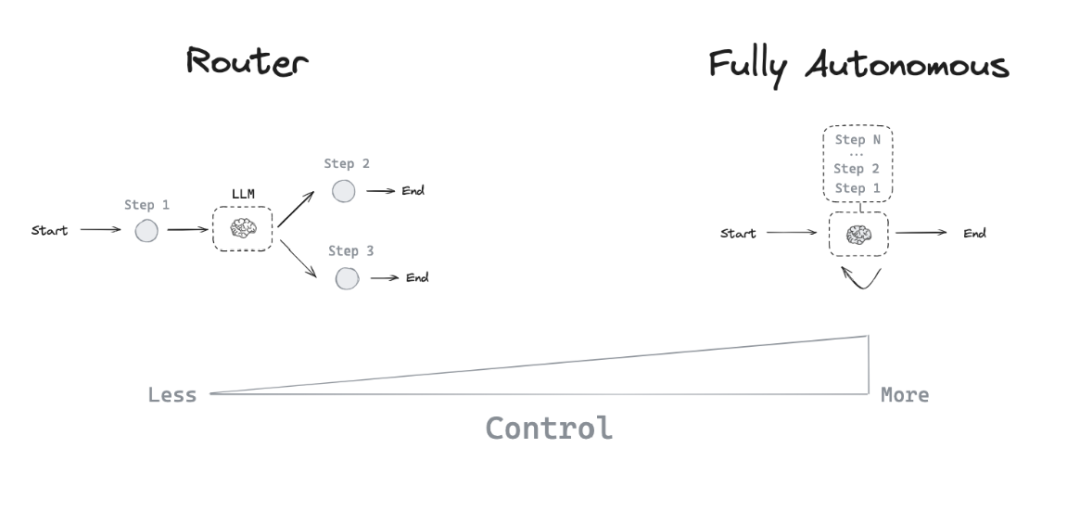

因此,有许多不同类型的智能体架构,它们赋予 LLM 不同程度的控制能力。

智能体类型

智能体类型

路由器(Router)

路由器允许 LLM 从一组给定的选项中选择单个步骤。这种智能体架构的控制级别相对有限,因为LLM 通常专注于做出一个单一决策,并从有限的预定义选项中选择一个特定输出。路由器通常采用以下几种概念来实现这一功能:

结构化输出(Structured Output)

通过为 LLM 提供特定的格式或模式,要求其在响应中遵循,从而实现结构化输出。这类似于工具调用,但更具通用性。工具调用通常涉及选择和使用预定义函数,而结构化输出可用于任何类型的格式化响应。实现结构化输出的常见方法包括:

- 提示工程(Prompt Engineering): 通过系统提示(system prompt)指令 LLM 以特定格式响应。

- 输出解析器(Output Parsers): 使用后处理技术从 LLM 响应中提取结构化数据。

- 工具调用(Tool Calling): 利用某些 LLM 内置的工具调用能力来生成结构化输出。

结构化输出对于路由至关重要,因为它们确保 LLM 的决策可以被系统可靠地解释和执行。

工具调用智能体(Tool-calling Agent)

路由器允许 LLM 做出单一决策,而更复杂的智能体架构则通过两种关键方式扩展了 LLM 的控制能力:

- 多步骤决策(Multi-step decision making): LLM 可以连续做出系列决策,而不仅仅是一个。

- 工具访问(Tool access): LLM 可以选择并使用各种工具来完成任务。

ReAct 是一种流行的通用智能体架构,它结合了这些扩展,并整合了三个核心概念:

- 工具调用(Tool calling): 允许 LLM 根据需要选择和使用各种工具。

- 记忆(Memory): 使智能体能够保留并利用前一步骤的信息。

- 规划(Planning):赋予 LLM 制定并遵循多步骤计划以实现目标的能力。

这种架构允许更复杂和灵活的智能体行为,超越了简单的路由,实现了多步骤的动态问题解决。与最初的 ReAct 论文不同,如今的智能体依赖于 LLM 的工具调用能力,并基于一系列消息进行操作。

在 LangGraph 中,你可以使用预构建的智能体来快速启动工具调用智能体。

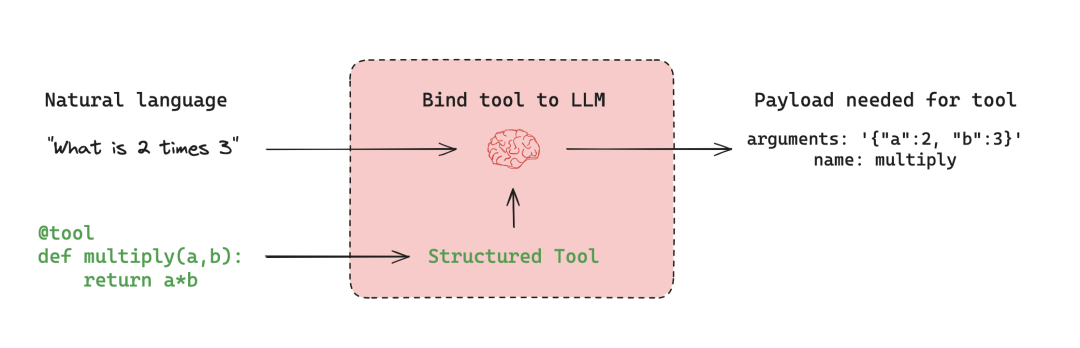

工具调用(Tool Calling)

当您希望智能体与外部系统(例如 API)交互时,工具非常有用。外部系统通常需要特定的输入模式或载荷,而非自然语言。当我们将 API 绑定为工具时,模型就能了解所需的输入模式。模型会根据用户的自然语言输入选择调用工具,并返回符合工具所需模式的输出。

许多 LLM 提供商都支持工具调用。在 LangChain 中,工具调用接口很简单:您可以直接将任何 Python 函数 传递给 ChatModel.bind_tools(function)。

工具

工具

记忆(Memory)

记忆对于智能体至关重要,它使智能体能够在解决问题的多个步骤中保留和利用信息。记忆的作用范围不同:

- 短期记忆(Short-term memory): 允许智能体访问在序列早期步骤中获取的信息。

- 长期记忆(Long-term memory): 使智能体能够回忆起之前交互的信息,例如对话中的历史消息。

LangGraph 提供了对记忆实现方式的完全控制:

State: 用户定义的模式,指定要保留的记忆的确切结构。Checkpointer: 一种机制,用于在会话中每一步存储状态,跨越不同的交互。Store: 一种机制,用于在不同会话中存储用户特定或应用程序级别的数据。

这种灵活的方法允许您根据特定的智能体架构需求定制记忆系统。有效的记忆管理增强了智能体保持上下文、从过去经验中学习以及随着时间做出更明智决策的能力。

规划(Planning)

在工具调用智能体中,LLM 会在一个循环中被反复调用。在每一步,智能体都会决定要调用哪些工具以及这些工具的输入应该是什么。然后执行这些工具,并将输出作为观察结果反馈给 LLM。当智能体判断它有足够的信息来解决用户请求,并且无需再调用任何工具时,循环终止。

自定义智能体架构

虽然路由器和工具调用智能体(如 ReAct)很常见,但定制智能体架构通常能针对特定任务带来更好的性能。LangGraph提供了几个强大的功能来构建定制的智能体系统:

人机协作(Human-in-the-loop)

人的参与可以显著提高智能体的可靠性,尤其是在处理敏感任务时。这可能包括:* 批准特定操作。

- 提供反馈以更新智能体的状态。

- 在复杂的决策过程中提供指导。

当完全自动化不可行或不可取时,人机协作模式至关重要。

并行化(Parallelization)

并行处理对于高效的多智能体系统和复杂任务至关重要。LangGraph 通过其 Send API 支持并行化,从而实现:

- 多个状态的并发处理。 *Map-Reduce 类似操作的实现。

- 高效处理独立的子任务。

子图(Subgraphs)

子图对于管理复杂的智能体架构至关重要,特别是在多智能体系统中。它们允许:* 为单个智能体进行独立的状体管理。

- 智能体团队的层次化组织。

- 智能体与主系统之间受控的通信。

子图通过状态模式中重叠的键与父图进行通信。这使得灵活的模块化智能体设计成为可能。

反思(Reflection)

反思机制可以通过以下方式显著提高智能体的可靠性:

- 评估任务完成度和正确性。2. 提供反馈以进行迭代改进。

- 实现自我纠正和学习。

虽然反思通常基于 LLM,但也可以使用确定性方法。例如,在编程任务中,编译错误可以作为反馈。

通过利用这些功能,LangGraph 能够创建复杂的、针对特定任务的智能体架构,这些架构能够处理复杂的工作流程、有效地协作并持续提升

最后

选择AI大模型就是选择未来!最近两年,大家都可以看到AI的发展有多快,我国超10亿参数的大模型,在短短一年之内,已经超过了100个,现在还在不断的发掘中,时代在瞬息万变,我们又为何不给自己多一个选择,多一个出路,多一个可能呢?

与其在传统行业里停滞不前,不如尝试一下新兴行业,而AI大模型恰恰是这两年的大风口,整体AI领域2025年预计缺口1000万人,人才需求急为紧迫!

由于文章篇幅有限,在这里我就不一一向大家展示了,学习AI大模型是一项系统工程,需要时间和持续的努力。但随着技术的发展和在线资源的丰富,零基础的小白也有很好的机会逐步学习和掌握。

【2025最新】AI大模型全套学习籽料(可白嫖):LLM面试题+AI大模型学习路线+大模型PDF书籍+640套AI大模型报告等等,从入门到进阶再到精通,超全面存下吧!

获取方式:有需要的小伙伴,可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

包括:AI大模型学习路线、LLM面试宝典、0基础教学视频、大模型PDF书籍/笔记、大模型实战案例合集、AI产品经理合集等等

大模型学习之路,道阻且长,但只要你坚持下去,一定会有收获。本学习路线图为你提供了学习大模型的全面指南,从入门到进阶,涵盖理论到应用。

L1阶段:启航篇|大语言模型的基础认知与核心原理

L2阶段:攻坚篇|高频场景:RAG认知与项目实践

L3阶段:跃迀篇|Agent智能体架构设计

L4阶段:精进篇|模型微调与私有化部署

L5阶段:专题篇|特训集:A2A与MCP综合应用 追踪行业热点(全新升级板块)

AI大模型全套学习资料【获取方式】

更多推荐

已为社区贡献74条内容

已为社区贡献74条内容

所有评论(0)