Transformer 是什么?ChatGPT 的“大脑”原来是它

《Transformer:AI大模型背后的"技术地基"》摘要: 2017年诞生的Transformer架构彻底改变了AI发展路径,成为ChatGPT、BERT等大模型的核心技术。其革命性在于:1)突破传统RNN顺序处理限制,实现并行计算;2)独创自注意力机制,让每个词动态关注全句重点;3)采用编码器-解码器结构,分别处理语言理解和生成任务。这种设计使AI能像人类一样"

你用过 ChatGPT 吗?

它能写文章、写代码、做翻译、甚至陪你聊天,仿佛真的“懂”语言。

但你知道吗?

它的“大脑”并不是凭空变出来的,而是源于一个在 2017 年诞生的革命性架构——

Transformer

这个名字你可能没听过,但它却是 GPT、BERT、ChatGPT、通义千问、Claude 等几乎所有大模型的“技术地基”。

今天,我们不用公式、不讲代码,用生活化的比喻和清晰的逻辑图,带你彻底搞懂:Transformer 到底是什么?为什么它能改变 AI 的未来?

一、从“逐字阅读”到“一眼看懂”:语言理解的范式革命

在 Transformer 出现之前,AI 理解语言主要依赖一种叫 RNN(循环神经网络) 的模型。

它的处理方式很像人类“逐字阅读”:

“今天 / 天气 / 很 / 好 / 因为 / 我 / 吃了 / 冰淇淋”

RNN 必须按顺序一个词一个词处理,前一个没看完,就不能看下一个。

这带来了两个致命问题:

- 速度慢:无法并行计算,训练效率低

- 记性差:句子一长,“因为”和“所以”就对不上了

而 Transformer 完全打破了这种顺序限制。

它能做到:所有词同时处理,一眼扫完整句话,立刻判断词与词之间的关系。

这就像你读一句“小明喜欢小红,因为他喜欢她”,不需要从头逐字分析,而是瞬间理解“他”指的是“小明”。

这种能力,来自 Transformer 的核心技术——

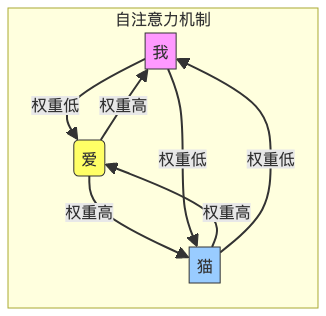

二、自注意力机制:让每个词“看见”整句话

Transformer 的核心是 自注意力机制(Self-Attention)。

它的思想很简单:

每个词在理解时,都应该知道句子里其他词的重要性。

举个例子:

句子:“我 爱 猫”

- “爱” 会重点关注 “我” 和 “猫”

- “我” 也会关注 “爱”,但不太关心 “猫”

- “猫” 同样更关注 “爱”,而不是 “我”

这种“谁该关注谁”的权重,由模型自动学习决定。

我们可以通过一个 Mermaid 图来直观展示这个过程:

💡 这就是“自注意力”:每个词都能动态地“看”全句,决定谁更重要。

它不依赖顺序,可以并行计算,还能轻松捕捉远距离依赖(比如“因为”和“所以”相隔很远也能关联)。

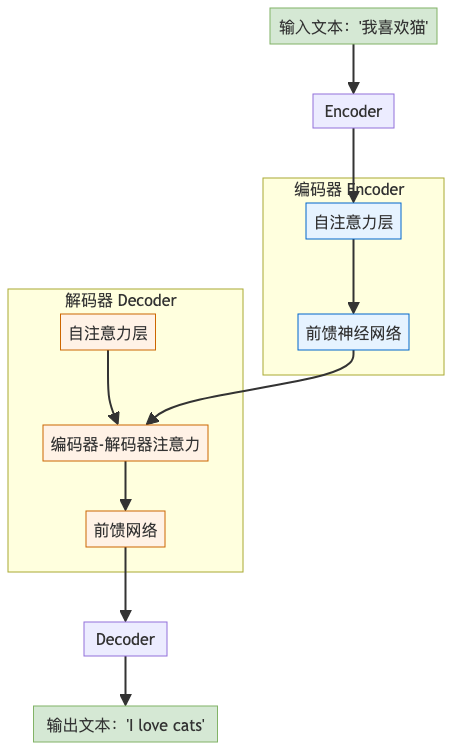

三、编码器 + 解码器:语言理解与生成的双引擎

Transformer 的整体结构由两部分组成:编码器(Encoder) 和 解码器(Decoder),合称“Encoder-Decoder”架构。

我们用一个 Mermaid 流程图来展示它的整体结构:

1. 编码器(Encoder)—— 负责“理解”

- 输入一句话(如“我喜欢猫”)

- 经过多个自注意力层和前馈网络

- 输出一个语义表示向量,包含整句话的含义

👉 代表模型:BERT(Google),擅长阅读理解、问答、情感分析

2. 解码器(Decoder)—— 负责“生成”

- 根据编码器的理解,一步步生成目标语言

- 在生成每个词时,既能“看自己已生成的内容”,也能“回头看原句重点”

- 使用“编码器-解码器注意力”机制,确保不偏离原意

👉 代表模型:GPT 系列(OpenAI),擅长写作、翻译、对话生成

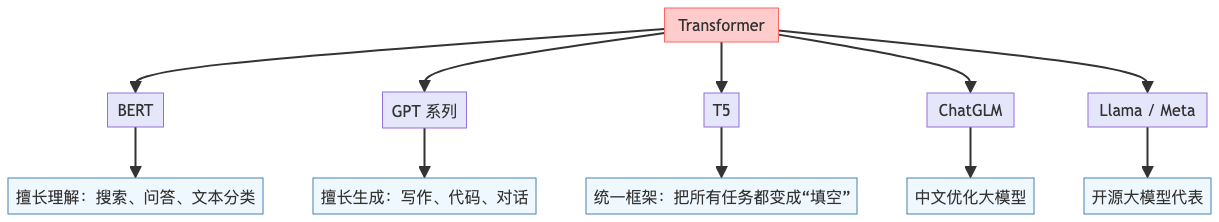

四、Transformer 的“家族谱系”:GPT、BERT、ChatGPT 都是它的孩子

Transformer 就像一位“AI 之父”,它的不同变体催生了当今几乎所有主流大模型:

- BERT:只用编码器,专注“理解”

- GPT / ChatGPT:只用解码器,专注“生成”

- T5:把所有任务都当作“文本到文本”转换

- Llama、通义千问:基于 Transformer 的大规模开源模型

可以说:没有 Transformer,就没有今天的 AI 大模型时代。

五、总结:为什么 Transformer 如此重要?

|

优势 |

说明 |

|

并行计算 |

所有词同时处理,训练速度大幅提升 |

|

长距离依赖 |

能捕捉“开头”和“结尾”之间的语义联系 |

|

结构统一 |

编码器+解码器设计清晰,易于扩展 |

|

通用性强 |

不仅用于文本,还可用于图像、语音、视频(如 Vision Transformer) |

结语:一场静悄悄的技术革命

Transformer 没有惊人的宣传,也没有复杂的外壳。

它只是一个架构,一篇论文(《Attention is All You Need》),却彻底改变了人工智能的走向。

它教会 AI:

真正的语言理解,不是死记硬背,而是学会关注重点、建立联系、把握逻辑。

当你下次使用 ChatGPT 写文章、问问题时,不妨想一想:

那个在背后默默工作的“大脑”,正是 2017 年诞生的 Transformer。

它不声不响,却已重塑世界。

如果你觉得这篇文章有帮助,欢迎点赞、转发,让更多人看懂AI背后的逻辑

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)