LangChain4j 入门实践

LangChain4j Java大语言模型集成框架入门指南 摘要:LangChain4j是一个简化大语言模型(LLM)集成到Java应用的框架。本文介绍了其发展背景(2023年由Quarkus发布)、核心功能(统一API访问主流LLM、支持智能代理和RAG等)及典型应用场景(智能客服、数据处理等)。详细演示了如何创建SpringBoot项目(含Maven配置),并逐步指导接入OpenAI模型,包括

一、LangChain4j 入门

1、简介

LangChain4j 的目标是简化将大语言模型(LLM - Large Language Model)集成到 Java 应用程序中的过程。

1.1、历史背景

2022 年11月30日OpenAI发布了Chat GPT(GPT-3.5)

早在 2022 年10月,Harrison Chase 发布了基于Python的LangChain。

随后同时包含了Python版和JavaScript(LangChain.js)版的LangChain 也发布了。

2023 年 11 月,Quarkus 发布了 LangChain4j 的 0.1 版本,2025 年 2 月发布了 1.0 - Beta1 版本,4 月发布了 1.0 - Beta4 版本

官网: https://docs.langchain4j.dev

1.2、主要功能

与大型语言模型和向量数据库的便捷交互

通过统一的应用程序编程接口(API),可以轻松访问所有主要的商业和开源大型语言模型以及向量数据库,使你能够构建聊天机器人、智能助手等应用。

专为 Java 打造

借助Spring Boot 集成,能够将大模型集成到ava 应用程序中。大型语言模型与 Java 之间实现了双向集成:你可以从 Java 中调用大型语言模型,同时也允许大型语言模型反过来调用你的 Java 代码

智能代理、工具、检索增强生成(RAG)

为常见的大语言模型操作提供了广泛的工具,涵盖从底层的提示词模板创建、聊天记忆管理和输出解析,到智能代理和检索增强生成等高级模式。

Agents: 智能体

Tools: 方法调用

RAG: 增强检索–(外挂知识库)

1.3、应用示例

-

你想要实现一个自定义的由人工智能驱动的聊天机器人,它可以访问你的数据,并按照你期望的方式运行:

-

客户支持聊天机器人,它可以:

-

礼貌地回答客户问题

-

处理 / 更改 / 取消订单

-

-

教育助手,它可以:

- 教授各种学科

-

- 解释不清楚的部分

- 评估用户的理解 / 知识水平

-

你想要处理大量的非结构化数据(文件、网页等),并从中提取结构化信息。例如:

- 从客户评价和支持聊天记录中提取有效评价

- 从竞争对手的网站上提取有趣的信息

- 从求职者的简历中提取有效信息

-

你想要生成信息,例如:

- 为你的每个客户量身定制的电子邮件

- 为你的应用程序 / 网站生成内容:

- 博客文章

- 故事

-

你想要转换信息,例如:

- 总结

- 校对和改写

- 翻译

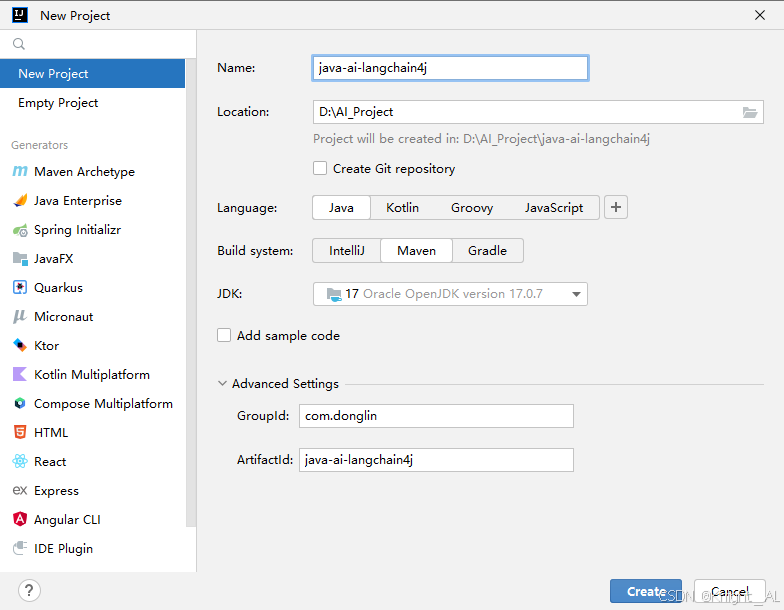

2、创建SpringBoot项目

2.1、创建一个Maven项目

java-ai-langchain4j

2.2、添加SpringBoot相关依赖

在pom.xml的 节点下填加如下依赖

<properties>

<maven.compiler.source>17</maven.compiler.source>

<maven.compiler.target>17</maven.compiler.target>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<spring-boot.version>3.2.6</spring-boot.version>

<knife4j.version>4.3.0</knife4j.version>

<langchain4j.version>1.0.0-beta3</langchain4j.version>

<mybatis-plus.version>3.5.11</mybatis-plus.version>

</properties>

<dependencies>

<!-- web应用程序核心依赖 -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<!-- 编写和运行测试用例 -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

<!-- 前后端分离中的后端接口测试工具 -->

<dependency>

<groupId>com.github.xiaoymin</groupId>

<artifactId>knife4j-openapi3-jakarta-spring-boot-starter</artifactId>

<version>${knife4j.version}</version>

</dependency>

</dependencies>

<dependencyManagement>

<dependencies>

<!--引入SpringBoot依赖管理清单-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-dependencies</artifactId>

<version>${spring-boot.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>

2.3、创建配置文件

在resources下创建配置文件application.properties

# web服务访问端口

server.port=8081

2.4、创建启动类

package com.donglin.java.ai.langchain4j;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

@SpringBootApplication

public class XiaozhiApp {

public static void main(String[] args) {

SpringApplication.run(XiaozhiApp.class,args);

}

}

2.5、启动启动类

访问 http://localhost:8081/doc.html 查看程序能否成功运行并显示如下页面

3、接入大模型

- 参考文档: Get Startedhttps://docs.langchain4j.dev/get-started

3.1、LangChain4j 库结构

LangChain4j 具有模块化设计,包括:

- langchain4j-core 模块,它定义了核心抽象概念(如聊天语言模型和嵌入存储)及其 API。

- 主 langchain4j 模块,包含有用的工具,如文档加载器、聊天记忆实现,以及诸如人工智能服务等高层功能。

- 大量的 langchain4j-{集成} 模块,每个模块都将各种大语言模型提供商和嵌入存储集成到 LangChain4j 中。你可以独立使用 langchain4j-{集成} 模块。如需更多功能,只需导入主 langchain4j 依赖项即可。

3.2、添加LangChain4j相关依赖

<properties>

<langchain4j.version>1.0.0-beta3</langchain4j.version>

</properties>

<dependencies>

<!-- 基于open-ai的langchain4j接口:ChatGPT、deepseek都是open-ai标准下的大模型 -->

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j-open-ai</artifactId>

</dependency>

</dependencies>

<dependencyManagement>

<dependencies>

<!--引入langchain4j依赖管理清单-->

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j-bom</artifactId>

<version>${langchain4j.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>

3.3、创建测试用例

接入任何一个大模型都需要先去申请apiKey。

如果你暂时没有密钥,也可以使用LangChain4j 提供的演示密钥,这个密钥是免费的,有使用配额限制,且仅限于 gpt-4o-mini 模型。

package com.donglin.java.ai.langchain4j;

import dev.langchain4j.model.openai.OpenAiChatModel;

import org.junit.jupiter.api.Test;

import org.springframework.boot.test.context.SpringBootTest;

@SpringBootTest

public class LLMTest {

/**

* gpt-4o-mini语言模型接入测试

*/

@Test

public void testGPTDemo() {

//初始化模型

OpenAiChatModel model = OpenAiChatModel.builder()

//LangChain4j提供的代理服务器,该代理服务器会将演示密钥替换成真实密钥, 再将请求转发给OpenAI API

.baseUrl("http://langchain4j.dev/demo/openai/v1")

.apiKey("demo") //设置模型apiKey

.modelName("gpt-4o-mini") //设置模型名称

.build();

//向模型提问

String answer = model.chat("你好");

//输出结果

System.out.println(answer);

}

}

4、SpringBoot整合

参考文档: https://docs.langchain4j.dev/tutorials/spring-boot-integration

4.1、替换依赖

将 langchain4j-open-ai 替换成 langchain4j-open-ai-spring-boot-starter

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j-open-ai-spring-boot-starter</artifactId>

</dependency>

4.2、配置模型参数

#langchain4j测试模型

langchain4j.open-ai.chat-model.base-url=http://langchain4j.dev/demo/openai/v1

langchain4j.open-ai.chat-model.api-key=demo

langchain4j.open-ai.chat-model.model-name=gpt-4o-mini

#请求和响应日志

langchain4j.open-ai.chat-model.log-requests=true

langchain4j.open-ai.chat-model.log-responses=true

#启用日志debug级别

logging.level.root=debug

4.3、创建测试用例

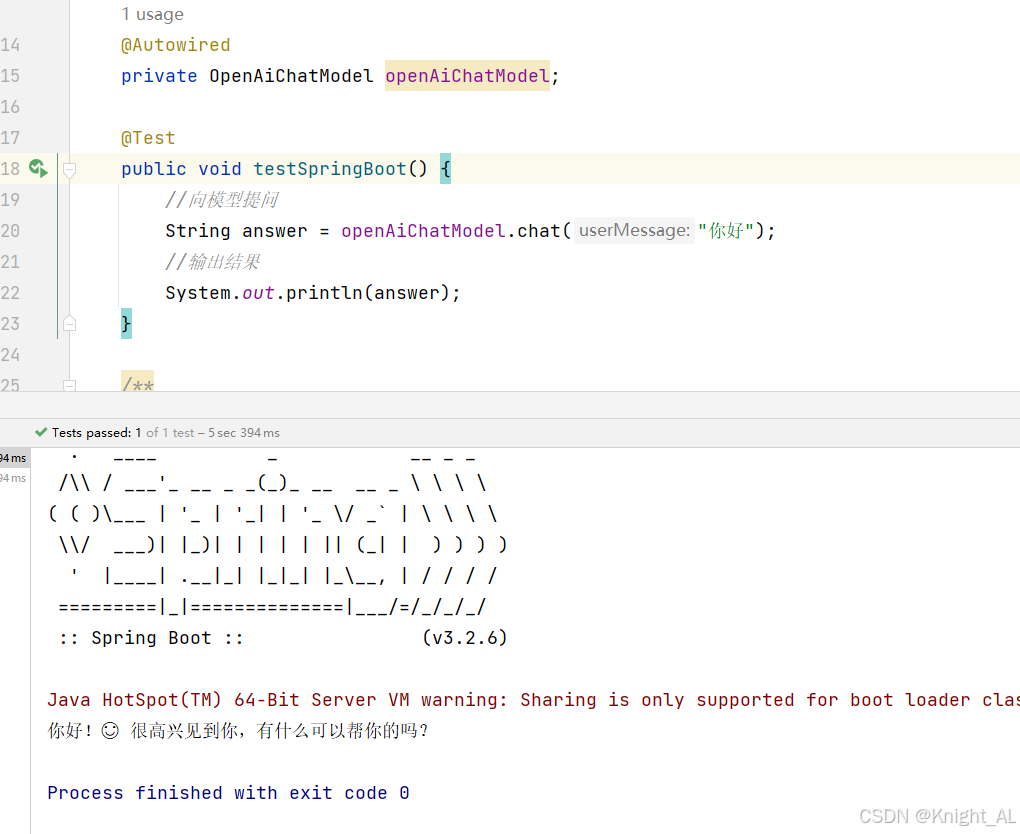

/**

* 整合SpringBoot

*/

@Autowired

private OpenAiChatModel openAiChatModel;

@Test

public void testSpringBoot() {

//向模型提问

String answer = openAiChatModel.chat("你好");

//输出结果

System.out.println(answer);

}

二、接入其他大模型

1、都有哪些大模型

- 大语言模型排行榜: https://superclueai.com/

SuperCLUE 是由国内 CLUE 学术社区于 2023 年 5 月推出的中文通用大模型综合性评测基准。

-

评测目的:全面评估中文大模型在语义理解、逻辑推理、代码生成等 10 项基础能力,以及涵盖数学、物理、社科等 50 多学科的专业能力,旨在回答在通用大模型发展背景下,中文大模型的效果情况,包括不同任务效果、与国际代表性模型的差距、与人类的效果对比等问题。

-

特色优势:针对中文特性任务,如成语、诗歌、字形等设立专项评测,使评测更符合中文语言特点。通过 3700 多道客观题和匿名对战机制,动态追踪国内外主流模型,如 GPT-4、文心一言、通义千问等的表现差异,保证评测的客观性和时效性。

-

行业影响:作为中文领域权威测评社区,其评测结果被学界和产业界广泛引用,例如商汤 “日日新 5.0” 和百度文心大模型均通过 SuperCLUE 验证技术突破,推动了中文 NLP 技术生态的迭代,为中文大模型的发展和优化提供了重要的参考依据,促进了中文大模型技术的不断进步和应用。

-

LangChain4j支持接入的大模型:https://docs.langchain4j.dev/integrations/language-models/

2、接入DeepSeek

1.1、获取开发参数

- 访问官网: https://www.deepseek.com/ 注册账号,获取base_url和api_key,充值

1.2、配置开发参数

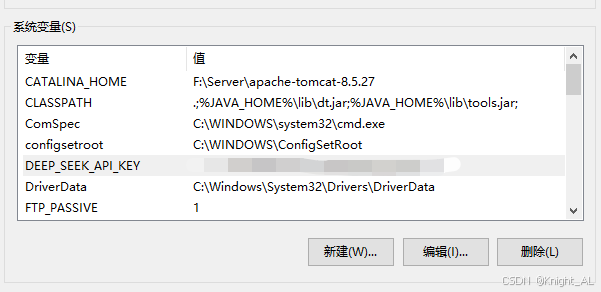

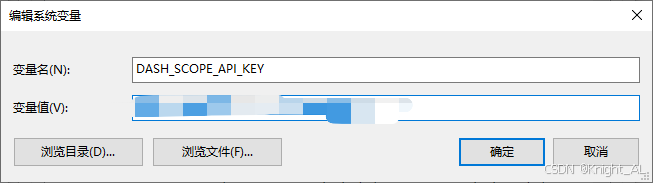

为了apikay的安全,建议将其配置在服务器的环境变量中。变量名自定义即可,例如 DEEP_SEEK_API_KEY

1.3、配置模型参数

DeepSeek API文档: https://api-docs.deepseek.com/zh-cn/

在 LangChain4j 中,DeepSeek 和 GPT 一样也使用了 OpenAI 的接口标准,因此也使用OpenAiChatModel进行接入

#DeepSeek

langchain4j.open-ai.chat-model.base-url=https://api.deepseek.com

langchain4j.open-ai.chat-model.api-key=${DEEP_SEEK_API_KEY}

#DeepSeek-V3

langchain4j.open-ai.chat-model.model-name=deepseek-chat

#DeepSeek-R1 推理模型

#langchain4j.open-ai.chat-model.model-name=deepseek-reasoner

记得重启IDEA

1.4、测试

直接使用前面的测试用例即可

3、ollama本地部署

3.1、为什么要本地部署

Ollama 是一个本地部署大模型的工具。使用 Ollama 进行本地部署有以下多方面的原因:

- 数据隐私与安全:对于金融、医疗、法律等涉及大量敏感数据的行业,数据安全至关重要。

- 离线可用性:在网络不稳定或无法联网的环境中,本地部署的 Ollama 模型仍可正常运行。

- 降低成本:云服务通常按使用量收费,长期使用下来费用较高。而 Ollama 本地部署,只需一次性投入硬件成本,对于需要频繁使用大语言模型且对成本敏感的用户或企业来说,能有效节约成本。

- 部署流程简单:只需通过简单的命令 “ollama run < 模型名>”,就可以自动下载并运行所需的模型。

- 灵活扩展与定制:可对模型微调,以适配垂直领域需求。

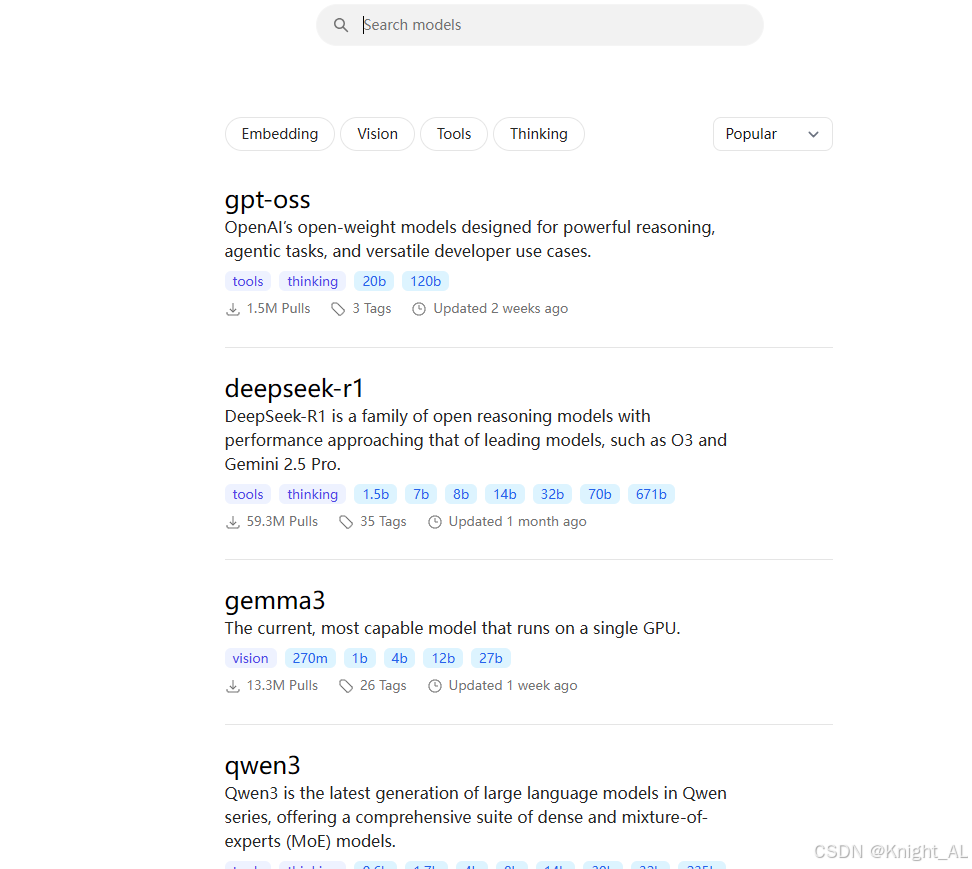

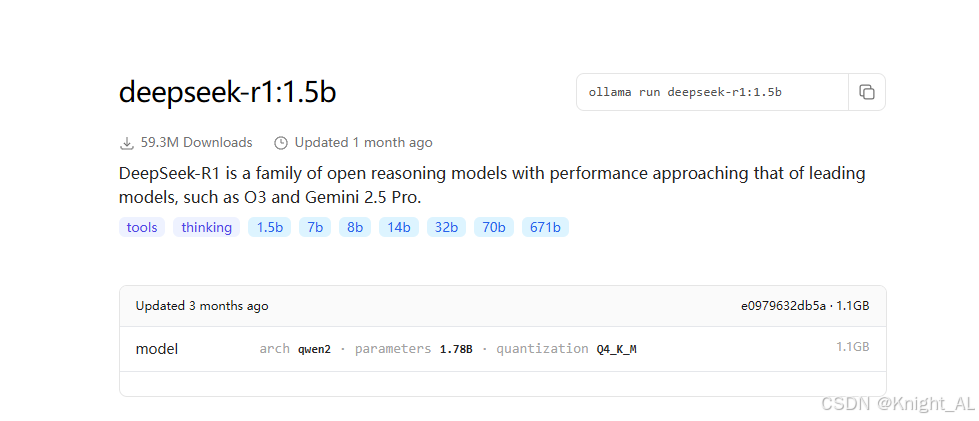

3.2、在ollama上部署DeepSeek

官网: https://ollama.com/

(1)下载并安装ollama:OllamaSetup.exe

(2)查看模型列表,选择要部署的模型,模型列表: https://ollama.com/search

(3)执行命令:ollama run deepseek-r1:1.5b运行大模型。如果是第一次运行则会先下载大模型

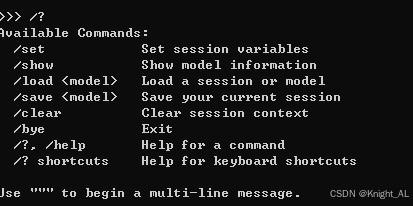

3.3、常用命令

3.4、引入依赖

参考文档: https://docs.langchain4j.dev/integrations/language-models/ollama#get-started

<!-- 接入ollama -->

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j-ollama-spring-boot-starter</artifactId>

</dependency>

3.5、配置模型参数

#ollama

langchain4j.ollama.chat-model.base-url=http://localhost:11434

langchain4j.ollama.chat-model.model-name=deepseek-r1:1.5b

# 创造性控制

# 0.7到1.2:适用于需要较高创造性的场景,如诗歌生成或头脑风暴

# 0.3到1.0:适用于需要较高稳定性和多样性的场景,如技术文档或法律文书的生成

langchain4j.ollama.chat-model.temperature=0.8

# 模型进行通信的超时时间为60秒。

langchain4j.ollama.chat-model.timeout=PT60S

langchain4j.ollama.chat-model.log-requests=true

langchain4j.ollama.chat-model.log-responses=true

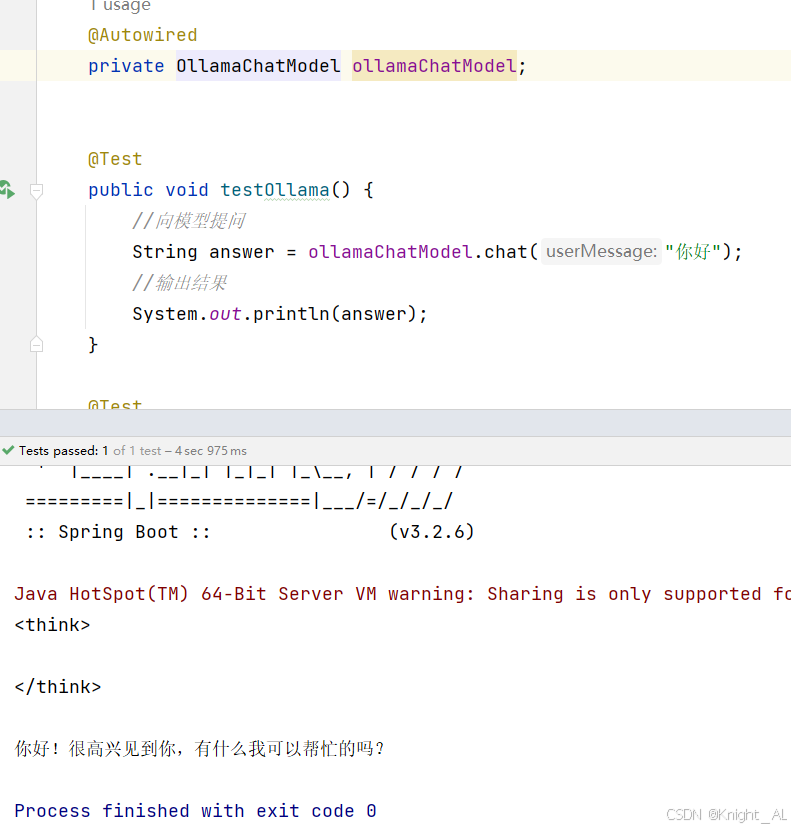

3.6、创建测试用例

/**

* ollama接入

*/

@Autowired

private OllamaChatModel ollamaChatModel;

@Test

public void testOllama() {

//向模型提问

String answer = ollamaChatModel.chat("你好");

//输出结果

System.out.println(answer);

}

4、接入阿里百炼平台

4.1、什么是阿里百炼

-

阿里云百炼是 2023 年 10 月推出的。它集成了阿里的通义系列大模型和第三方大模型,涵盖文本、图像、音视频等不同模态。

-

功能优势:集成超百款大模型 API,模型选择丰富;5-10 分钟就能低代码快速构建智能体,应用构建高效;提供全链路模型训练、评估工具及全套应用开发工具,模型服务多元;在线部署可按需扩缩容,新用户有千万 token 免费送,业务落地成本低。

-

模型广场: https://bailian.console.aliyun.com/?productCode=p_efm#/model-market

4.2、申请免费体验

(1)点击进入免费体验页面

(2)点击免费体验

(3)点击开通服务

(4)确认开通

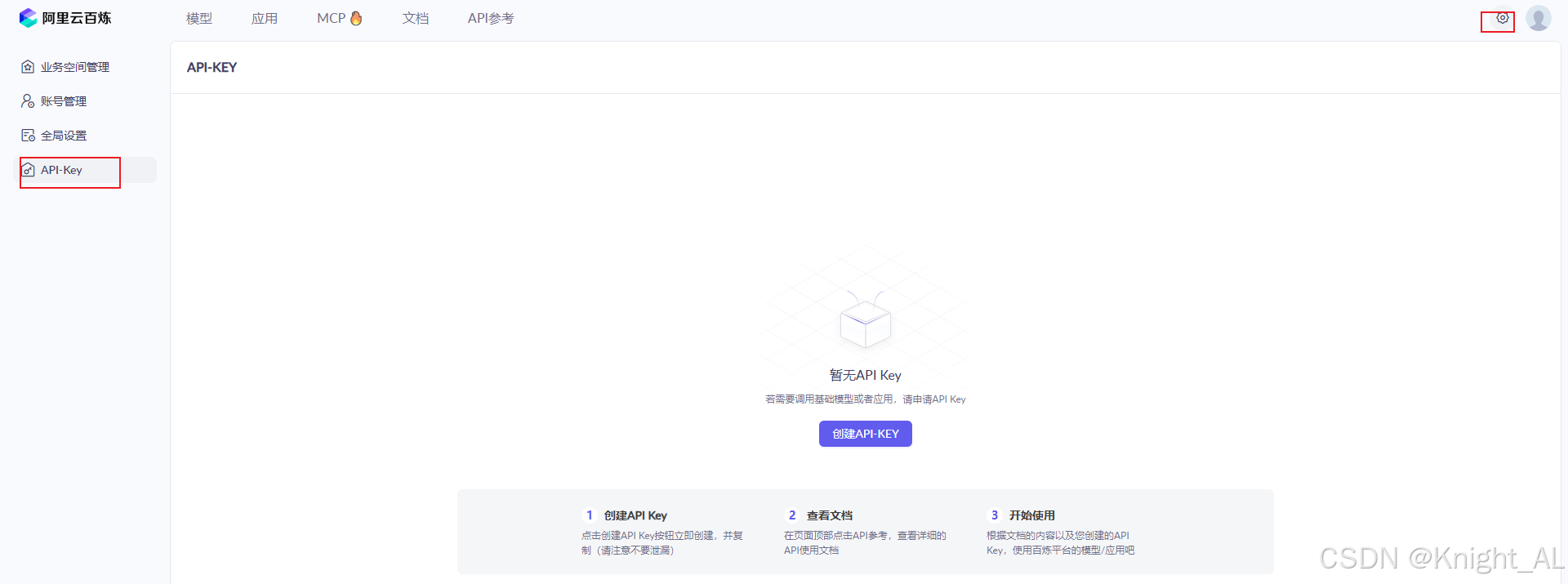

4.3、配置apiKey

申请apiKey: https://bailian.console.aliyun.com/?apiKey=1&productCode=p_efm#/api-key

配置apiKey:配置在环境变量DASH_SCOPE_API_KEY中

4.4、添加依赖

LangChain4j参考文档: https://docs.langchain4j.dev/integrations/language-models/dashscope#plain-java

<dependencies>

<!-- 接入阿里云百炼平台 -->

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j-community-dashscope-spring-boot-starter</artifactId>

</dependency>

</dependencies>

<dependencyManagement>

<dependencies>

<!--引入百炼依赖管理清单-->

<dependency>

<groupId>dev.langchain4j</groupId>

<artifactId>langchain4j-community-bom</artifactId>

<version>${langchain4j.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>

4.5、配置模型参数

#阿里百炼平台

langchain4j.community.dashscope.chat-model.api-key=${DASH_SCOPE_API_KEY}

langchain4j.community.dashscope.chat-model.model-name=qwen-max

4.6、测试通义千问

/**

* 通义千问大模型

*/

@Autowired

private QwenChatModel qwenChatModel;

@Test

public void testDashScopeQwen() {

//向模型提问

String answer = qwenChatModel.chat("你好");

//输出结果

System.out.println(answer);

}

4.6、测试通义万相

生成图片测试

@Test

public void testDashScopeWanx(){

WanxImageModel wanxImageModel = WanxImageModel.builder()

.modelName("wanx2.1-t2i-plus")

.apiKey(System.getenv("DASH_SCOPE_API_KEY"))

.build();

Response<Image> response = wanxImageModel.generate("奇幻森林精灵:在一片弥漫着轻柔薄雾的古老森林深处,阳光透过茂密枝叶洒下金色光斑。一位身材娇小、长着透明薄翼的精灵少女站在一朵硕大的蘑菇上。她有着海藻般的绿色长发,发间点缀着蓝色的小花,皮肤泛着珍珠般的微光。身上穿着由翠绿树叶和白色藤蔓编织而成的连衣裙,手中捧着一颗散发着柔和光芒的水晶球,周围环绕着五彩斑斓的蝴蝶,脚下是铺满苔藓的地面,蘑菇和蕨类植物丛生,营造出神秘而梦幻的氛围。");

System.out.println(response.content().url());

}

4.7、测试DeepSeek

也可以在阿里百炼上集成第三方大模型,如DeepSeek

将配置参数上的base-url参数指定到百炼平台,使用百炼上的大模型名称和apiKey即可

#集成百炼-deepseek

langchain4j.open-ai.chat-model.base-url=https://dashscope.aliyuncs.com/compatible-mode/v1

langchain4j.open-ai.chat-model.api-key=${DASH_SCOPE_API_KEY}

langchain4j.open-ai.chat-model.model-name=deepseek-v3

#温度系数:取值范围通常在 0 到 1 之间。值越高,模型的输出越随机、富有创造性;

# 值越低,输出越确定、保守。这里设置为 0.9,意味着模型会有一定的随机性,生成的回复可能会比较多样化。

langchain4j.open-ai.chat-model.temperature=0.9

使用之前的测试用例testSpringBoot测试即可

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)