LightRAG

LightRAG 通过轻量化图谱索引与灵活检索策略,解决了传统 RAG 在动态更新与复杂关系推理上的瓶颈,特别适合需快速响应、资源受限的场景。其开源生态(支持 OpenAI/Ollama/Hugging Face 模型)和模块化存储设计,进一步降低了企业部署门槛。开发者可通过GitHub 项目获取完整代码与案例。

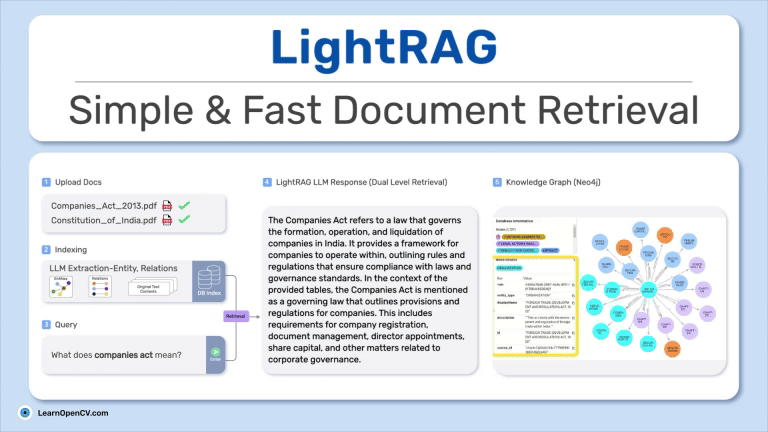

LightRAG 是一个轻量级检索增强生成(Retrieval-Augmented Generation, RAG)框架,由香港大学数据科学实验室开发,旨在通过结合知识图谱与向量检索技术,提升传统 RAG 系统在效率、动态更新和复杂关系推理上的能力。以下从核心特性、技术架构、应用场景及实践示例展开详细介绍:

LightRAG 是一个轻量级检索增强生成(Retrieval-Augmented Generation, RAG)框架,由香港大学数据科学实验室开发,旨在通过结合知识图谱与向量检索技术,提升传统 RAG 系统在效率、动态更新和复杂关系推理上的能力。以下从核心特性、技术架构、应用场景及实践示例展开详细介绍:

一、核心特性与设计目标

-

图增强索引

-

自动构建知识图谱:从文档中提取实体(如人物、地点、事件)和关系(如“深蹲训练股四头肌”),构建结构化图谱,捕捉数据间的复杂关联。

-

增量更新机制:新文档可直接合并至现有图谱,无需全量重建索引,降低计算开销(传统 RAG 重建需消耗数十万 token,LightRAG 仅需 <100 token)。

-

-

双层检索范式

-

Local 模式:聚焦查询中的具体实体,检索邻近节点(如“阿里巴巴的主要业务” → 关联“淘宝”“天猫”)。

-

Global 模式:从高层概念出发遍历全图(如“互联网发展趋势” → 关联“AI 技术推动行业升级”)。

-

Hybrid/Mix 模式:结合局部与全局检索,支持复杂推理(如“马云的创业历程”同时检索具体事件与商业理念)。

-

-

高效轻量化设计

-

单次 API 调用:相比 GraphRAG 的多次调用,LightRAG 通过单次检索整合多源上下文,响应速度达毫秒级(Local 模式 0.1–0.3 秒)。

-

资源消耗优化:支持在边缘设备(如移动端)部署,适应低带宽环境。

-

二、技术架构详解

-

模块化存储层

-

向量存储:默认集成

NanoVectorDB,支持替换为 Faiss/Milvus,处理文本嵌入。 -

图谱存储:默认

NetworkX,可扩展至 Neo4j 等,管理实体关系。 -

键值存储:使用

JsonKVStorage或 Redis,缓存文档状态与 LLM 响应。

-

-

智能文档处理管道

流程包括:文档分块(默认 1200 token/块)→ 实体关系提取(LLM 驱动)→ 图谱构建 → 向量嵌入生成。支持多模态数据(如 CLIP 模型处理图像)。

-

多模式查询引擎

# 示例:混合检索模式 result = rag.query( "如何制定增肌计划?", param=QueryParam(mode="hybrid") # 可选 naive/local/global/mix )不同模式通过调整检索策略平衡速度与深度。

三、典型应用场景

-

垂直领域知识库

-

健身教练平台:构建动作、营养、训练原则的图谱,生成个性化计划(如“增肌需结合深蹲与高蛋白饮食”)。

-

法律合规分析:追溯条款关联性,回答“某合同是否符合最新法规”并引用具体条文。

-

-

实时交互系统

-

客服机器人:单次 API 调用整合历史工单与产品知识,响应速度支持千级 QPS。

-

学术研究助手:解析 PDF 论文,定位“神经网络算法的优缺点”及相关章节页码。

-

-

边缘计算场景

-

离线教育工具:在无网络环境下检索本地教材,生成学习提示。

-

物联网数据分析:轻量化设计适配 Raspberry Pi 等设备,本地处理传感器数据。

-

四、部署与实践

-

快速启动

git clone https://github.com/HKUDS/LightRAG.git pip install -e . python -m lightrag.api.lightrag_server # 启动服务(默认端口 9621) -

生产级部署

-

数据库配置:使用 Docker 部署 Neo4j 和 Redis:

docker run -d --name neo4j -p 7474:7474 -e NEO4J_AUTH=neo4j/password neo4j -

存储后端切换:在

.env中设置:LIGHTRAG_GRAPH_STORAGE=Neo4JStorage LIGHTRAG_VECTOR_STORAGE=FaissVectorDBStorage

-

-

性能优化建议

-

分块策略:调整

chunk_token_size(默认 1200)平衡检索精度与速度。 -

轻量模型:选用

GPT-4o-mini或GLM-4-Flash降低 API 成本。

-

五、与同类框架对比

|

维度 |

LightRAG |

GraphRAG |

|---|---|---|

|

检索效率 |

单次 API 调用(<100 token) |

多次调用(600–10k token) |

|

更新成本 |

增量更新,无需重建图谱 |

全量重建 |

|

适用场景 |

实时交互、边缘计算 |

深度推理(如医疗诊断) |

|

硬件要求 |

低(支持移动端) |

高性能 GPU |

六、总结

LightRAG 通过轻量化图谱索引与灵活检索策略,解决了传统 RAG 在动态更新与复杂关系推理上的瓶颈,特别适合需快速响应、资源受限的场景。其开源生态(支持 OpenAI/Ollama/Hugging Face 模型)和模块化存储设计,进一步降低了企业部署门槛。开发者可通过 GitHub 项目获取完整代码与案例。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)