AI基础概念

摘要 梯度下降是一种通过迭代优化寻找函数最小值的方法,其核心思想是沿着函数梯度的反方向逐步调整参数。梯度方向指示了函数变化最快的上升方向,因此其反方向即为最快下降路径。关键参数学习率η控制步长,需平衡收敛速度与精度。反向传播算法则利用链式法则高效计算神经网络中的梯度,实现参数优化。这两种方法共同构成了深度学习模型训练的基础。

1.梯度下降:

首先,我们有一个可导的函数。这个函数就代表着一座山。我们的目标就是找到这个函数的最小值,也就是山底。根据之前的场景假设,最快的下山的方式就是找到当前位置最陡峭的方向,然后沿着此方向向下走,对应到函数中,就是找到给定点的梯度 ,然后朝着梯度相反的方向,就能让函数值下降的最快!因为梯度的方向就是函数之变化最快的方向(在后面会详细解释)

所以,我们重复利用这个方法,反复求取梯度,最后就能到达局部的最小值,这就类似于我们下山的过程。而求取梯度就确定了最陡峭的方向,也就是场景中测量方向的手段。那么为什么梯度的方向就是最陡峭的方向呢?首先梯度是什么?

1.1梯度

一阶函数里梯度就是表示某一函数在该点处的方向导数沿 着该方向取得较大值,即函数在当前位置的导数。 如果函数为一元函数,梯度就是该函数的导数。

而多元函数中,我们可以看到,梯度就是分别对每个变量进行偏导,然后用逗号分割开,梯度是用<>包括起来,说明梯度其实一个向量,向量有方向,梯度的方向就指出了函数在给定点的上升最快的方向。

这也就说明了为什么我们需要千方百计的求取梯度!我们需要到达山底,就需要在每一步观测到此时最陡峭的地方,梯度就恰巧告诉了我们这个方向。梯度的方向是函数在给定点上升最快的方向,那么梯度的反方向就是函数在给定点下降最快的方向, 这正是我们所需要的。所以我们只要沿着梯度的方向一直走,就能走到局部的最低点!

1.2 核心公式

此公式的意义是:f 是关于Θ的一个函数,我们当前所处的位置为Θ0点,要从这个点走到 f 的最小值点,也就是山底。首先我们先确定前进的方向,也就是梯度的反向,然后走一段距离的步长,也就是η,走完这个段步长,就到达了Θ这个点!

η 在梯度下降算法中被称作为学习率或者步长,意味着我们可以通过η来控制每一步走的距离,步长太大走的就容易偏离路线,其实就是不要走太快,错过了最低点。同时也要保证不要走的太慢,导致太阳下山了,还没有走到山下。所以η的选择在梯度下降法中往往是很重要的!η不能太大也不能太小,太小的话,可能导致迟迟走不到最低点,太大的话,会导致错过最低点!

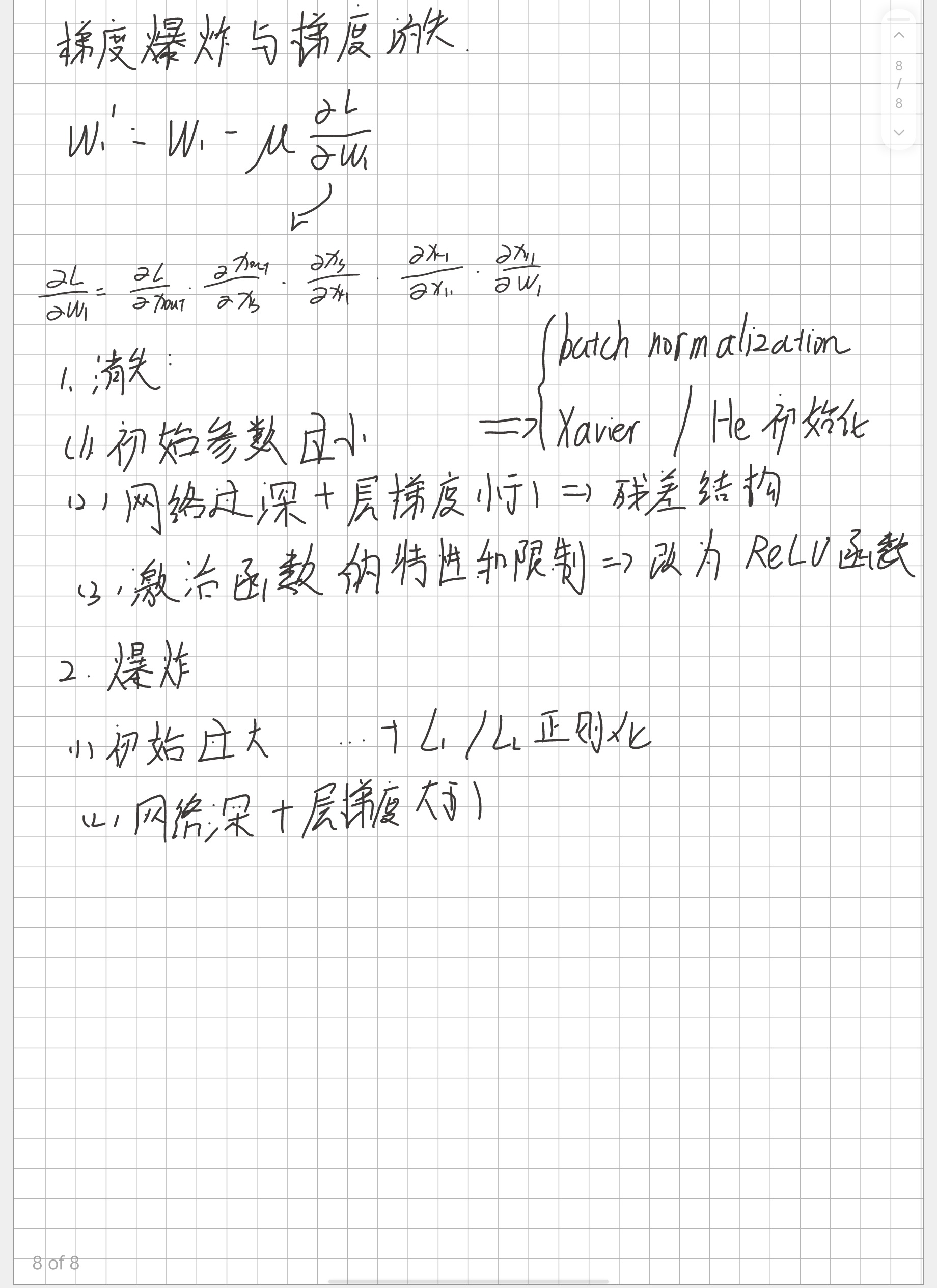

2反向传播算法

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)