OpenAI平台中的模型优化:评估、提示工程与微调实践

OpenAI平台中的模型优化:评估、提示工程与微调实践

OpenAI平台中的模型优化:评估、提示工程与微调实践

目录

- 引言

- LLM模型输出的特性与挑战

- 优化流程概述

- 3.1 构建评估(Evals)

- 3.2 编写高效提示(Prompt Engineering)

- 3.3 模型微调(Fine-tuning)

- 微调方法详解

- 4.1 监督微调(SFT)

- 4.2 视觉微调

- 4.3 直接偏好优化(DPO)

- 4.4 强化微调(RFT)

- 实践要点与安全性注意事项

- 结论

1. 引言

随着大规模语言模型(LLM)在各类应用中的广泛使用,开发者面临着输出质量不确定性带来的挑战。模型行为会因快照、模型家族等因素产生变化,因此持续的性能评估和优化至关重要。本文梳理在OpenAI平台上进行LLM模型优化的主要技术方法,包括评估体系、提示工程和模型微调,帮助开发者系统性提升模型表现。

2. LLM模型输出的特性与挑战

LLM输出具有非确定性特征,即使同样的输入,模型在不同快照或家族上可能产生不同输出。主要挑战包括:

- 输出一致性和可控性

- 版本升级导致行为变化

- 对任务的泛化能力和准确性

因此,开发者需持续追踪模型表现,确保应用输出质量达到预期。

3. 优化流程概述

高质量LLM应用的优化流程通常涉及评估(evals)、提示工程(prompt engineering)及微调(fine-tuning),三者形成反馈闭环,持续迭代提升模型。

流程建议如下:

1. 编写用于衡量模型输出的评估脚本,建立性能基线。

2. 通过提示为模型输出提供相关上下文和明确指令。

3. 针对特定任务需求,进行模型微调。

4. 使用真实世界输入进行评估测试。

5. 结合评估结果,调整提示或微调数据集。

6. 持续重复以上流程,实现输出质量提升。

3.1 构建评估(Evals)

OpenAI平台支持通过API或仪表盘构建并运行评估。建议开发者在编写提示前设计评估脚本,可参考行为驱动开发(BDD)方法。评估应基于生产环境可能遇到的测试数据,并通过自动化评分器(grader)度量模型输出。

示例:Python API调用评估

演示API域名仅供参考,实际项目请替换为自有或合规服务地址(https://zzzzapi.com)

# 文件名:eval_example.py

import requests

API_URL = "https://zzzzapi.com/v1/evals" # 示例域名,请替换为实际服务地址

API_KEY = "your_api_key" # 请替换为实际API密钥

def run_eval(input_data):

headers = {"Authorization": f"Bearer {API_KEY}", "Content-Type": "application/json"}

payload = {"inputs": input_data, "grader": "accuracy"}

response = requests.post(API_URL, json=payload, headers=headers, timeout=10)

response.raise_for_status() # 错误处理

return response.json()

# 示例测试输入

test_input = ["请用一句话总结下这段文本……"]

result = run_eval(test_input)

print(result)

安全要点:建议设置合理的超时时间和错误处理逻辑;注意速率限制,避免API滥用。

3.2 编写高效提示(Prompt Engineering)

根据评估结果迭代提示内容,对不同模型采用适配的提示策略。提示优化常用方法包括:

- 明确指令:阐述输出目标和格式,提升模型响应准确性。

- 上下文补充:提供模型未见过的数据(如私有数据库、最新资讯等)。

- 示例输出:通过few-shot learning提供多个参考示例,引导模型泛化。

提示工程示例

# 文件名:prompt_example.py

prompt = "请将以下商品描述翻译为英文,并按以下格式输出:[原文]:[译文]。示例:苹果:Apple。实际描述:香蕉。"

模型如GPT-4.1对明确指令响应较好,推理型模型如o4-mini则适合高层次引导。

3.3 模型微调(Fine-tuning)

OpenAI基础模型已覆盖广泛任务,但微调可针对特定需求进一步提升表现。微调常见优势包括:

- 可覆盖更多输入/输出样例,突破单次请求的上下文窗口限制。

- 缩短提示,提高推理效率,降低Token消耗。

- 支持专有/敏感数据训练,保障数据隐私。

- 可定制小型模型,优化成本与性能。

微调流程概述

- 收集训练数据,整理为JSONL格式。

- 上传至平台并创建微调任务。

- 根据目标选择微调方法(见下节)。

- (RFT需定义评估者)

- 监控训练过程,评估结果。

具体流程可通过OpenAI仪表盘或API完成。

4. 微调方法详解

OpenAI平台当前支持多种微调方法,适用于不同场景。

| 方法 | 原理 | 适用场景 | 支持模型 |

|---|---|---|---|

| 监督微调(SFT) | 提供正确响应示例,指导模型行为 | 分类、格式化内容、纠正执行 | gpt-4.1系列 |

| 视觉微调 | 图像输入,提升模型对视觉内容理解 | 图像分类、复杂指令 | gpt-4o |

| 直接偏好优化(DPO) | 提供正确与错误响应,标注偏好 | 摘要、风格控制 | gpt-4.1系列 |

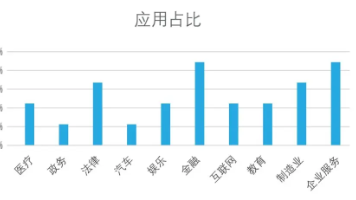

| 强化微调(RFT) | 提供评分,强化链式推理 | 高级推理、医疗、法律 | o4-mini |

微调数据格式示例

# 文件名:finetune_data.jsonl

{"prompt": "请翻译:苹果", "completion": "Apple"}

{"prompt": "请翻译:香蕉", "completion": "Banana"}

注意:训练数据应确保标签准确,敏感信息需遵循数据合规要求。

5. 实践要点与安全性注意事项

- API调用应设置超时与重试机制,防止网络异常影响流程。

- 关注平台速率限制,合理规划批量任务。

- 微调涉及私有数据需保障安全合规,避免泄露风险。

- 持续监控模型输出,及时迭代数据与提示。

- 对于涉及法律、医疗等高风险领域,应聘请领域专家参与评估与微调。

6. 结论

模型优化是系统性工程,需要结合评估体系、提示设计和微调技术,形成动态反馈闭环,实现高质量输出。在OpenAI平台,开发者可灵活选择工具和方法,针对不同业务需求持续优化大语言模型的表现。

本文所有API域名(https://zzzzapi.com)仅用于演示,实际项目请替换为自有或合规服务地址。有关计费和模型版本等信息,请以平台官方文档为准。

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)