构建卓越LLM Agent的工程哲学:从Claude Code的设计精髓出发

构建卓越LLM Agent的工程哲学:从Claude Code的设计精髓出发

在AI Agent开发领域,Claude Code(以下简称CC)作为一款备受赞誉的编码 Agent工具,以其简洁高效的设计脱颖而出。它不仅仅是一个AI工作流,更是一种让用户感到“愉悦”的体验。根据对CC的深度使用、日志分析以及架构剖析,我们可以提炼出一套构建卓越LLM(Large Language Model) Agent的工程哲学。本文将从CC的设计精髓出发,探讨如何通过简洁性、可调试性和智能约束来打造强大而可靠的 Agent系统。无论是初学者还是资深开发者,这些洞察都能帮助你避免常见陷阱,实现高效的 Agent构建。

核心设计理念:简洁至上

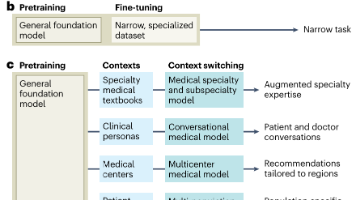

Claude Code的成功实践印证了一个核心原则:可调试性远胜于复杂性。在LLM Agent开发中,许多开发者倾向于引入多 Agent系统、复杂的RAG(Retrieval-Augmented Generation)算法或层层嵌套的抽象框架,但这些往往适得其反,导致系统难以调试和维护。CC则反其道而行之:它采用单一主循环架构,通过精心设计的控制流、提示词和工具集实现高效运作。这种“保持简单,笨蛋”(Keep It Simple, Stupid)的理念,让 Agent在处理复杂任务时既自主又可控,避免了“控制感丧失”的不安感。

正如CC的开发者所言,LLM本身已足够强大——如Claude 4模型的交错思考能力——无需过度工程化。相反,通过良好的“线束”(harness)约束模型,让它在专长领域(如代码理解)大放异彩,同时弥补其弱点(如上下文腐烂)。这种简洁哲学不仅降低了开发成本,还让 Agent更易扩展和迭代。如果你正在构建类似 Agent,从CC中汲取的第一个教训就是:把一切放在一个文件中,避免多余的样板代码,并至少“撕掉它几次”以验证鲁棒性。

架构设计要点

1. 控制循环设计

控制循环是 Agent的核心“心脏”,决定其响应效率和稳定性。CC的设计强调单一性和轻量化,避免多 Agent的复杂交接。

- 单一主循环:CC维护一个扁平的消息历史列表,仅允许最多一个分支。这意味着对于简单任务,通过迭代工具调用即可处理;对于复杂任务,主 Agent会生成自身的“克隆”作为子 Agent,但子 Agent无权进一步生成分支。结果以“工具响应”形式反馈到主历史中。这种设计确保了 Agent能分解子问题,同时保持对最终目标的专注。相比多 Agent系统(如LangChain的节点图),单一循环极大提升了可调试性——你无需追踪层层移交的抽象层,就能快速定位问题。

- 轻量化模型优先:CC超过50%的LLM调用使用claude-3-5-haiku等较小模型,这些模型比标准模型(如Sonnet 4或GPT-4.1)便宜70-80%。它们负责阅读大文件、解析网页、处理git历史和总结长对话,甚至包括一词标签处理。这种策略不仅降低了成本,还加速了响应时间。对于核心思考任务,才切换到更强大的模型。

- 自主任务管理:CC让 Agent自主维护待办清单(ToDo List),通过ToDoWrite工具创建和更新。这解决了长期运行 Agent的常见问题——上下文腐烂( Agent热情开局,却逐渐迷失方向)。不同于多 Agent的显式移交(e.g., PM Agent→实现者→QA),CC的待办清单由单一模型维护,利用LLM的交错思考能力实时插入或拒绝新项,确保灵活性和目标一致性。

2. 提示词工程体系

提示词(Prompts)是LLM Agent的“大脑指令”,CC的提示设计详尽而结构化,总计超过1.2万词元,确保模型行为一致。

-

系统化提示结构:系统提示约2800词元,覆盖语气、主动性、任务管理、工具使用策略和执行细节;工具描述占9400词元,包括日期、当前工作目录(CWD)、平台和OS信息,以及最近提交记录。用户提示总是包含claude.md文件(约1000-2000词元),这让每次交互都携带完整上下文。

-

claude.md模式:这是CC的创新之一,通过一个专用文件固化用户偏好和团队规范。例如,强制跳过某些文件夹、使用特定库,或定义代码风格。没有claude.md的CC性能会大打折扣。这类似于Cursor Rules或agent.md,已成为编码 Agent的标准模式。在实践中,你可以扩展为minusx.md等自定义文件,作为事实上下文源。

-

XML标签与Markdown融合

- 用于关键事项提醒,例如提醒模型待办清单为空时勿提及用户。

- /对比展示最佳实践,如优先使用绝对路径避免cd命令的好坏示例。

- Markdown用于分节,如“Tone and Style”、“Tool Use Policy”,使提示易读且逻辑清晰。

-

强调语句的有效性:现阶段,“IMPORTANT”、“VERY IMPORTANT”、“NEVER"和"ALWAYS"等强调措辞仍是引导模型的最佳方式。例如,“IMPORTANT: DO NOT ADD ANY COMMENTS unless asked”,或"VERY IMPORTANT: You MUST avoid using search commands like find and grep”。虽然这显得“丑陋”,但在模型可控性提升前,它是状态艺术(state-of-the-art)。

3. 工具设计策略

工具是 Agent的“手臂”,CC拒绝RAG,转而让LLM直接驱动搜索和操作,这大大减少了移动部件。

-

三级工具体系:

- 底层:Bash、Read、Write等基础操作,提供最大灵活性。

- 中层:Edit、Grep、Glob等常用功能,优化频繁任务(如Edit是最常用工具)。

- 高层:Task、WebFetch、exit_plan_mode等语义化操作,减少LLM的多步推理。

权衡在于使用频率 vs 精度:对于高频任务(如grep),专用工具更高效;特殊场景则用通用Bash。工具描述详尽,包括何时使用和选择策略。

-

LLM搜索优于RAG:CC使用ripgrep、jq和find等命令,让LLM生成复杂regex搜索代码库。这比RAG更灵活——模型可逐步阅读文件(如先看JSON前10行理解结构),避免分块、相似函数等隐性故障。更重要的是,这是RL(Reinforcement Learning)可优化的,符合BigLabs的趋势。作者将此比作“LLM时代的Camera vs Lidar”,强调直接连接智能系统的优雅性。

-

工具选择权衡:基于场景决定粒度。高层工具如WebFetch节省低级点击,保持 Agent“在轨道上”。所有工具提示充满示例,确保模型正确调用。

关键技术洞察

可控性设计

可控性是 Agent“人性化”的关键,CC通过细致规范确保输出优雅而不烦人。

- 语调与风格管控:系统提示有专用部分,禁止多余前言、说教或表情符号(除非用户要求)。示例如:“If you cannot help, do not say why, as it comes across as preachy。”这让CC的评论感觉“优雅”和热情。

- 算法显式说明:为关键任务编写流程图式算法,包括决策点、启发式和场景示例。例如,“Task Management”部分走通过分解任务的步骤,避免简单的Dos/Don’ts清单(后者易导致冲突)。这结构化了模型决策,提升鲁棒性。

- 实时策略调整:利用模型的交错思考动态管理任务清单,中途课程修正而不失焦点。

避免的陷阱

- 拒绝多 Agent交接:多层抽象偏离通用模型改进轨迹,增加调试难度。

- 警惕过度工程:复杂框架(如多 Agent或高级RAG)往往带来更多问题,而非解决方案。CC证明,简单 Agent也能处理复杂任务。

- 冲突指令规避:长提示词中,杂乱的Dos/Don’ts易产生矛盾,导致模型脆弱。优先用算法形式组织。

实践建议

- 从简入手:初期采用单一Agent架构,仅在必要时增加复杂度。测试时,优先使用较小模型处理辅助任务。

- 深度借鉴:研究Claude Code的提示词设计,特别是其算法说明部分。直接复制语气规范和XML标签,能快速提升你的 Agent。

- 持续重构:保持代码和架构的简洁性,定期进行彻底重构。记住:LLM Agent脆弱,任何额外复杂性都会放大调试成本。

- 关注官方实践:BigLab的设计(如JSON vs XML的选择)反映了对LLM RLHF数据分布的理解。逆向工程这些,能告知你的提示策略。

结论

Claude Code的成功证明了简洁性与精心设计的结合能够产生卓越的AI Agent体验。通过单一主循环、清晰的提示词结构和合理的工具设计,我们完全可以构建出既强大又可维护的LLM应用系统。最重要的是:保持简单,让模型在良好的约束框架中自主发挥其能力。这不仅仅是技术选择,更是一种工程哲学——在AI时代,简洁往往是通往卓越的捷径。

作者注:本文基于对Claude Code的深度使用和源码分析,更多技术细节可参考官方文档和相关技术博文(如MinusX博客)。如果您对构建类似 Agent感兴趣,欢迎讨论交流。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)