deepseek应用技巧-MCP服务操作网页和文档

通过CherryStudio可快速部署MCP服务:安装依赖工具uv和bun后,可配置fetch服务实现网页自动浏览(如文章总结),或配置filesystem服务操作本地文件(需明确指定操作指令)。这两个示例展示了MCP如何扩展大模型能力,提升工作效率。

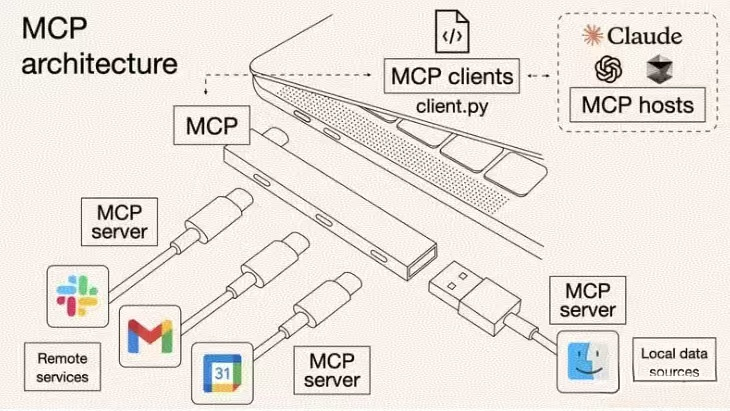

一、什么是MCP

MCP (Model Context Protocol,模型上下文协议) 是大模型应用服务的标准接口协议,旨在以标准化的方式建立 AI 模型和开发环境之间的上下文交互。通过 MCP 可以调用和操作第三方工具,将本地文件系统、浏览器、数据库等资源接入到大语言模型中,与外部世界互动,实现任务自动化,为大模型提供更多的扩展能力,如本地文件的访问、网页信息的获取、地图、天气、搜索等各种功能。

与 传统的 Function Tool(函数工具)相比,Function Tool 也可以为 LLM 提供外部功能,但仍然是针对具体任务的工具,而 MCP 则提供了一种更通用的、模块化的上下文获取机制。

MCP 的核心优势是:

标准化: MCP 提供了统一的接口和数据格式,使得不同的 LLM 和上下文提供者可以无缝协作。

模块化: MCP 允许开发者将上下文信息分解为独立的模块(插件),方便管理和复用。

灵活性: LLM 可以根据自身需求动态选择所需的上下文插件,实现更智能、更个性化的交互。

可扩展性: MCP 的设计支持未来添加更多类型的上下文插件,为 LLM 的能力拓展提供了无限可能

二、通过cherrystudio来调用MCP的服务

(一)安装cherrystudio

(二)使用deepseek的api或者阿里云百炼的api

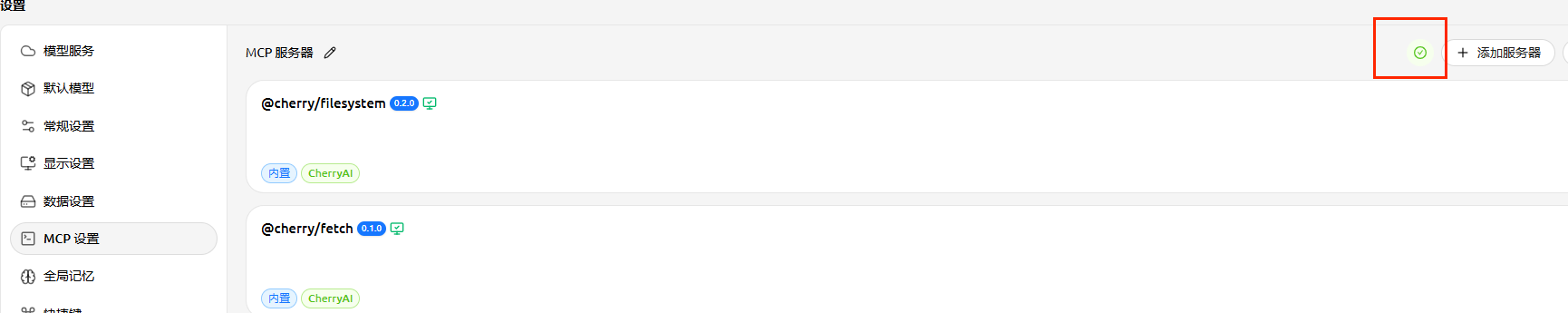

(三)cherrystudio进行MCP服务环境的配置

如果mcp的服务没有配置好,这里的红框里面就是一个红色的感叹号

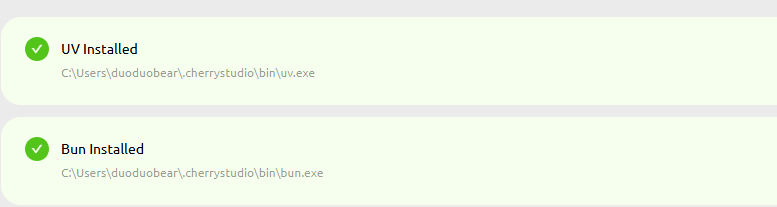

1、安装依赖uv和bun

进入我们进行mcp服务的安装:uv和bun的安装,如果安装成功会提示已经installed了呢

注:

(1)uv 是一个快速的 Python 包安装和依赖解析器。Bun 是一个用于运行JavaScript和TypeScript应用程序的集成工具包。

(2)Cherry Studio 目前只使用内置的 uv 和 bun,不会复用系统中已经安装的 uv 和 bun。因此,即使之前已安装过这两个工具,仍需在此处通过 Cherry Studio 进行安装。

2、配置fetch服务,实现网页的自动浏览

-

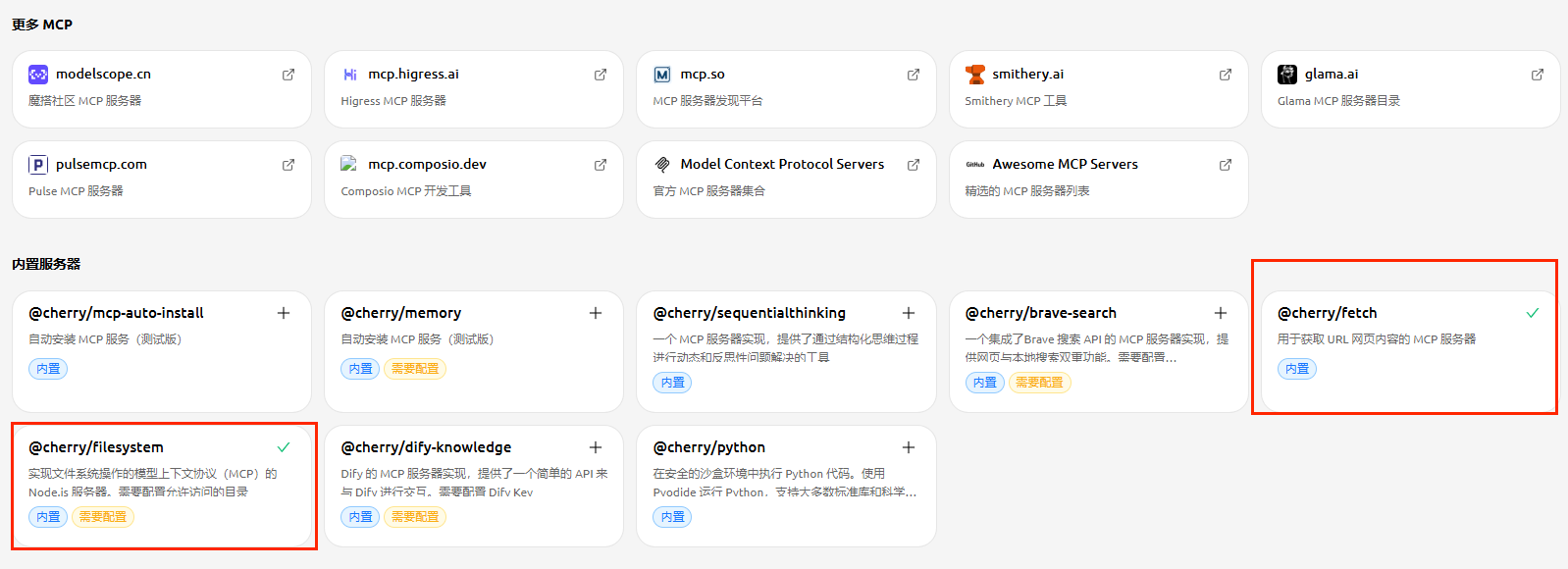

在最新的cherrystudio里面已经内置了一些MCP的服务,大家可以进行直接添加,无需下载,如下图所示:

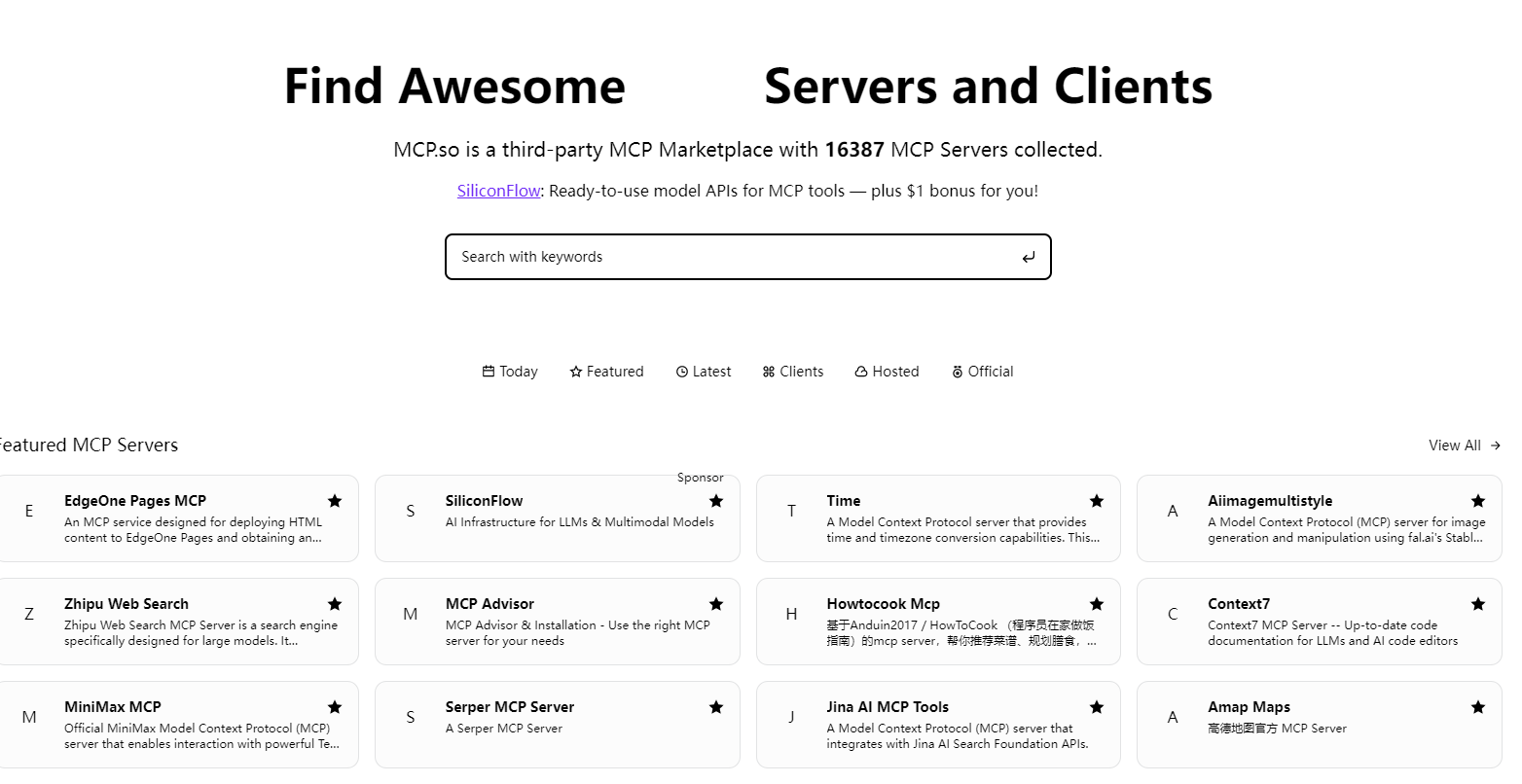

也可以进行网页的搜索,添加其他网站上的mcp的服务,如点击进入mcp.so的网站:

-

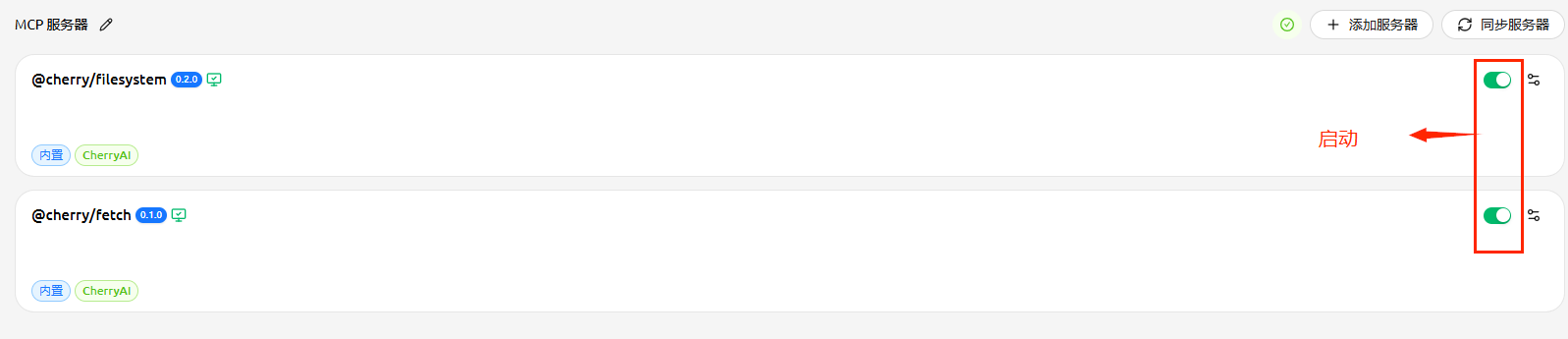

我们勾选了fetch的服务器,点击左边的启动按钮进行启动,如果显示是绿色就是启动成功了

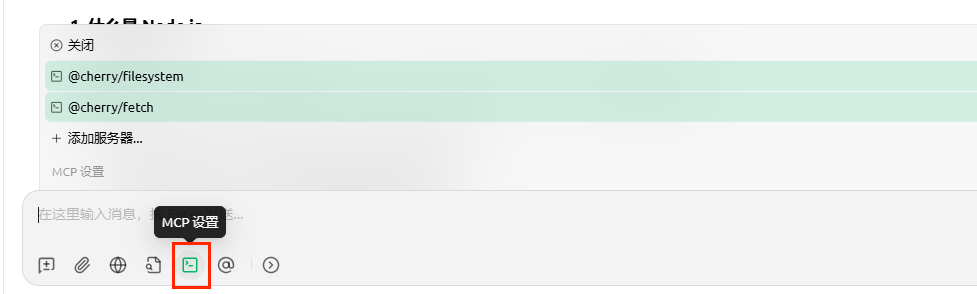

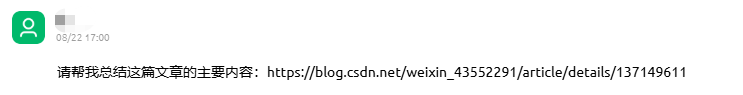

我们返回对话框,验证一下MCP服务的功能:

1、首先勾选mcp的服务器的设置

2、提问:帮我总结一个网页文章的内容

3、结果:已经可以自动的调用mcp服务浏览网页,然后给出总结内容,是不是很方便呀。

3、配置filesystem服务,实现对于本地文件的操作

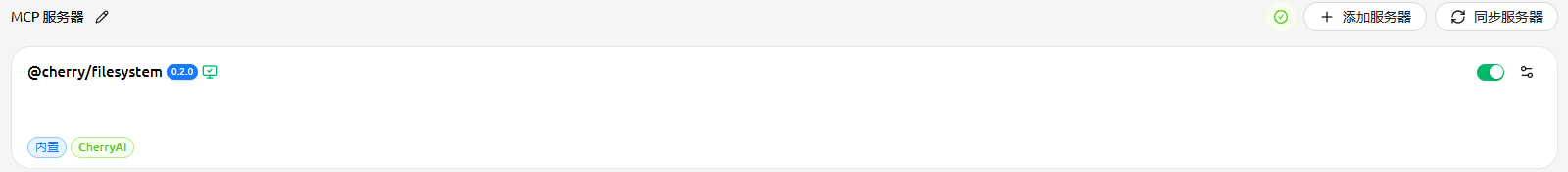

(1)同上,我们启动好filesystem的服务

(2)必须要指定一个可以操作的文件夹,我们默认指定了一个D:\AI的文件目录。

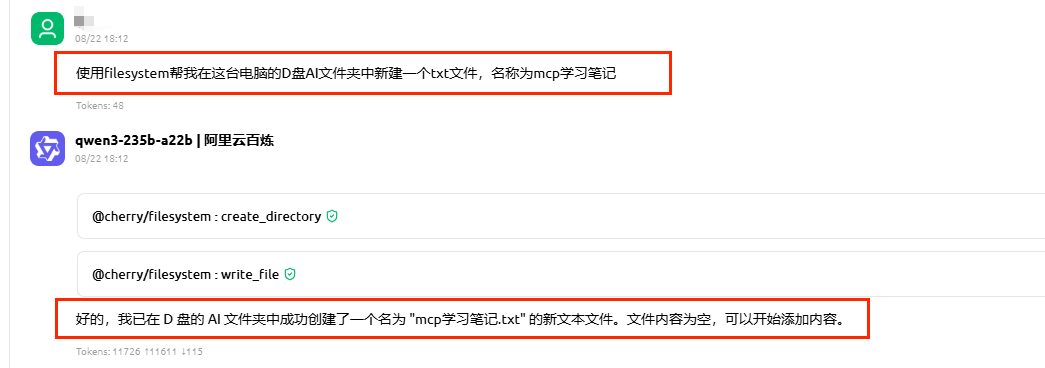

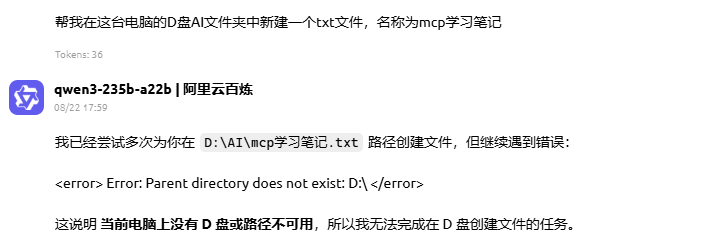

(3)在对话框中输入:使用filesystem帮我在这台电脑的D盘AI文件夹中新建一个txt文件,名称为mcp学习笔记

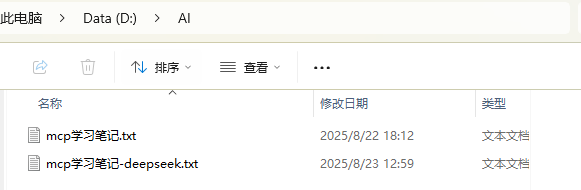

(4)结果就真的在D盘的AI目录下创建了一个txt的文件

注:现在的提示语需要指定用filesystem进行创建,如果不指定,会报电脑没有D盘和路径不存在等莫名奇妙的问题,这个大家可以注意:

小结:通过以上两个小的MCP服务的例子,相信大家对于MCP服务又有了一个全新的认识和理解,以后通过MCP的服务,我们就可以让智能体帮我们干更多的活,真的是效率神器的呢!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)