零成本体验免费大模型API平台

在当前AI技术快速发展的浪潮中,越来越多的企业希望借助大模型的力量来提升业务效率和用户体验。然而,高昂的部署成本、复杂的运维流程以及技术门槛,往往让不少企业望而却步。白山云科技推出的平台提供大模型API服务,正是为解决这些问题而生——为开发者和企业提供高效、低成本的模型服务,用户无需自建硬件或进行复杂配置,仅通过 API 调用模型,让无论是开发者是非技术人员,都能轻松将AI应用落地,实现业务升级。

在当前AI技术快速发展的浪潮中,越来越多的企业希望借助大模型的力量来提升业务效率和用户体验。然而,高昂的部署成本、复杂的运维流程以及技术门槛,往往让不少企业望而却步。

白山云科技推出的白山智算平台提供大模型API服务,正是为解决这些问题而生——为开发者和企业提供高效、低成本的模型服务,用户无需自建硬件或进行复杂配置,仅通过 API 调用模型,让无论是开发者是非技术人员,都能轻松将AI应用落地,实现业务升级。

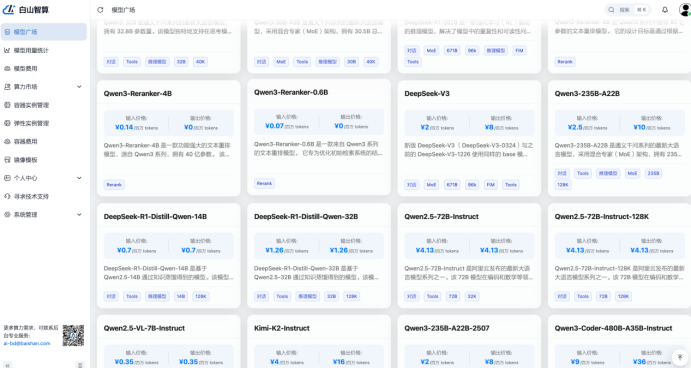

丰富的开源大模型

白山智算平台集成主流的开源大模型,包括:DeepSeek-R1、DeepSeek-V3、Qwen2.5、Qwen3、Kimi、BAAI/bge等大语言模型。基于白山全球边缘云架构优势,打造超低延时、超稳定、简单易用的API接口服务,降低大模型应用成本和开发门槛,助力企业和个人用户快速开启AI创新之旅。

多模态模型:支持自然语言理解、文本生成、代码生成等场景模型。

适用场景:适配多行业应用场景如自然语言处理、图像生成、数据分析、自动化内容创作等。

|

模型类型 |

适用场景 |

|

LLMQwen3-32B |

创意写作、角色扮演 |

|

LLMDeepSeek-R1-0528 (旗舰) |

复杂推理、混合专家 |

|

LLMDeepSeek-R1-0528-Qwen3-8B |

快速生成、成本友好 |

|

LLMQwen3-30B-A3B |

代码生成与修复 |

|

EmbeddingBAAI/bge-m3 |

通用文本向量化 |

高性价比Token调用:提供行业内较低的 API 调用价格。例如,Qwen3-32B-FP8模型的调用费用输入价格为:1元/百万 Token。

操作流程

1. 注册并实名认证:访问白山智算官网,通过手机号完成账号注册和企业实名认证。

2. 选择模型:在模型库中选择适合业务需求的大模型,如自然语言处理、代码生成或文本向量化模型。

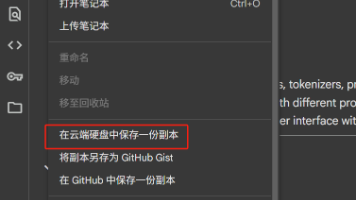

3. 获取API密钥:平台将自动生成API密钥,用于调用模型服务。妥善保存密钥,用于后续配置模型调用。

4. 模型调用:以下是常见的配置步骤

5. 点击 【模型广场】-选择模型,选择适合的模型(如 DeepSeek-V3、Qwen3-32B-FP8 等)。

6.

7. 参数设置:

8. Max Tokens:设置生成文本的最大长度。

9.

10. Temperature:调整生成文本的随机性(低值更精确,高值更有创意)。

11. API 调用:调用 API,示例代码如下:

12. import requests

13.

14. url = "https://api.edgefn.net/v1/chat/completions"

15. headers = {

16. "Authorization": "Bearer {YOUR_API_KEY}",

17. "Content-Type": "application/json"

18. }

19. data = {

20. "model": "Qwen3-32B-FP8",

21. "messages": [{"role": "user", "content": "Hello, how are you?"}]

22. }

23.

24. response = requests.post(url, headers=headers, json=data)

25. print(response.json())

26.

27. 集成至应用系统:通过标准API接口将模型能力接入现有业务系统。

28. 监控与优化:使用平台提供的性能监控工具,实时查看API调用情况,并根据业务需求调整模型参数。

用户福利

为了让更多的用户能够轻松体验AI能力,白山云提供了以下用户福利:

· 新用户注册赠送体验金:完成实名认证后,即可获得150元体验金;首次调用模型服务后,再获300元体验金,总计450元≈Qwen3模型1.125亿 Tokens调用额度,可用于抵扣API调用费用,适合企业开发者和团队。

· 免费试用模型:部分基础模型(Qwen3系列、DeepSeek系列、BAAI/Bge系列)提供永久免费调用,用户可先试用后决定是否升级,是个人开发者和小型AI项目首选。

· 技术支持服务:无论是否为付费用户,均可享受基础技术咨询与问题排查服务,帮助用户快速上手。

技术优势

白山云的大模型API服务基于其全球边缘云网络构建,拥有超过1700个边缘节点,每日处理请求超过6000亿次。这意味着用户在调用API时,可以享受到:

· <300ms的超低延迟响应:通过就近边缘节点推理,极大缩短响应时间,提升用户体验。

· 高可用性保障(99.9%):采用分布式架构,确保服务稳定运行,即使在高并发请求下也能保持流畅。

· 全链路安全保障:从数据传输到模型运行,均采用隔离机制,保障用户数据与模型安全。

· 弹性扩展能力:平台支持百万级并发请求,可根据业务需求动态调整资源,避免资源浪费或服务中断。

场景一:一家初创企业想快速上线AI客服功能

某家初创电商公司,业务发展迅速,但团队中缺乏AI工程师。他们希望通过AI客服提升用户响应效率,但前期又不想投入大量成本搭建AI系统。这时,白山云的大模型API服务成为他们的理想选择。

用户只需注册账号,进入控制台,选择适合自身业务的模型(如Qwen3-32B、DeepSeek-R1等),然后通过一行代码即可接入需要的模型。整个过程无需自建硬件服务器,也不需要复杂的配置部署,最快10分钟就能上线AI客服功能。

此外,白山智算还提供新用户注册即送450元体验金的优惠,让用户在无成本压力的前提下,充分测试AI功能的实际效果。

·

AI应用,从此触手可及

无论是希望快速接入AI能力的技术开发者,还是寻求智能化升级的中小企业,白山云科技的大模型API服务平台通过简单操作,用户即可将大模型应用于智能客服、制造质检、内容生成等多个业务场景,真正实现“AI即服务”。

更重要的是,白山云不仅提供稳定高效的技术支持,还通过免费试用、体验金、租赁服务等福利,大幅降低AI落地的门槛,让更多企业敢于尝试、乐于使用。未来,白山云将继续深耕AI边缘推理技术,助力更多企业实现智能化转型。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)