盘点AAAI 2025 小模型的惊艳之作:全方位解读小模型如何实现技术飞跃

文章首先利用知识蒸馏技术,充分挖掘原始SAM大模型的表征能力,引导小模型学习关键特征表达。接着,通过灵活的量化策略,将模型权重和计算过程压缩至低比特,实现资源占用极小化。最后,结合优化的轻量解码器以及端到端训练,使TinySAM能在多种实际场景下以极低算力完成高精度分割任务,兼顾速度与准确率。

关注gongzhonghao【计算机sci论文精选】

最近研读了诸多小模型的论文,而且小模型的新版本也在持续迭代升级。今天小图给大家精选 3 篇 AAAI 有关小模型方向的论文,顺便梳理了一番小模型各版本的技术突破,以及小模型相关的一些热门改进思路。

这些思路我从实验方法、作用方式和创新点分析等角度做了分类,既能帮助大家理清不同技术在小模型改进中的定位、作用机制及关联关系,便于组织论文结构;也方便想要投稿AAAI的同学快速定位技术在流程中的位置,明确各阶段的优化重点。

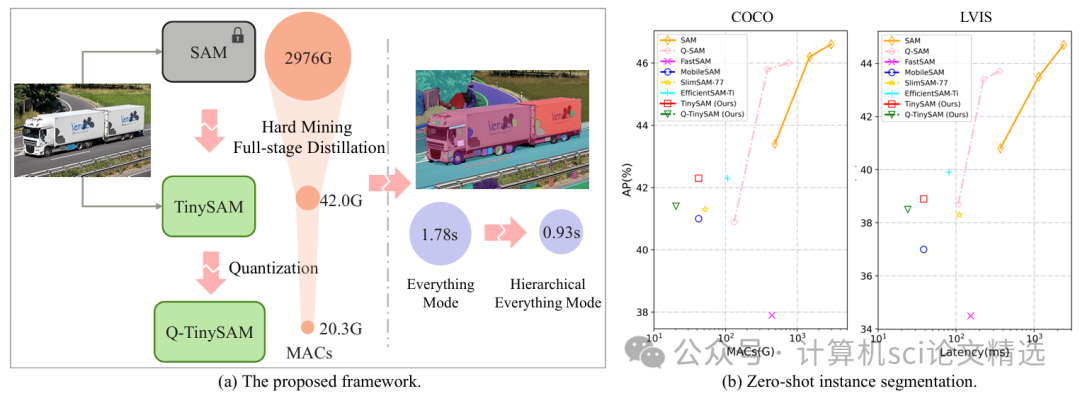

论文一:TinySAM: Pushing the Envelope for Efficient Segment Anything Model

方法:

作者首先利用知识蒸馏技术,充分挖掘原始SAM大模型的表征能力,引导小模型学习关键特征表达。接着,通过灵活的量化策略,将模型权重和计算过程压缩至低比特,实现资源占用极小化。最后,结合优化的轻量解码器以及端到端训练,使TinySAM能在多种实际场景下以极低算力完成高精度分割任务,兼顾速度与准确率。

创新点:

-

首创将知识蒸馏与量化深度结合于语义分割模型压缩,显著提升小模型效能

-

设计了专用的轻量解码器架构,有效保留原始大模型的分割精度。

-

提出端到端训练流程,让小模型在实际运行中实现超低延迟与高能效。

论文链接:

https://doi.org/10.1609/aaai.v39i19.34255

图灵学术论文辅导

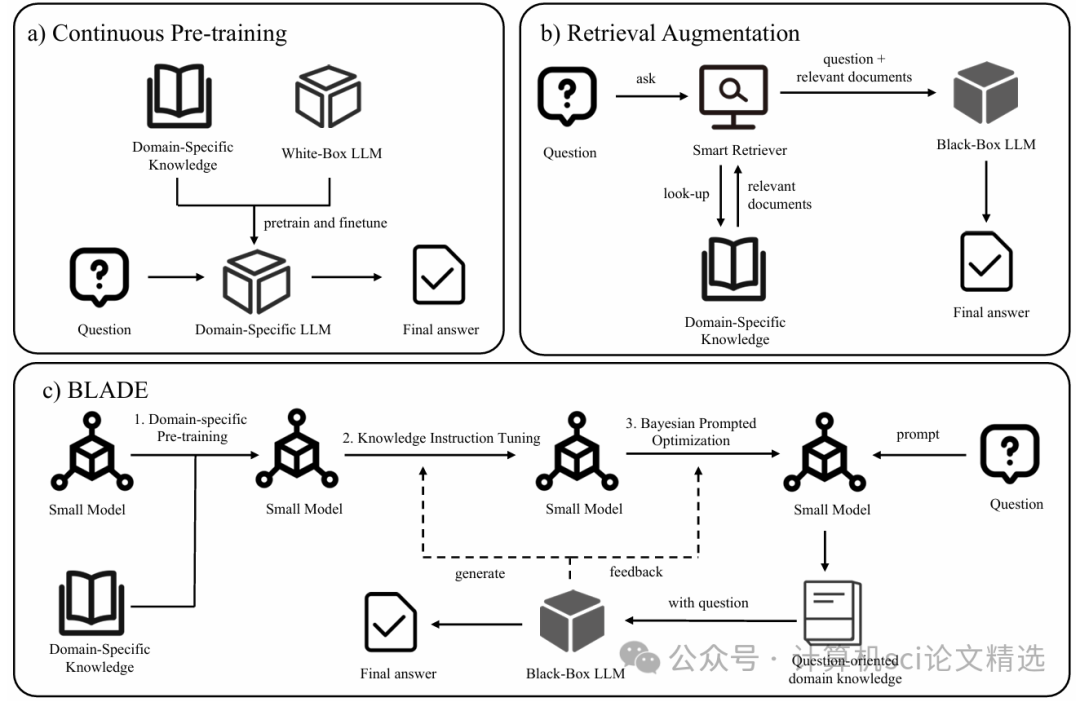

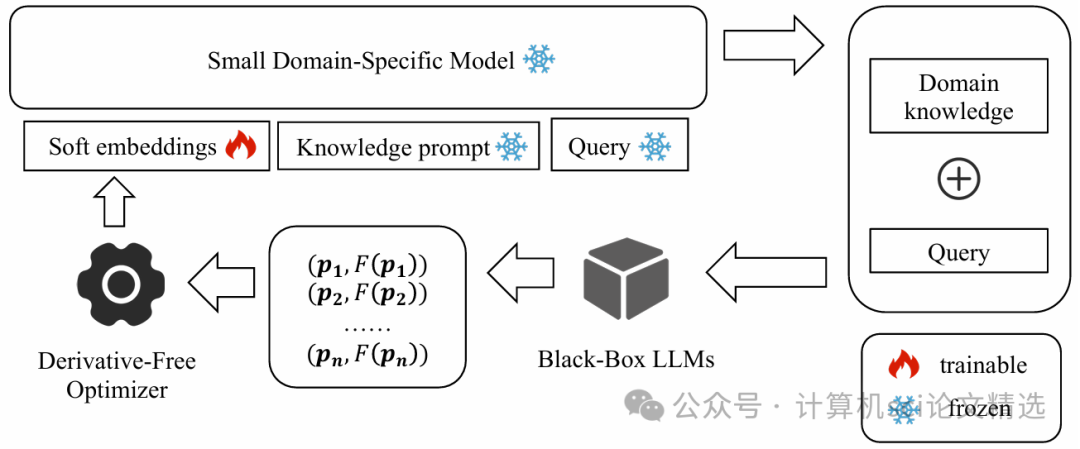

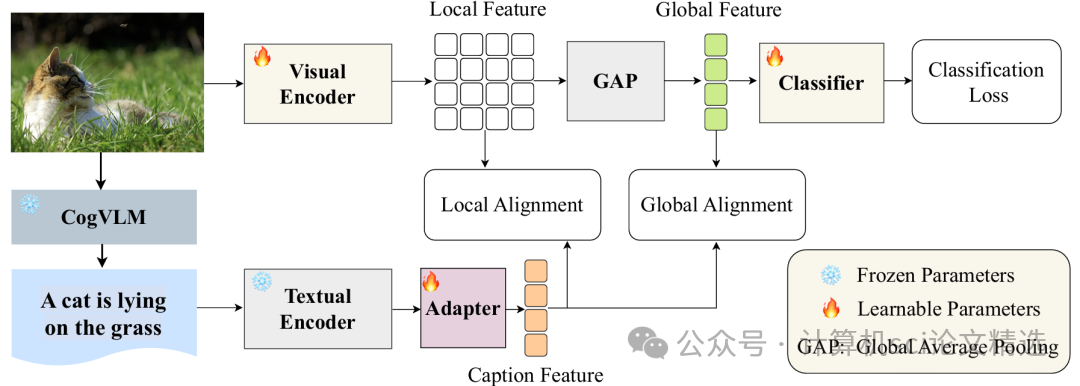

论文二:BLADE: Enhancing Black-Box Large Language Models with Small Domain-Specific Models

方法:

作者首先训练了一组专门针对特定领域的小模型,并设计接口让这些小模型能在大模型推理过程中对相关问答进行补充或纠正。然后,通过灵活的知识融合算法,系统自动判断何时调用小模型输出,从而在不影响大模型原有能力的前提下增强其领域表现。最后,整个BLADE框架以黑盒方式集成,无需对大模型参数进行改动,实现低成本、高兼容性的智能增强效果。

创新点:

-

创新性提出以小领域模型实时补充大模型知识,实现无缝协作,提升领域问答表现。

-

设计了无需修改大模型结构的黑盒增强机制,降低集成成本与系统风险。

-

构建了高效的知识融合策略,使小模型贡献信息最大化且易于扩展至多领域。

论文链接:

https://doi.org/10.1609/aaai.v39i23.34620

图灵学术论文辅导

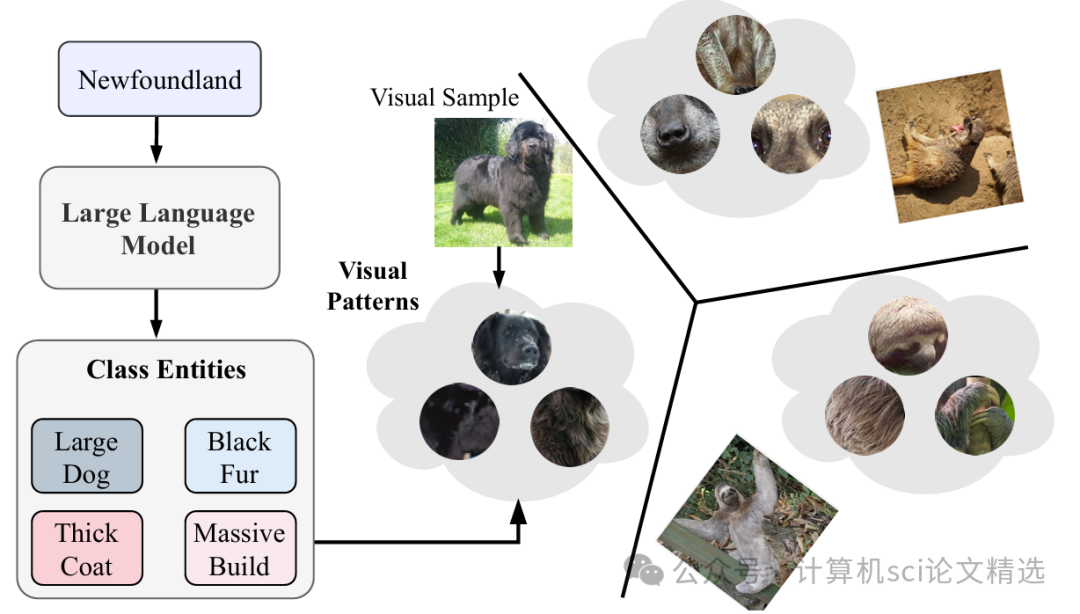

论文三:Envisioning Class Entity Reasoning by Large Language Models for Few-shot Learning

方法:

作者提出新型框架,先用大语言模型提取类别的抽象语义特征,再融合具体实例实体信息,实现多层次的类别原型表示。随后,通过动态推理机制,让模型在少量样本条件下自动优化原型,以捕捉类别间的细微差异。最终,整个方法以端到端训练方式,将语义与实体有机结合,在众多小样本基准任务上展现出显著优越性。

创新点:

-

首次在小样本学习中系统结合抽象语义与具体实体信息,极大丰富类别表示。

-

利用大语言模型的强推理能力,创新实现类别原型的动态构建与优化。

-

提出了端到端的框架,显著提升了少样本任务中的泛化与区分能力。

论文链接:

https://doi.org/10.1609/aaai.v39i18.34081

本文选自gongzhonghao【计算机sci论文精选】

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)