Dify:大模型开发工具入门知识

Dify:大模型开发工具入门知识

一、Dify简介

Dify 是一款开源的大语言模型(LLM) 应用开发平台。它融合了后端即服务(Backend as Service)和 LLMOps[1] 的理念,使开发者可以快速搭建生产级的生成式 AI 应用。即使你是非技术人员,也能参与到 AI 应用的定义和数据运营过程中。

由于 Dify 内置了构建 LLM 应用所需的关键技术栈,包括对数百个模型的支持、直观的 Prompt 编排界面、高质量的 RAG 引擎、稳健的 Agent 框架、灵活的流程编排,并同时提供了一套易用的界面和 API。这为开发者节省了许多重复造轮子的时间,使其可以专注在创新和业务需求上。

二、Dify与大模型开发

Dify 是苏州一家公司开源的平台,因此在使用上符合国人习惯,更重要的是它完全开源,能够快速做出大模型应用的同时,还能嵌入你已有的平台。因此有很多便利。

• 创业,快速的将你的 AI 应用创意变成现实,无论成功和失败都需要加速。在真实世界,已经有几十个团队通过 Dify 构建 MVP(最小可用产品)获得投资,或通过 POC(概念验证)赢得了客户的订单。

• 将 LLM 集成至已有业务,通过引入 LLM 增强现有应用的能力,接入 Dify 的 RESTful API 从而实现 Prompt 与业务代码的解耦,在 Dify 的管理界面是跟踪数据、成本和用量,持续改进应用效果。

• 作为企业级 LLM 基础设施,一些银行和大型互联网公司正在将 Dify 部署为企业内的 LLM 网关,加速 GenAI 技术在企业内的推广,并实现中心化的监管。

• 探索 LLM 的能力边界,即使你是一个技术爱好者,通过 Dify 也可以轻松的实践 Prompt 工程和 Agent 技术,在 GPTs 推出以前就已经有超过 60,000 开发者在 Dify 上创建了自己的第一个应用。

三、Dify部署

Dify部署方式多种多样,可以简单点使用云服务,或者使用本地部署,这里简单演示一下本地docker部署方式。

安装条件

安装 Dify 之前, 请确保你的机器已满足最低安装要求:

• CPU >= 2 Core

• RAM >= 4 GiB

安装步骤

1、启动Dify进入 Dify 源代码的 Docker 目录,复制环境配置文件,启动Docker

cd dify/docker

cp .env.example .env

docker compose up -d

二、Dify 功能简介

本次入门篇,简单介绍dify几个常用的主要功能,会在陆续的文章里详细介绍,并且分享一些使用踩坑等经验。

- 接入大模型 AI相关的应用,最在意的就是大模型的接入了吧。 从模型类型上来说,Dify支持推理、嵌入、向量、语音转文本、文本转语音

共五种模型。 从模型提供商来说,Dify支持的更多了,基本上场景的方式都支持了,不过还是有所限制的。

如,对ollama,只支持推理模型与嵌入模型,尽管ollama上也有别的模型。至于不同的模型有什么具体的区别,有必要的话,后面会单独写一篇。

添加模型的方式: 个人账号–>设置–>工作空间–>模型供应商–>选择具体的供应商–>添加连接信息

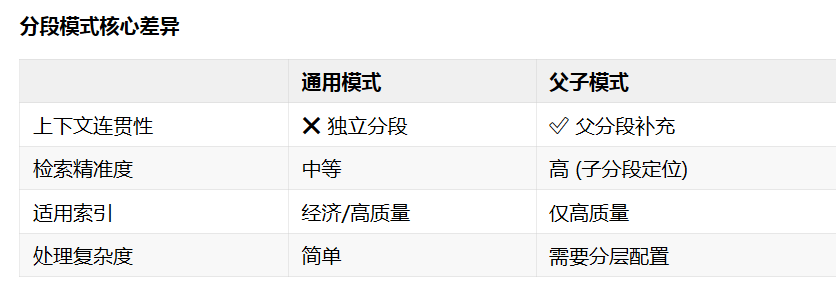

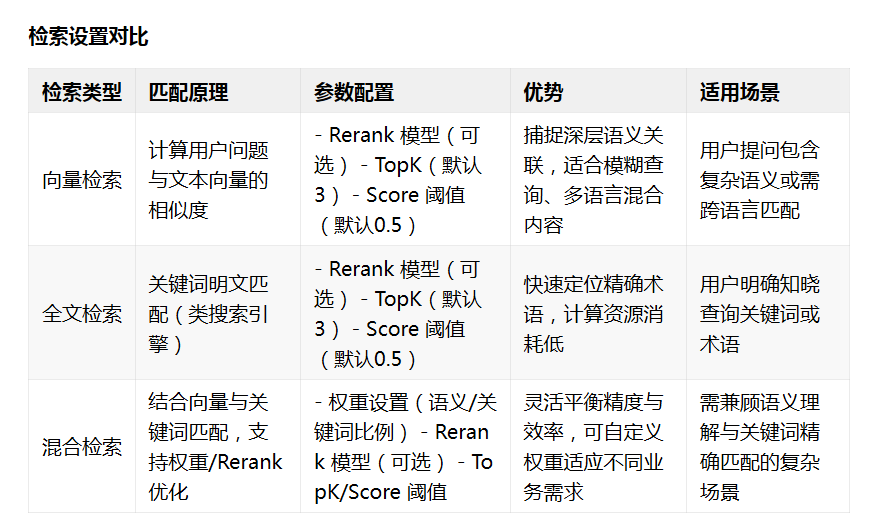

三、知识库设置从分段模式上来说,分为两种方式,通用模式VS父子模式,在索引上分为高质量与经济模式,在检索上分为向量检索、全文检索与混合检索。

知识库使用

- 进入 工作室 – 创建应用 --创建聊天助手

- 进入 上下文设置 点击 添加 选择已创建的知识库

- 在 上下文设置 – 参数设置 内配置召回策略

- 在 添加功能 内打开 引用和归属

- 在 调试与预览 内输入与知识库相关的用户问题进行调试

- 调试完成之后保存并发布为一个 AI 知识库问答类应用

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)