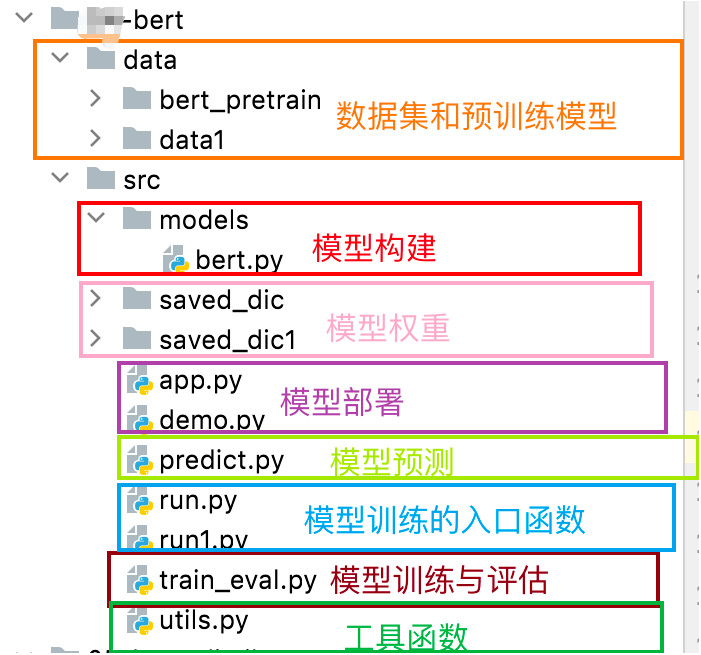

NLP 项目开发: 代码编写顺序(参考)

在真实NLP项目开发里,结合该项目架构,推荐按从底层到上层、从基础到业务的顺序编码,保障架构清晰与功能验证顺畅:先编写`utils.py`实现通用工具函数,构建`data`目录的数据加载逻辑;接着在`models/bert.py`定义BERT模型结构;再于`train_eval.py`写训练和评估逻辑,验证模型效果;之后用`run.py/run1.py`封装训练入口、`predict.py`实现推

·

在真实的 NLP 项目开发中,建议按照从底层到上层、从基础到业务的顺序编写代码,既保证架构清晰,也能让每一步的功能验证更顺畅。结合你的项目结构,推荐的开发顺序如下,可参考:

一、基础工具层(先搭“地基”)

-

utils.py(工具函数)

- 先写通用工具,比如:

- 数据预处理函数(文本分词、ID 映射、padding 补全)

- 日志记录、时间戳生成

- 设备选择(自动判断 CPU/GPU)

- 作用:让后续代码复用这些工具,避免重复造轮子。

- 先写通用工具,比如:

-

data 目录(数据集准备)

- 整理

bert_pretrain和data1里的数据集,编写 数据加载逻辑(如果是自定义数据集,可先写Dataset类)。 - 比如在

data里加一个data_loader.py(如果没有的话),实现:- 文本 -> Tokenizer 编码

- 数据集划分(训练集/验证集/测试集)

- 搭配 PyTorch 的

DataLoader做批量加载

- 作用:后续模型训练需要喂数据,先把数据流程跑通,后面调模型更高效。

- 整理

二、模型核心层(再建“房子主体”)

- models/bert.py(模型构建)

- 定义 BERT 模型结构(或基于预训练模型的微调结构)。

- 可以先写基础的模型类,包含:

__init__初始化(加载预训练权重、定义下游任务头)forward前向传播(模型怎么处理输入、输出预测结果)

- 作用:模型是核心,先把结构写好,后面训练、预测都依赖它。

三、训练与评估层(给房子“装修+测试”)

- train_eval.py(模型训练与评估)

- 写训练逻辑:

- 加载数据集(依赖

utils和data里的代码) - 初始化模型(依赖

models/bert.py) - 定义优化器、损失函数、训练循环(epoch 迭代、前向/反向传播)

- 加载数据集(依赖

- 写评估逻辑:

- 在验证集/测试集上跑模型,计算准确率、损失等指标

- 保存最佳模型权重(存到

saved_dic或saved_dic1)

- 作用:验证模型是否能跑通、是否有效果,是“让模型能干活”的关键步骤。

- 写训练逻辑:

四、业务应用层(给房子“装家具”)

-

run.py / run1.py(训练入口)

- 配置训练参数(学习率、batch_size、epoch 数等)

- 调用

train_eval.py的训练函数,一键启动训练 - 作用:把训练流程封装成“快捷启动器”,方便后续调参、复现实验。

-

predict.py(模型预测)

- 加载训练好的模型权重(从

saved_dic或saved_dic1) - 写推理逻辑:输入文本 -> 模型预测 -> 输出结果(分类标签、概率等)

- 作用:验证模型在单条数据/新数据上的表现,向“能用”靠近一步。

- 加载训练好的模型权重(从

-

app.py / demo.py(模型部署/演示)

- 如果是 Web 部署(Flask/FastAPI):写接口逻辑,接收 HTTP 请求、调用

predict.py做预测、返回结果。 - 如果是 Demo 演示:做简单的交互界面(命令行或网页),让用户输入文本,实时看预测结果。

- 作用:把模型变成“可用的服务/产品”,完成从开发到落地的闭环。

- 如果是 Web 部署(Flask/FastAPI):写接口逻辑,接收 HTTP 请求、调用

五、为什么这样排序?

- 从底层到上层:工具、数据、模型是基础,先保证这些“地基”稳定,再做训练、预测、部署这些“上层建筑”,避免反复改动底层逻辑。

- 从验证到落地:先让模型能训练(train_eval)、能预测(predict),再封装成应用(app/demo),每一步都能验证前一步的成果,减少返工。

实际开发中,也可以小步迭代:比如写完 utils 和 data,就简单测试下数据加载;写完 bert.py,就打印下模型结构和输出维度,确保没问题再继续。这样能及时发现问题,避免最后“牵一发动全身”~

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)