DeepSeek 开源 6850 亿参数大模型上架

对比其他主流模型,如 GPT-4O 的上下文长度在常规应用场景下远不及 DeepSeek-V3.1-Base 的 128K ,这使得 DeepSeek-V3.1-Base 在处理长篇学术论文、大型项目代码库等长文本任务时具有明显优势,能够一次性理解和处理更完整的信息,而无需像其他模型那样进行繁琐的文本分段处理,大大提升了处理效率和结果的准确性。这模型用的是 Safetensors 格式存储,可能有

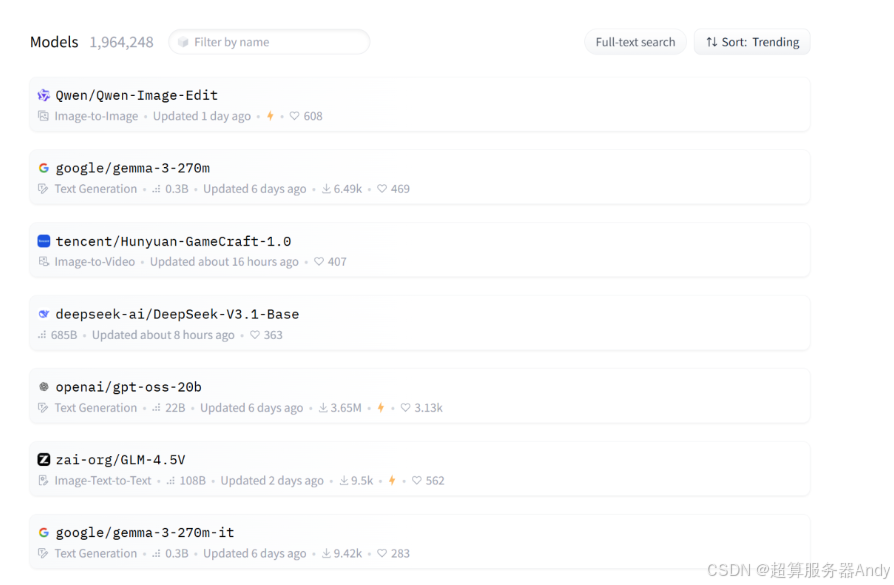

昨天半夜睡不着,习惯性打开 Hugging Face 刷最新模型动态,结果一眼看到 DeepSeek 官方刚上架的新东西 ——DeepSeek-V3.1-Base。本来以为就是个小更新,点进去一看直接精神了:参数居然给到 6850 亿,上下文长度更是拉到了 128K!这哪是迭代,简直是给 AI 圈扔了颗 “重磅炸弹”,难怪评论区才几小时就挤满了讨论的人。

估计不少朋友看到 “685B”“128K” 这俩数字会懵:这到底是啥意思?跟咱们平时用 AI 有啥关系?我花了一早上翻文档、对比旧模型,把这些门道捋清楚了,保证你看完就懂这模型有多实用。

先说说6850 亿参数有多夸张。咱们拿大家熟悉的模型做对比,早期火遍全网的 GPT-3 才 1750 亿参数 ,这次 DeepSeek 直接干到近 7000 亿 —— 参数规模就像 AI 的 “大脑容量”,容量越大,能记住的知识越细、理解的逻辑越复杂。比如以前用 AI 看法律合同,遇到好几层嵌套的条款,AI 经常会 “断片”,要么漏看条件,要么理解反了;但参数到了 6850 亿这个级别,再看这类复杂文本,就能顺着逻辑链一路捋到底,连不起眼的补充条款都能精准抓住。从技术原理来讲,更多参数意味着模型具备更庞大的神经元连接模拟能力,能够学习到更加微妙和复杂的语言模式与语义关系。以语义理解为例,在处理诸如 “苹果从树上掉落,牛顿受到启发从而发现了万有引力” 这类句子时,参数较少的模型可能仅能识别出 “苹果”“牛顿”“万有引力” 等孤立词汇的关联;而 DeepSeek-V3.1-Base 凭借其海量参数,能够精准捕捉到 “掉落” 这一动作与后续事件的因果联系,以及该事件在科学史上的重要意义。

相较于同样拥有较高参数规模的 Llama 3.1 405B 模型,DeepSeek-V3.1-Base 在参数数量上具有显著优势,为其在复杂任务处理、知识储备和语言理解深度等方面奠定了坚实基础。

更让我觉得 “解决大问题” 的是128K 上下文长度。先通俗讲下 “上下文长度”:就是 AI 一次性能 “读明白” 的文字上限。之前我用 AI 处理公司的行业报告,一份 30 页的文档得拆成七八段喂进去,结果 AI 经常把前面的数据分析和后面的结论搞混,还得我反复调整分段;现在 128K 是什么概念?按咱们中文平均每字 2 字节、一页文档 500 字算,128K 能一次性读 13 万字左右 —— 差不多是一整本《小王子》加半本《三体》的量,别说几十页报告,就算是一整套代码文档、一本小说初稿,AI 都能一口气 “看完”,再也不用手动拆文本、反复核对逻辑了。从技术角度深入剖析,长上下文处理能力依赖于模型的位置编码机制与注意力机制的协同优化 。DeepSeek-V3.1-Base 采用了基于旋转位置编码(RoPE)改进的 YaRN(Yet another RoPE extensioN)技术对位置编码进行创新。RoPE 是一种相对位置编码方法,通过复杂的旋转嵌入修改 Query 和 Key,使二者内积依赖相对位置。然而,由于余弦和正弦函数的周期性,在固定基础频率时,仅在小范围上下文窗口预训练的模型在处理超出范围的位置索引时易出现混淆。YaRN 则采用插值频率策略,通过计算扩展后与原始上下文长度的比值作为缩放因子,对 Query 和 Key 使用新频率进行旋转,实现了更平滑的过渡,让模型能够有效处理长序列。在注意力机制方面,模型很可能采用了优化的多头注意力机制,能够在长序列中更高效地捕捉不同位置信息间的关联,避免信息丢失或混淆。

对比其他主流模型,如 GPT-4O 的上下文长度在常规应用场景下远不及 DeepSeek-V3.1-Base 的 128K ,这使得 DeepSeek-V3.1-Base 在处理长篇学术论文、大型项目代码库等长文本任务时具有明显优势,能够一次性理解和处理更完整的信息,而无需像其他模型那样进行繁琐的文本分段处理,大大提升了处理效率和结果的准确性。

再说说普通用户可能没注意,但特别实用的细节:

首先是安全。这模型用的是 Safetensors 格式存储,可能有人不知道,以前有些模型用的 PyTorch 格式,存在恶意代码注入的风险,下载下来心里总有点慌;现在换了这个格式,相当于给模型加了层 “安全锁”,不管是个人用还是企业部署,都少了份顾虑。

然后是门槛。它支持 BF16、F8_E4M3、F32 三种张量类型,这里重点说下 F8_E4M3—— 这是一种 FP8 精度,简单讲就是能在不怎么影响 AI 性能的前提下,大幅减少显存占用。以前想跑大参数模型,得有那种几十万的专业显卡;现在有了这个精度选项,哪怕是显存没那么夸张的消费级显卡,也有机会试着部署起来,对咱们普通开发者、学生党太友好了。

还有个点可能有人觉得 “不完美”:目前这模型虽然上架了,但没给详细的 Model Card(就是说明模型细节的文档),也没有推理商帮忙部署好直接用。但说实话,这恰恰是开源的魅力 —— 它不是给你一个 “只能这么用” 的成品,而是扔给你一个 “能随便改” 的底子。比如我认识的一个做金融分析的朋友,已经打算基于这个模型,自己微调适配银行的财报解读;还有高校的学生,想拿它研究怎么让大模型更好地理解长文本逻辑。这种 “可折腾” 的空间,比一个现成的工具值钱多了。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)