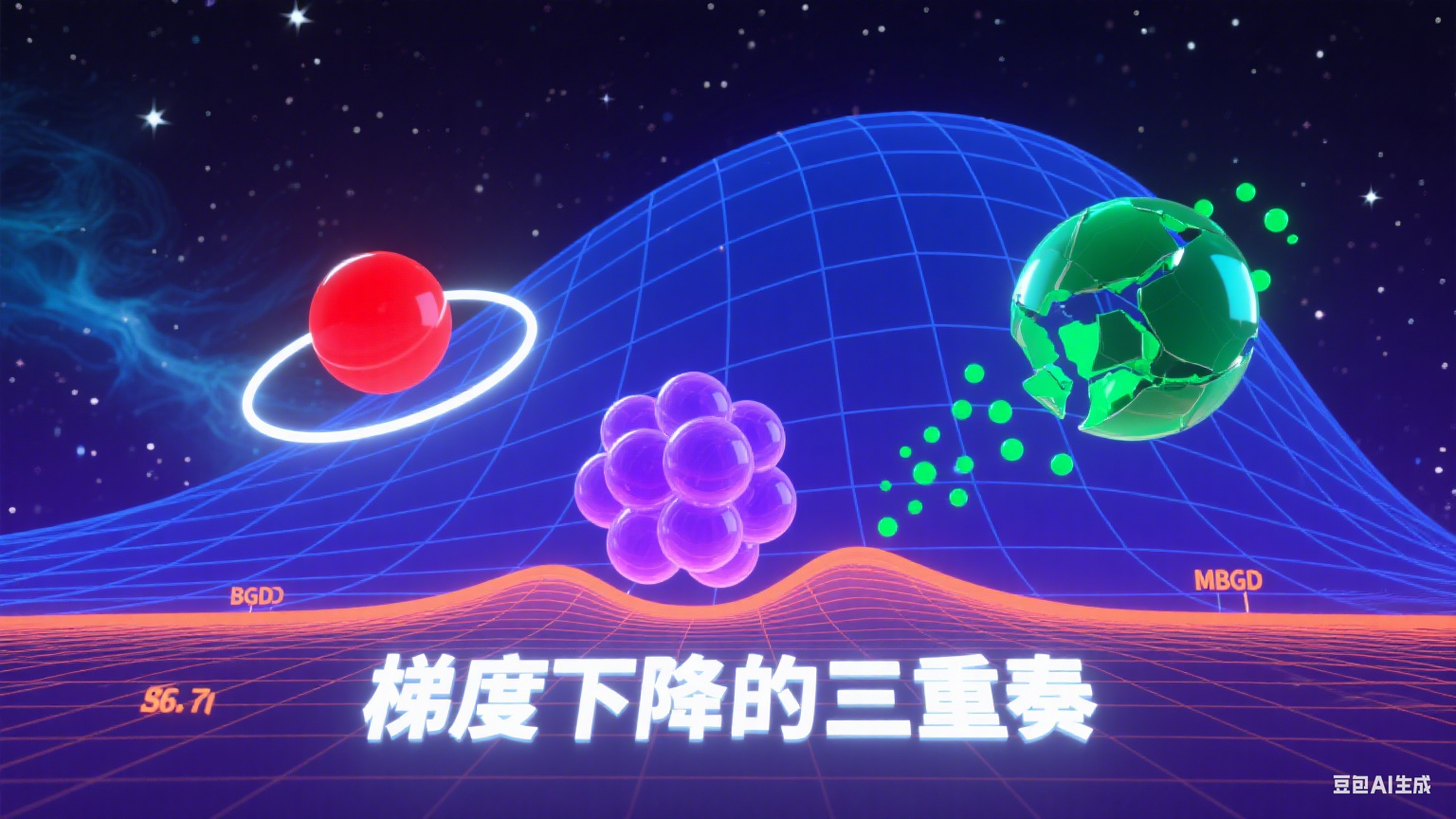

老码农和你一起学AI:数学基础知识系列-梯度下降的三重奏

梯度下降是机器学习的核心优化算法,其三种主要变体各具特色:批量梯度下降(BatchGD)计算准确但效率低,随机梯度下降(SGD)速度快但波动大,小批量梯度下降(Mini-batchGD)则实现了稳定性与灵活性的平衡。批量大小的选择需要权衡数据特性、模型结构及硬件条件,通常采用2的幂次方以适配GPU架构。这三种方法体现了机器学习在确定性与随机性、效率与精度之间的动态平衡艺术,Mini-batchGD

有没有早上出去散步,看见叶片上滚动的露珠总会沿着最陡峭的叶脉滑落 —— 这像极了机器学习中那个无处不在的优化过程:梯度下降。从训练识别猫咪的神经网络到预测股票走势的模型,梯度下降始终扮演着 "登山向导" 的角色,带领参数在误差的山峦间寻找最低点。但这个向导有三位性格迥异的助手:Batch GD(批量梯度下降)、SGD(随机梯度下降)和 Mini-batch GD(小批量梯度下降),它们用不同的节奏诠释着优化的艺术。

一、从整齐划一到自由随性

想象一群登山者在迷雾中摸索下山的路。Batch GD 是最谨慎的领队,它要求所有人每走一步前都必须测量整座山的坡度 —— 也就是用全部训练数据计算梯度。这种方法如同在白天行路,每次迈步都基于完整的地形信息,方向稳定却效率低下。当数据集达到百万级别时,它每一步的计算成本都像背着整座山前行,在深度学习时代逐渐显得笨重。

SGD 则走向了另一个极端。这位急脾气的向导拒绝等待,每次只让一个队员报出脚下的坡度就立刻下令前进。这种随机性如同在黑夜中凭借闪电的瞬间光亮奔跑,虽然速度飞快,却时常偏离方向。你会看到参数在最优值附近剧烈震荡,像醉汉蹒跚的脚步,但正是这种混乱中藏着突破局部陷阱的可能 —— 偶尔的闪电或许会照亮一条捷径。

Mini-batch GD 是位懂得妥协的智者。它让十到一百名队员组成小分队,每次根据小队的测量结果调整方向。这种折中方案既保留了批量计算的稳定性,又拥有随机探索的灵活性。当你在 TensorFlow 的配置文件里写下 batch_size=32 时,其实是在告诉模型:"每次用 32 个样本的智慧来决定下一步。" 这种方法如今已成为深度学习的默认选择,就像城市交通中恰到好处的红绿灯,维持着系统的高效运转。

二、噪声的辩证法

梯度下降的世界里,噪声并非全然的敌人。SGD 的高噪声性如同湍急的河流,虽然让航行变得颠簸,却能冲开河道中的淤泥(局部最优解)。当模型陷入鞍点 —— 一个在某些方向上升、某些方向下降的特殊点时,Batch GD 可能会因为梯度为零而停滞不前,而 SGD 的随机扰动却能像一阵风,推动参数离开这个困境。

但噪声的剂量需要精确把控。当批量大小趋近于 1 时,参数更新会呈现剧烈的锯齿状轨迹,如同在地震中行走,虽然始终在移动,却难以稳定地接近目标。随着批量增大,噪声逐渐平滑,轨迹变得像高速公路般笔直,但过度追求平稳反而会错失发现新路线的机会。研究表明,在 ImageNet 等大型数据集上,使用 256-1024 的批量大小往往能在收敛速度与泛化能力间取得最佳平衡,这恰如驾驶时保持适当的车速,既不龟速爬行,也不鲁莽飞驰。

这种噪声与稳定性的博弈,本质上是探索与利用的平衡艺术。就像勘探金矿时,既需要随机钻探寻找新矿脉(探索),也需要集中力量开采已发现的富矿(利用)。Mini-batch GD 通过调节批量大小这个旋钮,让模型在不同阶段切换策略:初期用小批量快速探索,后期用大批量精细调整,实现了从 "广泛撒网" 到 "精准捕捞" 的自然过渡。

三、批量大小的选择

选择合适的批量大小,如同为乐曲选择恰当的节拍,需要综合考虑数据特性、模型结构与硬件条件。当数据集存在大量冗余样本(如重复的图片),增大批量能减少计算浪费 —— 就像读同一本书时,一次翻十页比逐页阅读更高效。反之,对于稀疏且多样的数据(如文本语料),小批量能让模型更频繁地接触不同类型的样本,避免思维僵化。

模型的深度与复杂度同样影响着批量选择。浅层模型如同轻便的小船,适合用 SGD 的 "小碎步" 灵活转向;而深层神经网络像万吨巨轮,需要 Mini-batch 的 "稳健步伐" 才能保持航向。这解释了为何 ResNet 等深度模型通常使用较大的批量(256 以上),而逻辑回归等简单模型即使使用 SGD 也能表现良好。

硬件的约束则为这场选择划定了边界。GPU 的内存容量如同货车的载重限制,当批量大小超过显存时,就会出现 "超载" 错误。这时可以采用梯度累积技巧 —— 将 4 次 batch_size=16 的计算结果合并,等效于 batch_size=64,既遵守了硬件规则,又实现了预期的批量效果。就像集装箱运输中,用多个小集装箱组合成标准货运单位,灵活适应不同的运载能力。

一个有趣的经验法则是:批量大小通常设置为 2 的幂次方(如 16、32、64)。这并非数学上的必然,而是硬件架构的产物 ——GPU 对 2 的幂次方运算有天然的加速优势,如同钢琴家演奏调性为 C 大调的乐曲时更为流畅。但这并非铁律,当数据分布特殊时,打破这个惯例反而能获得更好的效果,毕竟算法的终极目标是解决问题,而非迁就硬件。

站在深度学习的花园里,看这三种梯度下降算法各自绽放:Batch GD 如古树根基,沉稳却生长缓慢;SGD 似蒲公英种子,轻盈却随风飘荡;Mini-batch GD 像精心修剪的灌木,兼具秩序与生机。理解它们的特性,不仅是调参时的技术需要,更是把握机器学习本质的关键 —— 在确定性与随机性、效率与精度、探索与利用之间,寻找属于具体问题的那个完美平衡点。

当你下次训练模型时,不妨凝视参数更新的曲线:那些起伏的波动不是混乱的噪音,而是数据在诉说规律;那些平滑的轨迹不是机械的重复,而是算法在积累智慧。梯度下降的三重奏,正在用数学的语言,演奏着人工智能探索未知的交响乐。

最后小结:

梯度下降的三种形态,实则是机器学习在效率与精度之间不断校准的缩影。Batch GD 以全局视野稳健前行,却在大数据时代略显迟缓;SGD 凭随机之力快速探索,却常因震荡错失坦途;而 Mini-batch GD 通过批量大小的精妙调节,在噪声与稳定间找到了动态平衡,成为当代深度学习的中流砥柱。

批量大小的选择从来不是数字游戏,而是对数据特性的洞察、模型需求的理解与硬件能力的适配。它如同调控琴弦的松紧,过紧则失之灵活,过松则难成曲调。当我们在实践中调试这个参数时,本质上是在教模型如何 "思考"—— 何时该广泛尝试,何时该专注深耕。

从数学公式到训练曲线,梯度下降的演化史印证了一个朴素真理:优秀的算法不在于极致的完美,而在于懂得妥协的智慧。那些参数在误差曲面留下的轨迹,既是数学规律的具象化,也是人工智能向人类学习平衡之道的生动注脚。未完待续.........

更多推荐

已为社区贡献23条内容

已为社区贡献23条内容

所有评论(0)