Windows本地部署DeepSeek-R1全指南|Ollama+ChatBoxAI保姆级教程(含配置建议)

突破官网访问限制!本文详解 Windows 平台本地部署 DeepSeek - R1 完整流程:从 Ollama 环境搭建、 ChatBoxAI 客户端配置,到命令行模型拉取与整合。包含硬件配置分级建议( CPU / GPU / 内存需求),针对不同设备提供蒸馏版本选择策略。文末附 API 替代方案链接,解决低配设备部署难题。

一、前文

由于官网 DeepSeek 经常出现问题,所以我决定在本地部署 DeepSeek 。

整个过程非常简单,不需要任何特殊技能。

考虑到部分读者硬件配置不足,可能无法顺利本地部署或体验较差,请阅读我的这篇文章:

deepseek - 连接 SiliconFlow - API 使用方法(非本地部署) 。

二、正文

1.Ollama

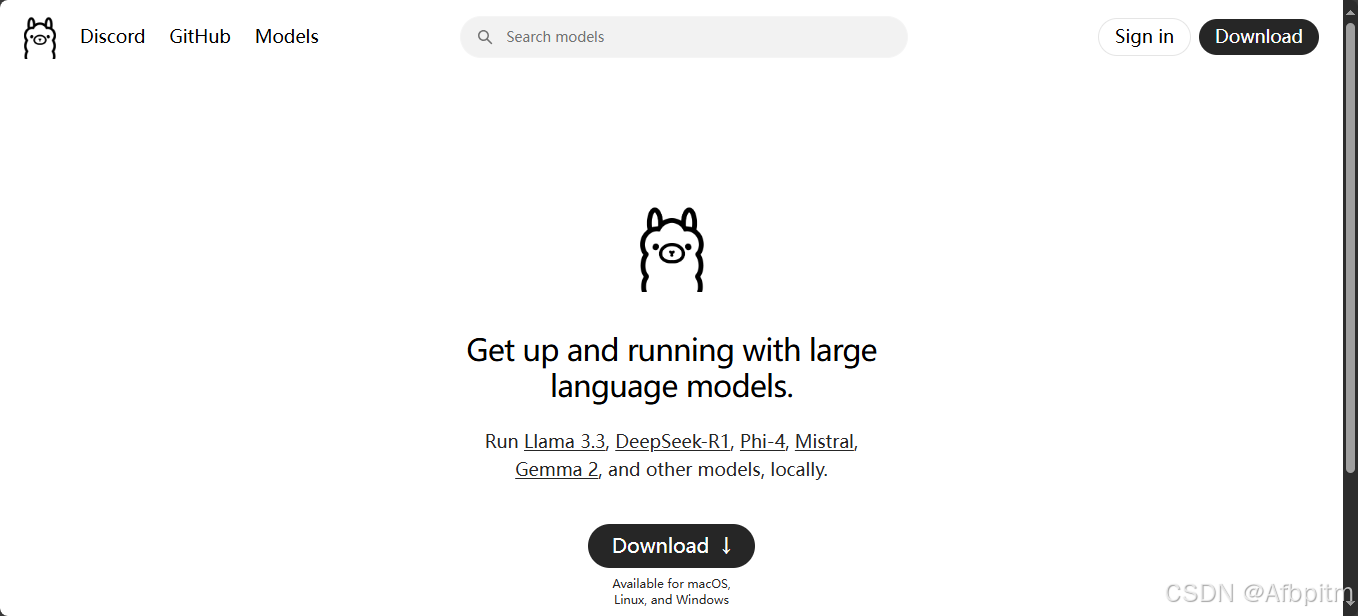

- 首先访问 Ollama 官网 。

- 点击页面中央显眼的

Download按钮。

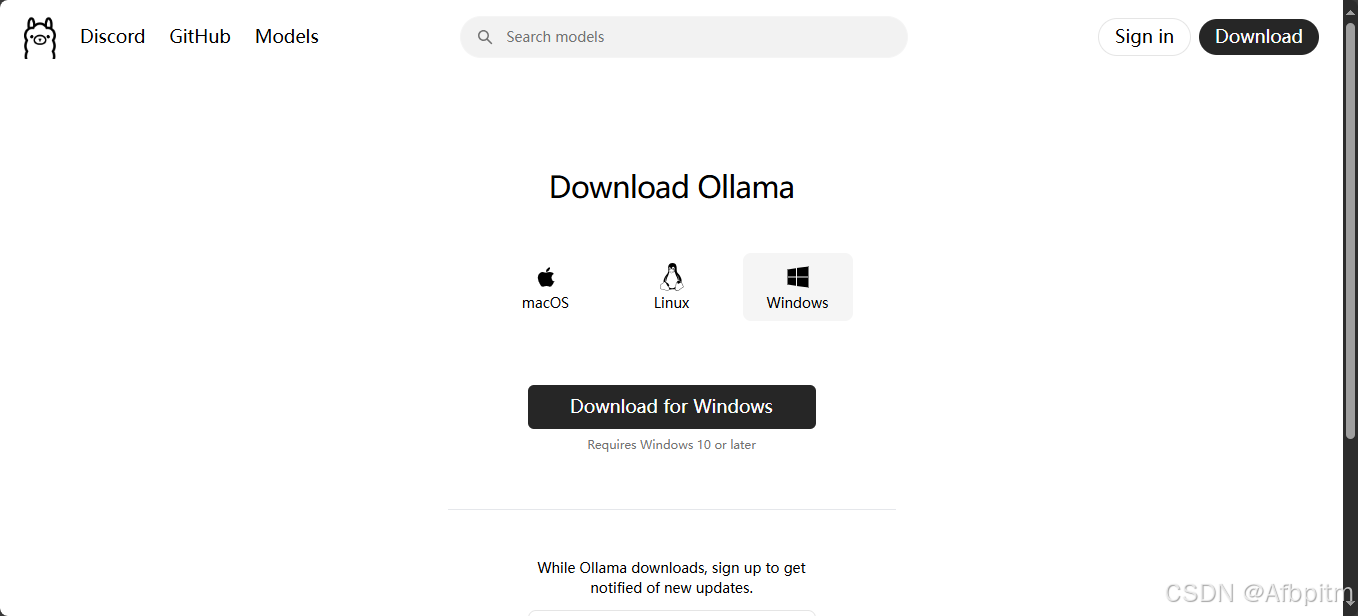

- 再次点击页面中央显眼的

Download for Windows按钮。

- 等待下载完成。

- 下载完成后,进入下载目录,找到下载好的安装包,双击打开。

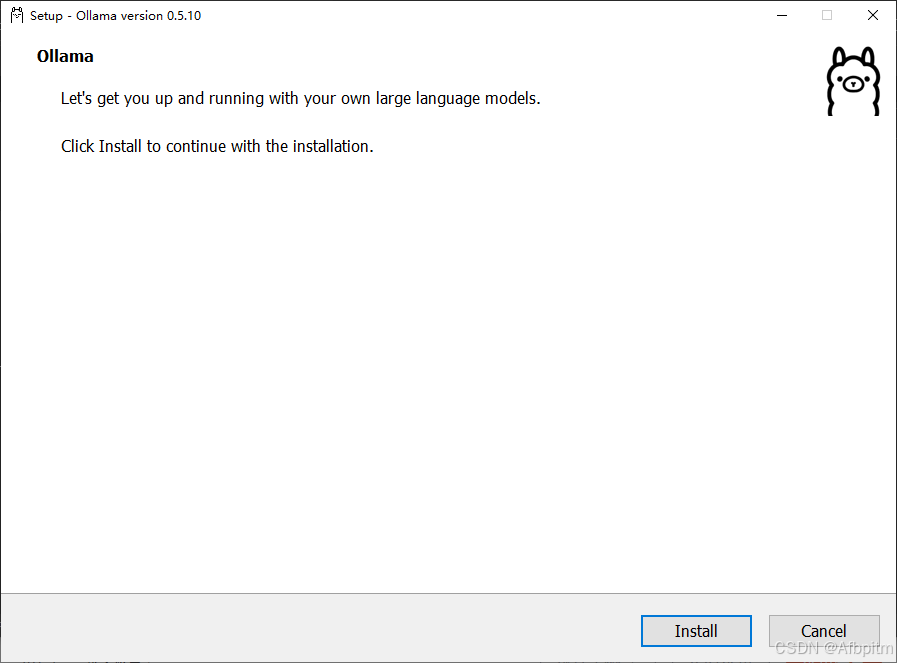

- 点击

Install开始安装。

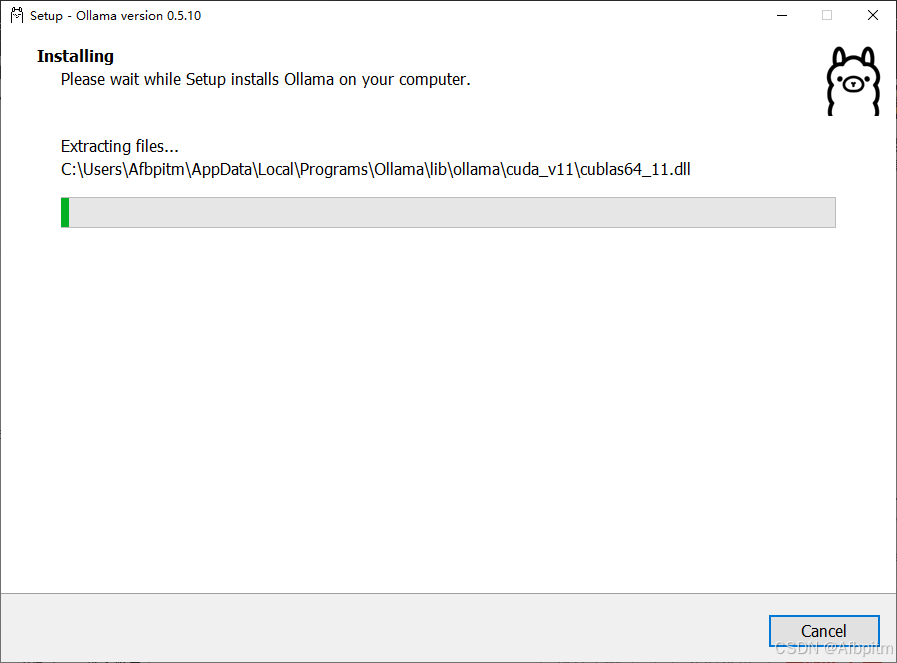

- 等待安装完成。

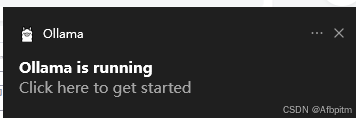

- 安装完成后,查看任务栏右下角的小箭头图标,其中的羊驼图标即为

Ollama的运行进程。

- 请保持

Ollama进程运行,继续下一步操作。

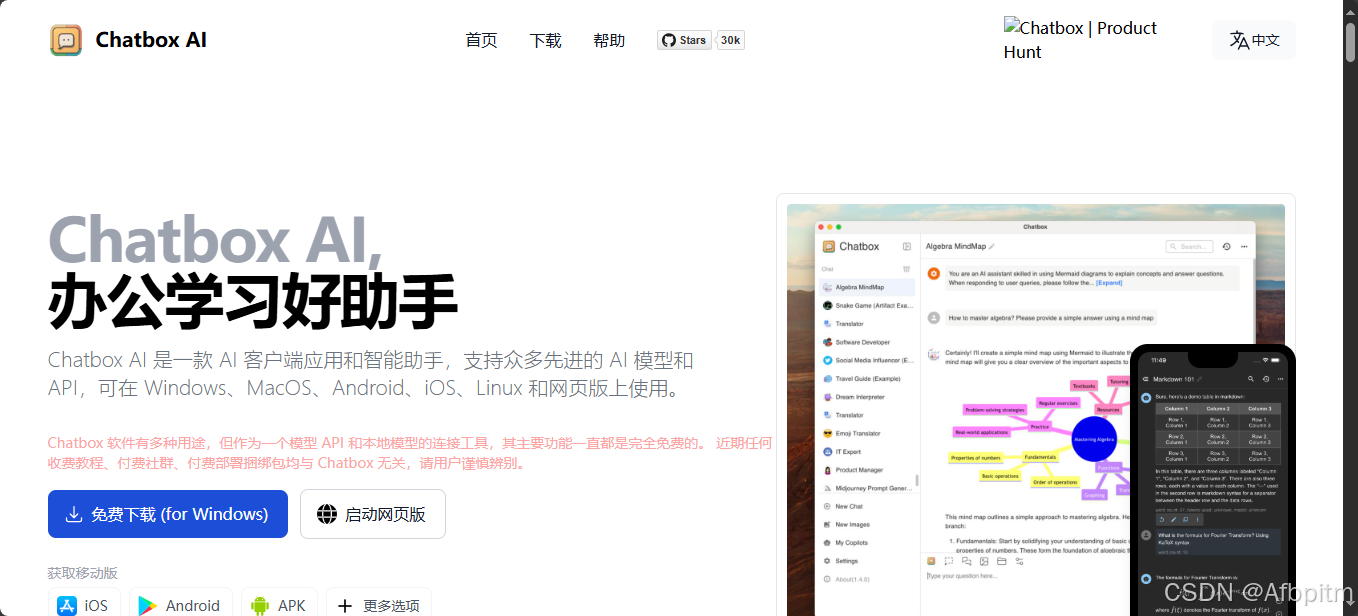

2.ChatBoxAI

- 打开 ChatBoxAI 的官网 。

- 点击

免费下载 ( for Windows )。

- 开始下载,等待完成。

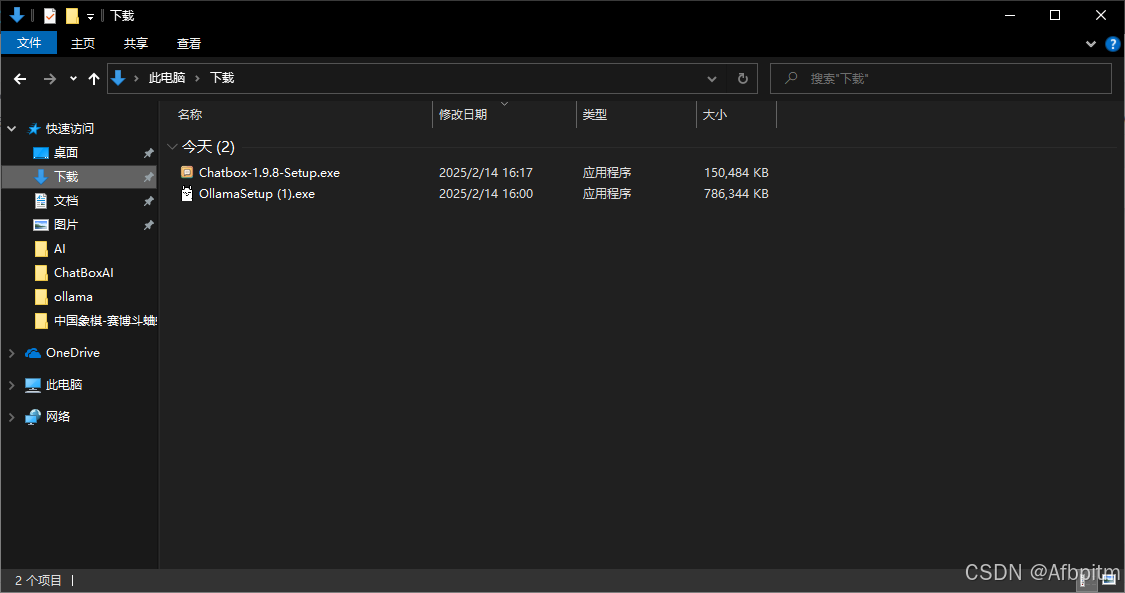

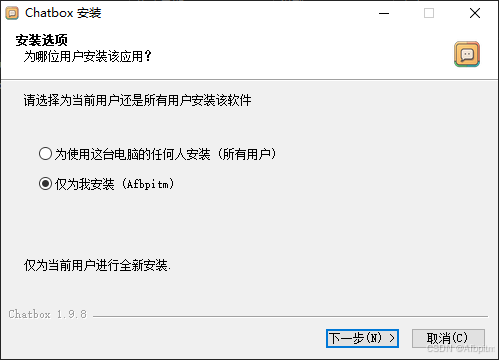

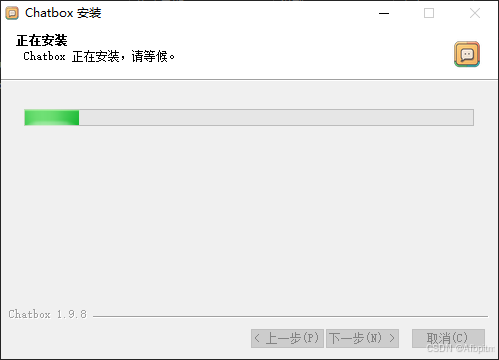

- 下载完成后,进入下载文件夹,双击打开安装包。

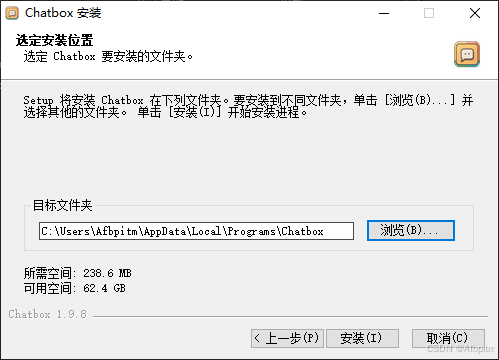

- 点击

下一步。

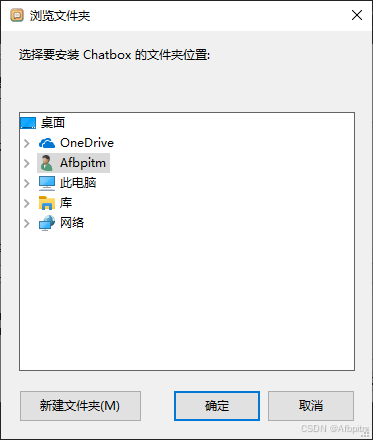

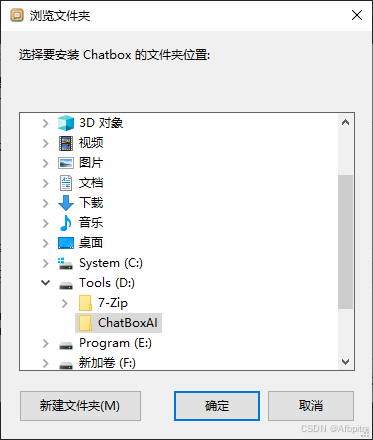

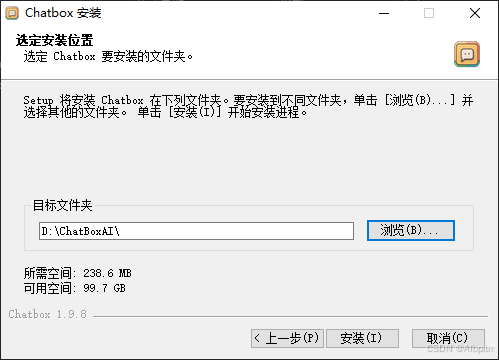

- 选择一个安装位置,点击

浏览按钮。

- 在弹出窗口中选择安装目录,点击

确定。

- 回到安装界面,点击

安装。

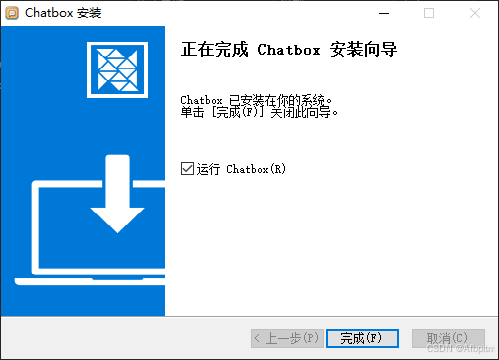

- 等待安装完成。

- 安装完成后,点击

完成,稍等片刻,会弹出一个界面(这是你之后与 DeepSeek 对话的窗口),关闭它,继续下一步。

3.DeepSeek-R1

-

拉取模型需要通过命令行操作。

-

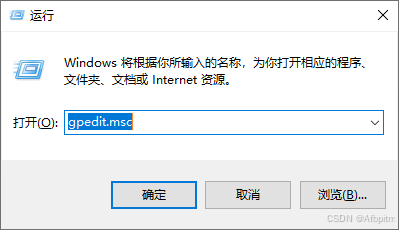

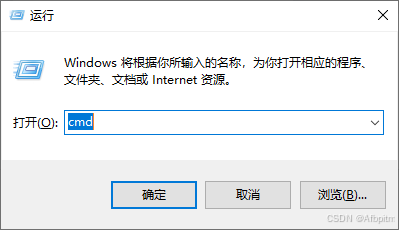

同时按下

Win + R打开运行窗口。

- 输入

cmd,回车。

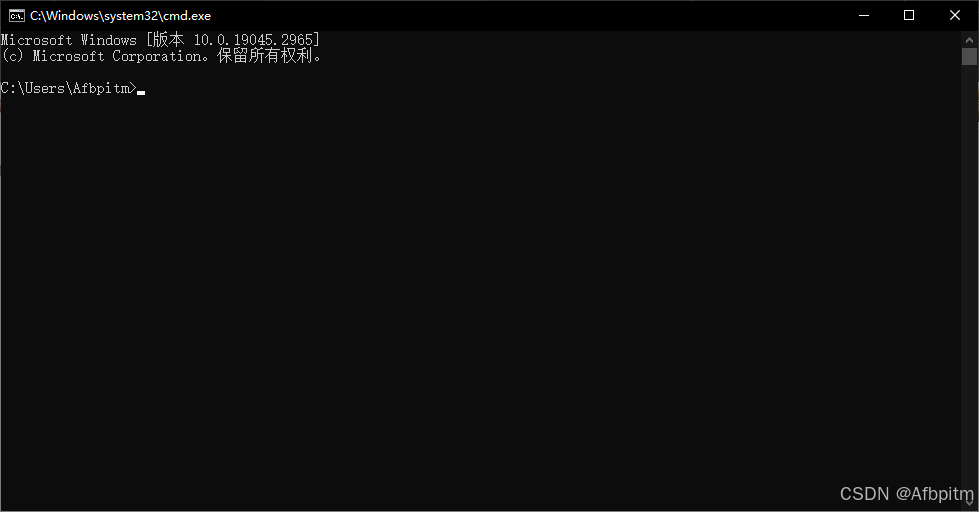

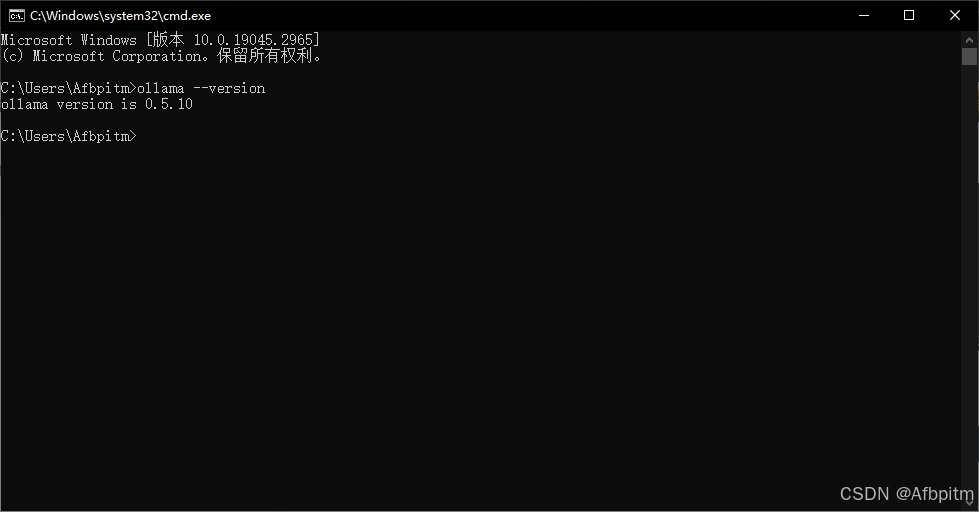

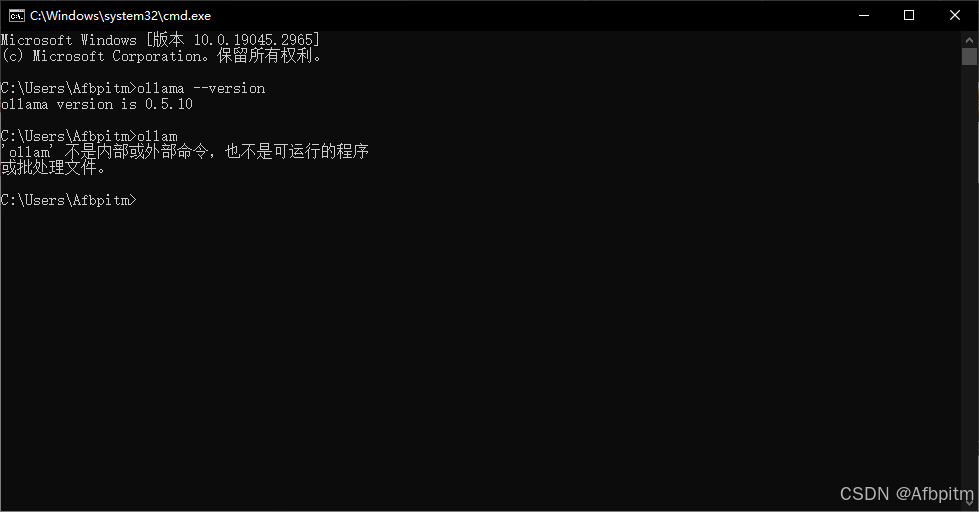

- 出现命令提示符窗口后,输入以下命令:

ollama --version

- 然后会出现版本信息。

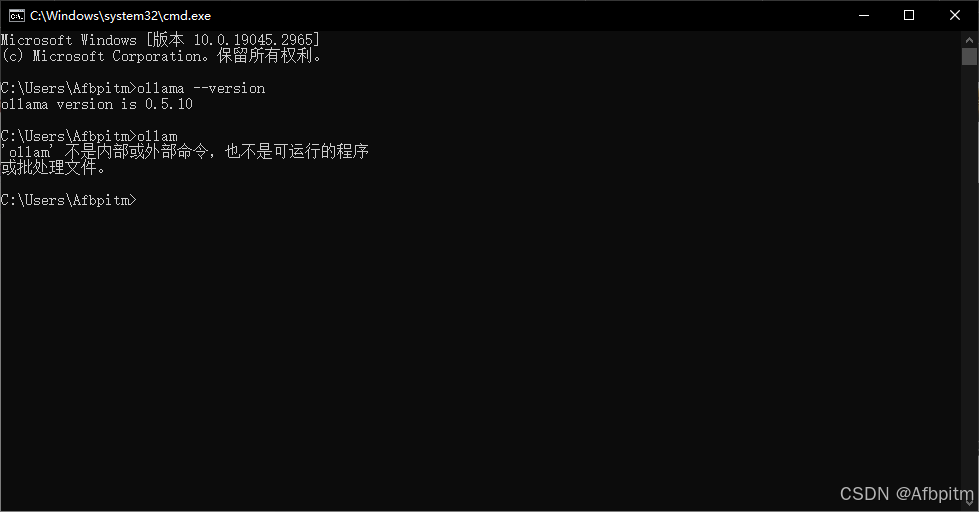

- 但如果你输入命令后提示错误,看到类似提示信息,请反复检查命令是否正确。如果确认无误仍报错,建议返回

Ollama部分重新操作一遍。

- 再次进入 Ollama 官网(不要关闭命令提示符窗口)。

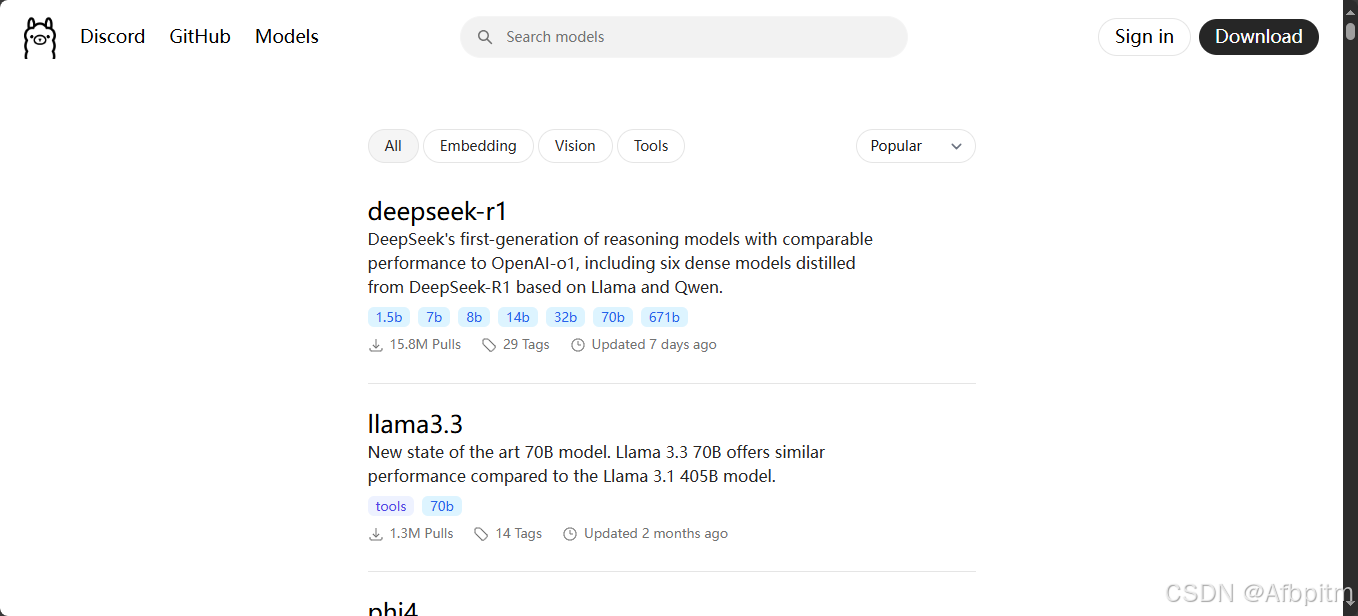

- 点击左上角的

Models。

-

然后在列表中选择你需要的 AI 模型,一般推荐第一个显示的

deepseek-r1。 -

点击

deepseek-r1。

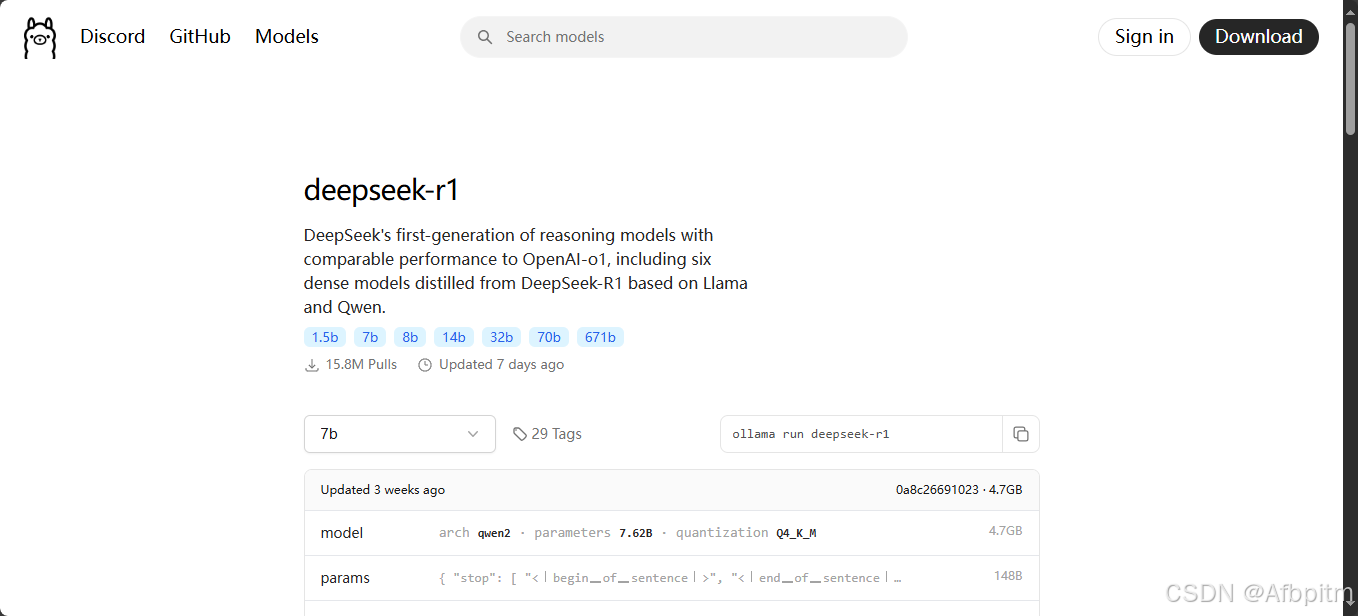

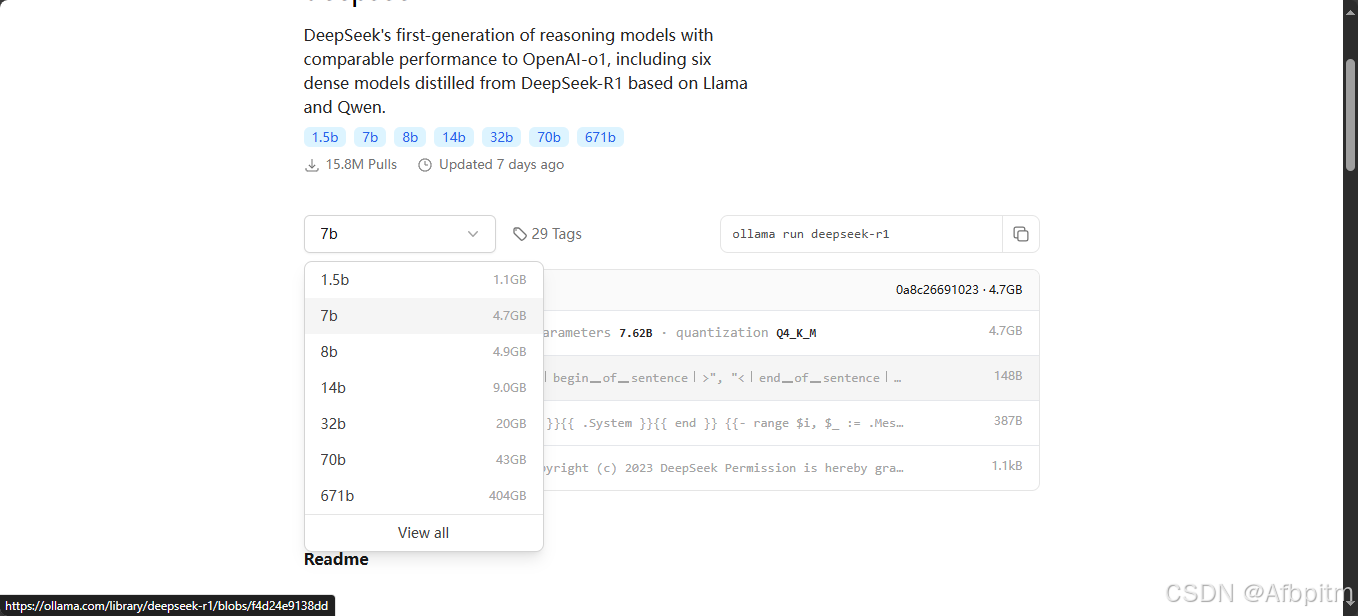

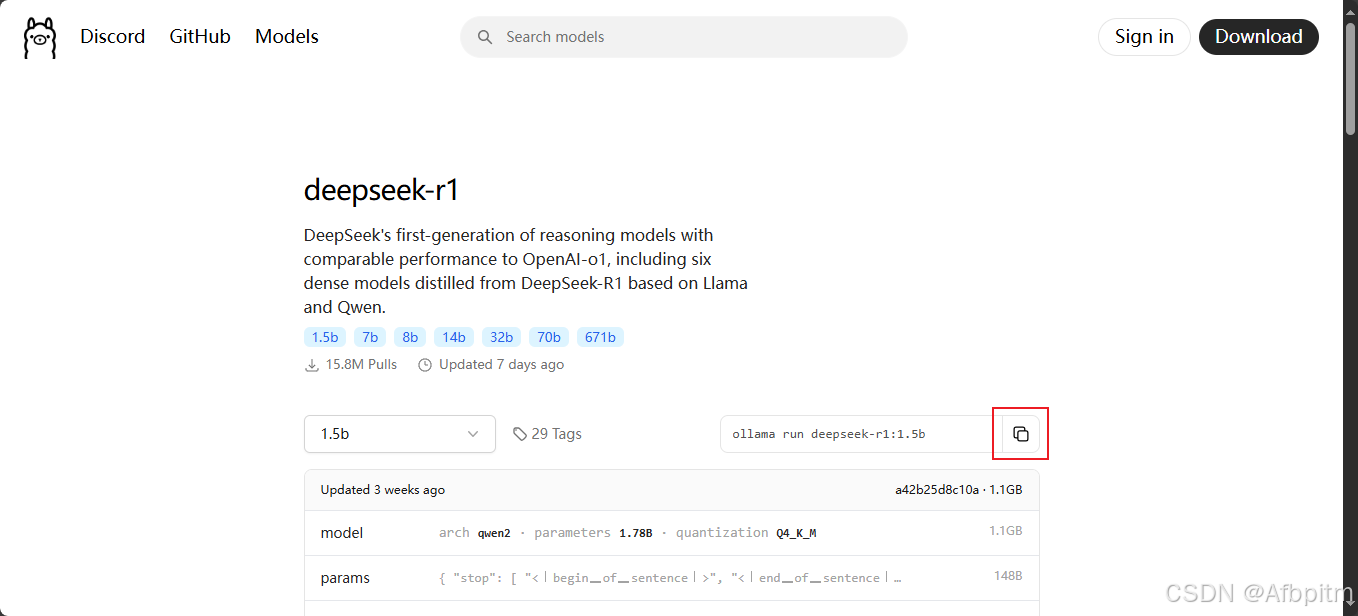

- 点击下拉框,选择适合自己的蒸馏版本。

-

如何选择?请参考下文 Decide 部分的说明。

-

选好后点击图中红色框内的

Copy按钮。

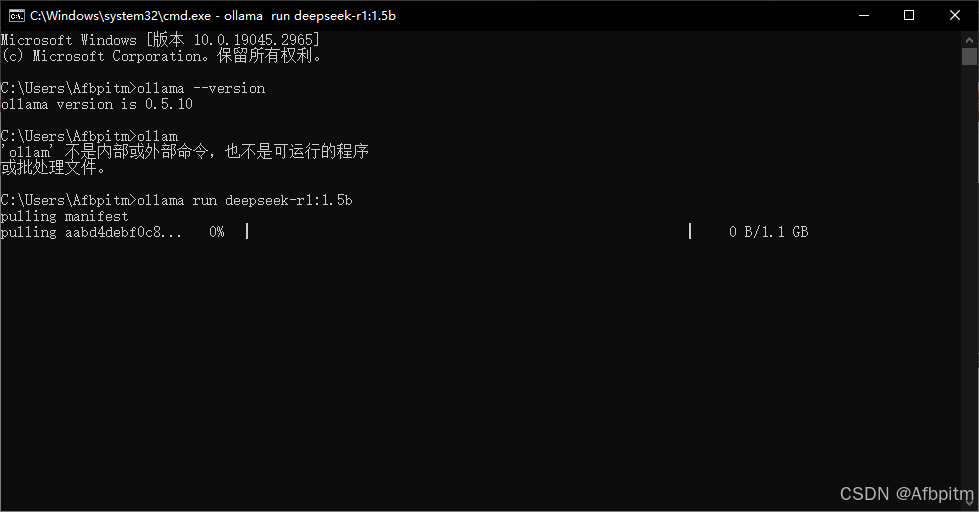

- 回到命令提示符窗口,右键粘贴复制的内容。

- 粘贴完成后回车。

-

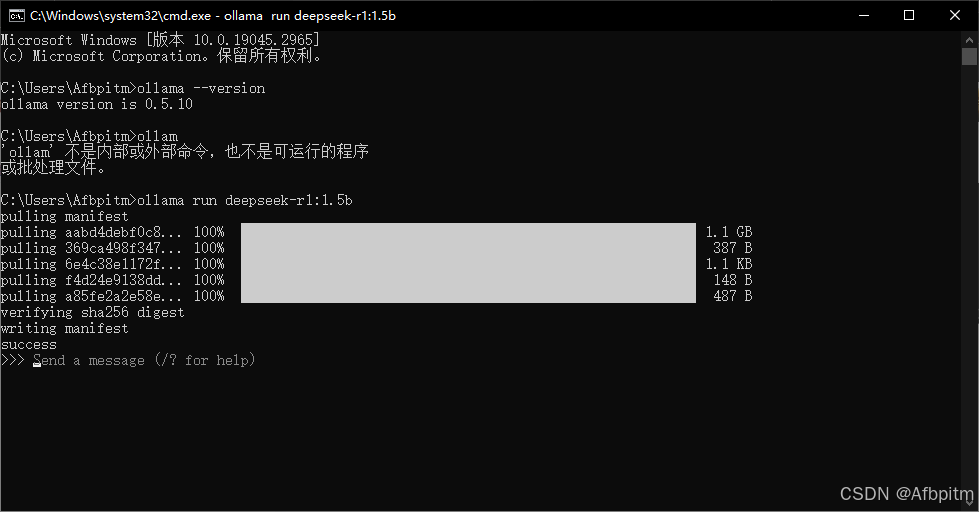

等待模型拉取完成。

-

当看到提示

success,说明模型拉取成功。

-

命令行中会出现

Send a message字样,可忽略不处理。 -

下一步。

-

组装

-

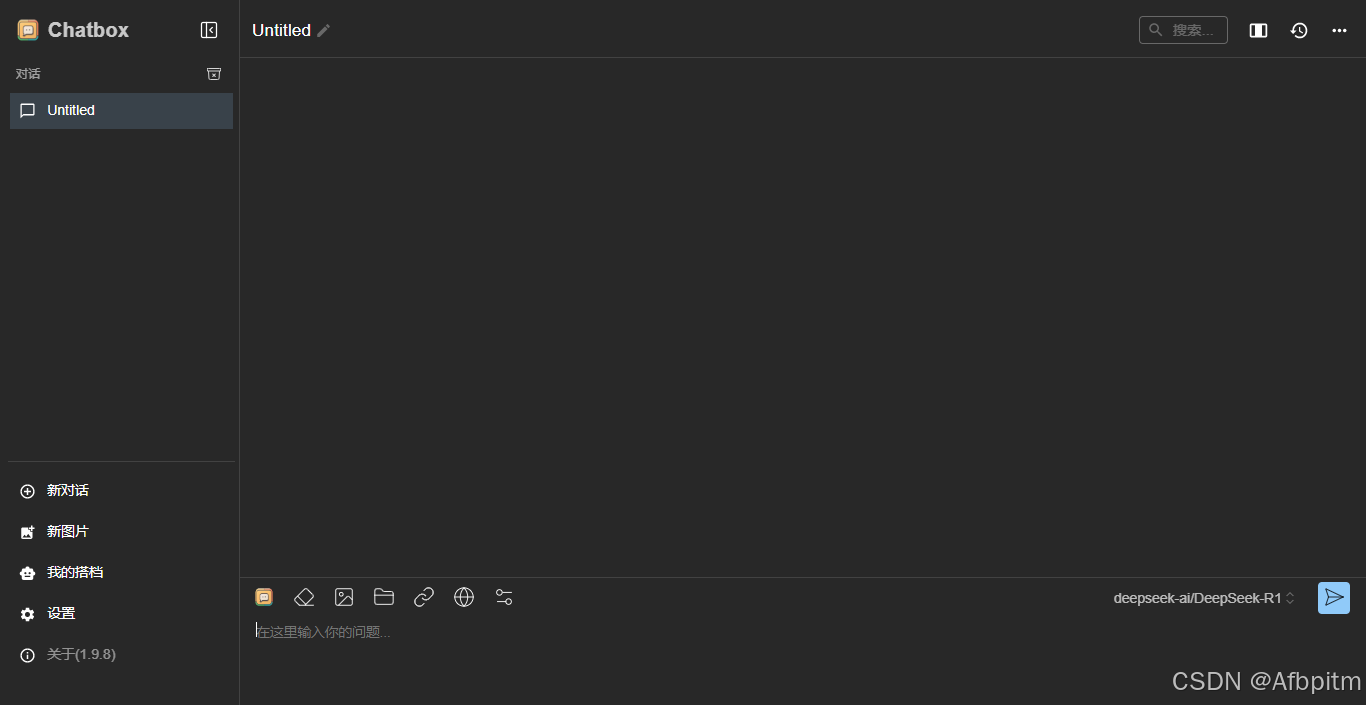

打开桌面上的

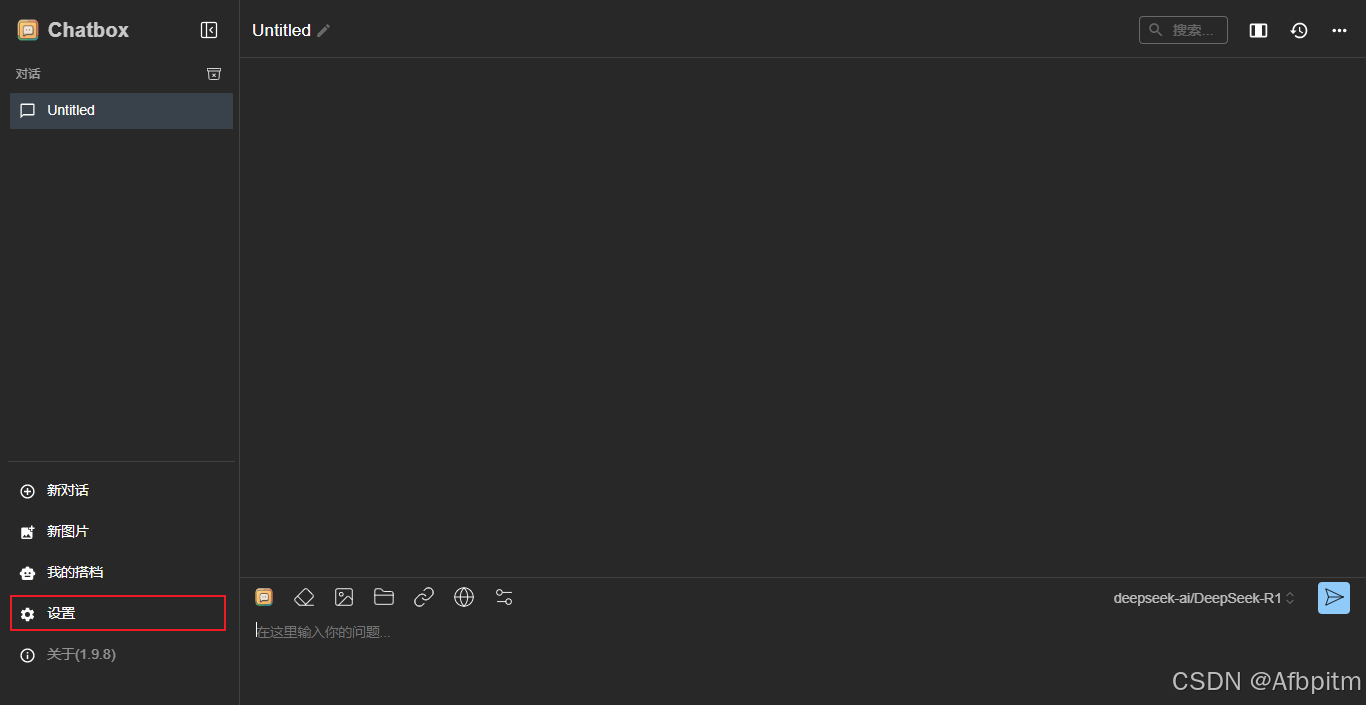

ChatBoxAI应用程序。

- 点击

设置。

- 打开

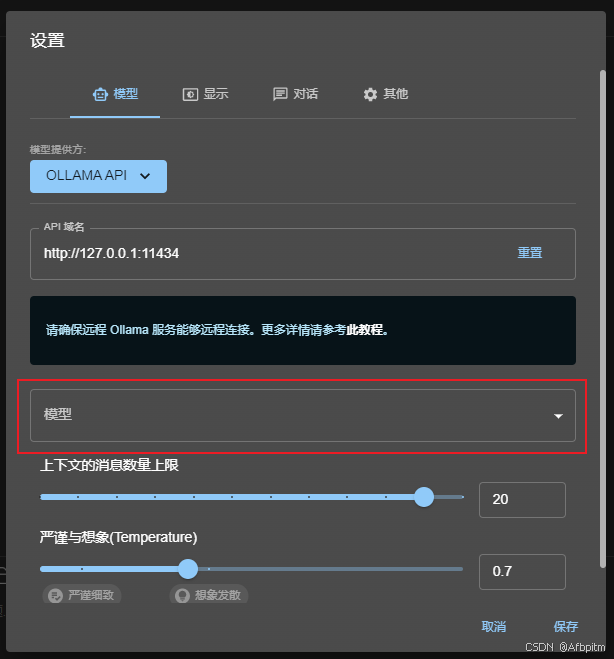

模型提供方下拉菜单。

- 选择图中红色框内的

Ollama API。

- 打开

模型下拉菜单。

- 可以看到我们刚刚拉取的

deepseek模型,选择它。

- 点击

保存。

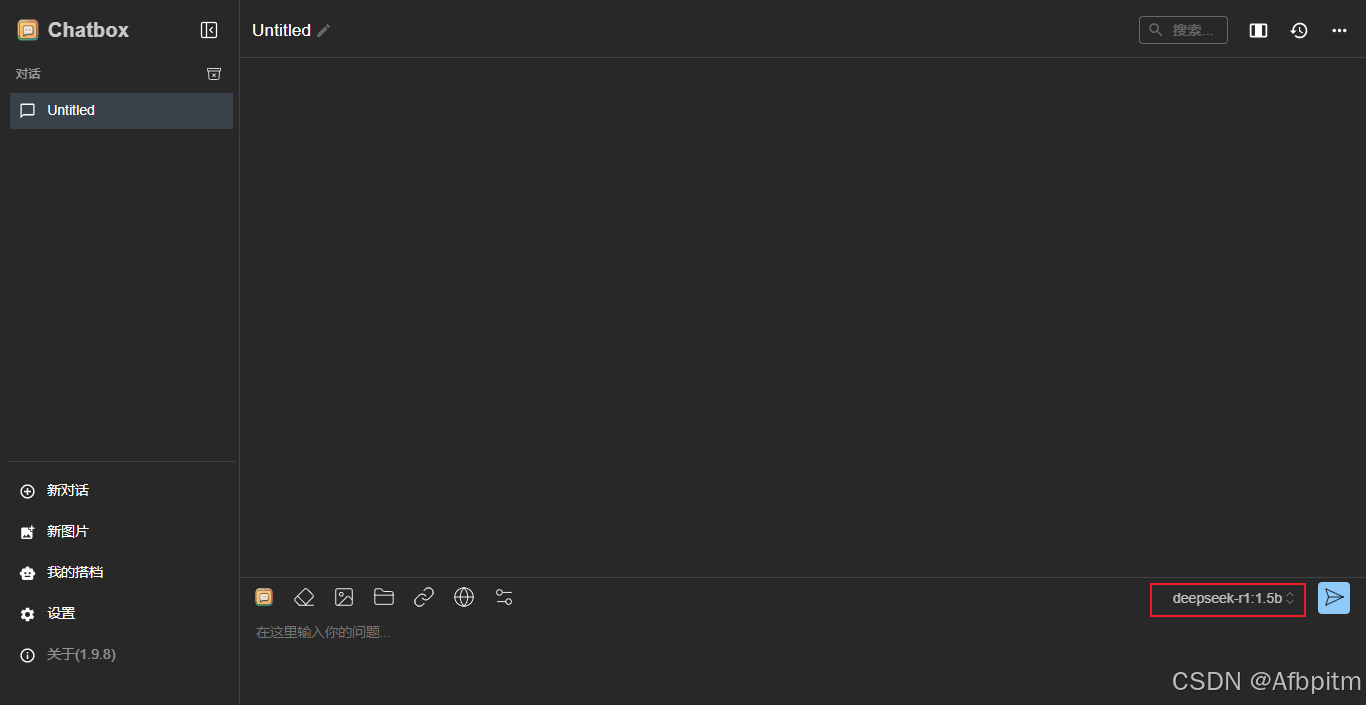

- 这里的模型名称也会同步更新为你刚刚选择的 AI。

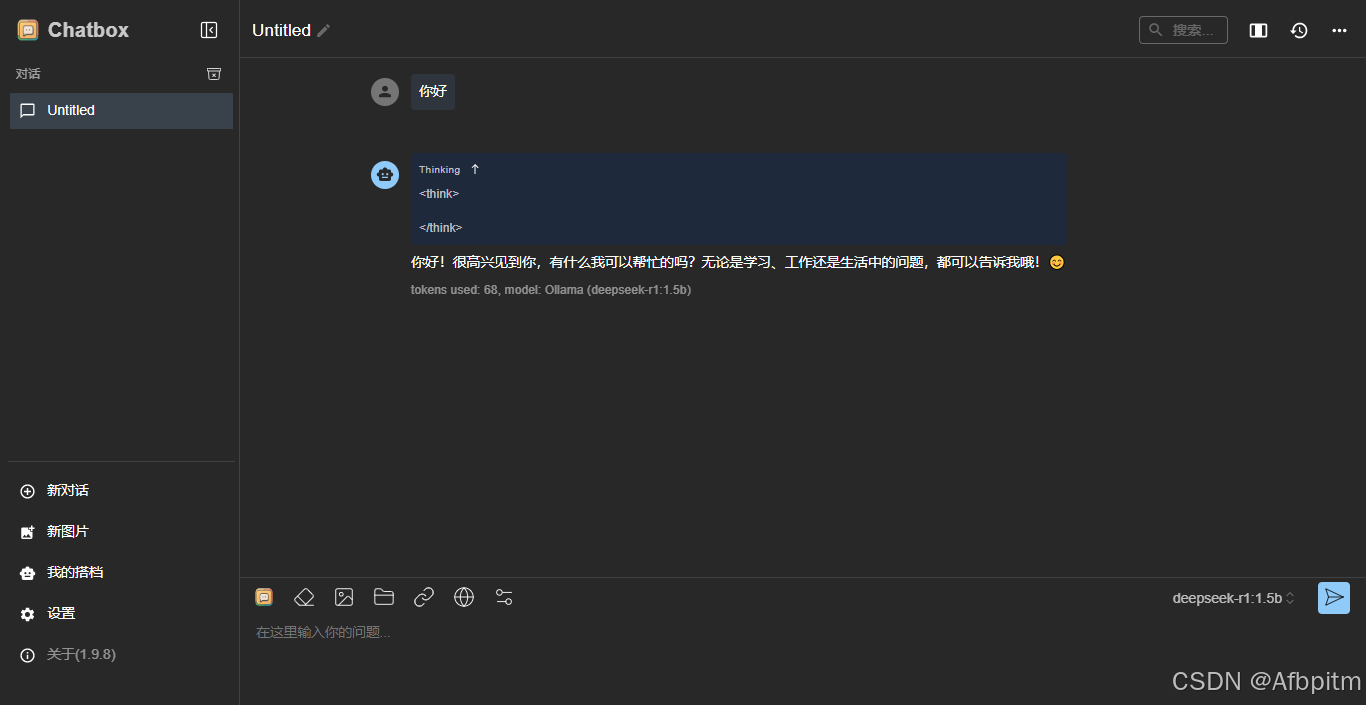

- 然后可以尝试输入一条消息测试一下。

-

之后每次打开

ChatBoxAI即可与DeepSeek对话 😊 -

关闭程序会自动终止 AI 进程。

三、文末

至此,已完成 DeepSeek 的本地部署。(如果配置不足,无法本地部署或体验较差,请阅读我的这篇文章:

deepseek - 连接 SiliconFlow - API 使用方法(非本地部署))

四、Decide

CPU: 至少 8 核,推荐 16 核或以上。

GPU: 至少 16GB 显存,推荐 24GB 或以上(如 NVIDIA RTX 3090、A100 等)。

内存: 至少 32GB,推荐 64GB 或以上。

存储: 至少 100GB SSD ,推荐 NVMe SSD 以加快加载速度。

-

小型蒸馏版: 适合低资源环境,显存需求约 8GB,内存需求约 16GB。(1.5b、7b、8b)

-

中型蒸馏版: 显存需求约 16GB,内存需求约 32GB。(14b)

-

大型蒸馏版: 显存需求约 24GB,内存需求约 64GB。(32b)

对性能要求更高的版本不推荐个人用户本地部署使用。

实际运行所需配置可能更低,但具体表现会根据你的硬件配置有所差异,请根据实际情况自行选择。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)