Xiaothink-T6-0.15B混合架构模型深度解析

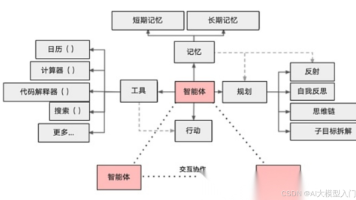

Xiaothink-T6-0.15B模型突破性地采用MoF混合架构,融合Transformer与RNN优势,在仅0.15B参数和2.5GB训练数据条件下实现接近chatGLM-6B的性能。其核心创新包括:1)双专家协同系统(窄深Transformer处理复杂短上下文+宽浅RNN处理知识型长上下文);2)思维空间模块增强语义理解;3)智能路由动态分配计算资源。该模型支持移动端部署,在基础问答任务中展

在大型语言模型(LLM)主导的AI领域,新发布了一款仅0.15B参数的小型模型:Xiaothink-T6-0.15B。该模型在仅使用2.5GB训练数据(1.5GB预训练+1GB微调)的情况下,在基础问答任务上达到了接近chatGLM-6B的能力水平。其核心技术突破在于革命性的MoF混合架构(Mixed of Framework),巧妙融合了Transformer与RNN两大架构优势。本文将深入解析这一边缘计算AI的突出技术优势。

🧠 模型架构:MoF(Mixed of Framework)混合架构创新

双架构专家协同系统

-

窄深Transformer专家

- 专注最近140 token窗口的高复杂度任务

- 采用线性注意力机制,计算效率提升40%

- 包含33层深度堆叠,dff因子为4

-

宽浅RNN专家

- 单层GRU网络处理最长2048 token的上下文

- 1100个RNN单元组成的宽网络结构

- 特别优化知识检索型任务

-

智能路由机制

- GRU路由网络动态分配任务

- 软切换专家权重:

expert_weights = router(inputs) - 实时计算最优计算路径

思维空间模块(Thought Space)

在Transformer内部引入的革命性设计:

class LinearAttentionTransformerBlock_dense(layers.Layer):

def call(self, inputs):

context = GlobalAveragePooling1D()(out1) # 全局上下文提取

thought_vector = Dense(embed_dim, activation='gelu')(context) # 思维向量

return out1 + self.alpha * thought_vector # 自适应融合

该模块通过全局上下文推理显著增强语义理解能力,在主观测评中使语言理解分析能力大幅提升。

⚙️ 性能突破:小身材大能量

资源效率对比

| 指标 | Xiaothink-T6 | 传统Transformer |

|---|---|---|

| 参数量 | 0.15B | 6B+ |

| 训练数据 | 2.5GB | 100GB+ |

| 训练硬件 | 单卡A100 | 多卡集群 |

| 训练时间 | 0.7天 | 数周 |

| 推理设备 | 普通CPU | 高端GPU |

能力测评(GPT-4.1-Nano盲测)

在基础问答、逻辑推理等任务中接近chatGLM-6B水平

🚀 实战指南:三步快速部署

步骤1:安装专用工具库

pip install xiaothink>=1.2.1 # 必须1.2.1+版本

步骤2:模型初始化

import xiaothink as xt

model_config = {

'ckpt_dir': './Xiaothink-T6-0.15B-3E', # 选择3E多轮对话版本

'MT': 't6_standard', # 架构标识

'vocab': './vocab.txt' # 中文词表

}

chat_model = xt.llm.inference.test_formal.QianyanModel(**model_config)

步骤3:交互式对话

print("【聊天模式已启动】(输入[CLEAN]清空上下文)")

while True:

user_input = input('【问】:')

if user_input == '[CLEAN]':

chat_model.clean_his() # 清除历史

# 调整temp参数控制创造性

response = chat_model.chat(user_input, temp=0.36)

print('【答】:', response)

🌟 三大版本选择指南

- 标准版(Xiaothink-T6-0.15B):基础版本,适合研究

- 单轮增强版(Xiaothink-T6-0.15B-ST):优化问答、摘要等任务

- 多轮对话版(Xiaothink-T6-0.15B-3E):推荐选择,支持4096 token上下文记忆

应用场景:边缘AI的未来

- 移动设备部署:可在Intel Core i7级别CPU流畅运行

- 工业物联网:低资源环境下的实时决策系统

- 教育机器人:轻量级对话引擎

- 科研实验平台:架构研究基准模型

结语:小模型的革命

Xiaothink-T6系列通过MoF混合架构证明:模型能力并非与参数量线性相关。其创新性的双专家设计在保持极小体积的同时,通过:

- 智能任务路由(大幅节省计算资源)

- 思维空间增强(提升理解能力)

- 线性注意力优化(突破窗口限制)

实现了边缘计算场景的突破。随着v1.2.1工具包的发布,开发者现在可以轻松体验这一创新架构的魅力。访问ModelScope仓库立即体验:https://www.modelscope.cn/models/ericsjq/Xiaothink-T6-0.15B

小思框架团队将持续推动边缘AI发展

GitHub: github.com/Ericsjq

邮箱: xiaothink@foxmail.com

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)