docker.dify接入本地部署的deepseek大模型macOS

本文介绍了如何下载和部署本地大模型,并通过ollama和dify进行接入。首先下载ollama并选择合适的模型版本(如8b/14b/32b),通过终端命令完成下载测试。接着配置ollama服务监听0.0.0.0以允许外部访问,并在dify中安装ollama插件,设置连接地址为docker内部域名。最后创建对话测试本地模型接入成功。整个过程详细说明了从模型下载到应用集成的完整流程。

·

本地大模型下载以及接入

ollama部署本地大模型

- 下载ollama

https://ollama.com/

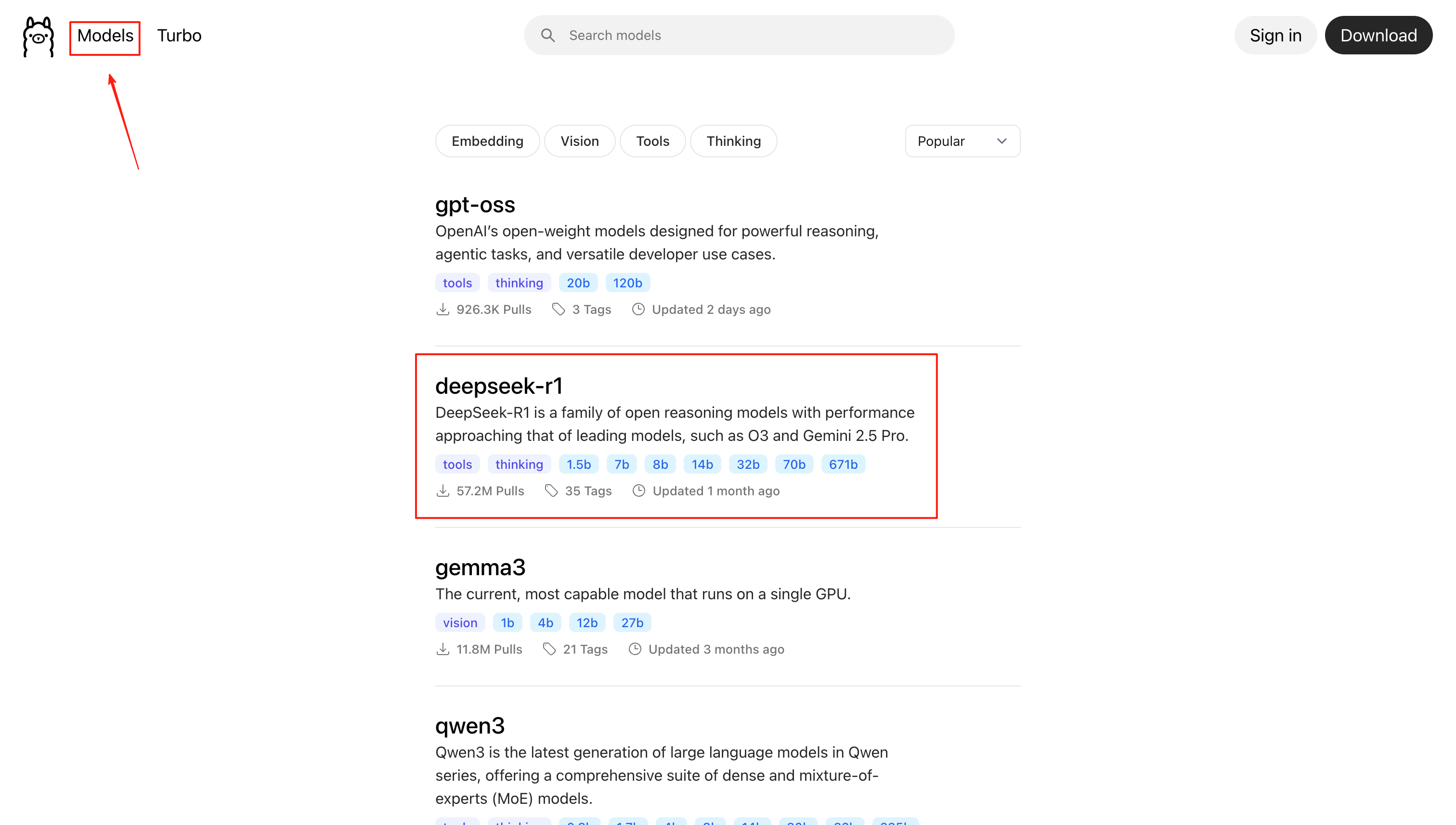

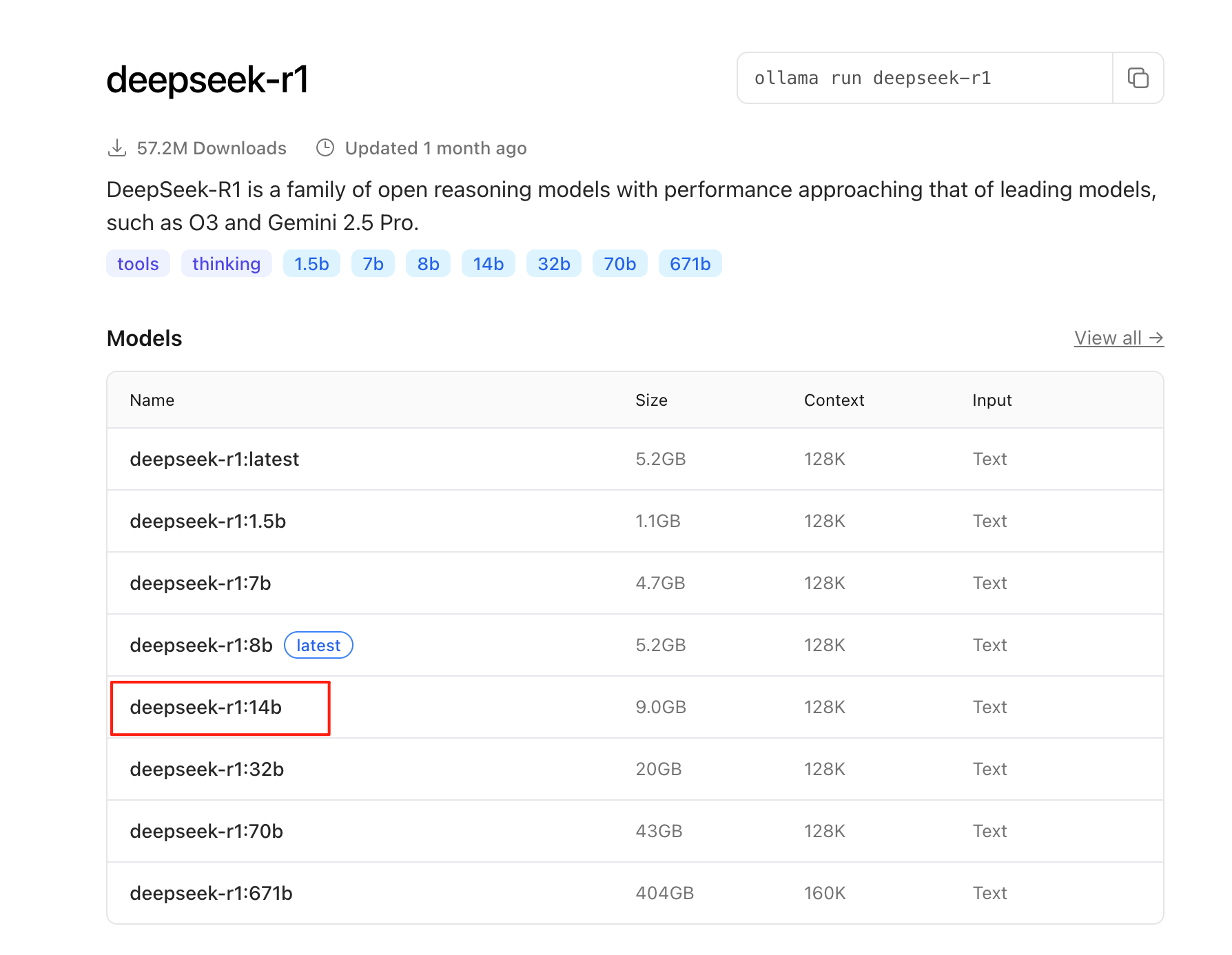

- 下载模型

可以直接在官网下载。

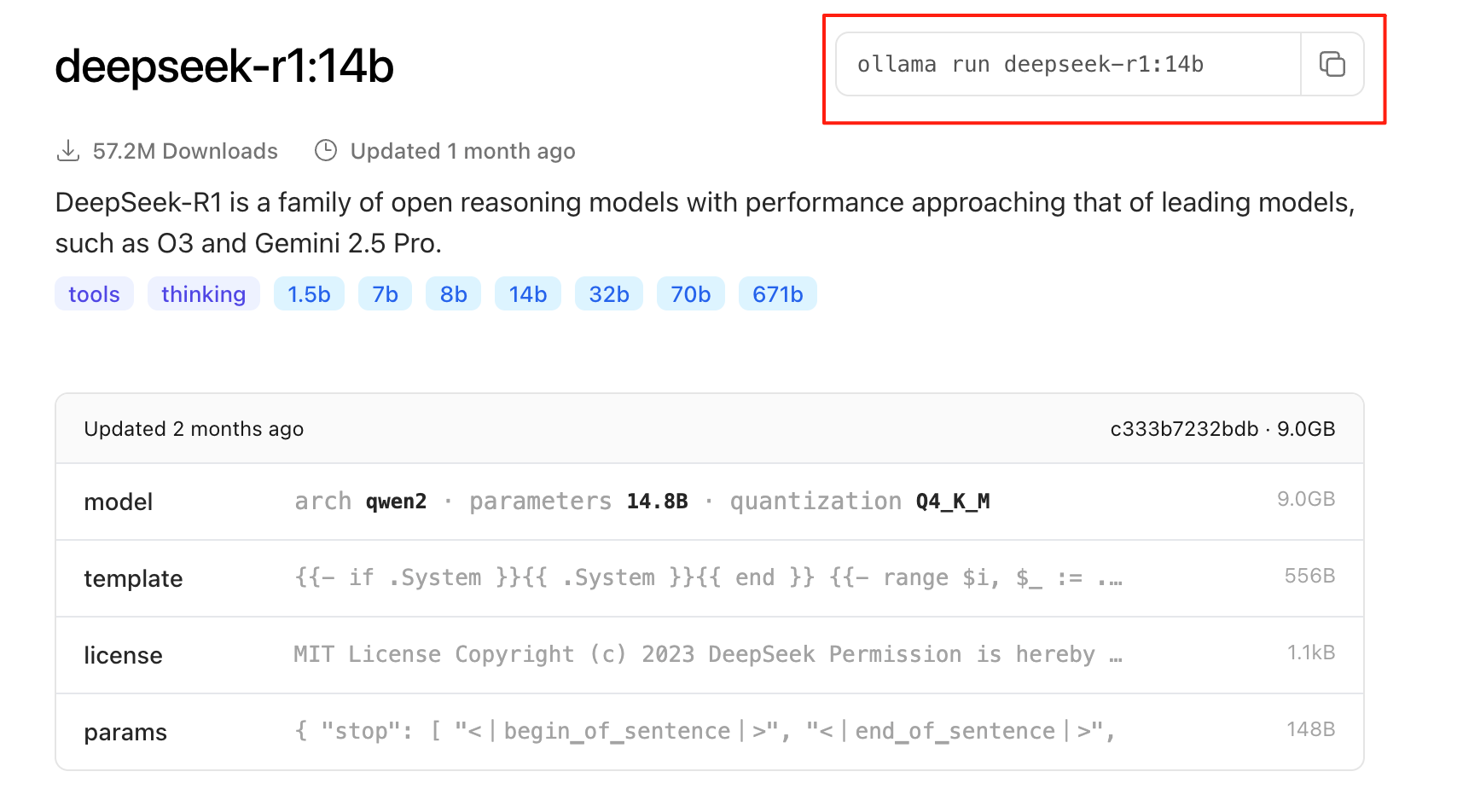

选择自己想下载的版本,根据电脑配置选择,一般本地8b,14b,32b中选。

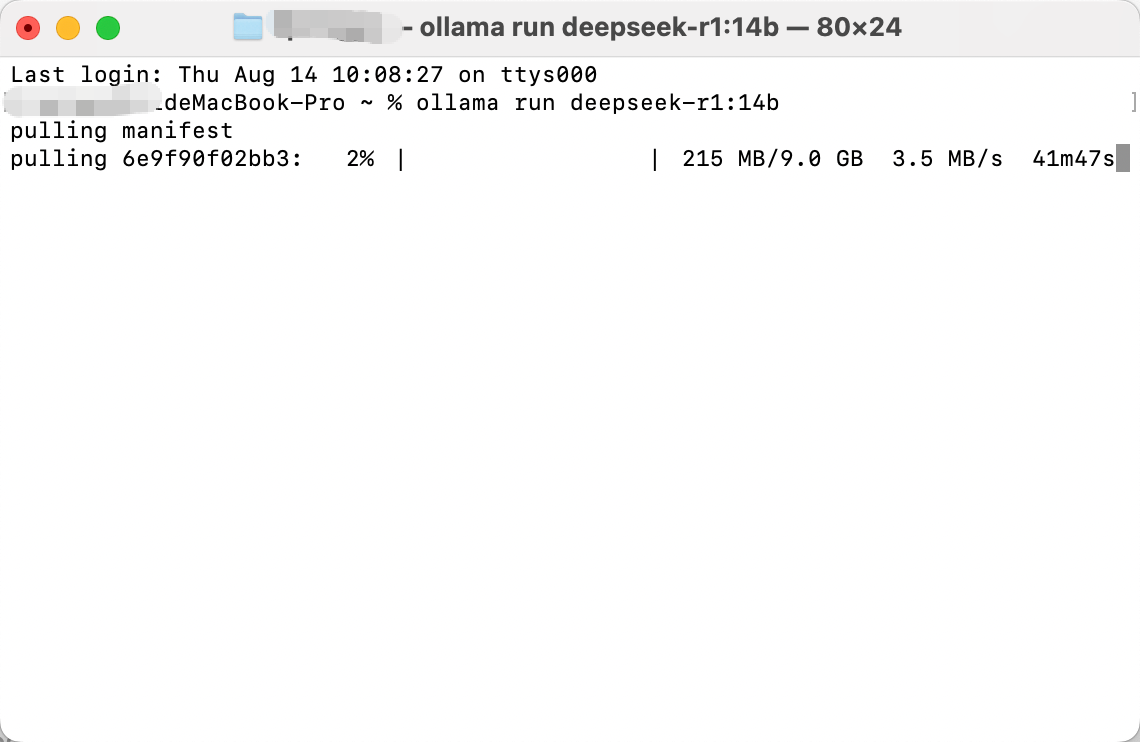

复制命令终端执行即可自动下载。

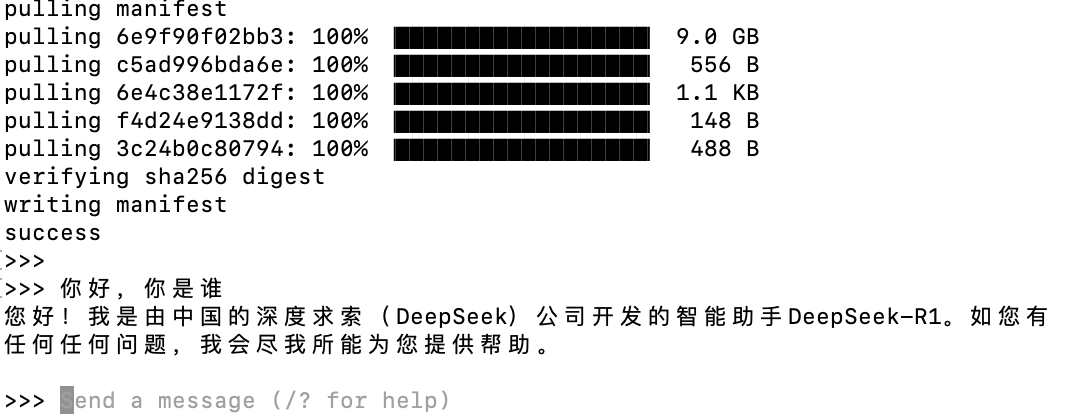

下载好进行测试。

dify接入本地大模型

ollama配置

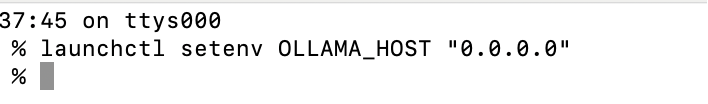

- 配置ollama服务可以接受请求统一网络其他。

launchctl setenv OLLAMA_HOST "0.0.0.0"

- 重启容器,让设置生效。

因为ollama默认绑定的127.0.0.1也就是允许本机访问,我们是docker部署的dify,即使docker运行在本机也不行,因为127.0.0.1属于容器外部,对docker内部容器是不可见的。

设置为0.0.0.0就可以让监听统一网络下的全部端口,包括docker端口。

dify配置

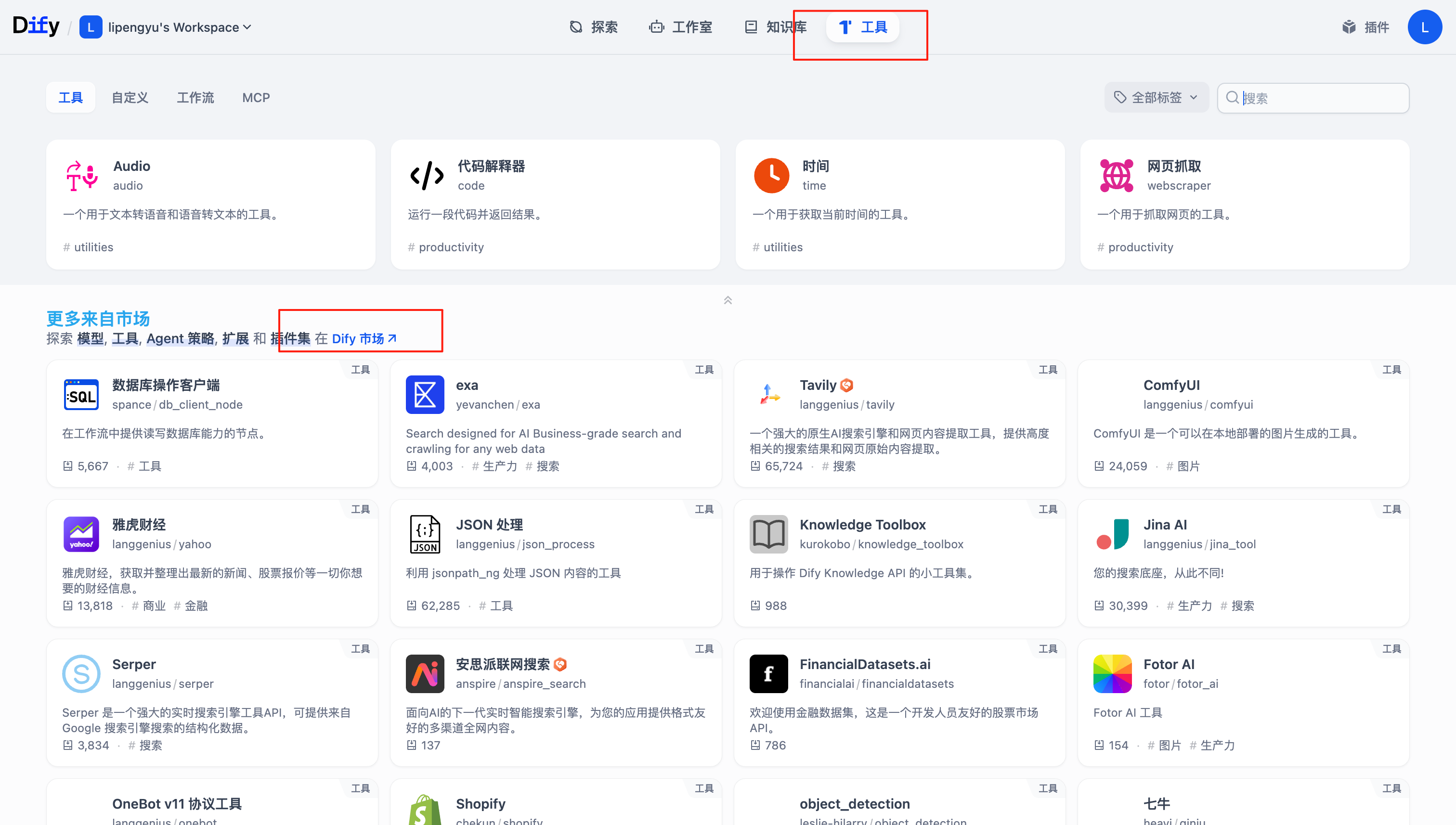

在工具插件市场中搜索ollama插件,安装。

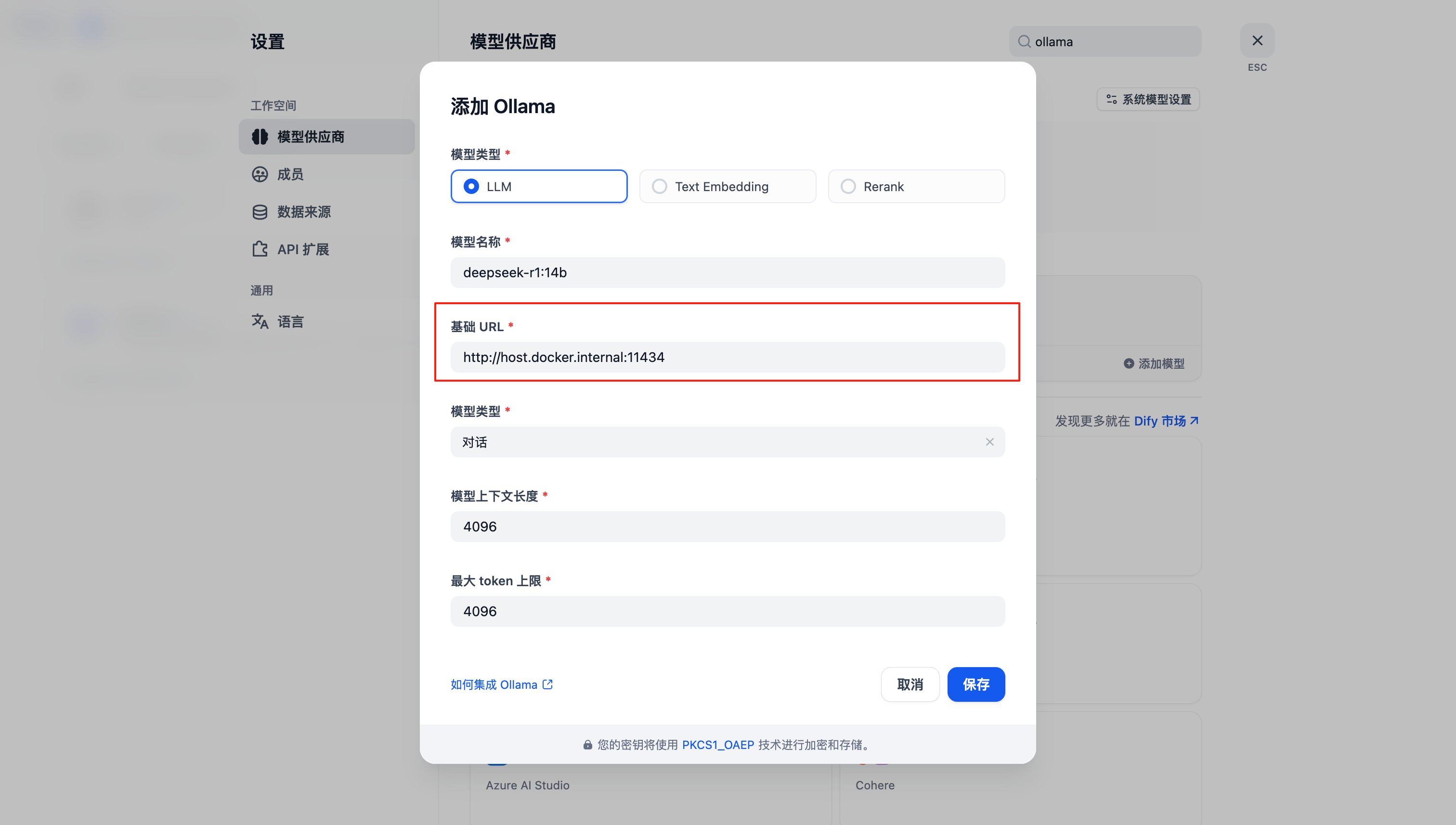

点击设置,选择ollama配置大模型。

配置路径:

http://host.docker.internal:11434

这个是docker内部访问外部的特殊域名。

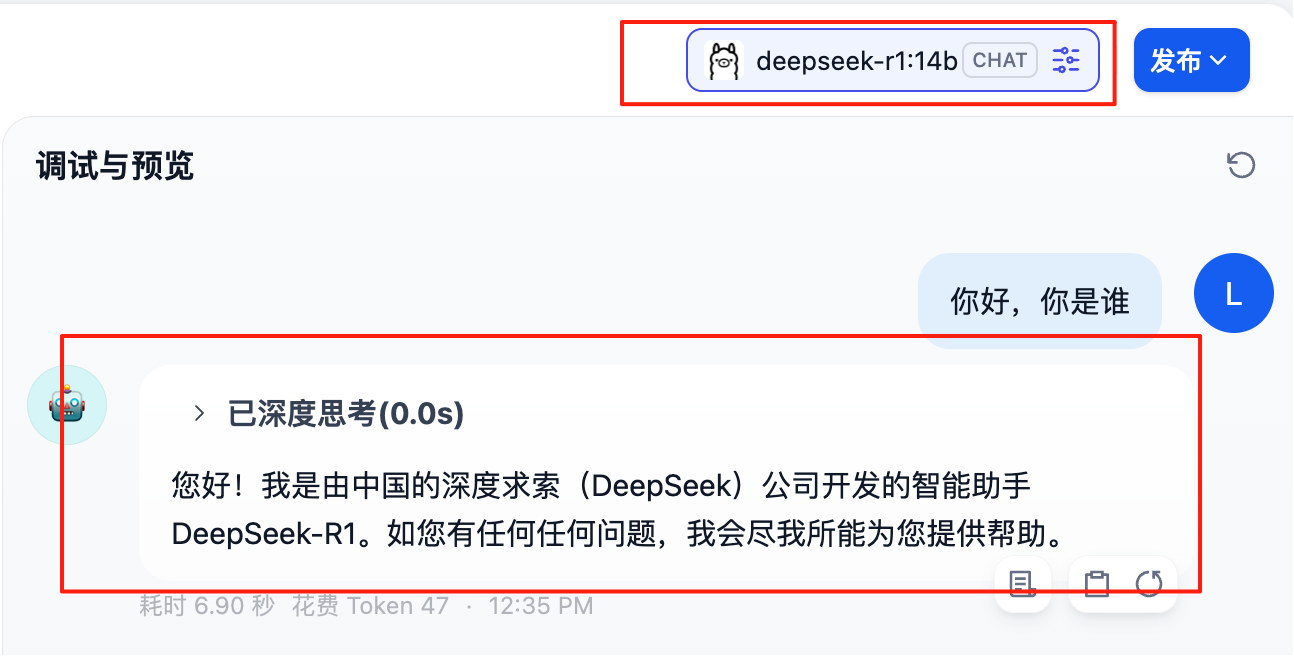

保存后,随便创建一个对话切换为我们刚接入的本地模型测试一下。

恭喜你成功完成接入哦。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)