NVIDIA RTX PRO 6000 Blackwell 精度算力对比及 LLM 应用分析

方面,如果是大模型的线上服务,需求往往是批量推理吞吐和足够大的显存,RTX 6000 Blackwell 的单卡性能和 96GB 显存非常契合此类需求,可以用于部署 70B 级别模型的加速推理。搜索了一下,好像没有很好的资料,特别是对于其具体的参数上,很多文章都是二手,三手,甚至是洋葱文章,无法做到详细的对比。) 的高带宽 HBM,内存带宽略低。4-bit 量化是更激进的一步,目前主要在研究阶段,

最近AI卡的发展也是越来越快,很多新卡好像也是越来越强了。昨天被问到RTX PRO 6000怎么样。搜索了一下,好像没有很好的资料,特别是对于其具体的参数上,很多文章都是二手,三手,甚至是洋葱文章,无法做到详细的对比。经过在英伟达官网上的技术文档的一手调研,终于能够搞清楚了PRO 6000到底几斤几两。

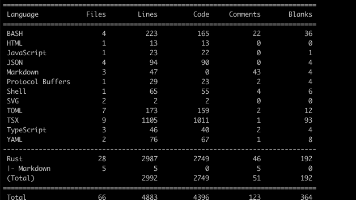

各精度算力指标对比(RTX PRO 6000 vs A100 80GB vs H20 96GB)

下表汇总了 NVIDIA RTX PRO 6000 Blackwell(工作站版)、数据中心级 A100 80GB(Ampere架构)以及 H20 96GB(Hopper架构,中国版)在多种计算精度下的峰值算力表现(单位:TFLOPS 或 TOPS)。表中斜杠前的数值为稠密计算(不使用稀疏加速)的性能,斜杠后的带“”数值为使用结构化稀疏加速下的性能(2:1稀疏模式可使Tensor Core吞吐量加倍[1])。粗体*标注表示利用Tensor Core实现的混合精度矩阵计算吞吐量。RTX 6000 Blackwell 的 FP64 性能仅为 FP32 的 1/64,用于程序兼容而非高性能计算[2]。

|

精度 |

NVIDIA A100 80GB (Ampere) |

NVIDIA H20 96GB (Hopper中国版) |

NVIDIA RTX PRO 6000 (Blackwell) |

|

FP64 (双精度) |

9.7 TFLOPS (19.5 TFLOPS,Tensor Core)[3] |

~1 TFLOPS[4] (不支持FP64 TC) |

~2 TFLOPS (1/64 FP32,仅CUDA Core)[2] |

|

FP32 (单精度) |

19.5 TFLOPS[3] |

~44 TFLOPS[5] |

126.0 TFLOPS[6] |

|

TF32 (Tensor Core) |

156 / 312* TFLOPS[7] |

~74 / 148* TFLOPS[5] |

251.9 / 503.8* TFLOPS[8] |

|

BF16 (Tensor Core) |

312 / 624* TFLOPS[9] |

~148 / 296* TFLOPS (推测) |

503.8 / 1007.6* TFLOPS[10] |

|

FP16 (Tensor Core) |

312 / 624* TFLOPS[11] |

148 / 296* TFLOPS[5] |

503.8 / 1007.6* TFLOPS[10] |

|

FP8 (E4M3 / E5M2) |

不支持 |

≈300 / 600* TFLOPS (估算) |

1007.6 / 2015.2* TFLOPS[8] |

|

INT8 (Tensor Core) |

624 / 1248* TOPS[12] |

296 / 592* TOPS[5] |

1007.6 / 2015.2* TOPS[13] |

|

INT4 (Tensor Core) |

1248 / 2496* TOPS[14] |

≈592 / 1184* TOPS (估算) |

2015.2 / 4030.4* TOPS[8] |

|

FP4 (Tensor Core) |

不支持 |

不支持 |

2015.2 / 4030.4* TFLOPS[8] |

注:上述 Tensor Core 算力均假设使用稀疏Tensor加速(2:1 结构化稀疏)时,性能提升一倍(斜杠后标注号的数值)[1]。A100/H20 的 FP64 一栏斜杠后括号中的数值表示利用Tensor Core进行矩阵运算的双精度性能[3]。RTX 6000 Blackwell 的 FP64 性能受限,仅提供约 2 TFLOPS(为 FP32 算力的1/64,用于保证程序兼容性[2])。H20 的 FP8/INT4 性能未公布,约按其 15% 的 H100 理论性能估计[15]。

上述数据尽量采用官方指标;A100 80GB 和 RTX 6000 Blackwell 来自官方白皮书/数据表[16][8]。H20 因未公开详细规格,表中采用权威来源披露的测算值[5]并结合 H100 比例估计(以注明“~”或“≈”)。可以看出,RTX PRO 6000 Blackwell 在低精度(如 FP16/FP8/INT4)上的理论吞吐远高于上一代 A100 80GB [8]。但需注意 RTX 6000 Blackwell 并非面向 HPC 双精度运算,其 FP64 算力远低于数据中心 GPU(仅约 2 TFLOPS)[2]。另外,RTX 6000 Blackwell 虽有高达 96GB 的显存,但采用 GDDR7 显存(带宽约 1.79 TB/s[17]),相比 A100 (80GB HBM2e ~ 2.0 TB/s) 和 H20 (96GB HBM3 ~ 4.0 TB/s[5]) 的高带宽 HBM,内存带宽略低。在使用上述算力时,需要利用 Tensor Core 指令才能达到表中标称的 TF32/BF16/FP16/FP8/INT8 等精度性能,并在模型稀疏化条件下达到后面的加速性能。下面,我们进一步比较这些差异对大模型训练与推理的影响。

大模型训练与推理适用性分析

单卡性能与适用场景

NVIDIA RTX PRO 6000 Blackwell 拥有极高的单卡低精度算力和超大的显存容量(96GB),非常适合单卡运行大型AI模型的推理或开发调试。相比 A100 80GB(仅 80GB 内存)和常规 Hopper H100 80GB,RTX 6000 的 96GB 容量允许容纳更大的模型。比如,Llama 2 70B 等模型在 INT8 精度下约需 65 GB 显存即可加载,RTX 6000 单卡即可完整放下并运行推理;而 A100 80GB 也可容纳但空间较紧张,H100 80GB 则可能需要切分内存或减少 batch size。得益于 Blackwell 架构高达千兆级的 FP8/INT8 算力,RTX 6000 在单卡推理吞吐上会非常可观,对于批量推理服务或模型微调中的前向计算有优势。同时,96GB 显存也利于单卡对较大模型进行低精度微调(如 LoRA、QP4Quan 4-bit 量化微调等),不用像小显存卡那样频繁借助主机内存。需要注意的是,RTX 6000 Blackwell 的双精度能力很弱,不适合需要高 FP64 精度的科学计算场景,这一点与 A100/H100 等数据中心 GPU 有本质区别[2]。总体而言,在单卡模式下,RTX 6000 Blackwell 非常适合大模型的开发调试和推理工作,尤其适合需要超大显存和高密度矩阵运算的应用。

多卡训练的性能与扩展性

在多卡训练场景下,RTX PRO 6000 Blackwell 相对于数据中心 GPU 存在明显劣势。首先,RTX 6000 缺乏 NVLink 高速互联能力——不像 A100 (支持 NVLink 600 GB/s直连[18])或 H100/H20 (8卡 NVSwitch 互联高达 900 GB/s[19]),RTX 6000 只能通过主板 PCIe 总线进行 GPU 间通信。即使 RTX 6000 支持 PCIe 5.0 ×16(单向带宽约 32 GB/s,总带宽 64 GB/s)[20], 其通信带宽只有 NVLink 互联的几十分之一。在大模型训练中,多个 GPU 需要频繁同步梯度和模型分片激活值,RTX 6000 多卡由于带宽瓶颈,很难像 A100/H100 那样高效扩展。在数据并行训练时,RTX 6000 间通过 PCIe 交换梯度,相比 NVLink 架构会有更高延迟和更低吞吐,导致多卡加速比不佳[18]。在模型并行或流水线并行场景下(必须在多卡间拆分模型),没有 NVLink 的 RTX 6000 需要经由CPU内存或PCIe交换分块张量,通信开销巨大。因此,使用 RTX 6000 组成多卡系统训练诸如 Llama2-70B 这样参数过百亿的大模型时,扩展效率和同步开销会成为主要瓶颈,难以线性加速。

需要特别指出的是,RTX 6000 Ada/Blackwell 专业卡近年来取消了以往 Quadro 系列的 NVLink 金手指(无法像早期 RTX A6000 那样桥接两卡共享显存)[21][18]。这意味着即使在一台工作站内插入两张 RTX 6000 Blackwell,也无法像 A100 那样组成统一的大显存池。每张 96GB 显存彼此独立,模型若超过 96GB 则仍需拆分运行,并通过 PCIe 交换数据。因此,在要求单一大模型占用多卡显存的情形(如并行加载一个超过 100 GB 权重的模型)下,RTX 6000 缺少 NVLink 会使实现和效率大打折扣。

多机集群和网络互联支持

在多机集群方面,RTX 6000 Blackwell 并非设计用于大型 GPU 集群环境。数据中心 GPU(如 A100/H100)不仅有 NVLink/NVSwitch 实现单机内 GPU 全互联,还支持 InfiniBand/NVLink Switch 等跨节点高速互联方案,可组成成百上千卡的大规模训练集群[22][23]。例如 H100 通过 NVLink Switch 可扩展至 256 GPU 互联,带宽是 PCIe Gen5 的 7倍以上[24]。相比之下,RTX 6000 主要面向工作站,在多机情况下只能通过常规以太网或 InfiniBand NIC 进行 GPU 通信,且缺乏 NCCL/Collective 通信优化支持(数据中心卡在 NVSwitch 拓扑下有专门调优)。因此,用多台配备 RTX 6000 的工作站搭建分布式训练,通信性能和软件栈支持都会弱于 DGX 或 HGX 等服务器方案。

此外,数据中心 GPU 通常支持 GPUDirect RDMA 等技术,可使多机通信绕过 CPU 瓶颈直接 GPU-NIC 通信,提高跨节点带宽利用。而 RTX 6000 这类工作站卡未必支持或经过优化验证这些特性。在多机大模型推理场景,如果模型太大只能拆分到多机,RTX 6000 可能在每层输出交换上产生明显延迟,推理吞吐也会降低。

总的来说,RTX 6000 Blackwell 更适合单机/单卡或少数几卡的小规模部署。如果需要扩展到多机多卡的集群(例如训练上千亿参数模型),A100/H100 等具备强互联和集群方案的 GPU 才是更合适的选择。RTX 6000 可以用于小型集群执行分布式训练,但扩展性、稳定性和效率会受上述互联限制影响,应根据任务规模谨慎评估。需要指出的是,RTX 6000 Blackwell本身就是工作站级别的显卡,并不是为数据中心场景准备的所以上述问题也是正常的。

MIG、多实例划分能力

NVIDIA Ampere/Hopper 数据中心 GPU 提供了 MIG(多实例 GPU)功能,可将一块物理 GPU 划分为多个独立的小 GPU 实例。例如 A100/H100 可切分出 7 个 GPU 实例(每个有独立的显存和计算资源)供不同任务或用户隔离使用[25]。MIG 非常适合在推理场景下一卡多用,提高利用率并提供服务质量隔离。RTX 6000 Blackwell同样支持MIG,但是最多只支持X4,即每个分片最小要24G显存。

FP4/FP6 超低精度特性在 LLM 中的潜力

Blackwell 架构引入了全新的FP4和FP6超低精度数据类型支持[27]。第五代 Tensor Core 在继承 FP8 Transformer Engine 的基础上,增加了对 4-bit 和 6-bit 浮点格式的矩阵运算支持,并宣称在稀疏加速下相比上一代性能提升可达 3 倍[28]。对于大语言模型,这意味着可以探索更加激进的权重压缩和量化方案:例如将模型权重从 8-bit 进一步压缩为 4-bit,从而将模型内存占用和带宽需求再降低一半,并利用硬件实现的 FP4 算术获得巨大吞吐提升[8]。理论上,1750 TFLOPS 级别的 FP4 算力足以支撑实时推理千亿参数模型(若其权重能用 4-bit 表示而精度损失可接受)。举例来说,GPT-3 175B 模型如果用 FP4 量化,其参数占用约 87.5 GB,可被 96GB 显存容纳在单卡中;结合 RTX 6000 强大的 FP4 算力,有望在单卡上执行此类超大模型的推理。这对于研究者进行大模型推理测试具有吸引力。

然而,FP4/FP6 在实际 LLM 训练与推理中的应用仍有明显局限。首先,4-bit/6-bit 的数值动态范围和精度非常有限,直接将大型Transformer模型权重量化到 4-bit 可能导致严重的精度下降。业界通常需要借助量化感知训练、误差补偿(如 GPTQ 等方法)才能在 8-bit 环境下勉强保持模型质量[29]。4-bit 量化是更激进的一步,目前主要在研究阶段,难以在不牺牲过多准确率的情况下用于高精度要求的模型推理,更遑论训练过程(训练对数值精度更敏感)。FP6 作为折中精度,可能在保持一定精度的同时减少内存,但相对 FP8 的优势有限,尚待观察其实际效果。其次,FP4/FP6 主要利于推理吞吐,对于模型训练,过低精度会影响收敛和稳定性,目前主流做法仍是使用 FP16/BF16 进行训练,辅以 FP8 做部分运算加速[23]。在未来,如果算法上找到更好的超低精度训练方法(例如通过调整优化器或新的量化方案),Blackwell 的 FP4/FP6 硬件支持才有可能在训练大模型时发挥作用。

总的来说,FP4/FP6 为大模型推理提供了新的压缩维度和性能可能。在一些对质量要求不高或者经过专门优化的小模型上,4-bit 量化推理可以极大提高吞吐性能并减少部署成本。但在大型通用语言模型上,FP4 量化目前更多还是一种实验性的选项,需要平衡模型准确率。对于注重生成质量的应用,可能仍会以 FP8/INT8 推理为主,FP4 作为一个探索性选项。随着研究社区在量化算法上的突破,Blackwell 硬件提供的这些新精度将为进一步优化 LLM 部署效率提供硬件基础,其潜力值得关注但短期内的实际价值有待验证。

综合对比与应用建议

综上所述,从硬件算力上看,RTX PRO 6000 Blackwell 在低精度AI计算方面远超前代 A100 80GB,并引入了更低精度(FP4/FP6)支持,为大模型推理提供了前所未有的单卡性能和内存容量。然而,从架构定位上讲,它仍是一款工作站 GPU,不具备数据中心 GPU 的多卡互联和大规模集群优化能力。相比之下,A100 80GB 和 H20 96GB (H100 变种)在多 GPU 扩展、NVLink 高速通信等方面明显占优,更适合大规模分布式训练和部署。尤其是 H20 96GB,在降低计算单元后仍保留了超大的 HBM3 显存和 NVLink 互联,在中国市场上被证明在大型模型推理效率上甚至优于满配的 H100(因模型完全放入显存减少了通信开销)[15][30]。因此,对于大模型训练,需要多卡协同、高带宽通信的场合,仍然建议优先采用 A100/H100 系列或其变体(如 H20),以发挥其NVLink互联和集群方案优势。RTX 6000 Blackwell 更适合作为开发者工作站中的单卡高速计算加速器:用于模型原型开发、小批量训练实验以及大模型的推理服务等。在无法获得数据中心 GPU 的情况下,RTX 6000 也可组成小规模集群进行训练,但应考虑到其可扩展性瓶颈,在软件上尽量采用梯度累加、模型拆分减少通信等策略来缓解。

在推理部署方面,如果是大模型的线上服务,需求往往是批量推理吞吐和足够大的显存,RTX 6000 Blackwell 的单卡性能和 96GB 显存非常契合此类需求,可以用于部署 70B 级别模型的加速推理。但若需要大规模并发实例部署,缺少机间高速通讯的 RTX 6000 在灵活性上不如 A100/H100 。综合考虑,RTX PRO 6000 Blackwell 更加适合需要极高单卡算力和大显存的场景(如本地原型研发、模型调优和推理),而在追求多卡扩展和集群训练的场合,传统的数据中心 GPU 方案依旧是更稳妥的选择。各单位应根据自身应用规模和性能要求,选择合适的 GPU:单机需求可考虑 RTX 6000 Blackwell 提升开发效率,大规模训练任务则应部署 HGX/DGX 架构以获得最佳的整体性能表现。[18][15]

[2] [6] [8] [10] [13] [17] nvidia.com

[3] [7] [9] [11] [12] [16] NVIDIA A100 | Tensor Core GPU

[4] [5] [26] NVIDIA's China-Compliant H20 GPU Has 41% Fewer Cores & 28% Lower Performance Versus Top Hopper H100 Config

[15] [19] [30] NVIDIA H20's Impact on China and Market Demand Analysis - INFINITIX | AI-Stack

NVIDIA H20's Impact on China and Market Demand Analysis - INFINITIX | AI-Stack

[18] Is RTX 6000 ADA still good for AI Training and Inference in 2024? — Blog — DataCrunch

https://datacrunch.io/blog/rtx-6000-ada-for-ai

[20] [27] [28] [29] NVIDIA RTX PRO™ 6000 Blackwell Workstation Edition | NVIDIA Professional Graphics - Leadtek

NVIDIA RTX PRO™ 6000 Blackwell Workstation Edition | NVIDIA Professional Graphics - Leadtek

[21] Review: Nvidia RTX 6000 Ada Generation - DEVELOP3D

Review: Nvidia RTX 6000 Ada Generation - DEVELOP3D

[22] [23] [24] [25] NVIDIA H100 Tensor Core GPU Datasheet

https://www.megware.com/fileadmin/user_upload/LandingPage%20NVIDIA/nvidia-h100-datasheet.pdf

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)