Stable diffusion生成装修效果图实操案例

目前市面上比较权威,并能用于工作中的AI绘画软件其实就两款。一个叫Midjourney(简称MJ),另一个叫Stable-Diffusion(简称SD)。MJ需要付费使用,而SD开源免费,但是上手难度和学习成本略大,并且非常吃电脑配置(显卡、内存)。E和Midjourney相比,Stable Diffusion 最大的优势是开源,这意味着Stable Diffusion的潜力巨大、发展飞快。

前言

目前市面上比较权威,并能用于工作中的AI绘画软件其实就两款。一个叫Midjourney(简称MJ),另一个叫Stable-Diffusion(简称SD)。MJ需要付费使用,而SD开源免费,但是上手难度和学习成本略大,并且非常吃电脑配置(显卡、内存)。

E和Midjourney相比,Stable Diffusion 最大的优势是开源,这意味着Stable Diffusion的潜力很大、发展飞快。由于开源免费属性,SD 已经收获了大量活跃用户,开发者社群已经为此提供了大量免费高质量的外接预训练模型(fine-tune)和插件,并且在持续维护更新。在第三方插件和模型的加持下,SD拥有比Midjourney更加丰富的个性化功能,在经过使用者调教后可以生成更贴近需求的图片,甚至在 AI 视频特效、AI音乐生成等领域,Stable Diffusion 也占据了一席之地。

Stable Diffusion本地部署

Stable Diffusion的配置要求并非很高,显存4G以上就可以,不过要求硬盘至少要有50G以上(建议100G),适用于Win10-11版本。

如果你的电脑满足以上要求,那么就可以进行Stable Diffusion的本地部署了。

(1)下载整合包。将文件解压在全英文的安装路径中,减少后期报错的可能。

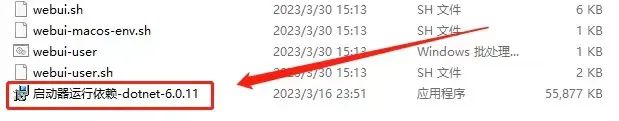

(2)点击"启动器运行依赖"完成启动环境搭建。

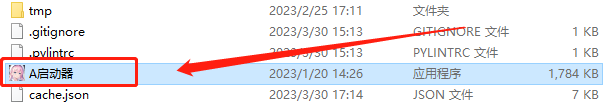

(3)点击启动器应用程序,一键启动Stable Diffusion。

(4)待启动器页面弹出后,点击“一键启动”。

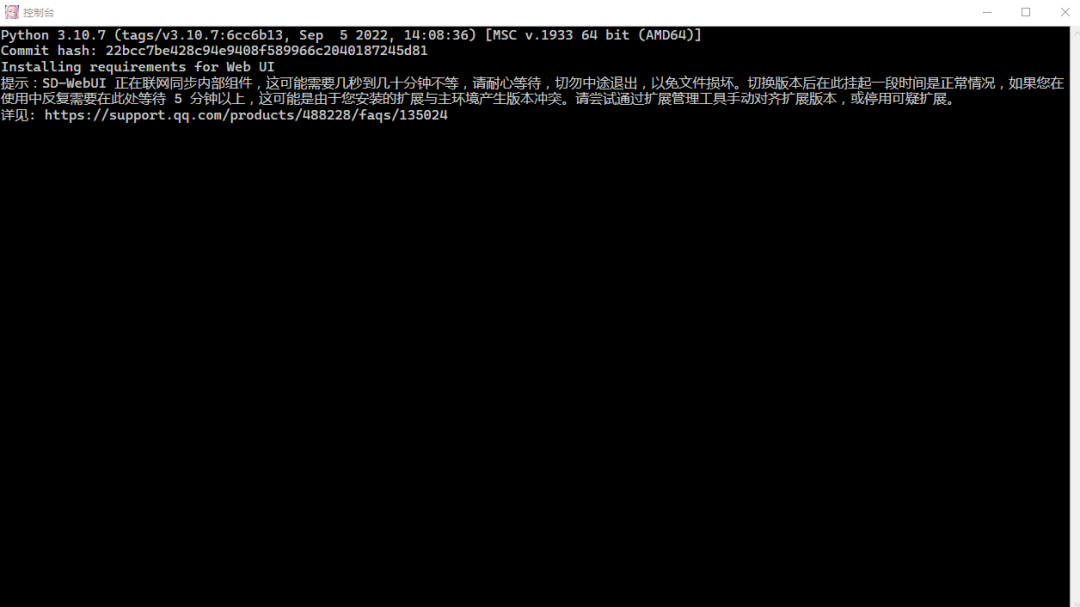

(5)首次启动Stable Diffusion可能需要较长的时间,请耐心等待:

(6)当Stable Diffusion界面自动弹出时,就代表着你已经完成其本地部署。

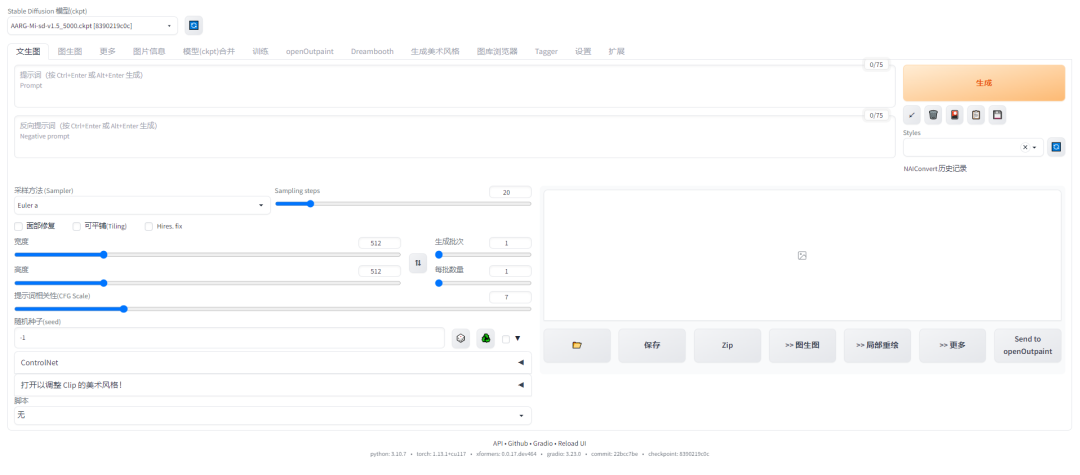

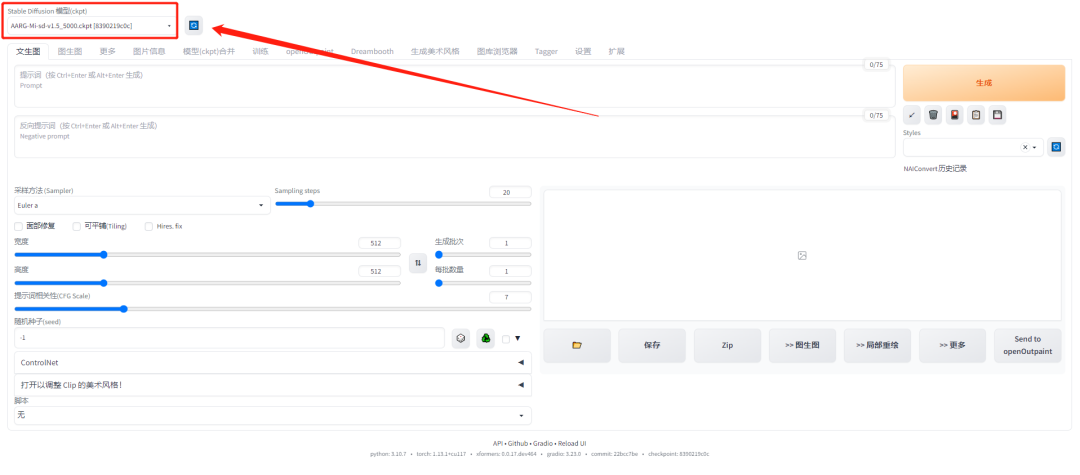

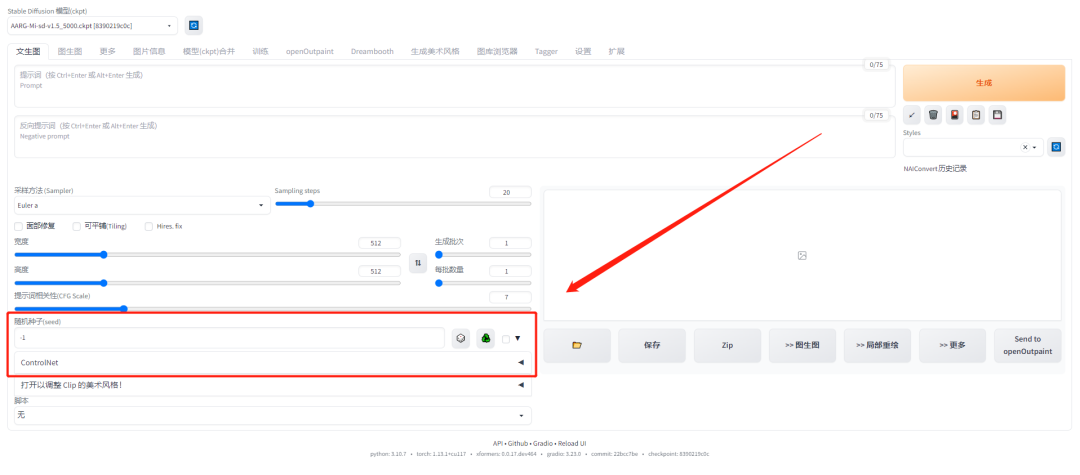

2、熟悉Stable Diffusion界面

(1)在界面的左上角,你可以选择进行创作的基础模型。

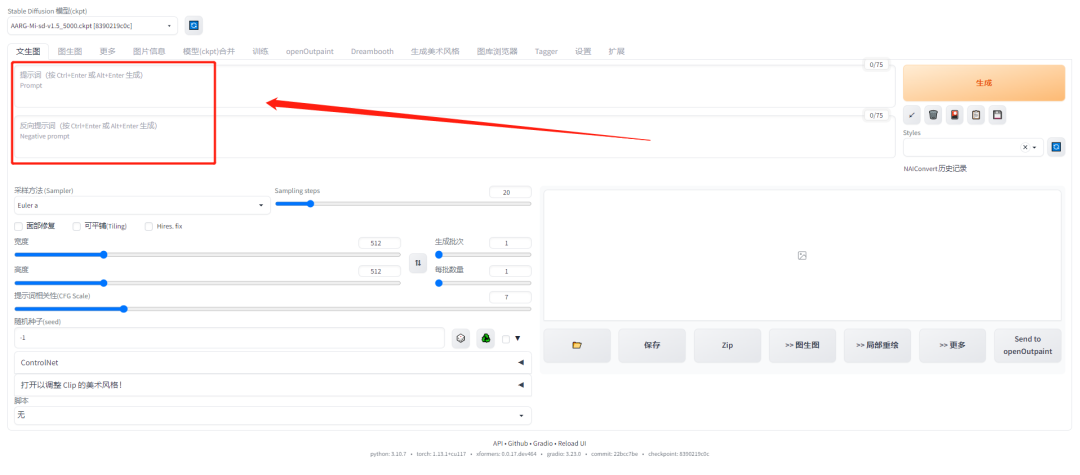

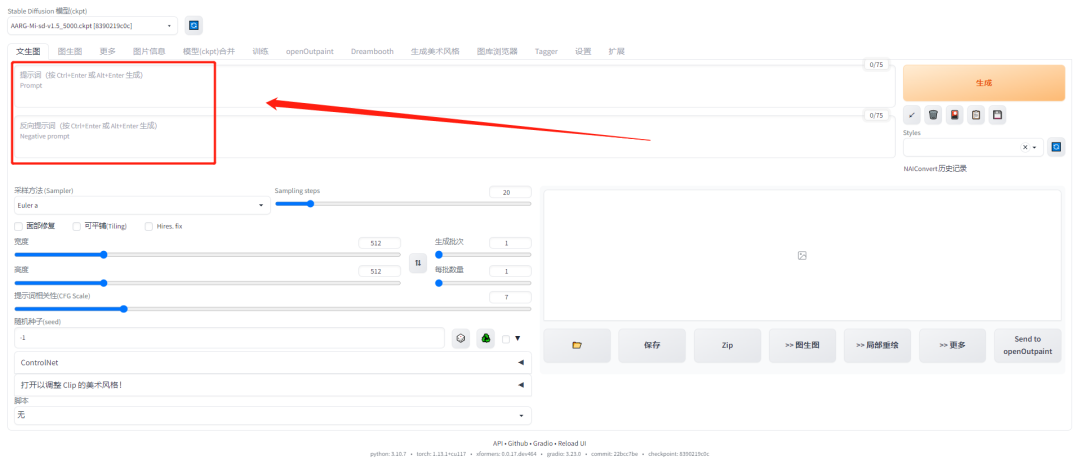

(2)在模型选择的下方,是输入提示词的文本栏。

与Midjourney不同的是,Stable Diffusion还拥有一行反提示词文本栏,你可以将不希望呈现在画面中的元素输入进去以贴合创作需求。

(3)提示词文本栏的下方,是采样方法与迭代步数。

简单的来讲,迭代步数影响的是创作画面的细节丰富程度。迭代步数越多,产生的细节就越多。

不是迭代步数越多越好,这需要结合创作项目来进行实际调试。

(4)下方是图片宽度、高度、生成批次、每批数量。

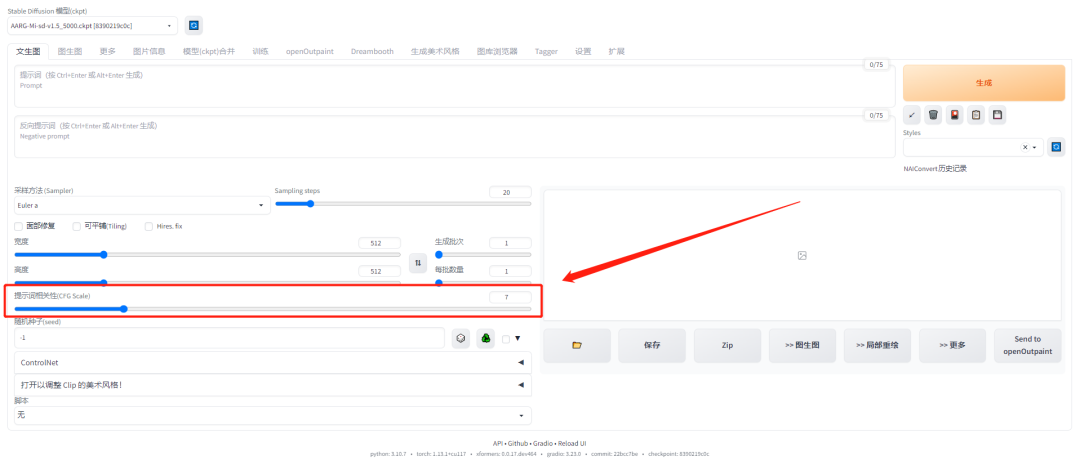

值得注意的是在它们下方的提示词相关性。它控制着产出图片受输入提示词的影响程度。一般取值范围在7-15。

(5)提示词相关性的下方,是十分重要的随机种子参数以及ControlNet插件。

可以说,正是因为有了ControlNet插件,才使得Stable Diffusion区别于Midjourney等“抽盲盒”式AI生成工具,更能应用于建筑、室内设计方向的实际项目之中。

3、Control Net 插件入门

Stable Diffusion安装Control Net插件的方法:

A. 点击页面中的“扩展”。

B. 点击扩展界面中的“可用”。

C. 点击可用界面中的"加载自"。

D. 按住键盘 contorl 键后,按 F键调出检索文本框。

E. 在检索文本框内输入 con-trolnet。

F. 找到“扩散控制网络 (con-trolnet)”,并点击后方的安装。

G. 点击“应用并重启用户界面”等待安装完成。

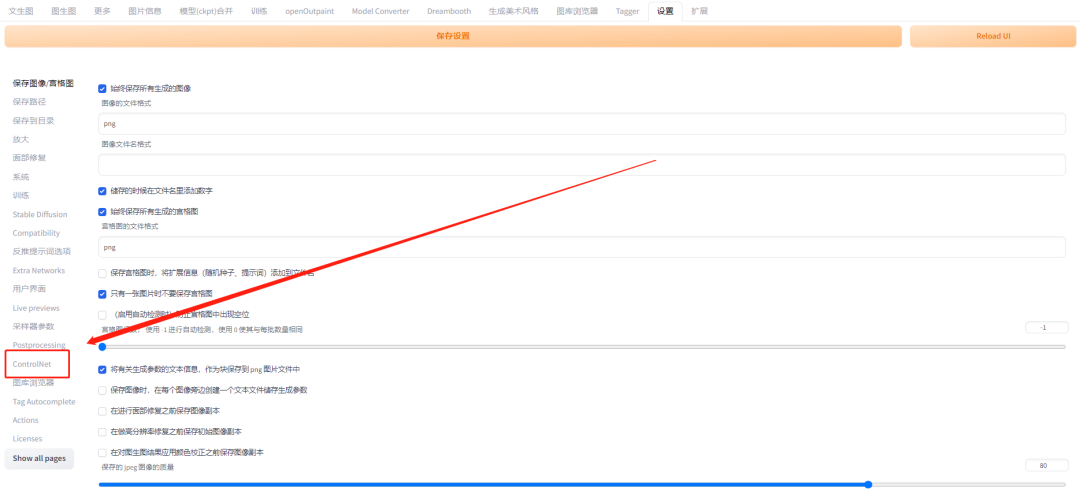

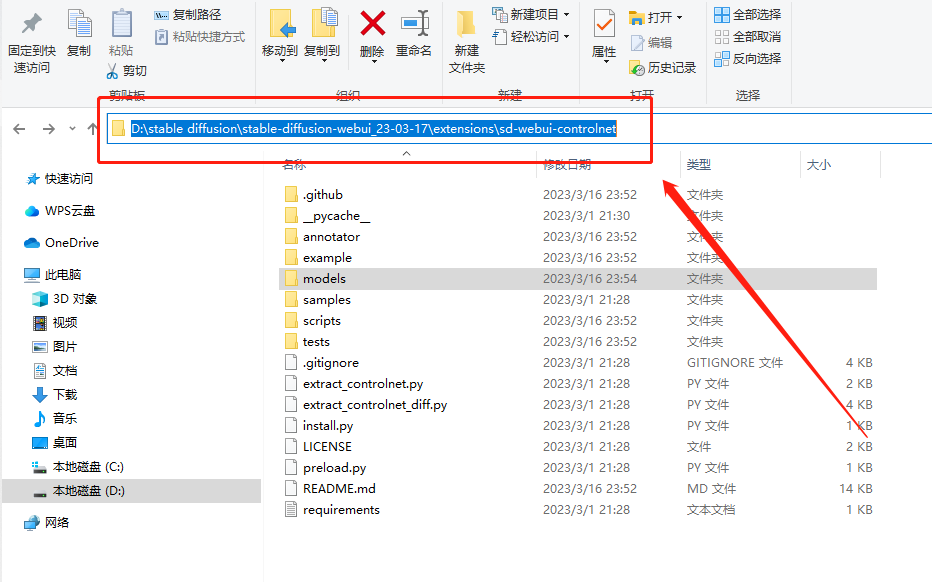

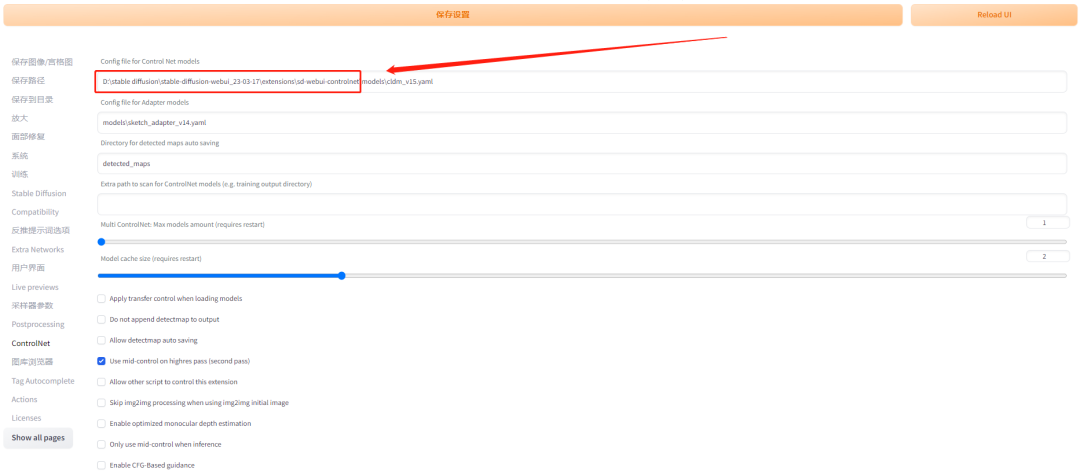

在确保已经安装 Control Net 插件之后,需要将 Control Net 的根路径进行更改,具体流程如下:

A. 点击“设置”找到 Control Net 选项。

B. 复制 Control Net 的根路径。

C. 将 Control Net 根路径粘贴更改到保存路径中。

需要注意的是,该操作需在"科学上网"前提下进行。

4、实操案例分享

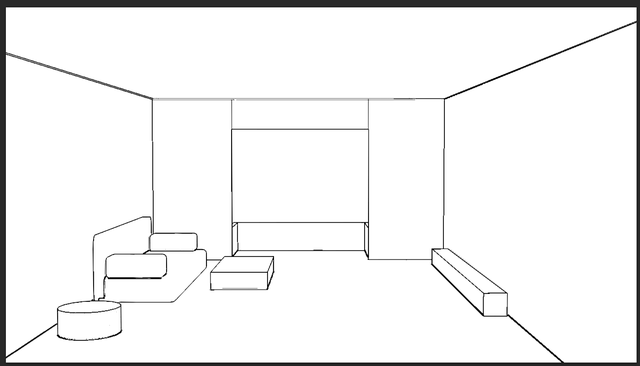

(1)获得室内线稿图

首先,打开3ds max ,简单用box堆一个室内场景出来,你用其他三维软件也可以,然后将这个场景渲染出一个线稿图出来。

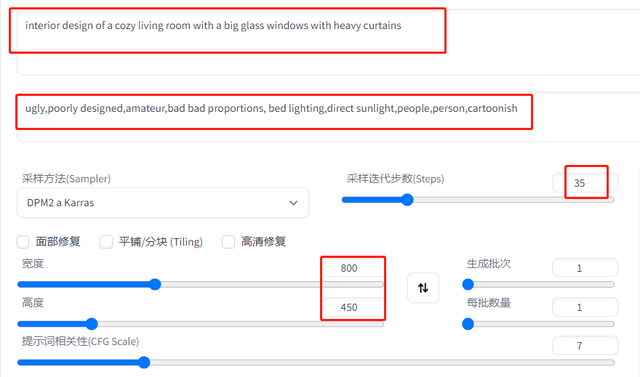

(2)设置提示词

选择文生图,正向关键词和负向关键词见下方,初始迭代步数可以调低一些,宽高比注意和线稿图一致。

正向关键词:

The interior design of a beautiful living room with a big glass windows with heavy curtains,bay window,tv wall

反向关键词:

ugly,poorly designed,amateur,bad bad proportions, bed lighting,direct sunlight,people,person,cartoonish

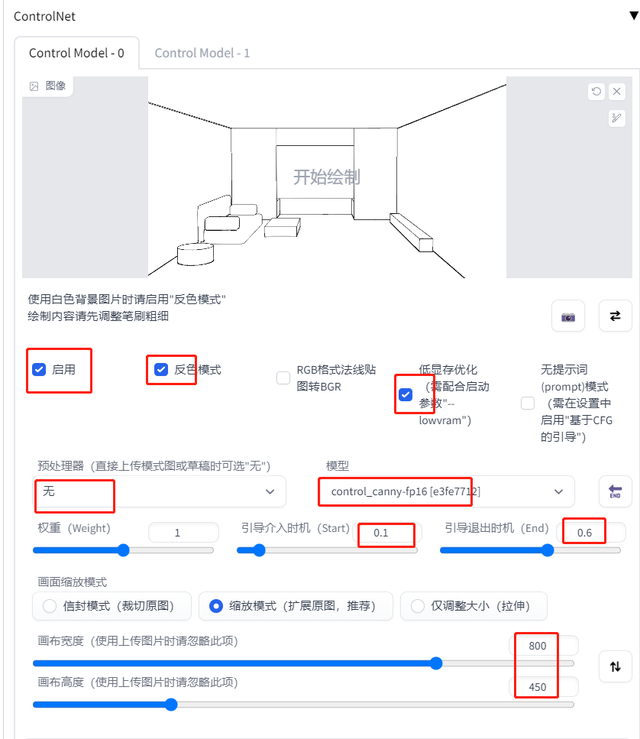

(3)设置 Control Net

打开 Control Net,将之前渲染得到的线稿拖到 ControlNet 的参考图中,勾选启用,因为是白色背景图片,所以要勾选反色模式。

如果显卡显存低,要勾选低显存优化。因为参考图本身就是线稿,所以预处理器不需要选择,在模型里选择 canny。

引导介入时机 设置为0.1左右,引导退出时机设置为0.6左右。

最后不要忘记尺寸,要设置为和原图比例一致。

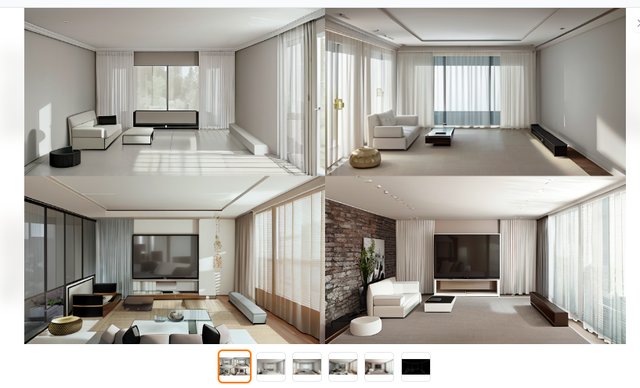

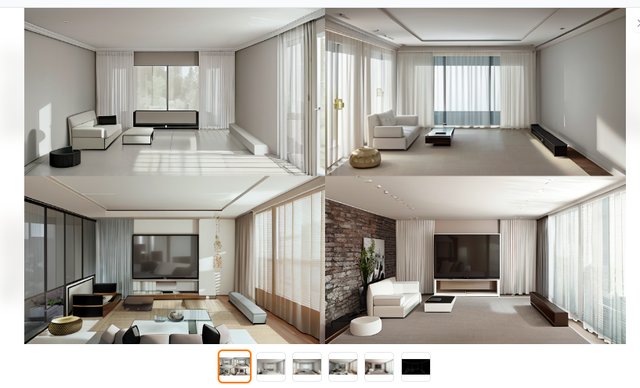

出图结果如下。如果这张不满意,可以多出几张,直到有自己喜欢的为止。

需要注意的是:打开 Control Net 后,出图速度会变得非常慢,所以,开始时建议大家把迭代步数和尺寸设置小一些,生成图片批次多设几张,待

找到自己满意的图片后,保留种子数,然后再出大图。

选择比较满意的图片后,保留种子数,然后再生成大图。

怎么保留种子数?点击想保留种子数的图片,在左侧有个绿色的按钮,点一下会出来一段数字,这个就是种子数。

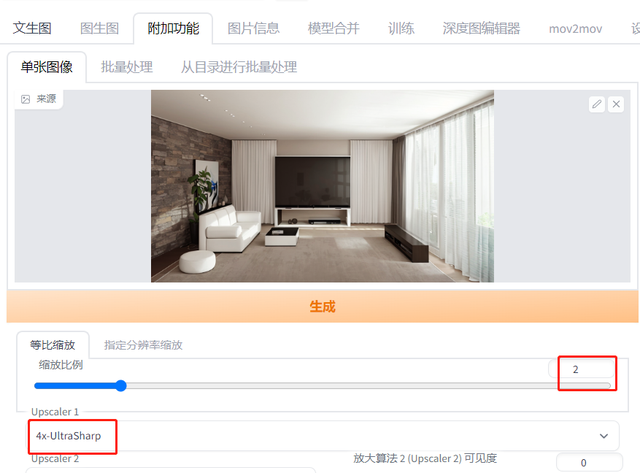

(4)得到4K大图

下面对图片进行放大处理。点击图片下方的图生图,来到图生图界面,你会发现之前在文生图我们用的提示词还有种子数全复制过来了。

接下来设置好采样器、提高迭代步数,按比例提高画面尺寸,最后注意重绘幅度不要太大,否则出图会发生比较大的变化。

最后再到附加功能里,将刚刚图生图得到的图片再进行放大2倍,得到4K高清大图。

总结

如果你花了一些时间,认真的阅读了上述内容,跟着操作了一遍。那么相信你已经成功入门了Stable Diffusion这个AI出图利器。

分享了「StableDiffusion零基础入门课」

链接:https://pan.quark.cn/s/0e16a5e0232c

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)