云舟观测:大模型语言LLM 应用观测功能全解

随着大语言模型(LLM)技术的飞速发展,对话机器人、RAG 系统、智能 Agent 等基于 LLM 的应用已成为企业数字化转型的核心驱动力。然而,这些应用在实际落地过程中,常面临链路复杂难追踪、性能波动难预判、成本消耗难控制、效果稳定性不足等多重挑战。为解决这些痛点,云舟观测产品推出 “LLM 应用观测” 功能,以全链路追踪为核心,为开发者和运维人员提供覆盖 LLM 应用全生命周期的观测能力,助力

随着大语言模型(LLM)技术的飞速发展,对话机器人、RAG 系统、智能 Agent 等基于 LLM 的应用已成为企业数字化转型的核心驱动力。然而,这些应用在实际落地过程中,常面临链路复杂难追踪、性能波动难预判、成本消耗难控制、效果稳定性不足等多重挑战。为解决这些痛点,云舟观测产品推出 “LLM 应用观测” 功能,以全链路追踪为核心,为开发者和运维人员提供覆盖 LLM 应用全生命周期的观测能力,助力大模型应用稳定、高效、可信地落地。

核心定位

聚焦 LLM 应用的专属观测需求。LLM 应用与传统软件应用在架构逻辑、技术依赖和核心指标上存在显著差异,因此需要专属的观测解决方案。云舟观测的 LLM 应用观测功能重点解决三大核心问题:

-

复杂链路可视化:完整采集对话应用、RAG 应用、Agent 应用的调用链路,清晰呈现从用户交互到模型推理的全流程,帮助开发者直观理解应用内部逻辑;

-

性能与成本监控:实时监控 Token 消耗、响应延迟等关键指标,精准把控资源投入与应用效果的平衡,避免成本失控或性能瓶颈;

-

一站式全景观测:支持将 LLM 应用链路与日志、指标进行全方位关联,无需切换工具即可完成 LLM 应用的全景观测,提升问题排查效率;

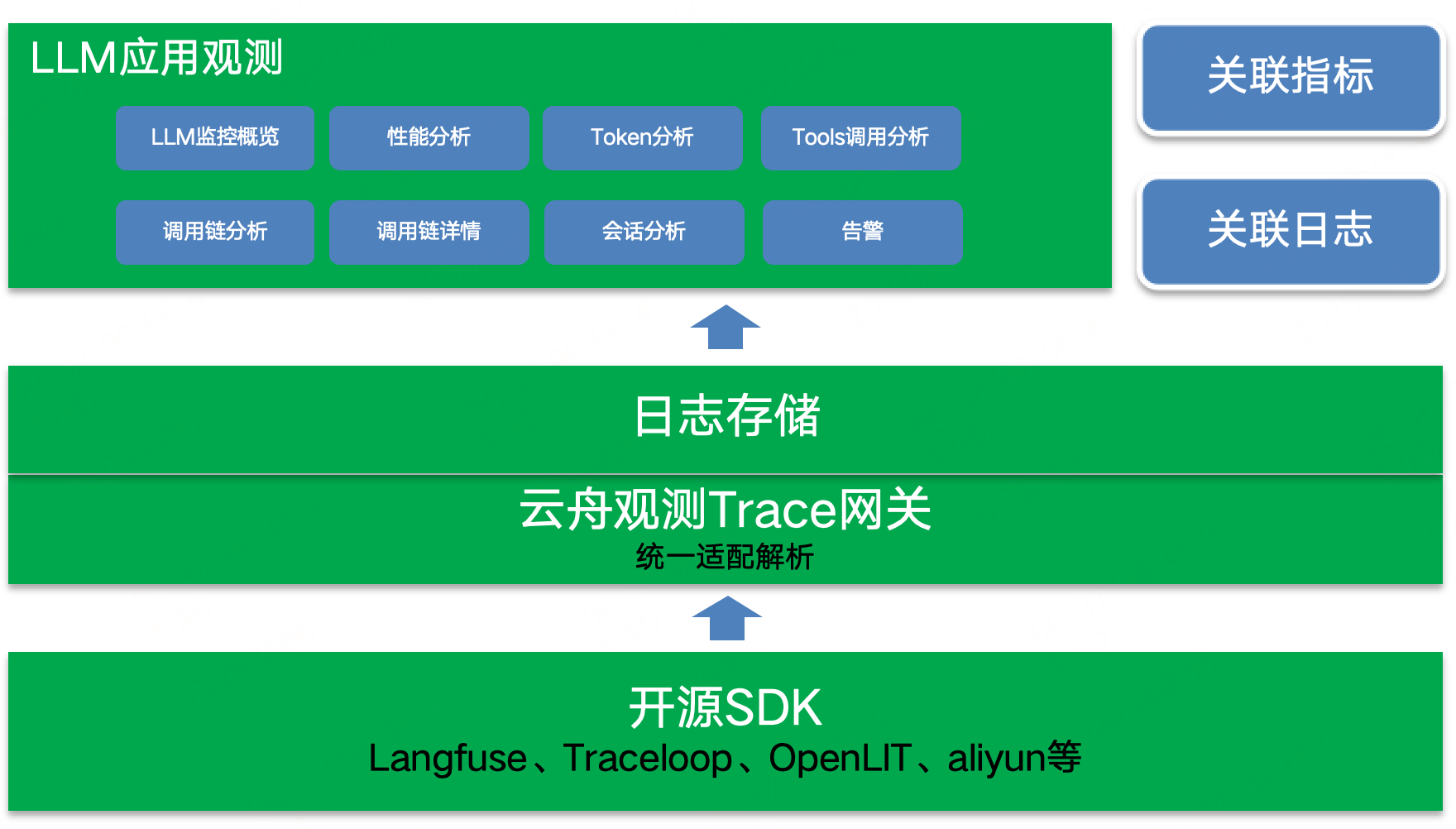

整体架构

LLM 应用观测功能采用了分层架构设计,从数据的采集层、存储层,到统计分析层和展示层,各个层级紧密协作,形成一个完整的LLM应用观测体系。

-

采集层:支持 Langfuse、Traceloop、OpenLIT、aliyun 等主流开源 SDK,并兼容 Opentelemetry 标准,确保各类 LLM 应用数据均可被有效采集;

-

存储层:对采集的 LLM 应用链路数据进行统一适配解析,通过高效日志存储实现结构化存储,为后续分析提供可靠数据基础;

-

统计分析层:对存储的链路数据、指标数据进行多维度分析,生成性能、成本、调用分布等关键洞察;

-

展示层:提供各类统计大盘,实时监控 LLM 性能及成本消耗;同时展示完整的链路调用及详情分析视图,让调用链路更加直观;

整体架构通过 “云舟观测 Trace 网关” 实现数据流转,关联 LLM 监控概览、性能分析、Token 分析等模块,并支持 “调用分析 - 会话分析 - 告警 - 关联日志” 的全链路能力。

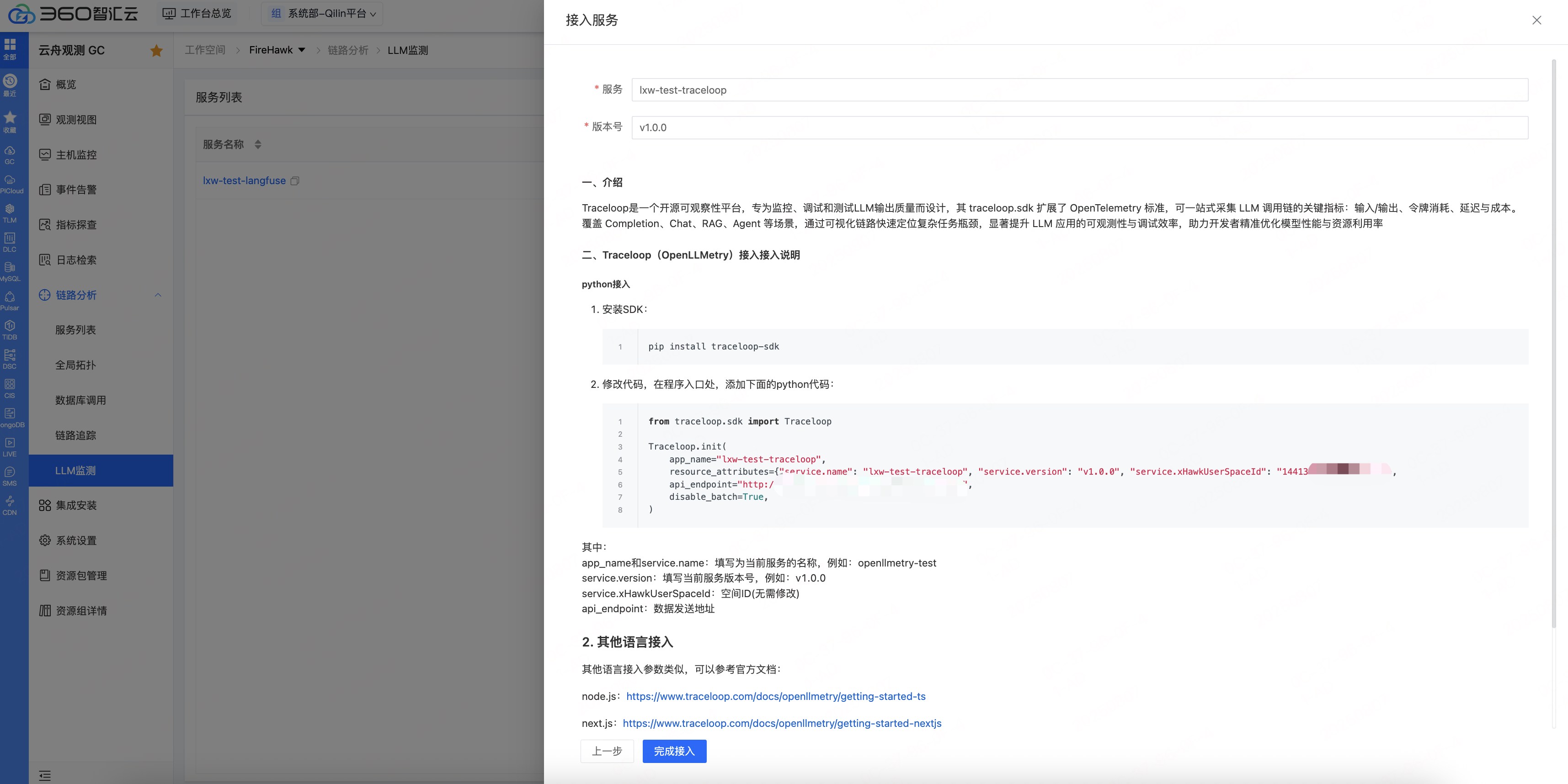

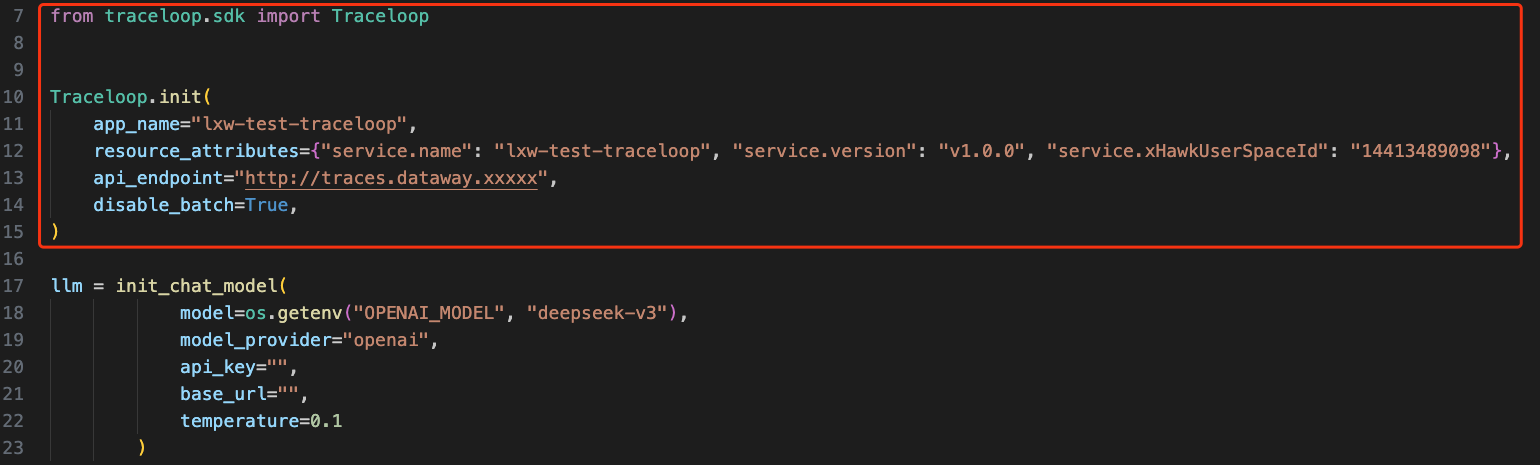

应用接入

为降低开发者接入成本,LLM 应用观测功能在兼容性和便捷性上做了多重优化:

-

广泛兼容性:支持 LangChain、LlamaIndex 等主流框架,适配 OpenAI、DeepSeek 等国内外通用大模型,无需大规模改造现有应用即可接入;

-

多语言支持:覆盖 Python、JS/TS 等主流 LLM 应用开发语言,满足不同技术栈团队的需求;

-

便捷集成:对于通用观测场景,仅需在应用程序开头引入并初始化采集 SDK,即可自动完成数据收集与上报;

-

持续扩展:兼容 Opentelemetry 标准,未来将逐步增加对更多语言及开源框架的支持,保障长期可用性;

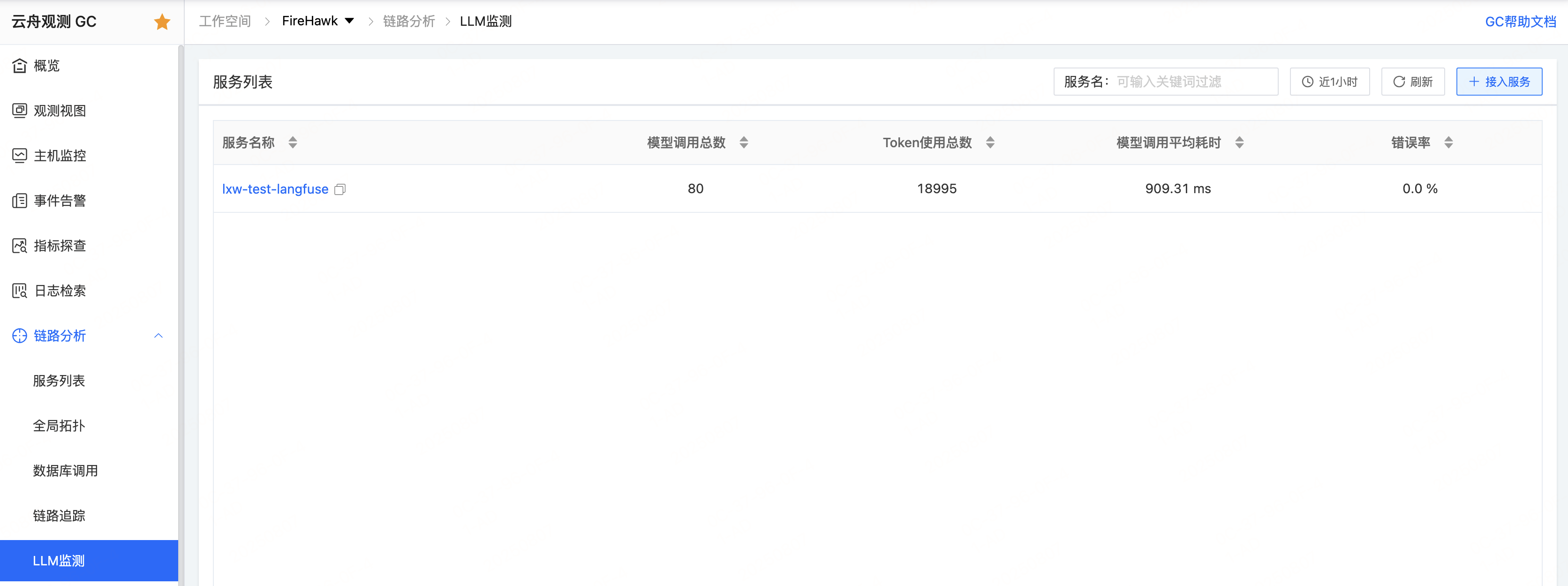

指标大盘

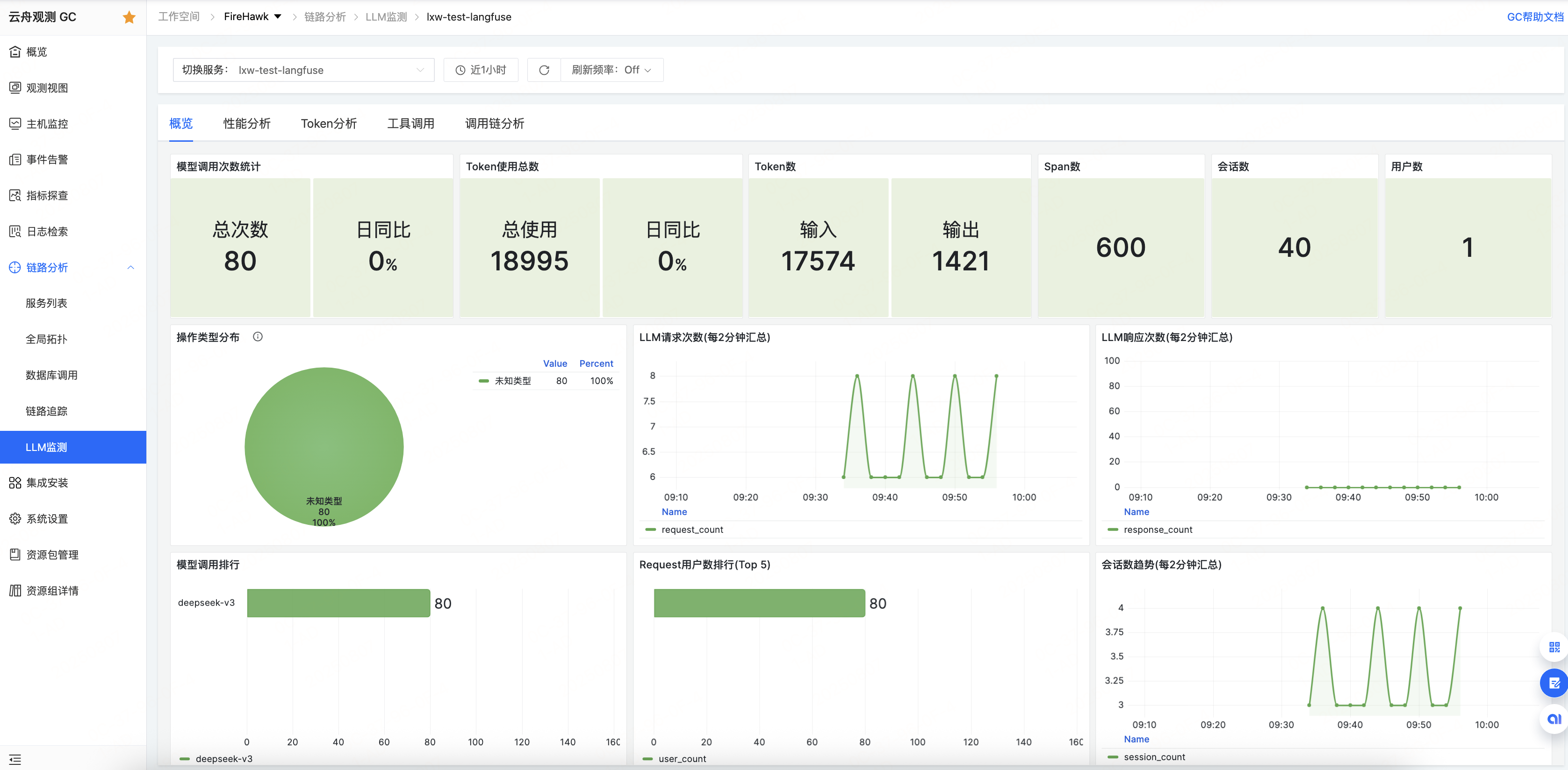

LLM 应用观测功能提供调用概览、性能分析、Token 分析等多类指标大盘,实时监控LLM调用性能和成本消耗情况,助力开发者精准优化;数据上报后,可以在LLM监测列表中看到服务,点击服务名称,即可进入该服务的观测详情;

-

概览大盘:动态展示核心指标趋势,包括 LLM 调用量、Token 消耗总量 / 分布、平均响应延迟、各操作类型占比等,支持日同比、环比分析,直观把握应用整体表现。通过指标大盘,开发者可以清晰看到每天、每周 LLM 调用量的变化趋势,对比不同时间段的 Token 消耗情况,分析是哪些操作类型导致了响应延迟的增加,从而及时调整优化策略。

主要指标说明:

模型调用次数:LLM应用在指定时间范围内对大模型的调用次数;

Token使用总数:LLM应用在指定时间范围内的Token消耗总数;

Token数:LLM应用在指定时间范围内的Input/Output Token消耗数;

Span数:LLM应用在指定时间范围内产生的Span总数;

会话数:LLM应用在指定时间范围内产生的Session总数(需要自定义Session ID);

操作类型分布:包括CHAIN、LLM、TOOL、AGENT、TASK等;

模型调用排行:LLM应用调用次数最多的大语言模型排行;

-

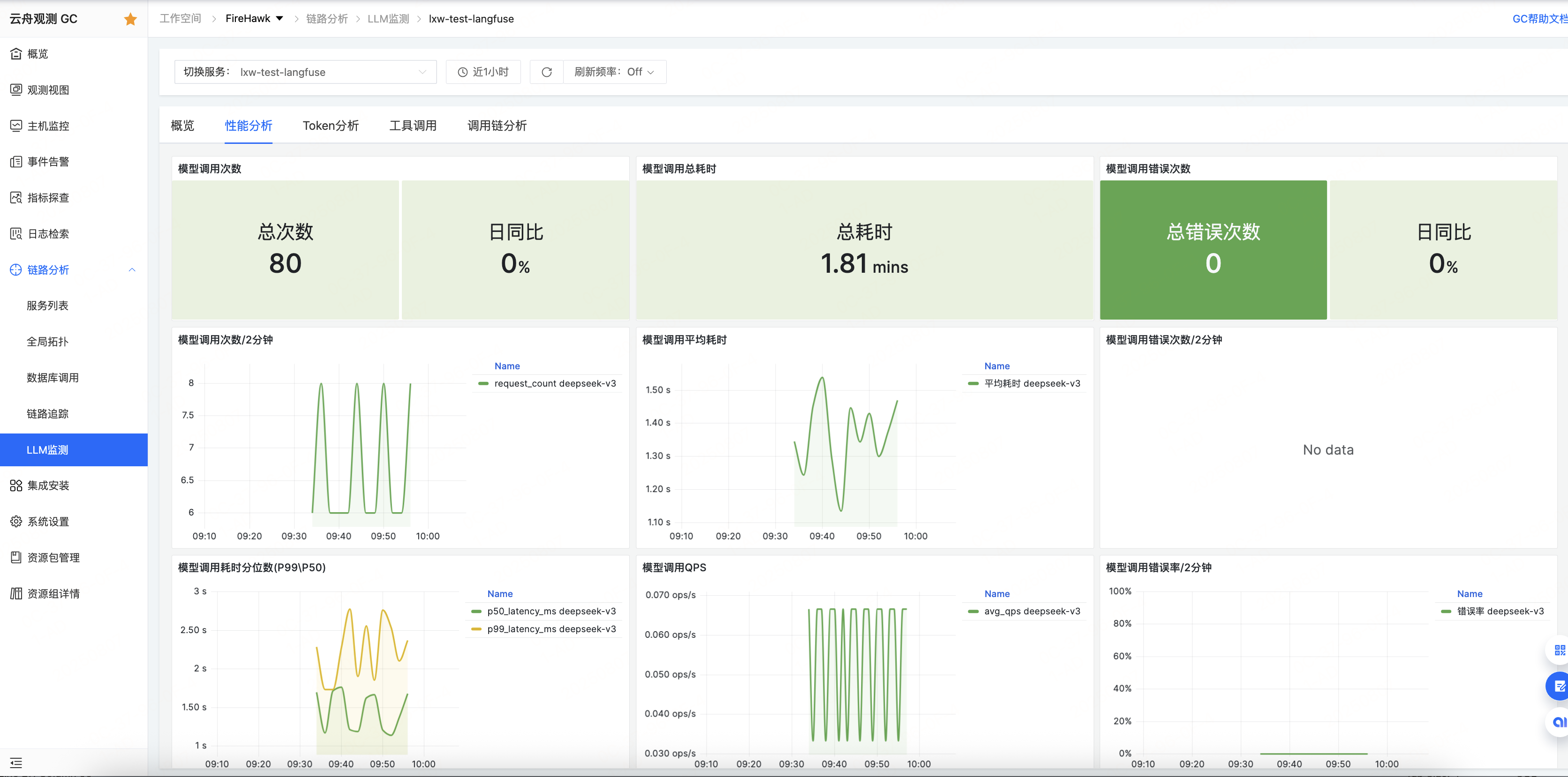

性能分析大盘:聚焦 LLM 调用的性能表现,展示模型调用次数、平均耗时、调用错误次数等关键指标。通过监控这些指标,开发者可快速发现性能瓶颈(如某模型平均耗时过高)或稳定性问题(如错误次数突增),针对性优化调用逻辑。

主要指标说明:

模型调用次数:指定时间范围内对大模型的调用次数;

模型调用平均耗时:指定时间段内调用大语言模型的平均耗时;

模型调用错误次数:指定时间段内调用大语言模型失败的次数;

-

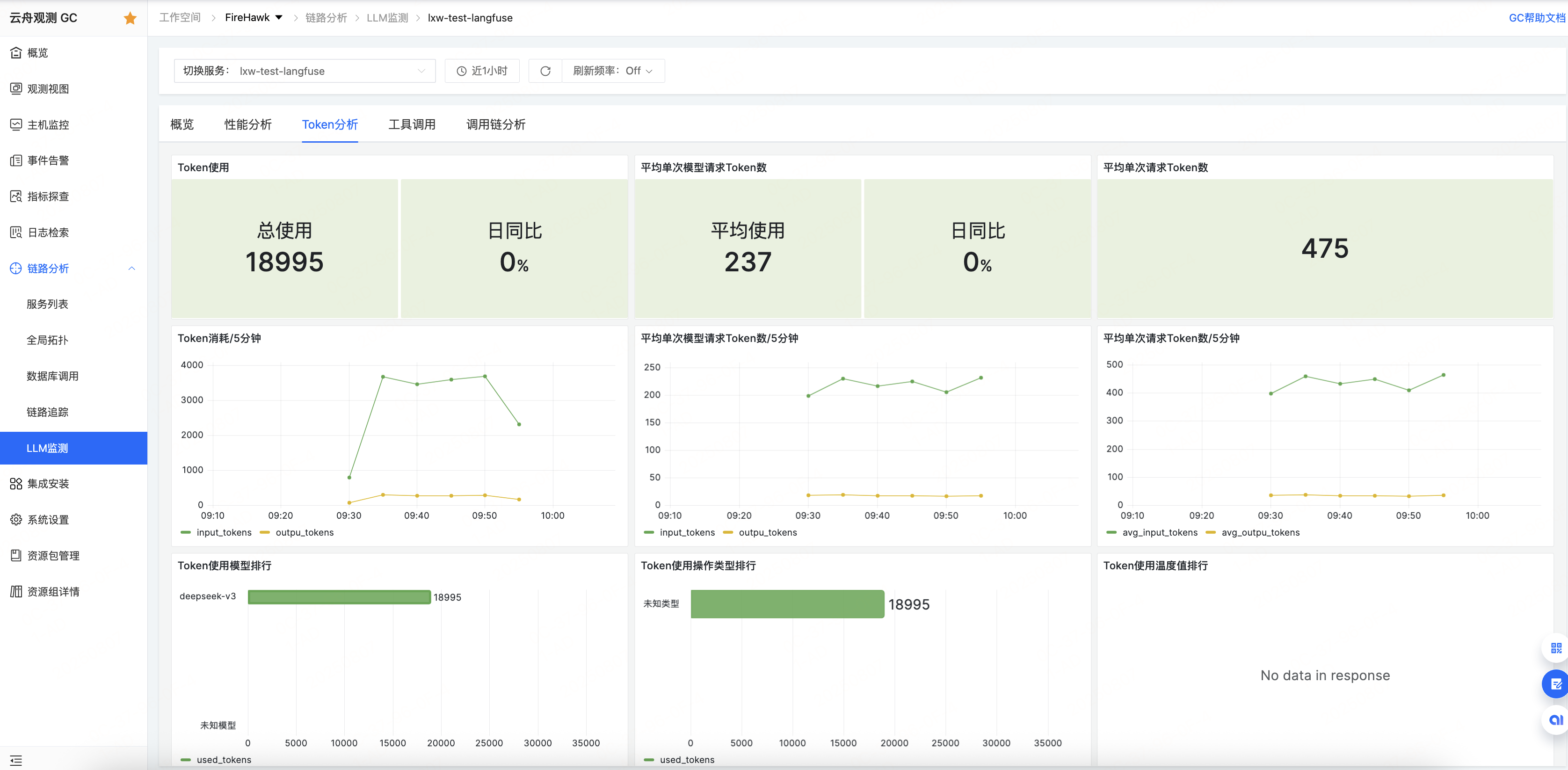

Token分析大盘:在大模型应用中,Token 是文本处理的基本单位,用于表示模型输入和输出的最小语义单元。可以在Token分析大盘了解LLM应用中的Token使用情况,识别高消耗场景,提供优化建议(如模型切换、Prompt 精简)。如果发现某个特定模型的调用成本过高,Token分析模块可以进一步分析是因为调用次数频繁,还是 Token 消耗量大导致的。针对高消耗场景,给出如切换到性价比更高的模型、精简 Prompt 以减少 Token 使用量等优化建议,帮助开发者降低应用运行成本

主要指标说明:

Token使用:指定时间段内所有模型调用消耗的 Token 总量;

平均单次模型请求Token数:平均每次模型调用(LLM Call)消耗的 Token 数量;

平均单次请求Token数:平均每个用户请求(Request)消耗的 Token 数量;

Token使用模型排行:Token 使用最多的前5个模型;

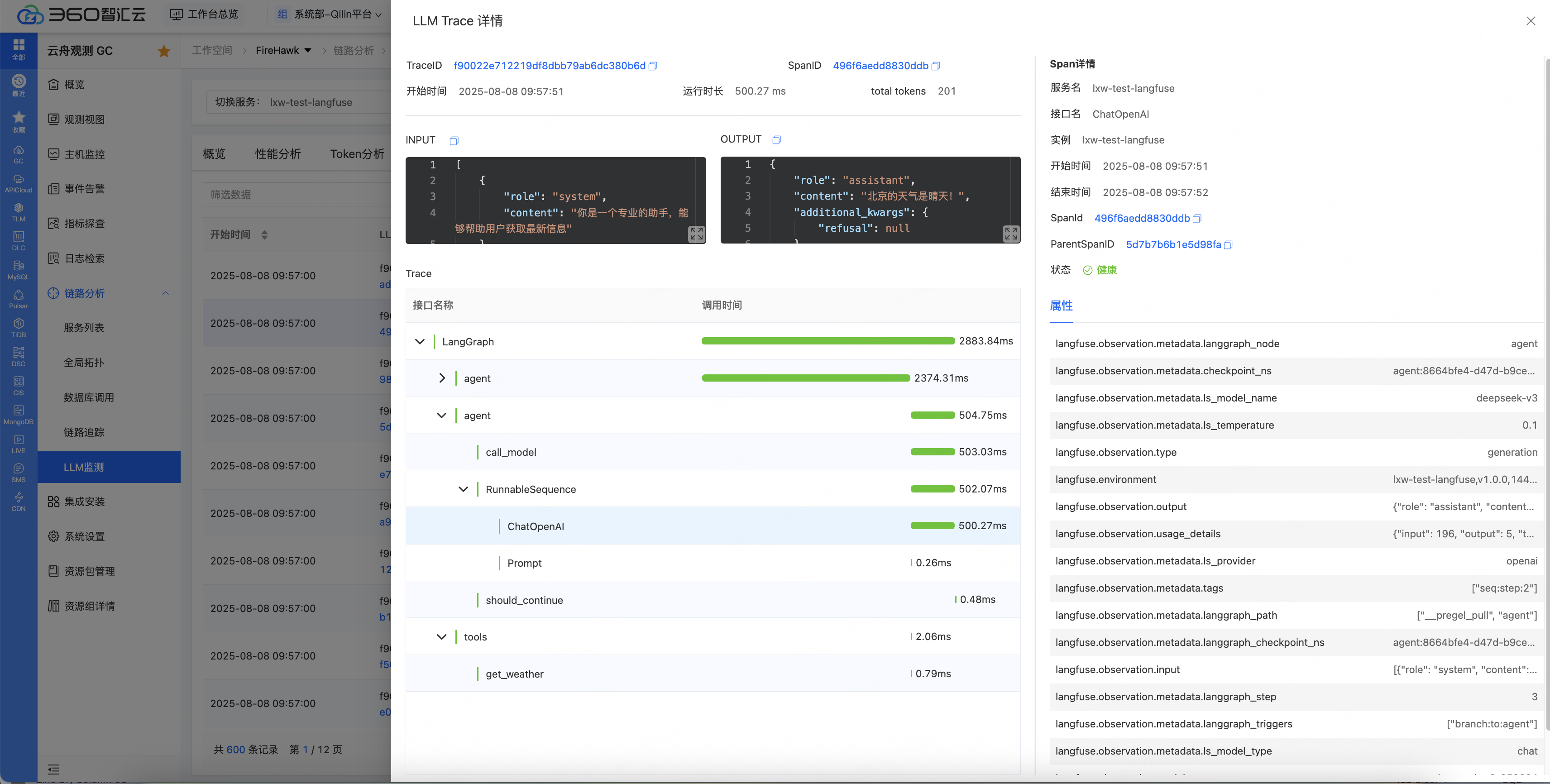

调用链路

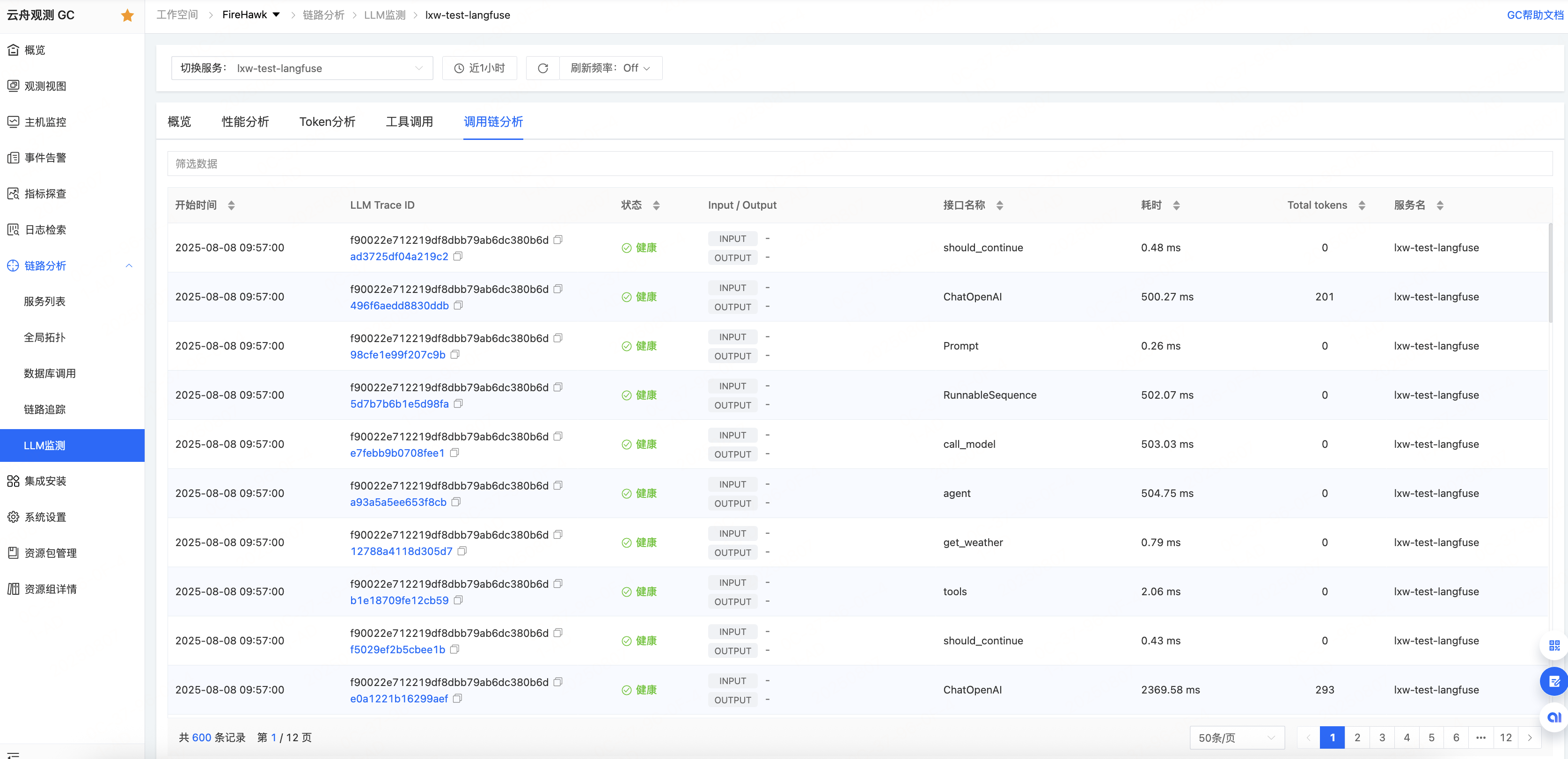

在 LLM 应用中集成 SDK 并正常上报数据后,调用链分析功能可展示每一步操作的详细信息,包括 Prompt 内容、Token 数、耗时等,支持一键定位异常节点。例如:

-

当应用出现异常时,可通过链路详情视图筛选 LLM 调用链路,查看具体 Prompt 内容,分析是否因 Prompt 设计不合理导致模型响应异常;

-

通过查看 Token 数和耗时信息,定位耗时较长的操作节点,针对性优化链路逻辑。

在调用链详情页面可以查看调用链的时间轴、开始时间、总耗时,以及Input/Output内容、Span名称、类型、应用名称、Token数、耗时等信息。

云舟观测在 LLM 应用观测功能方面的核心优势在于:

-

专属适配性强,深度聚焦 LLM 应用的独特架构与指标体系,区别于传统应用性能观测工具,能精准解决 LLM 应用特有的链路复杂、Token 成本难控等问题;

-

全链路覆盖完整,从数据采集到存储、分析、展示的分层架构设计,实现了对 LLM 应用全生命周期的无缝观测,无需依赖多工具拼接,并支持与平台自有的指标和日志观测能力结合,实现全栈观测;

-

集成与使用便捷,通过兼容主流开源 SDK、框架及多语言支持,大幅降低接入门槛,开发者无需复杂配置即可快速启用观测能力;

-

决策支撑精准,依托多维度指标大盘与精细化链路分析,不仅能实时监控运行状态,更能提供针对性优化建议,助力开发者在性能提升与成本控制间找到最佳平衡,最终推动 LLM 应用更稳定、高效地落地实践。

关于云舟观测

云舟观测是由360智汇云推出的一款一站式数据采集与监控观测产品,可以对基础设施、应用性能,以及云原生下业务指标和日志进行全面的监控和观测,构建全链路的可观测性服务,帮助用户及时发现和解决系统及应用性能问题,提高系统的稳定性和可靠性。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)