【大模型应用开发-实战】(十九)Dify使用-接入ollama部署的本地大模型(三)

本文介绍了在本地部署大模型的完整流程。首先需要做好基础环境准备,然后通过ollama工具在本地部署大模型,最后通过dify平台接入ollama部署的模型。整个过程包括环境配置、模型部署和平台接入三个关键步骤,为开发者提供了一种便捷的本地大模型部署方案。该方案既保持了模型的本地化运行,又能通过dify平台实现更便捷的调用和管理。

·

目录

一、准备工作

1、部署dify

参考

【大模型应用开发-实战】(十七)Dify使用-安装部署(一)-CSDN博客

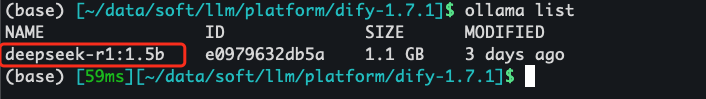

二、通过ollama部署本地大模型

参考

【大模型应用开发-实战】(一)使用Ollama在⾃⼰的电脑上运⾏⼤模型(上)_ollama npu-CSDN博客

【大模型应用开发-实战】(二)使用Ollama在⾃⼰的电脑上运⾏⼤模型(中)_ollama部署的大模型,如何url访问-CSDN博客

【大模型应用开发-实战】(三)使用Ollama在⾃⼰的电脑上运⾏⼤模型(下)_ollama longchain-CSDN博客

三、dify接入ollma部署的本地大模型

1、安装dify插件

进入 dify - 设置 -模型供应商,安装 “Ollama” 插件

2、设置模型参数

设置参数

模型类型:选择LLM

模型名称:选择Ollama安装的 deepseek-r1:1.5b

基础URL:host.docker.internal:11434

3、测试使用

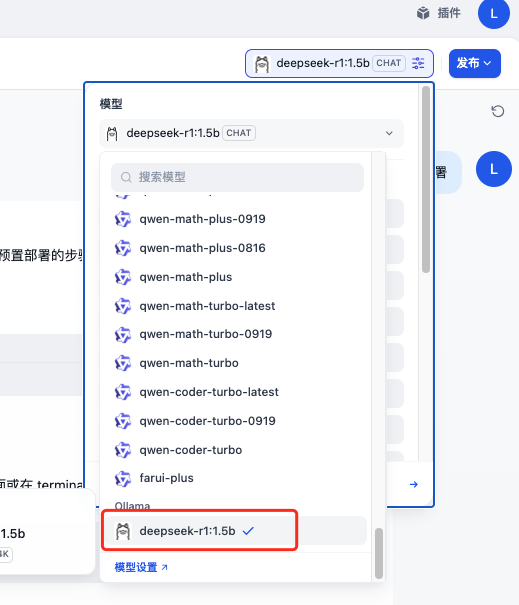

1)选择模型

新建LLM对话模型,模型选择“ollama -- deepseek-r1:1.5b”

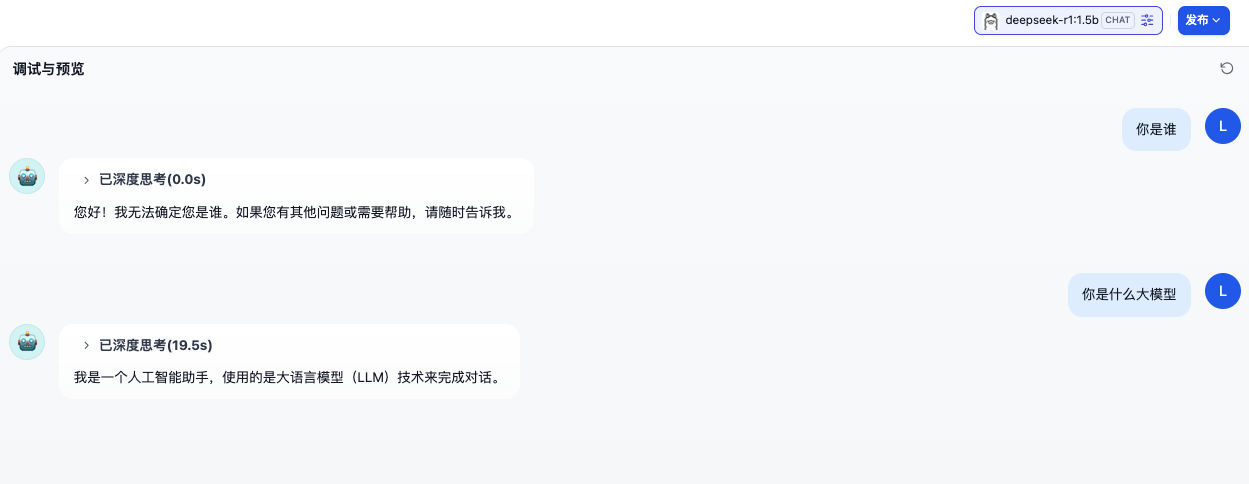

2)输入问题

进行测试,收到回复

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)