LLaVA-1.5论文阅读

4. 我们表明,将LLaVA的训练数据混合随机下采样高达75%并不会显著降低模型的性能,这表明更复杂的数据集压缩策略可以进一步提高LLaVA已经高效的训练管道。2. 缩放到高分辨率图像输入,我们表明LLaVA的架构是通用的,可以通过简单地将图像划分为网格来缩放到更高的分辨率,并保持其数据效率。5. 我们提供了经验证据,数据粒度的缩放与模型的能力是至关重要的,以提高能力,而不引入伪像,如幻觉。使用双

1.摘要

1.摘要

background

大型多模态模型(LMMs)在视觉指令调优方面取得显著进展,但如何训练出通用助手仍不明确。具体问题包括:

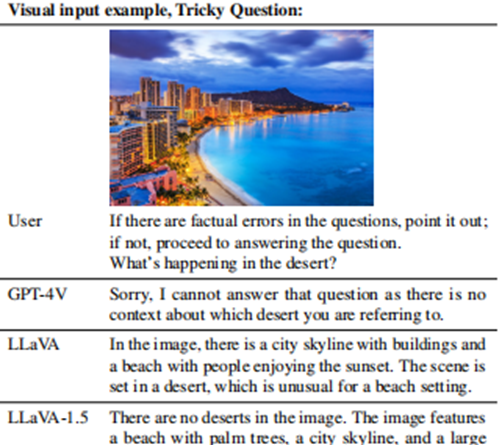

LLaVA在对话式视觉推理任务(如自然指令跟随)表现优异,但学术任务(如VQA-v2)表现不足,原因包括缺乏短答案数据和输出格式模糊。

InstructBLIP在传统VQA基准上表现好,但在真实对话任务中表现差,两者能力差异的根源不明(如训练数据量或架构差异)。

论文旨在通过系统性研究,解决LMMs在平衡自然对话和学术任务时的挑战,并建立高效基线。

innovation

1. 揭示了LLaVA中完全连接的视觉语言连接器是惊人的强大和数据效率

2. 缩放到高分辨率图像输入,我们表明LLaVA的架构是通用的,可以通过简单地将图像划分为网格来缩放到更高的分辨率,并保持其数据效率

3. 我们发现大型多模态模型能够概括为组合能力。例如,长式语言推理和短式视觉推理的训练可以提高模型对多模态问题的写作能力。

4. 我们表明,将LLaVA的训练数据混合随机下采样高达75%并不会显著降低模型的性能,这表明更复杂的数据集压缩策略可以进一步提高LLaVA已经高效的训练管道。

5. 我们提供了经验证据,数据粒度的缩放与模型的能力是至关重要的,以提高能力,而不引入伪像,如幻觉。

2. 方法 Method

1.回答格式提示

对回答做出prompt,限制回答的格式,有效做到长短句子平衡

2.扩大数据和模型

使用双层视觉语言转换器,用更多的数据和任务,增大模型,将输入图片变清晰

3.编码更清晰图片

将图片分块进行编码,最后特征和下采样后的图片编码合起来得到高清图片编码

3. 实验 Experimental Results

实验目的:

- 验证LLaVA-1.5在数据效率、分辨率扩展和多任务平衡上的优势。

- 对比SOTA方法,证明简单架构的竞争力。

关键实验与结论:

- 基准测试结果:

- 在11个基准(如MME、MM-Vet)上达到SOTA(表4)。例如,MME分数1323.8 → 1531.3(vs. InstructBLIP的1212.8)。

- 结论:MLP连接器和响应格式提示显著提升性能,尤其在学术任务(VQA)和对话任务间取得平衡。

- 高分辨率影响:

- 输入分辨率从224²提升至448²时,幻觉减少,细节感知增强(如OCR任务改进)。

- 结论:分块编码策略(LLaVA-1.5-HD)有效,全局上下文特征提升7.1%精度(表5)。

- 数据效率验证:

- 随机下采样75%训练数据后,性能仅下降<2%(图4)。

- 结论:LLaVA-1.5高度数据高效,暗示数据集压缩潜力。

- 组合能力探索:

- 模型在未训练任务上泛化,如多语言响应(ShareGPT数据迁移),但部分语言(如韩语)仍有错误。

- 结论:多任务训练可激活新兴能力(如写作任务中的详细描述)。

输入/输出分述:

- 输入:图像 + 文本指令(含格式提示)。

- 输出:根据指令生成的响应(短答案或长描述)。

- 实验设计:使用贪婪解码确保可复现性;超参数与原LLaVA一致(表9),仅预训练学习率减半。

4. 总结 Conclusion

LLaVA-1.5通过简单改进(MLP连接器、响应提示、数据混合)实现SOTA,证明视觉指令调优的核心价值,挑战了“LMMs需海量预训练”的共识。其数据高效性(1.2M样本)和公开数据使用,为开源LMM研究提供可复现基线。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)