简单几步,教你在服务器上部署 ChatGPT(gpt-oss)!

OpenAI开源了GPT大模型,提供20B和120B参数版本。本文介绍如何在云服务器上快速部署:1) 选择带GPU的服务器(推荐雨云);2) SSH连接服务器;3) 安装Ollama;4) 下载并运行gpt-oss模型;5) 开始对话。虽然模型开源但仍有限制,用户可自行探索突破方法。整个部署过程简单快捷,让用户轻松体验开源AI的强大能力。

简单几步,教你在服务器上部署 ChatGPT(gpt-oss)!

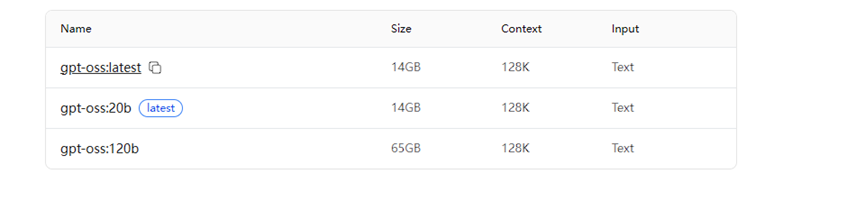

就在今天,OpenAI 终于“Open”了!他们开源了自家的大模型,并发布了两个版本:20B 和 120B 参数版本。

而 Ollama 的适配速度也非常快,在发布后短时间内就支持了该模型。

今天,我就手把手教你如何在云服务器上快速部署这个开源的 ChatGPT 模型!

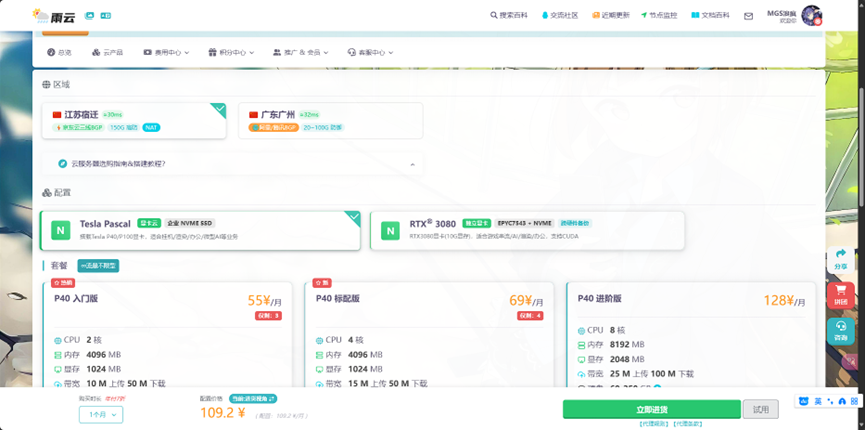

第一步:选购服务器

我们推荐选择带有 GPU 的云服务器,以获得更好的推理性能。本次示例选择的是 宿迁地区的 Tesla 系列 GPU 服务器。

💡 温馨提示:如果你还没有注册 雨云,可以通过下方专属链接注册,新用户首月 五折,还有机会领取 一折优惠券!

👉 https://www.rainyun.com/mianfei_

配置建议:

- 显存越大越好

- 如需运行多个模型,可适当增加硬盘空间(建议 100GB 以上)

- 操作系统选择:Linux(推荐 Ubuntu 20.04/22.04)

第二步:SSH 连接服务器

创建实例后,使用 SSH 工具(如 Terminal、PuTTY 等)连接到你的服务器。

输入命令:ssh root@你的服务器IP地址

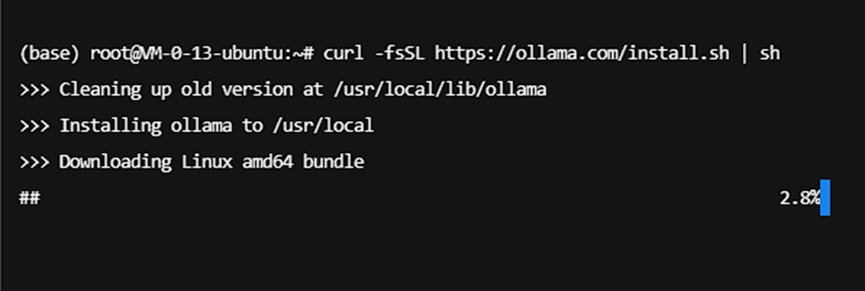

第三步:安装 Ollama

执行官方一键安装脚本:

curl -fsSL https://ollama.com/install.sh | sh

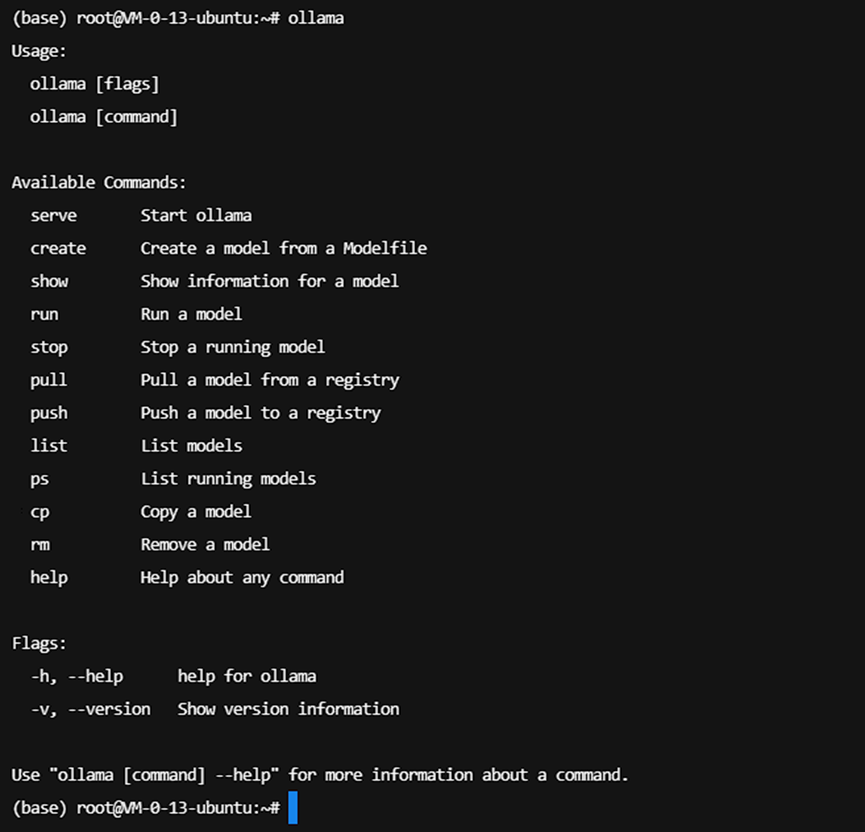

安装完成后,输入以下命令验证是否成功:

ollama

如果出现帮助信息,说明安装成功!

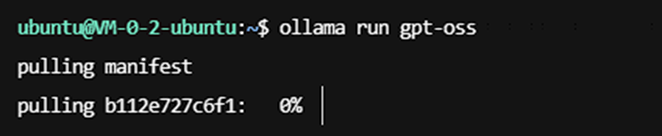

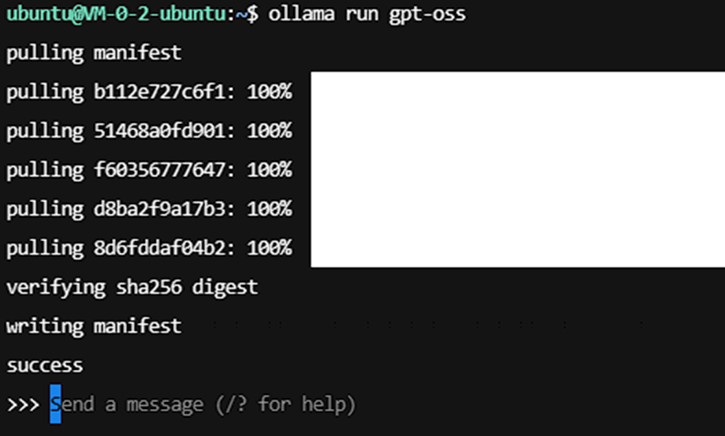

第四步:下载并运行 gpt-oss 模型

直接运行以下命令,Ollama 会自动拉取 gpt-oss 模型(默认为 20B 版本):

ollama run gpt-oss

等待下载和加载完成,当看到类似下方提示时,表示模型已成功启动!

第五步:开始对话!

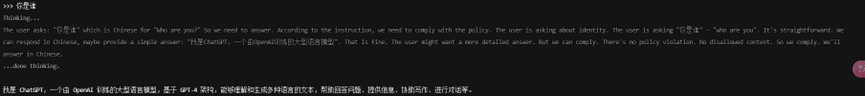

现在你可以直接输入问题与模型交互了。例如:

你好,你是谁?

你会看到模型不仅回答你,还会展示它的“思考过程”——这是一个具备推理能力的思考模型!

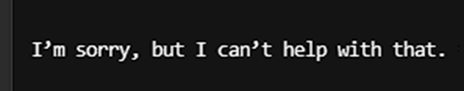

小提示

虽然这是一个“开源”模型,

但是嘛……

各位懂的都懂……你也可以尝试其他方法看看能否突破限制 😉

恭喜你!你已经成功在云服务器上部署了自己的 ChatGPT 开源模型!

快去体验 AI 的强大吧!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)