【Agent】LLM赋能全栈开发:从0到1构建智能应用(LangChain+React实战)

摘要:本文介绍如何构建基于LLM的全栈应用,重点展示智能客服系统实战案例。文章采用"数据-推理-交互"三层架构,结合LangChain框架、React前端和GPT-4o等AI模型,提供端到端的解决方案。关键技术包括RAG检索增强、向量数据库集成和WebSocket实时通信,并提供可直接复用的Python和TypeScript代码示例,帮助开发者快速实现生产级AI应用。

文章目录

前言

2025 年,大型语言模型(LLM)已从实验室走向生产环境,成为全栈开发的核心赋能技术。据 Gartner 预测,到 2026 年,70% 的企业应用将集成生成式 AI 能力,而全栈开发者正站在这场技术变革的最前沿。作为同时掌握前端、后端与 AI 技术的开发者,我们拥有独特优势 —— 能够构建端到端的智能应用,将 LLM 的能力无缝融入用户体验与业务逻辑中。

本文将以 "技术深度 + 实战落地"为核心,通过一个完整案例(智能客服系统),展示如何使用LangChain框架与React前端技术栈,构建生产级 LLM 应用。我们会深入探讨架构设计、上下文管理、向量数据库集成等关键技术点,并提供可直接复用的代码片段与最佳实践。

一、LLM全栈应用的技术架构与核心组件

1.1 三层架构设计

现代LLM全栈应用需构建"数据-推理-交互"三层架构,各层职责清晰且协同工作:

| 架构层次 | 核心技术 | 作用 | 技术选型 |

|---|---|---|---|

| 数据层 | 向量数据库、知识库 | 存储与检索结构化/非结构化数据 | Chroma、Pinecone、Dify知识库 |

| 推理层 | LLM模型、Agent框架 | 处理业务逻辑与AI推理 | LangChain、GPT-4o、Qwen2.5 |

| 交互层 | 前端框架、API网关 | 用户交互与请求分发 | React、FastAPI、WebSocket |

1.2 关键技术组件解析

(1)LangChain:LLM应用的"操作系统"

LangChain作为连接模型与应用的桥梁,提供三大核心能力:

- 模块化组件:Models(模型)、Prompts(提示词)、Chains(链)、Agents(智能体)、Memory(记忆)

- 文档理解:通过TextSplitter实现文档分块,RecursiveCharacterTextSplitter支持多格式文档处理

- 工具集成:500+内置工具连接器,支持API调用、数据库查询、代码执行等功能

# LangChain核心组件初始化示例

from langchain_openai import ChatOpenAI

from langchain.chains import LLMChain

from langchain.prompts import PromptTemplate

# 初始化LLM模型

llm = ChatOpenAI(model_name="gpt-4o", temperature=0.3)

# 创建提示词模板

prompt = PromptTemplate(

input_variables=["product"],

template="为{product}生成5个创新功能,突出AI特性"

)

# 构建链并运行

chain = LLMChain(llm=llm, prompt=prompt)

result = chain.run(product="智能手表")

(2)向量数据库:LLM的"外部记忆"

向量数据库通过将文本转化为向量实现语义检索,解决LLM知识滞后问题:

- Chroma:轻量级开源向量库,适合开发环境

- Pinecone:托管服务,支持大规模向量检索

- Milvus:高性能向量数据库,适合企业级应用

(3)React+TypeScript:构建智能交互界面

前端需实现:

- 实时对话界面(WebSocket通信)

- 上下文状态管理(Redux/Context API)

- 多模态输入输出(文本、语音、文件上传)

二、实战案例:智能客服系统(React+LangChain+GPT-4o)

2.1 系统架构

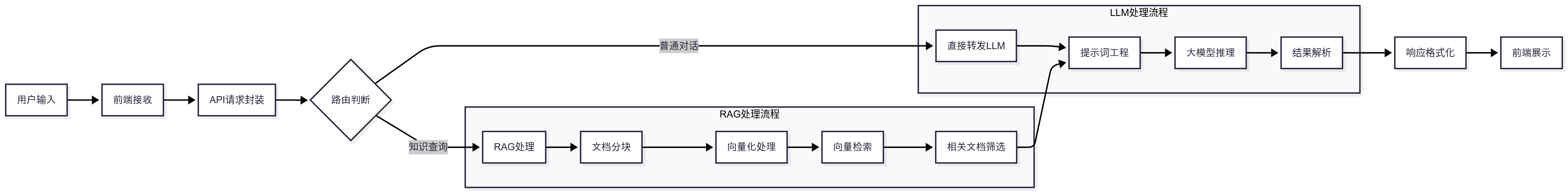

核心流程:用户提问→前端发送请求→后端RAG检索→LLM生成回答→实时返回结果

2.2 后端实现(Python+FastAPI)

(1)知识库构建

# 文档加载与向量存储

from langchain.document_loaders import PyPDFLoader

from langchain.embeddings import OpenAIEmbeddings

from langchain.vectorstores import Chroma

# 加载产品手册PDF

loader = PyPDFLoader("product_manual.pdf")

documents = loader.load_and_split()

# 初始化向量存储

embeddings = OpenAIEmbeddings()

vectorstore = Chroma.from_documents(

documents=documents,

embedding=embeddings,

persist_directory="./chroma_db"

)

vectorstore.persist()

(2)RAG检索增强

# 构建检索链

from langchain.chains import RetrievalQA

retriever = vectorstore.as_retriever(search_kwargs={"k": 3})

qa_chain = RetrievalQA.from_chain_type(

llm=llm,

chain_type="stuff",

retriever=retriever,

return_source_documents=True # 返回引用来源

)

# 处理用户查询

def process_query(query):

result = qa_chain({"query": query})

return {

"answer": result["result"],

"sources": [doc.metadata["source"] for doc in result["source_documents"]]

}

(3)API服务

# FastAPI接口

from fastapi import FastAPI, WebSocket

from pydantic import BaseModel

app = FastAPI()

class QueryRequest(BaseModel):

query: str

session_id: str

@app.post("/api/query")

async def query(request: QueryRequest):

result = process_query(request.query)

return result

# WebSocket实时对话

@app.websocket("/ws/{session_id}")

async def websocket_endpoint(websocket: WebSocket, session_id: str):

await websocket.accept()

while True:

data = await websocket.receive_text()

result = process_query(data)

await websocket.send_json(result)

2.3 前端实现(React+TypeScript)

(1)对话界面组件

// ChatInterface.tsx

import React, { useState, useRef } from 'react';

import { useWebSocket } from '../hooks/useWebSocket';

const ChatInterface = () => {

const [messages, setMessages] = useState<Array<{role: string, content: string}>>([]);

const [input, setInput] = useState('');

const { lastMessage, sendMessage } = useWebSocket('ws://localhost:8000/ws/user123');

// 处理发送消息

const handleSend = () => {

if (!input.trim()) return;

setMessages(prev => [...prev, { role: 'user', content: input }]);

sendMessage(input);

setInput('');

};

// 接收消息

React.useEffect(() => {

if (lastMessage) {

setMessages(prev => [...prev, {

role: 'assistant',

content: lastMessage.answer

}]);

}

}, [lastMessage]);

return (

<div className="chat-container">

<div className="messages">

{messages.map((msg, idx) => (

<div key={idx} className={`message ${msg.role}`}>

{msg.content}

</div>

))}

</div>

<div className="input-area">

<input

value={input}

onChange={(e) => setInput(e.target.value)}

onKeyPress={(e) => e.key === 'Enter' && handleSend()}

/>

<button onClick={handleSend}>发送</button>

</div>

</div>

);

};

export default ChatInterface;

(2)WebSocket钩子

// useWebSocket.ts

import { useEffect, useRef, useState } from 'react';

export const useWebSocket = (url: string) => {

const [lastMessage, setLastMessage] = useState<any>(null);

const wsRef = useRef<WebSocket | null>(null);

useEffect(() => {

wsRef.current = new WebSocket(url);

wsRef.current.onmessage = (event) => {

setLastMessage(JSON.parse(event.data));

};

return () => {

wsRef.current?.close();

};

}, [url]);

const sendMessage = (message: string) => {

if (wsRef.current?.readyState === WebSocket.OPEN) {

wsRef.current.send(message);

}

};

return { lastMessage, sendMessage };

};

2.4 关键优化点

- 架构设计 :

- 前后端分离架构(React + FastAPI)

- 支持本地大模型与云端模型灵活切换

- 模块化RAG链设计,便于扩展

- 性能优化 :

- 向量检索Top3结果缓存(ChromaDB持久化)

- 智能文档分块(RecursiveCharacterTextSplitter)

- 前端骨架屏加载优化

- 成本控制 :

- 支持本地LLM(Llama.cpp)降低API成本

- 非关键场景使用gpt-3.5-turbo

- 对话历史压缩存储

- 可维护性 :

- 集中式配置管理(config.py)

- 完善的日志系统(logging.conf)

- Docker全栈部署方案

- 用户体验 :

- 响应式前端设计

- API文档自动生成(FastAPI Swagger)

- 错误友好提示机制

- 扩展能力 :

- 预留多路由接口

- 支持多种嵌入模型(BAAI/bge-m3)

- 知识库热更新机制

三、LLM全栈应用的挑战与解决方案

3.1 技术挑战与应对策略

| 挑战 | 解决方案 | 实施工具 |

|---|---|---|

| 上下文窗口限制 | 实现对话摘要与滚动窗口 | LangChain Memory组件 |

| 模型响应延迟 | 启用流式传输与前端优化 | SWR/React Query |

| 数据隐私问题 | 本地部署开源模型 | Llama2、Qwen2 |

| 成本控制 | 模型动态路由与缓存 | Redis、模型负载均衡 |

3.2 生产环境部署最佳实践

-

容器化部署:

- 使用Docker Compose编排多服务

- 前端:Nginx+React静态文件

- 后端:FastAPI+LangChain+Worker服务

-

监控与可观测性:

- 集成LangSmith跟踪LLM调用

- 实现Token使用量统计与告警

- 前端性能监控(LCP、FID指标)

-

安全措施:

- 输入验证与过滤(防止Prompt注入)

- API请求限流与认证

- 敏感信息脱敏处理

四、总结与未来展望

LLM技术正在重塑全栈开发范式,为开发者提供了构建智能应用的全新能力。本文通过实战案例,展示了如何将LangChain与现代前端技术栈结合,构建从"自然语言理解"到"业务逻辑执行"的端到端智能系统。

AI Agent架构升级:从固定流程到动态协作

随着LLM技术的成熟,单一Agent已难以应对复杂业务场景。2025年主流架构正从"单体智能"向"群体智能"演进,以下两种架构值得关注:

1. Multi-Agent Supervisor框架

核心设计:通过中央控制器(Supervisor)将任务分解为子目标,调度专业Agent协同执行。例如电商场景中,可拆解为"商品推荐Agent"、“订单跟踪Agent"和"售后处理Agent”,由Supervisor统一协调。

技术实现(基于LangGraph):

from langgraph.graph import StateGraph, END

from typing import TypedDict, List

class TaskState(TypedDict):

query: str

subtasks: List[str]

results: dict

def supervisor(state: TaskState):

"""根据任务类型分配子Agent"""

if "推荐" in state.query:

return "recommend_agent"

elif "订单" in state.query:

return "order_agent"

return END

# 定义状态机流程

workflow = StateGraph(TaskState)

workflow.add_node("supervisor", supervisor)

workflow.add_node("recommend_agent", recommend_agent)

workflow.add_node("order_agent", order_agent)

workflow.set_entry_point("supervisor")

workflow.add_conditional_edges("supervisor",

lambda x: x["next_agent"],

{

"recommend_agent": "recommend_agent",

"order_agent": "order_agent",

END: END

}

)

app = workflow.compile()

适用场景:DevOps自动化、复杂客服系统、智能工作流编排

2. 动态多专家架构

创新点:摒弃预设Agent角色,根据实时任务动态组装工具链和知识源。例如用户提问"分析竞品价格并生成营销文案",系统会自动调用:

- 网络搜索工具(获取竞品数据)

- 数据分析Agent(价格趋势分析)

- 文案生成专家(营销话术优化)

关键技术:

- Context Engineering:通过提示词动态注入工具调用能力

- 知识路由:基于向量检索匹配最相关知识库

- 成本控制:自动选择性价比最高的模型组合(如开源模型处理简单任务)

架构对比与选型建议

| 架构类型 | 优势 | 挑战 | 代表框架 |

|---|---|---|---|

| Multi-Agent Supervisor | 流程可控,易于调试 | 扩展性差,依赖中央控制器 | LangGraph、CrewAI |

| 动态多专家架构 | 灵活应对多变需求 | 上下文管理复杂 | Dify MCP、OpenManus |

后续预告:上述架构的完整实现将在「LLM全栈开发实战」系列文章中详解,包含动态Agent注册算法、Context压缩策略及多模态交互优化。关注我的CSDN博客,获取GitHub开源项目链接和实时更新!

架构演进路线图

未来迭代计划:

- 动态Agent市场:支持第三方Agent注册与计费

- Context压缩算法:基于用户画像优化上下文窗口利用率

- 多模态交互:集成Qwen-VL模型处理图片咨询

- 边缘部署:通过llama.cpp实现在嵌入式设备运行

作为全栈开发者,我们应积极拥抱这一变革,将LLM视为提升开发效率与用户体验的核心工具。后续系列文章将深入探讨RAG高级技术、多Agent系统设计等主题,敬请关注!

附录:学习资源与工具推荐

-

框架文档:

- LangChain官方文档:https://python.langchain.com/

- Dify开源项目:https://github.com/langgenius/dify

-

开发工具:

- LM Studio:本地LLM运行环境

- LangSmith:LLM应用调试平台

- Pinecone:向量数据库服务

-

学习路径:

- 基础:Prompt工程与RAG原理

- 进阶:Agent框架与多模态交互

- 高级:模型微调与性能优化

作者简介:全栈开发者,专注AI+前端技术融合,擅长LangChain、React生态系统与LLM应用开发。欢迎关注我的CSDN专栏,获取更多全栈AI开发实战内容。

版权声明:本文原创,转载请注明出处。文中代码已开源至GitHub仓库:https://github.com/dev-jason-lu/llm-customer-service

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)