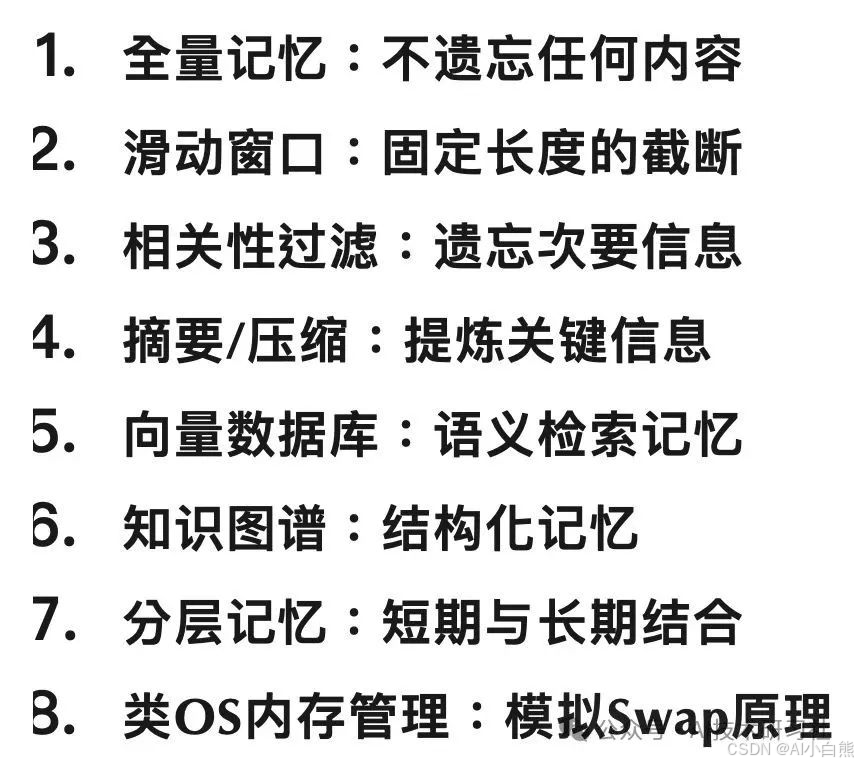

AI Agent 记忆系统怎么选?8种主流策略的设计逻辑与落地实践

本文将全面讲透8种主流AI记忆策略,配套代码演示、适用场景分析和优劣对比,让你搞懂原理,也能直接上手实战。

当你和ChatGPT聊得越久,你有没有发现它似乎总是“健忘”?聊到第十轮,它可能已经忘了你第一轮的问题。这不是它不聪明,而是它的大脑——也就是上下文窗口,有容量限制。

这就像你和一个同事开会,他只能记住你刚刚说的三句话,前面讨论的战略和目标早就忘得一干二净。这种“记忆力差”的问题,不仅困扰着AI聊天助手,也直接限制了Agent、对话系统等复杂AI应用的智能上限。

为了让AI真正具备“长记性”,我们必须在其系统中加入记忆模块(Memory)。

记忆不仅影响对话连贯性,更决定了AI是否能成为一个真正的“长期助手”。但记忆并不等于简单存储。不同的任务、不同的代价容忍度,决定了你要用不同类型的记忆策略。

本文将全面讲透8种主流AI记忆策略,配套代码演示、适用场景分析和优劣对比,让你搞懂原理,也能直接上手实战。

记忆(Memory)是AI智能体必备的能力之一。随着对话轮数与深度的增加,如何让AI智能体“记住”过去的上下文,是实现精准理解与个性化AI系统的关键。

由于大语言模型(LLM)存在上下文长度限制,如果不对记忆进行优化,长对话很容易带来两个问题:

- 遗忘早期信息,导致理解偏差;

- 过度消耗计算资源,增加推理成本。

尽管 MemGPT、Mem0 等优秀开源项目已提供初步实现,理解这些策略的底层原理,仍是我们在设计或部署智能体时的重要一环。本文将深入解析 8 种常见的记忆管理策略,结合通俗原理讲解、代码示例、优劣分析与应用场景,帮助你系统掌握 AI 记忆的设计思路。

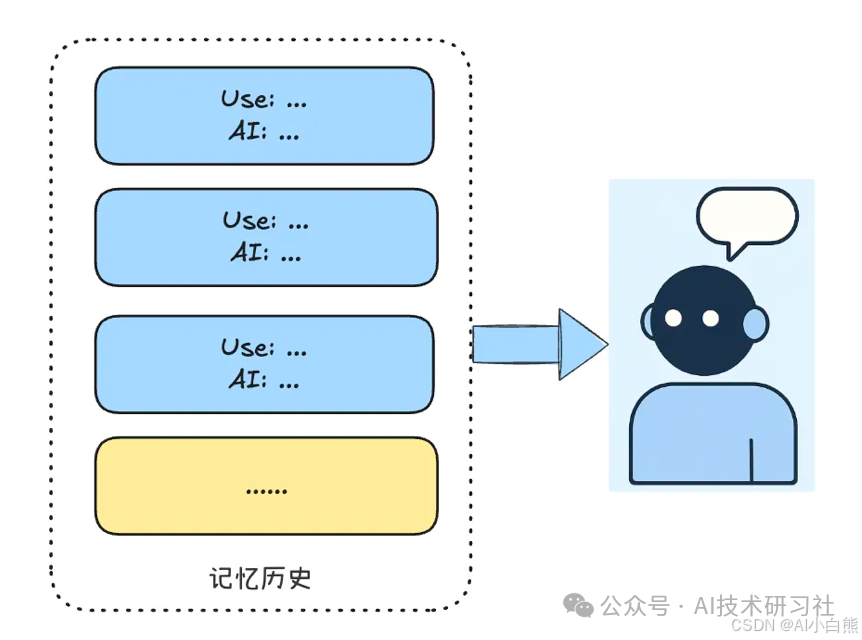

01. 全量记忆:不遗忘任何内容

原理

将全部历史上下文累积,每轮都完整地发送给 LLM,无需筛选或删减。

实现代码

history = []def add_message(user_input, ai_response): turn = {"user": user_input, "assistant": ai_response} history.append(turn)def get_context(query): return concat_all(history) # 拼接所有历史信息

优劣分析

- ✅ 保留全部细节,简单易实现;

- ❌ 易触发上下文溢出,增加推理成本。

适用场景

一次性对话或上下文长度可控的应用,如 FAQ 问答、简短闲聊。

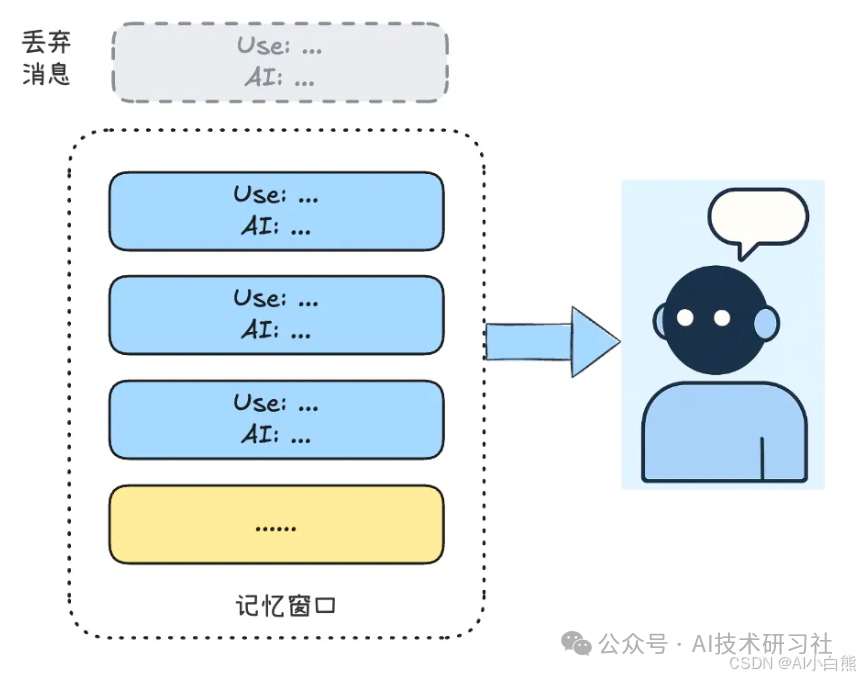

02. 滑动窗口:固定长度截断

原理

仅保留最近若干轮对话,以模拟人类短时记忆。

实现代码

memory = []WINDOW_SIZE = 3def add_message(user_input, ai_response): turn = {"user": user_input, "assistant": ai_response} memory.append(turn) if len(memory) > WINDOW_SIZE: memory.pop(0)def get_context(query): return concat_all(memory)

优劣分析

- ✅ 控制上下文长度,节省计算资源;

- ❌ 遗忘早期重要信息,健忘性强。

适用场景

适合对上下文依赖不强的轻量级任务,如闲聊机器人。

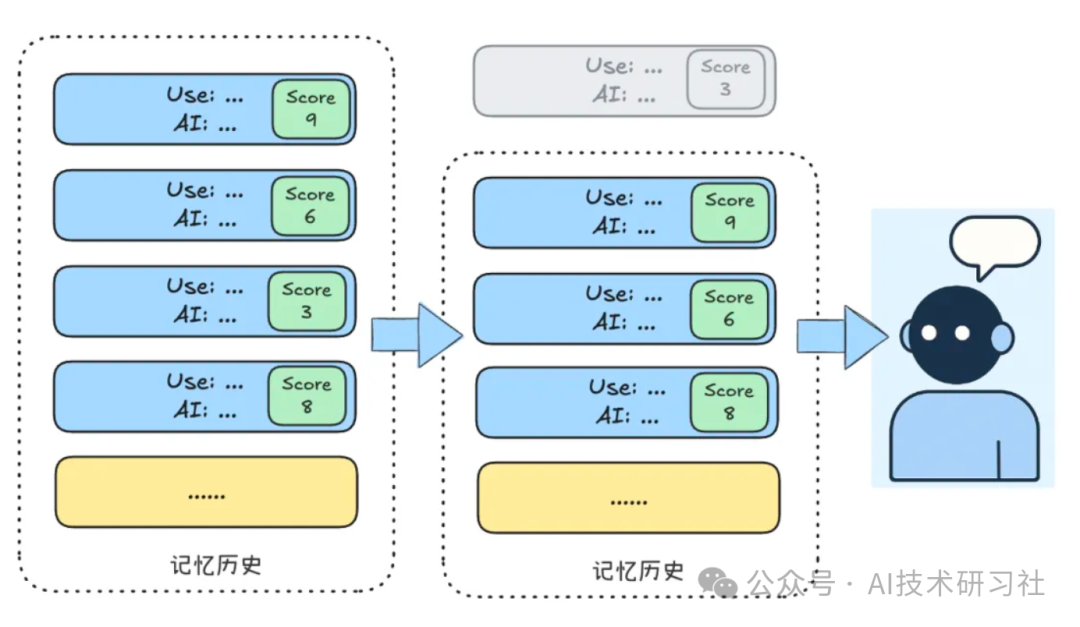

03. 相关性过滤:遗忘次要信息

原理

为每轮对话计算“相关性”得分,仅保留高分内容。

实现代码

memory = []MAX_ITEMS = 25def add_message(user_input, ai_response): item = { "user": user_input, "assistant": ai_response, "score": evaluate(user_input, ai_response) } memory.append(item) if len(memory) > MAX_ITEMS: to_remove = min(memory, key=lambda x: x["score"]) memory.remove(to_remove)def get_context(query): return concat_all(sorted(memory, key=lambda x: x.get("order", 0)))

优劣分析

- ✅ 更“智能”的选择性保留重要内容;

- ❌ 评估函数复杂,可能误删。

适用场景

知识密集型场景,如研究助理、教育问答系统。

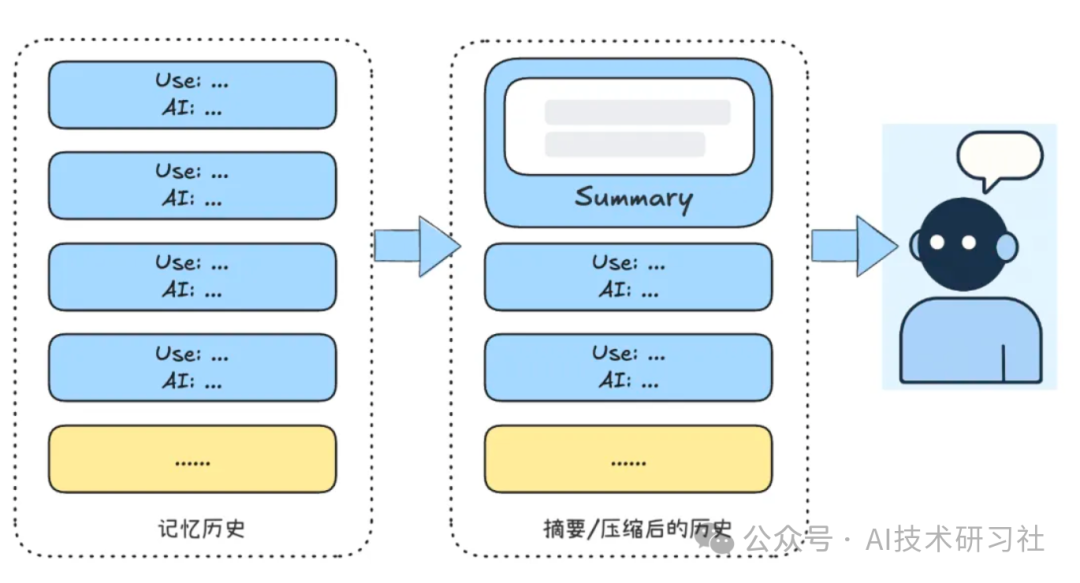

04. 摘要/压缩:提炼关键信息

原理

将旧对话浓缩为摘要,节省窗口空间。

实现代码

memory = []summary = NoneMAX_LEN = 10def add_message(user_input, ai_response): turn = {"user": user_input, "assistant": ai_response} memory.append(turn) if len(memory) > MAX_LEN: old_turns = memory[:-5] summary_text = summarize(old_turns) summary = merge(summary, summary_text) memory.clear() memory.append({"summary": summary}) memory.extend(memory[-5:])def get_context(query): return concat_all(memory)

优劣分析

- ✅ 长期保留核心信息,节省空间;

- ❌ 摘要依赖LLM质量,可能遗漏。

适用场景

AI心理咨询、长期陪伴型助手。

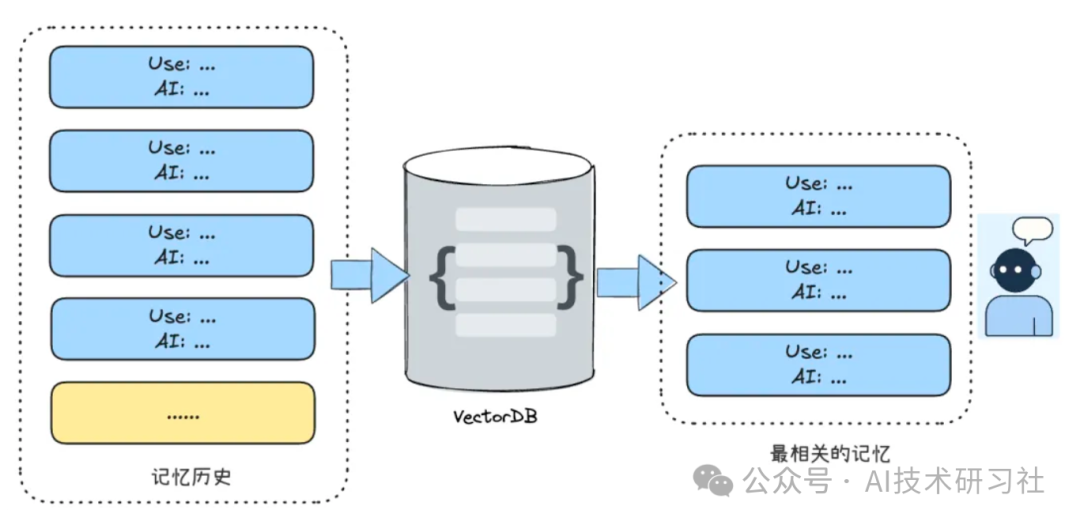

05. 向量数据库:语义检索记忆

原理

将对话嵌入存入向量数据库,按需语义检索。

实现代码

memory = VectorStore()def add_message(user_input, ai_response): turn = {"user": user_input, "assistant": ai_response} embedding = embed(turn) memory.add(embedding, turn)def get_context(query): q_embedding = embed(query) results = memory.search(q_embedding, top_k=3) return concat_all(results)

优劣分析

- ✅ 可无限扩展,支持长期语义记忆;

- ❌ 向量质量影响大,系统复杂度高。

适用场景

个性化助手、法律/医疗对话增强。

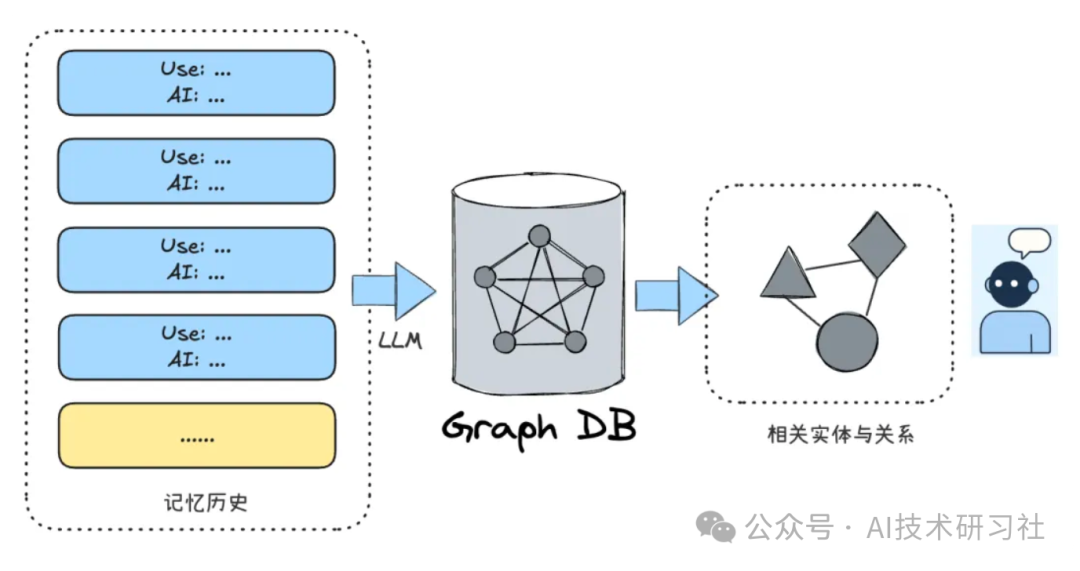

06. 知识图谱:结构化长期记忆

原理

提取实体-关系三元组构建图谱,以图结构组织记忆。

实现代码

graph = KnowledgeGraph()def add_message(user_input, ai_response): full_text = f"User: {user_input}\nAI: {ai_response}" triples = extract_triples(full_text) for s, r, o in triples: graph.add_edge(s.strip(), o.strip(), relation=r.strip())def get_context(query): entities = extract_entities(query) context = [] for e in entities: context += graph.query(e) return context

优劣分析

- ✅ 支持复杂推理与结构化检索;

- ❌ 构建维护成本高,抽取依赖准确度。

适用场景

科研助理、政务数据智能体等结构知识管理应用。

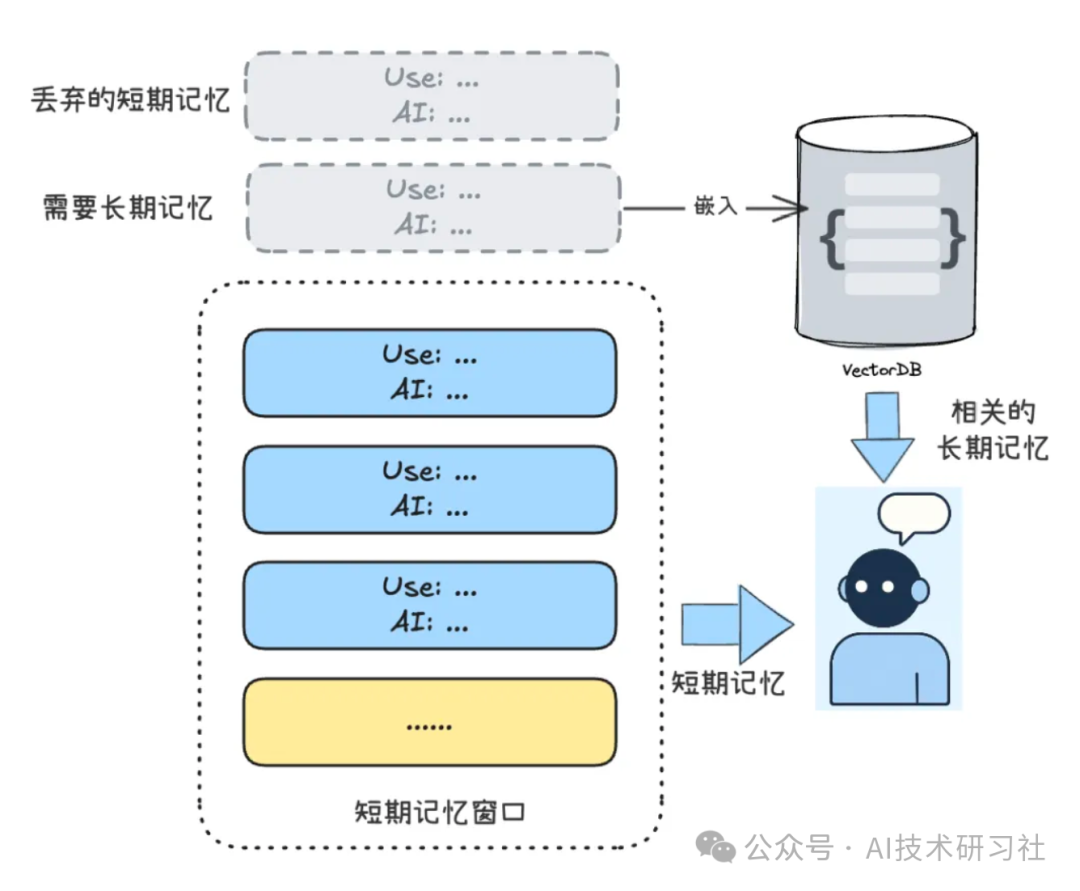

07. 分层记忆:结合短期与长期

原理

模仿人类记忆,将信息分别存入短期与长期存储。

实现代码

short_term = SlidingWindow(max_turns=2)long_term = VectorDatabase(k=2)promotion_keywords = ["记住", "我喜欢", "总是"]def add_message(user_input, ai_response): short_term.add(user_input, ai_response) if any(k in user_input for k in promotion_keywords): summary = summarize(user_input + ai_response) vector = embed(summary) long_term.add(vector, summary)def get_context(query): recent = short_term.get_context() vector_query = embed(query) related = long_term.search(vector_query) return f"【长期记忆】\n{concat(related)}\n\n【当前上下文】\n{concat(recent)}"

优劣分析

- ✅ 结合短期及时性与长期持久性;

- ❌ 需要关键词策略,调优复杂。

适用场景

多轮持续对话、个性化客户服务。

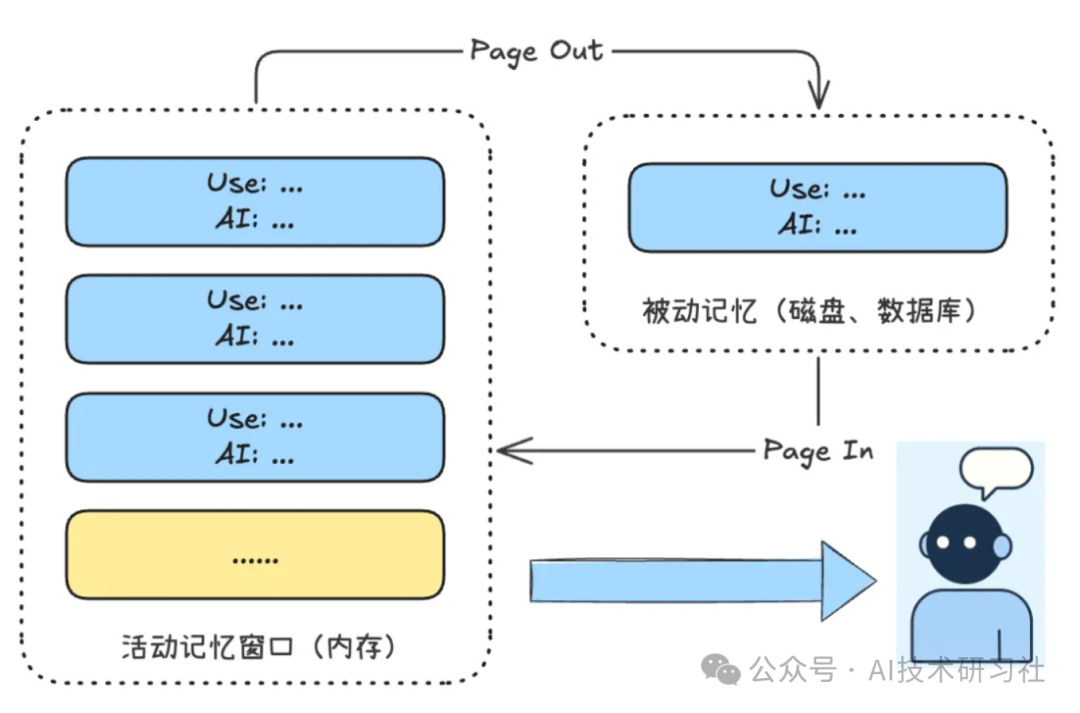

08. 类OS内存管理:模拟Swap机制

原理

仿操作系统“Page In/Out”内存调度,将旧信息换出,按需调入。

实现代码

active_memory = Deque(maxlen=2)passive_memory = {}turn_id = 0def add_message(user_input, ai_response): global turn_id turn = f"User: {user_input}\nAI: {ai_response}" if len(active_memory) >= 2: old_id, old_turn = active_memory.popleft() passive_memory[old_id] = old_turn active_memory.append((turn_id, turn)) turn_id += 1def get_context(query): context = "\n".join([x[1] for x in active_memory]) paged_in = "" for id, turn in passive_memory.items(): if any(word in turn.lower() for word in query.lower().split() if len(word) > 3): paged_in += f"\n(Paged in from Turn {id}): {turn}" return f"### Active Memory (RAM):\n{context}\n\n### Paged-In from Disk:\n{paged_in}"

优劣分析

- ✅ 避免重要信息遗失,管理高效;

- ❌ 实现较复杂,需调度机制合理。

适用场景

延迟敏感、多轮问答智能体,如智能客服、事务型助手。

总结:AI 记忆策略对比一览

| 策略 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| 全量记忆 | 简单直接,完整保留 | 上下文膨胀,计算成本高 | 一次性问答,短对话场景 |

| 滑动窗口 | 控制成本,实时性好 | 健忘性强 | FAQ,闲聊等无历史依赖任务 |

| 相关性过滤 | 选择性保留,智能筛选 | 评分难度大 | 知识型机器人 |

| 摘要压缩 | 长期存储,节省上下文 | 依赖LLM摘要质量 | 长对话、心理辅导 |

| 向量检索 | 可扩展、语义召回强 | 嵌入质量关键,系统复杂 | 个性助手、跨轮任务记忆 |

| 知识图谱 | 可推理、结构化记忆 | 构建成本高,抽取误差可能大 | 客服系统、科研辅助 |

| 分层记忆 | 人类仿生,结合长期短期优势 | 实现复杂、参数调优难 | 企业助手、用户画像建模 |

| 类OS机制 | 类虚拟内存,调度灵活 | 实现复杂,触发逻辑需调优 | 高效交互、回溯型问答场景 |

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

只要你真心想学习AI大模型技术,这份精心整理的学习资料我愿意无偿分享给你,但是想学技术去乱搞的人别来找我!

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

大模型全套学习资料展示

自我们与MoPaaS魔泊云合作以来,我们不断打磨课程体系与技术内容,在细节上精益求精,同时在技术层面也新增了许多前沿且实用的内容,力求为大家带来更系统、更实战、更落地的大模型学习体验。

希望这份系统、实用的大模型学习路径,能够帮助你从零入门,进阶到实战,真正掌握AI时代的核心技能!

01 教学内容

-

从零到精通完整闭环:【基础理论 →RAG开发 → Agent设计 → 模型微调与私有化部署调→热门技术】5大模块,内容比传统教材更贴近企业实战!

-

大量真实项目案例: 带你亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

02适学人群

应届毕业生: 无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型: 非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能突破瓶颈: 传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

vx扫描下方二维码即可

本教程比较珍贵,仅限大家自行学习,不要传播!更严禁商用!

03 入门到进阶学习路线图

大模型学习路线图,整体分为5个大的阶段:

04 视频和书籍PDF合集

从0到掌握主流大模型技术视频教程(涵盖模型训练、微调、RAG、LangChain、Agent开发等实战方向)

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路(不吹牛,真有用)

05 行业报告+白皮书合集

收集70+报告与白皮书,了解行业最新动态!

06 90+份面试题/经验

AI大模型岗位面试经验总结(谁学技术不是为了赚$呢,找个好的岗位很重要)

07 deepseek部署包+技巧大全

由于篇幅有限

只展示部分资料

并且还在持续更新中…

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

更多推荐

已为社区贡献186条内容

已为社区贡献186条内容

所有评论(0)