LLaMa-Factory部署微调大模型教程

由此便成功实现了直观的交互式的大模型微调,通过选择不同的模型、微调模式、数据集,设置不同的训练参数进行微调,最终还可以导出微调后合并的模型。各种参数模式的设置大家加油探索吧!可以从huggingface或者魔塔社区下载大模型,下载成功后需记住保存的地址,后续微调需要使用,以Qwen2.5-1.5B为例下载好的文件目录如下。模型的地址就是刚才下载保存的地址,注意模型名称要和地址下的名称所对应,这里我

LLaMa-Factory部署微调大模型教程

背景

LLaMA-Factory 是一个专为大语言模型(LLM)微调与推理而设计的开源框架,旨在简化模型训练、部署和应用的流程。它支持多种主流模型(如 LLaMA、Qwen、ChatGLM 等),并集成了 LoRA、QLoRA 等高效微调技术。LLaMA-Factory 提供统一的命令行接口、灵活的配置系统和可视化 Web UI,适用于科研、工业和个人项目的快速开发与部署。无论是文本生成、对话系统还是多模态任务,LLaMA-Factory 都能提供稳定、高效的解决方案。

一、下载部署LLaMa-Factory

直接从github拉取下载项目代码,然后创建虚拟环境(博主使用的是venv,env是虚拟环境名称)并安装一些相关的包

git clone https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

python3 -m venv env

source env/bin/activate

pip install -e ".[torch,metrics]" --no-build-isolation

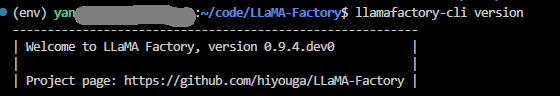

输入命令如llamafactory-cli version下图显示则表示安装成功。

二、下载大模型

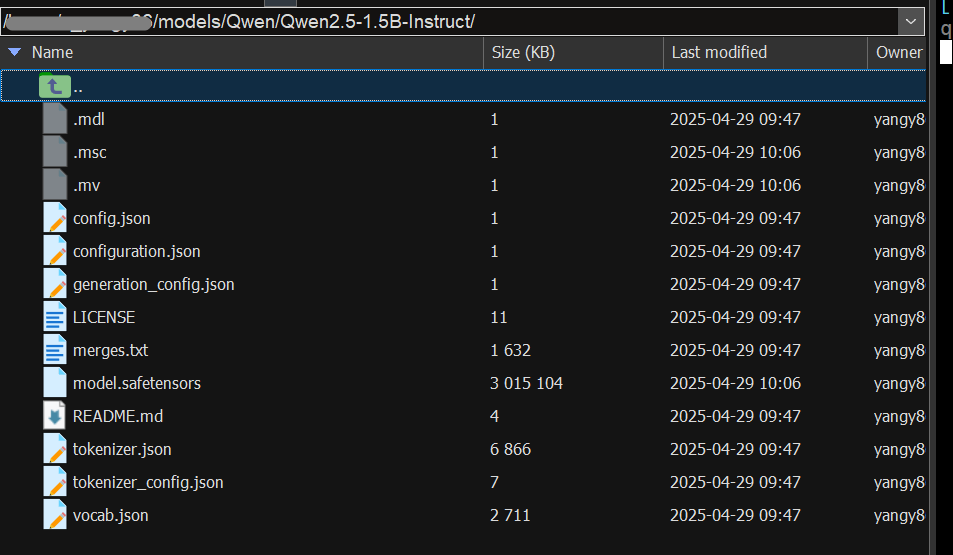

可以从huggingface或者魔塔社区下载大模型,下载成功后需记住保存的地址,后续微调需要使用,以Qwen2.5-1.5B为例下载好的文件目录如下。

三、启动LLaMa-Factory

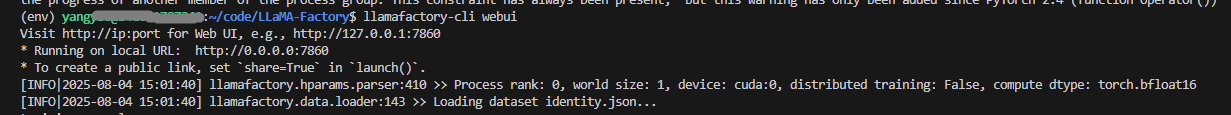

输入指令:llamafactory-cli webui 启动llama-factory的webui

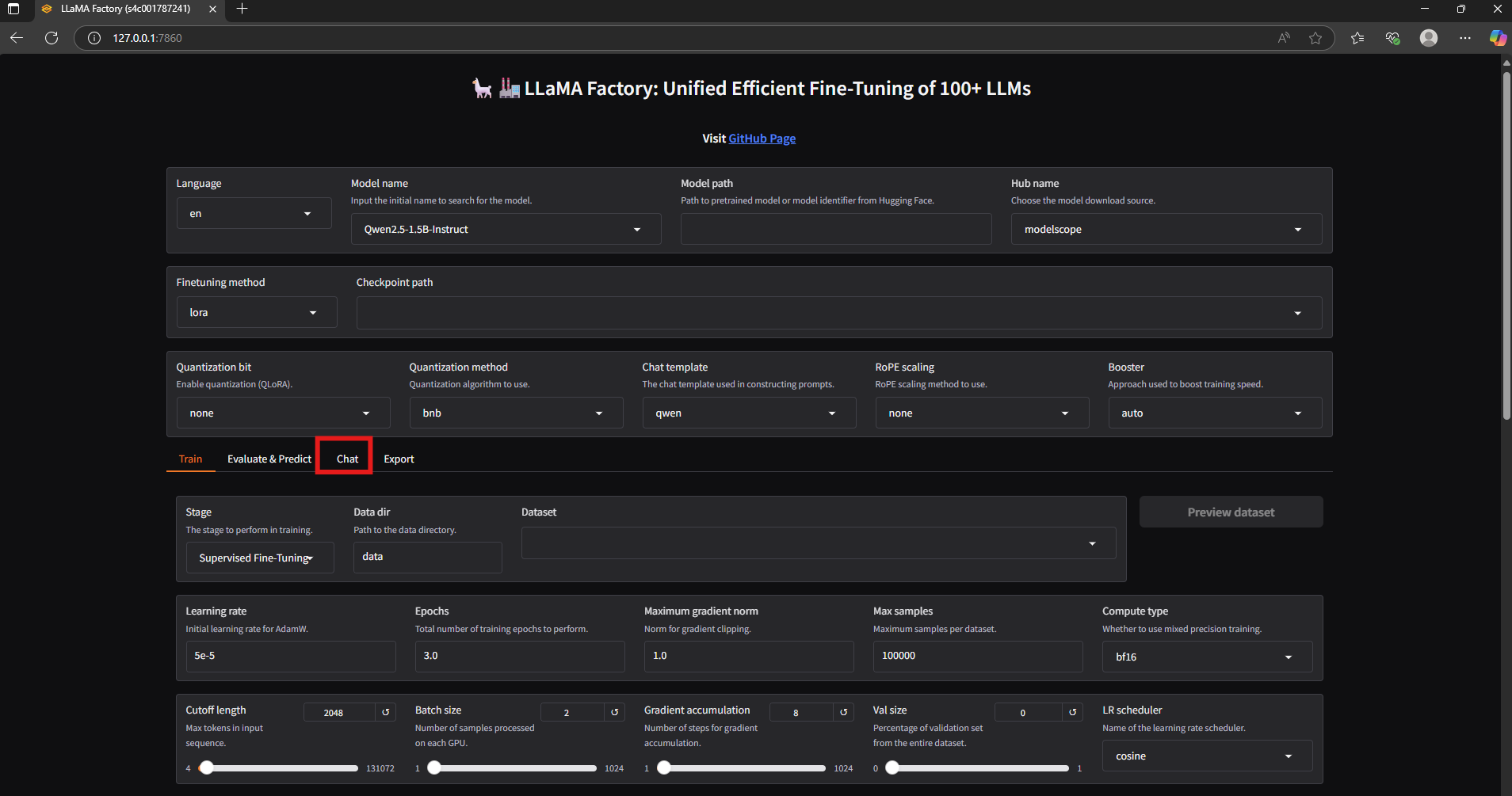

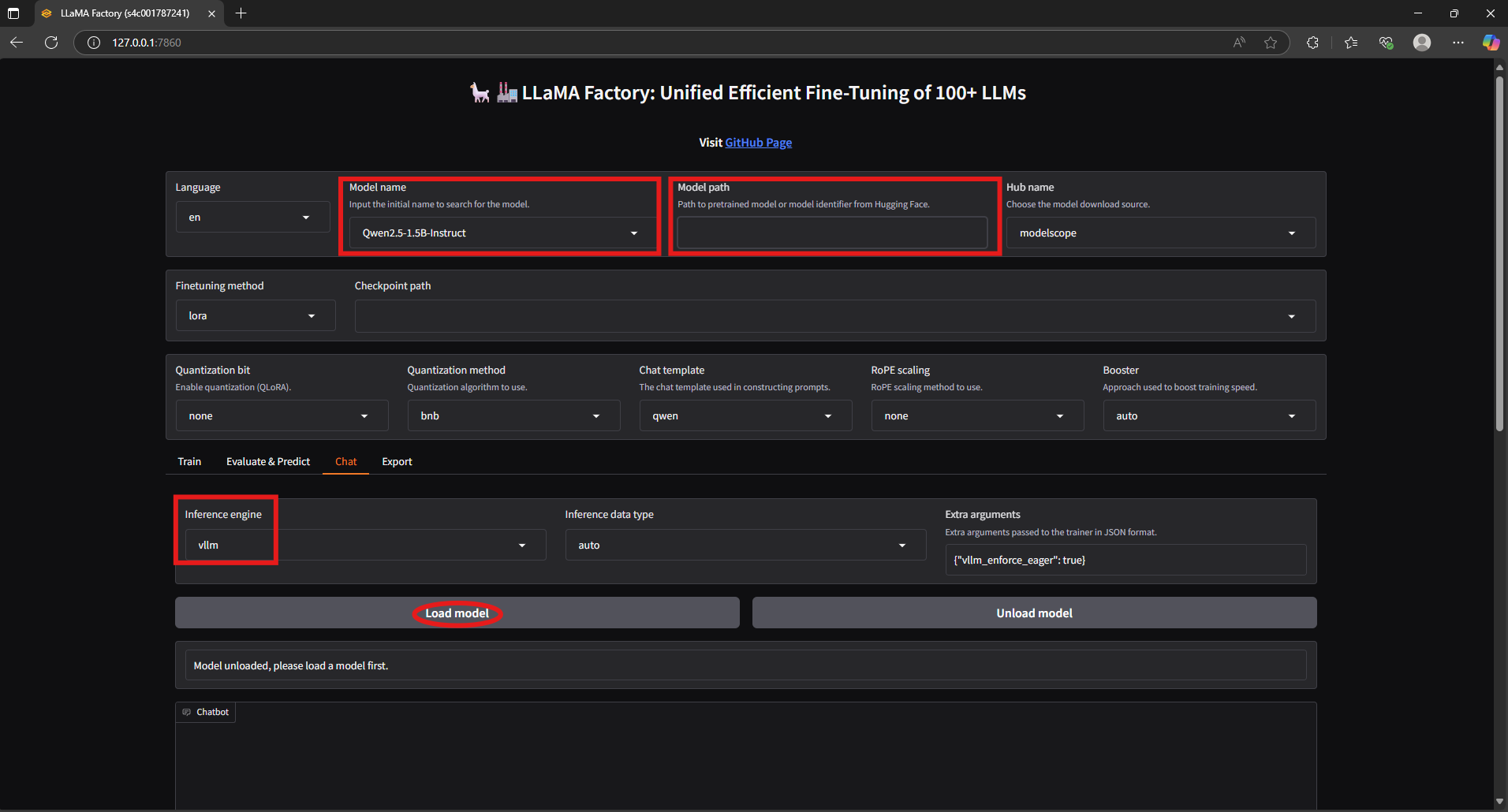

启动成功后在浏览器中打开http://127.0.0.1:7860,可以先选择chat模式测试大模型是否可以成功加载。

模型的地址就是刚才下载保存的地址,注意模型名称要和地址下的名称所对应,这里我选的是vllm部署,点击加载模型即可向大模型提问。

四、微调大模型

由此便成功实现了直观的交互式的大模型微调,通过选择不同的模型、微调模式、数据集,设置不同的训练参数进行微调,最终还可以导出微调后合并的模型。各种参数模式的设置大家加油探索吧!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)