Agent 核心逻辑设计:从目标拆解到记忆进化的实战探索

随着Dify等一系列高效的Agent构建组件的发布,Agent设计门槛组件降低。本文针对Agent核心逻辑设计提供一定参考思路,内容仅供参考。

随着Dify等一系列高效的Agent构建组件的发布,Agent设计门槛逐渐降低。本文针对Agent核心逻辑设计提供一定参考思路,内容仅供参考。

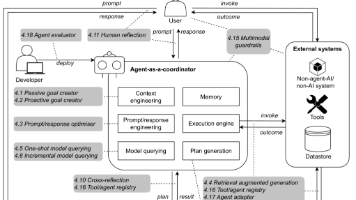

首先文主理解设计Agent的核心逻辑本质是构建一套“目标驱动-环境响应-经验进化”的闭环系统。其核心挑战在于让Agent既能理解复杂目标,又能灵活适配动态环境,同时通过记忆沉淀持续优化行为。以下从核心模块设计、实践心得、问题解决三个维度展开分享:

一、核心逻辑模块设计:从“目标”到“行动”的拆解与落地

1. 目标拆解:把“模糊需求”转化为“可执行步骤”

目标拆解是Agent的“大脑规划层”,核心是将用户的高层目标(如“策划一场3天的家庭露营”)拆解为多层级的子任务,直到每个子任务可被具体工具/动作执行。

-

拆解策略:

- 基于“因果链+依赖关系”拆解:比如“露营策划”可先拆分为“选址→装备采购→行程安排”,其中“装备采购”依赖“选址的地形(是否需要防潮垫)”;

- 结合LLM的“语义理解+逻辑推理”:复杂目标(如“写一篇对比A、B两款手机的测评”)需先拆解为“收集参数→用户评价分析→核心差异提炼→结论总结”,LLM擅长通过prompt引导(如“用MECE原则拆解任务”)生成结构化子任务;

- 动态调整颗粒度:简单目标(如“查明天北京天气”)直接拆分为“调用天气API”;复杂目标(如“组织一场跨部门会议”)需拆到“确认参会人时间→预订会议室→发送议程”等细粒度步骤。

-

关键心得:

- 避免“过度拆解”:子任务太细会导致Agent陷入“步骤冗余”(比如订会议室拆成“打开预订系统→输入日期→选择楼层”,实际可合并为“调用会议室预订工具并传入参数”);

- 预留“回溯接口”:当子任务执行失败(如“选址时发现营地关闭”),需能返回上一层重新拆解(如“更换备选营地”),而非机械执行。

2. 环境交互:让Agent“看懂世界、做对动作”

环境交互是Agent的“手脚执行层”,负责连接内部逻辑与外部世界(工具、用户、物理环境等),核心是“精准感知→有效动作→反馈处理”。

-

交互设计:

- 统一接口抽象:将工具(API、数据库、物理设备)封装为“动作函数”,定义输入(参数)、输出(结果格式)、异常(如“API超时”),让Agent无需关注工具细节(如调用“打车API”只需传入“起点、终点”,无需知道底层是滴滴还是高德);

- 多模态感知:除了文本交互,还需处理用户的语音、图片等输入(如用户发一张露营地照片,Agent需调用图像识别工具判断地形);

- 反馈闭环:每次交互后必须获取“结果是否符合预期”的信号(如调用“购票API”后检查“是否成功出票”),作为下一步决策的依据。

-

关键心得:

- 优先处理“确定性反馈”:工具返回的结构化结果(如“会议预订成功”)比模糊反馈(如用户说“差不多吧”)更易处理,需设计追问机制(如“您觉得时间是否需要调整?”)将模糊反馈转化为明确信号;

- 容错机制前置:对高概率失败的动作(如“支付”“预订”),提前设计重试策略(如“API超时后重试2次,失败则切换备用工具”)。

3. 记忆机制:让Agent“记住经验、避免重复犯错”

记忆是Agent的“经验沉淀层”,决定了其是否能从历史中学习。需区分“短期记忆”和“长期记忆”:

-

短期记忆(Working Memory):

- 存储当前任务上下文(如“正在处理露营策划,已完成选址”)、临时信息(如用户刚说的“孩子怕蚊子”),通常用“滑动窗口”管理(只保留最近N轮交互),避免信息过载;

- 核心作用:保证任务连贯性(如“跨天任务”不会忘记之前的子目标)。

-

长期记忆(Long-term Memory):

- 存储可复用的经验(如“上次露营发现XX营地蚊虫多,需提醒带驱蚊液”)、用户偏好(如“用户习惯订带早餐的酒店”);

- 技术实现:用向量数据库(如Milvus)存储记忆片段,通过语义检索(如“查找类似露营地的注意事项”)快速召回相关经验。

-

关键心得:

- 记忆需“轻量化”:长期记忆不是存储所有历史,而是提炼“结构化经验”(如“若用户带儿童,露营需包含‘儿童游乐设施’筛选条件”),否则检索效率会极低;

- 记忆需“可更新”:当环境变化(如“某营地重新开放”),需能覆盖旧记忆,避免Agent基于过时信息决策。

二、开发中的典型问题与解决方案

1. Agent“不听话”:目标理解与用户预期错位

表现:用户说“订一个性价比高的酒店”,Agent订了五星级(可能误解“性价比”为“高端低价”);或用户隐含需求未被捕捉(如“周末去上海”实际想顺便看展览,但Agent只订了车票)。

-

原因:

- 目标解析时忽略“隐性约束”(用户未明说但默认的条件,如“性价比”可能指“300元内+评分4.5以上”);

- 缺乏“多轮对齐”机制,直接基于初步理解拆解任务。

-

解决思路:

- 强化“意图澄清”:对模糊目标(如“找个好餐厅”),通过预设模板追问(“请问偏好中餐还是西餐?人均预算大概多少?”);

- 引入“用户画像”:长期记忆中存储用户历史偏好(如“用户过去订酒店优先选连锁品牌”),作为目标解析的默认约束;

- 用“示例引导”优化LLM:在prompt中加入“成功案例”(如“用户说‘性价比高’时,优先推荐评分>4.5且价格低于当地均值20%的选项”)。

2. 决策失误:步骤逻辑或环境判断错误

表现:规划行程时未考虑“故宫周一闭馆”导致冲突;或调用工具时参数错误(如“查上海天气”错传“北京”参数)。

-

原因:

- 目标拆解时“知识缺失”(如缺乏“景点开放时间”这类常识);

- 长链条决策中“遗忘中间约束”(如步骤1确定“露营地在山区”,步骤3采购装备时忘记“需防暴雨”);

- 工具调用时“参数校验缺失”(如未检查日期格式是否正确)。

-

解决思路:

- 引入“知识校验层”:在关键步骤执行前,调用外部知识库(如维基百科、本地常识库)验证(如“拆解‘故宫参观’子任务时,先查开放时间”);

- 强化“状态跟踪”:用结构化变量(如任务状态树)记录每个子任务的约束条件(如“露营地=山区→装备需包含防雨帐篷”),决策时强制校验;

- 工具调用“二次确认”:对高影响动作(如“转账”“订票”),执行前输出“待执行动作+参数”让用户确认,避免低级错误。

三、开发经验总结:从“能用”到“好用”的迭代思路

- 先跑通闭环,再优化细节:初期用“硬编码规则+基础LLM”实现核心流程(目标拆解→工具调用→结果返回),验证闭环可行性后,再逐步加入记忆机制、动态拆解等复杂功能;

- 场景化测试优于通用测试:Agent的表现高度依赖场景(如办公场景vs生活场景),需针对具体场景设计测试用例(如“会议策划”需测试“跨时区参会人协调”“临时改期”等边缘情况);

- 用户反馈是最佳训练数据:将用户对Agent决策的评价(如“这个酒店选得不好”)转化为记忆更新信号(如“用户不喜欢XX区域的酒店”),形成“用户反馈→记忆优化→决策升级”的正向循环。

Agent的核心竞争力不在于单模块的复杂度,而在于“目标-环境-记忆”三者的协同效率。未来的创新方向可能在于:用强化学习优化目标拆解策略(让Agent从成功/失败案例中自动学习拆解逻辑)、结合具身智能(物理世界感知)扩展环境交互维度、通过记忆压缩技术提升长程经验的复用效率——这些都需要在实践中持续打磨“精准理解、灵活执行、持续进化”的平衡。

希望可以对您后续工作中Agent相关内容设计思路提供帮助。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)