LKGE-AAAI-2023

本文提出了一种终身知识图谱嵌入模型LKGE,用于处理不断增长的知识图谱。针对现有KG嵌入模型仅适用于静态图谱的局限性,该研究设计了遮蔽KG自动编码器进行嵌入学习与更新,通过嵌入迁移策略实现知识传递,并采用嵌入正则化防止灾难性遗忘。实验基于四种不同增长模式的数据集,结果表明LKGE在链接预测准确率、知识迁移能力和学习效率方面均优于现有方法。该模型能够有效适应新知识同时保留旧知识,为动态知识图谱应用提

文章目录

- 本文是对原论文学习过程中的中文翻译,仅用于学术交流与科普分享,无任何商业目的。

- 翻译已尽力忠实原文,但受限于译者水平,可能存在偏差;术语或公式若有疑义,请以原文为准。

- 若原作者、期刊或版权方提出异议,译者将在收到通知后 24 小时内删除本文并致歉。

- 欢迎读者引用原文,并请注明出处

Lifelong Embedding Learning and Transfer for Growing Knowledge Graphs

Yuanning Cui, Yuxin Wang, Zequn Sun, Wenqiang Liu, Yiqiao Jiang, Kexin Han, Wei Hu

摘要

现有的知识图(KG)嵌入模型主要关注静态KG。然而,现实世界的KG并非保持静态,而是随着KG应用的发展而演化和增长。因此,新的事实以及之前未见过的实体和关系不断出现,这需要一个能够通过增长快速学习和迁移新知识的嵌入模型。基于这一动机,我们在本文中深入研究KG嵌入的一个不断扩展的领域,即终身KG嵌入。我们考虑在不从零开始学习嵌入的情况下,在KG增长快照上实现知识迁移和学习保持。所提出的模型包括一个用于嵌入学习和更新的遮蔽KG自动编码器,以及一个嵌入迁移策略,将学到的知识注入新的实体和关系嵌入中,还有一个嵌入正则化方法来避免灾难性遗忘。为了研究KG增长不同方面的影响,我们构建了四个数据集来评估终身KG嵌入的性能。实验结果表明,所提出的模型在归纳和终身嵌入基线方面优于现有技术水平。

1 引言

许多知识驱动型应用建立在知识图谱(KGs)之上,这些图谱存储了大量关于现实世界的结构化事实。在知识图谱构建和应用的整个生命周期中,新的事实、未知的实体和未知的关联持续地以规律性的方式涌现进入KG中。因此,现实世界的知识图谱很少是静态的,而是随着发展不断演化和增长。图1展示了从Wikidata中摘取的一个示例,它显示了知识图谱随着持续知识提取的增长。然而,知识图谱嵌入,作为下游应用的关键任务,多年来主要关注静态知识图谱。每次从头开始学习是低效的,并且浪费了之前获取的知识,而仅仅微调新事实会很快破坏之前获取的知识。因此,本文提出了对增长中的知识图谱进行终身嵌入学习和迁移的研究,目标是学习新的事实同时保留旧的知识,而无需从头开始重新训练。

本文的核心思想来源于人类学习过程。人类是典型的终身学习者,知识迁移和保持是终身学习最重要的方面。特别是,人类能够不断地在学习到新的事实后学习新知识,并利用之前学到的知识帮助新知识的学习(知识学习和迁移),同时更新旧知识,保留有用的知识(知识更新和保持)。受到这一启发,我们试图构建一个终身知识图谱嵌入模型,即LKGE,它能够高效地为增长中的知识图谱学习、迁移和保持知识。现有的相关工作,如归纳知识图谱嵌入(Hamaguchi et al. 2017; Wang et al. 2019b),主要关注知识迁移,忽略了新知识的学习和旧知识的更新。

提出的终身知识图谱嵌入任务面临两大挑战。首先,如何平衡新知识学习和旧知识迁移?从头开始学习新实体和关系的嵌入无法利用之前学到的知识,而归纳地生成它们的嵌入忽略了新快照中的新知识。其次,如何更新旧知识同时保持有用知识?学习关于旧实体的新事实通常需要更新之前学到的嵌入,这可能会对旧模型造成损害。这是因为更新旧实体的嵌入会影响许多相关旧实体的嵌入。这会导致灾难性遗忘问题,从而影响基于旧知识图谱快照的应用。

为了解决上述挑战,我们在LKGE模型中提出了三种解决方案。首先,作为新知识学习和旧知识更新的基础嵌入模型,我们设计了一个遮蔽KG自动编码器,用于遮蔽并重构新事实中的实体或关系。它在局部相关的旧实体和新实体之间建立连接,充当知识转移的桥梁。其次,为了帮助新知识的学习,我们提出了一种知识嵌入迁移策略,该策略使用之前学到的知识来初始化新实体和关系的嵌入。这些嵌入被KG自动编码器用来学习新事实。第三,为了避免旧知识更新中的灾难性遗忘,我们提出了嵌入正则化,以平衡新事实的学习和旧嵌入的更新。

我们构建了四个数据集来评估终身KG嵌入的性能,包括以实体为中心、以关系为中心、以事实为中心和混合增长的数据集。每个数据集检查KG增长的不同的方面。相比之下,现有的数据集(Hamaguchi等人2017年;Kou等人2020年;Daruna等人2021年)都假设KG以理想的方式增长,每个新快照中的新实体或事实都是平衡的。在我们的实验中,我们在四个数据集上比较了所提模型的链接预测准确性、知识迁移能力和学习效率与基线的表现。结果显示,提出的LKGE不仅在四个数据集上取得了最佳性能,而且具有最佳的前向知识迁移能力和学习效率。本文的主要贡献概括如下:

- 我们研究了终身KG嵌入的学习和迁移。这是一项实际任务,因为现实世界的KG不断演化和增长,这要求嵌入模型能够处理知识的增长。

- 我们提出了一个新颖的终身学习模型,LKGE。它包括一个作为嵌入学习和更新的基础的遮蔽知识图谱自动编码器,一个用于知识迁移的嵌入转移策略,以及一个嵌入正则化以防止知识更新中的灾难性遗忘。

- 我们在四个新的数据集上进行了广泛的实验。结果表明,LKGE在各种最先进的模型中显示出其有效性和效率。

2 相关工作

2.1 知识图谱嵌入

知识图谱嵌入旨在将KGs的符号表示编码到向量空间中,以促进KGs在下游任务中的应用。大多数现有的KG嵌入模型关注于静态图,并且不能在增长的知识图谱上持续学习新知识。

为了嵌入未见实体,归纳KG嵌入模型通过聚合前一个KG快照中的现有邻居来表示一个实体。MEAN使用图卷积网络(GCN)进行邻居聚合。当一个未见实体出现时,GCN会聚合其之前看到的邻近实体来生成嵌入。LAN采用注意力机制来聚合不同的邻居。由于MEAN和LAN依赖实体邻居进行嵌入学习,它们无法处理在之前的快照中没有邻居的新实体。此外,归纳KG嵌入忽略了学习关于新实体的事实。

我们的工作也与动态知识图谱嵌入相关。pu-TransE在添加事实时会训练几个新模型。DKGE学习实体和关系的上下文嵌入,这些嵌入可以随着知识图谱的增长而自动更新。它们都需要对旧事实进行部分重训练,但我们的模型不需要。此外,一些基于子图的模型,如GraIL、INDIGO和TACT,也可以使用实体独立特征和子图聚合来表示未见实体。它们的子图构建过程耗时较多,因此仅适用于小型知识图谱。为了在大规模知识图谱上运行,NBFNet提出了一种基于Bellman-Ford算法的快速节点对嵌入模型,而NodePiece使用标记的锚节点和关系路径来表示新实体。然而,它们没有考虑学习新知识,也不能支持新关系。

2.2 终身学习

终身学习旨在迅速解决新问题,同时不会灾难性地遗忘之前获得的知识。终身学习模型通常分为三类。(i) 动态架构模型 扩展网络以学习新任务并避免遗忘已获得的知识。(ii) 基于正则化的模型 捕获模型参数对旧任务的重要性并限制重要参数的更新。(iii) 基于复习的模型 记住一些旧任务的数据,并在学习新知识时重放它们。

很少有终身学习模型关注知识图谱嵌入。DiCGRL (Kou et al. 2020) 是一种基于解耦的终身图嵌入模型。它将节点嵌入分为不同的组成部分,并重放相关的历史事实以避免灾难性遗忘。该研究 (Daruna et al. 2021) 将类增量学习模型与 TransE 结合用于连续知识图谱嵌入。然而,它并没有提出一个特定的终身知识图谱嵌入模型。

3 终身知识图谱嵌入

3.1 基本概念

Growing KG. 知识图谱的增长过程产生了一系列快照,即 G = { S 1 , S 2 , … , S t } \mathcal{G} = \left\{ {{\mathcal{S}}_{1},{\mathcal{S}}_{2},\ldots ,{\mathcal{S}}_{t}}\right\} G={S1,S2,…,St} 。每个快照 S i {\mathcal{S}}_{i} Si 被定义为一个三元组 ( T i , E i , R i ) \left( {{\mathcal{T}}_{i},{\mathcal{E}}_{i},{\mathcal{R}}_{i}}\right) (Ti,Ei,Ri) ,其中 T i , E i {\mathcal{T}}_{i},{\mathcal{E}}_{i} Ti,Ei 和 R i {\mathcal{R}}_{i} Ri 分别表示事实、实体和关系集合。我们有 T i ⊆ {\mathcal{T}}_{i} \subseteq Ti⊆ T i + 1 , E i ⊆ E i + 1 {\mathcal{T}}_{i + 1},{\mathcal{E}}_{i} \subseteq {\mathcal{E}}_{i + 1} Ti+1,Ei⊆Ei+1 和 R i ⊆ R i + 1 {\mathcal{R}}_{i} \subseteq {\mathcal{R}}_{i + 1} Ri⊆Ri+1 。我们使用 T Δ i = T i − T i − 1 {\mathcal{T}}_{\Delta i} = {\mathcal{T}}_{i} - {\mathcal{T}}_{i - 1} TΔi=Ti−Ti−1 、 E Δ i = E i − E i − 1 {\mathcal{E}}_{\Delta i} = {\mathcal{E}}_{i} - {\mathcal{E}}_{i - 1} EΔi=Ei−Ei−1 和 R Δ i = R i − R i − 1 {\mathcal{R}}_{\Delta i} = {\mathcal{R}}_{i} - {\mathcal{R}}_{i - 1} RΔi=Ri−Ri−1 分别表示新的事实、实体和关系。每个事实的形式为 ( s , r , o ) ∈ T i \left( {s,r,o}\right) \in {\mathcal{T}}_{i} (s,r,o)∈Ti ,其中 s , o ∈ E i s,o \in {\mathcal{E}}_{i} s,o∈Ei 分别是主体和客体实体, r ∈ R i r \in {\mathcal{R}}_{i} r∈Ri 是它们的关系。

终身知识图谱嵌入。知识图谱嵌入旨在将实体和关系的符号表示编码到向量空间中,并使用向量操作捕捉知识图谱的语义。对于一个增长的知识图谱,终身知识图谱嵌入模型不断学习表示快照序列 G = { S 1 , S 2 , … , S t } \mathcal{G} = \left\{ {{\mathcal{S}}_{1},{\mathcal{S}}_{2},\ldots ,{\mathcal{S}}_{t}}\right\} G={S1,S2,…,St} 。当一个新的事实集合 T Δ i {\mathcal{T}}_{\Delta i} TΔi 出现时,当前的知识图谱嵌入模型 M i − 1 {\mathcal{M}}_{i - 1} Mi−1 需要更新以适应新的事实,并学习新实体 E Δ i {\mathcal{E}}_{\Delta i} EΔi 和新关系 R Δ i {\mathcal{R}}_{\Delta i} RΔi 的嵌入。得到的模型表示为 M i {\mathcal{M}}_{i} Mi 。

终身链接预测。链接预测任务要求知识图谱嵌入模型预测不完整事实中的缺失主体或对象实体,例如 ( s , r , ? ) \left( {s,r,?}\right) (s,r,?) 或 ( ? , r , o ) \left( {?,r,o}\right) (?,r,o) 。对于每个时间快照 S i {\mathcal{S}}_{i} Si ,新的事实集 T Δ i {\mathcal{T}}_{\Delta i} TΔi 被分为训练集 D i {\mathcal{D}}_{i} Di 、验证集 V i {\mathcal{V}}_{i} Vi 和测试集 Q i {\mathcal{Q}}_{i} Qi 。在终身学习设置中,模型需要依次学习训练数据集 D 1 , D 2 , … , D t {\mathcal{D}}_{1},{\mathcal{D}}_{2},\ldots ,{\mathcal{D}}_{t} D1,D2,…,Dt 。在学习完 D i {\mathcal{D}}_{i} Di 之后,模型在累积的测试数据 ∪ j = 1 i Q j { \cup }_{j = 1}^{i}{\mathcal{Q}}_{j} ∪j=1iQj 上进行评估,以评估整体学习性能。学习完 D i {\mathcal{D}}_{i} Di 之后, D i , V i {\mathcal{D}}_{i},{\mathcal{V}}_{i} Di,Vi 将不再用于后续的学习。请注意,终身知识图谱嵌入的目标是提高所有时间快照的整体性能,这要求知识图谱嵌入模型持续学习新知识并保留已学到的知识。

3.2 模型概述

我们模型 LKGE 的概述如图 2 所示。它能够在不重新训练之前见过的数据的情况下,连续地学习一系列知识图谱快照中的知识。基础是一个遮蔽的知识图谱自动编码器,它能够从遮蔽的相关子图中重建实体和关系嵌入。为了使知识从旧的时间快照转移到新的时间快照,我们提出了嵌入迁移方法,将学到的知识注入未见的实体和关系中,然后迭代优化模型以适应新的事实。我们还提出了一个轻量级正则化方法来保留旧知识。

3.3 遮蔽知识图谱自动编码器

在终身知识图谱嵌入学习中,新的事实,例如 T Δ i {\mathcal{T}}_{\Delta i} TΔi,带来了新的实体 E Δ i {\mathcal{E}}_{\Delta i} EΔi 和新的关系 R Δ i {\mathcal{R}}_{\Delta i} RΔi。它还会涉及来自 E i − 1 {\mathcal{E}}_{i - 1} Ei−1 的一些旧实体,以及来自 R i − 1 {\mathcal{R}}_{i - 1} Ri−1 的旧关系。因此,一个新实体可能与新实体和旧实体(称为新知识)相连接。涉及的旧实体也会接收到更多的事实,因此它们之前学到的嵌入(称为旧知识)需要更新以适应新的事实。因此,终身学习的基准知识图谱嵌入模型应能够捕捉新知识并更新旧知识。为此,我们提出了一种由最近自我监督学习成功(Hou et al. 2022)启发的遮蔽知识图谱自动编码器。关键思想是基于实体的遮蔽子图重构其嵌入,这个子图可能包括其他新实体和一些旧实体。具体来说,我们使用实体或关系的一阶子图来重构其嵌入 x ‾ i {\overline{\mathbf{x}}}_{i} xi:

x ‾ i = MAE ( ∪ j = 1 i N j ( x ) ) , (1) {\overline{\mathbf{x}}}_{i} = \operatorname{MAE}\left( {{ \cup }_{j = 1}^{i}{\mathcal{N}}_{j}\left( x\right) }\right) , \tag{1} xi=MAE(∪j=1iNj(x)),(1)

其中 x x x 表示实体或关系, N j ⊆ D j {\mathcal{N}}_{j} \subseteq {\mathcal{D}}_{j} Nj⊆Dj 表示 x x x 在第 j j j 个快照中涉及的事实。MAE( ) 是一个编码器,用于表示输入子图。我们的知识图谱编码器的目标是使实体或关系嵌入与以下重构表示对齐:

L M A E = ∑ e ∈ E i ∥ e i − e ‾ i ∥ 2 2 + ∑ r ∈ R i ∥ r i − r ‾ i ∥ 2 2 . (2) {\mathcal{L}}_{\mathrm{{MAE}}} = \mathop{\sum }\limits_{{e \in {\mathcal{E}}_{i}}}{\begin{Vmatrix}{\mathbf{e}}_{i} - {\overline{\mathbf{e}}}_{i}\end{Vmatrix}}_{2}^{2} + \mathop{\sum }\limits_{{r \in {\mathcal{R}}_{i}}}{\begin{Vmatrix}{\mathbf{r}}_{i} - {\overline{\mathbf{r}}}_{i}\end{Vmatrix}}_{2}^{2}. \tag{2} LMAE=e∈Ei∑ ei−ei 22+r∈Ri∑ ri−ri 22.(2)

关键问题是如何为终身学习设计一个有效且高效的编码器。GCN和Transformer是两种常见的编码器选择。这两种编码器都会引入额外的模型参数(例如,权重矩阵)。在我们的终身学习设置中,编码器需要更新以适应新的事实或子图。在这种情况下,一旦GCN或Transformer被更新,改变后的模型参数将会影响所有旧实体的嵌入生成(而不仅仅是新事实中涉及的旧实体),增加了灾难性遗忘之前快照的风险。为了避免这个问题,我们使用实体和关系嵌入转换函数作为编码器,这不会引入额外的参数。我们借鉴了TransE 的思想,将关系嵌入解释为主语和宾语实体嵌入之间的转换向量,即 s + r ≈ o \mathbf{s} + \mathbf{r} \approx \mathbf{o} s+r≈o ,其中 s , r \mathbf{s},\mathbf{r} s,r 、 o \mathbf{o} o 分别表示主语实体、关系和宾语实体的嵌入。基于这一点,我们可以推导出两个用于实体和关系嵌入的转换函数。事实(s,r,o)的主语实体可以表示为 f sub ( r , o ) = o − r {f}_{\text{sub }}\left( {\mathbf{r},\mathbf{o}}\right) = \mathbf{o} - \mathbf{r} fsub (r,o)=o−r ,关系嵌入是 f rel ( s , o ) = o − s {f}_{\text{rel }}\left( {\mathbf{s},\mathbf{o}}\right) = \mathbf{o} - \mathbf{s} frel (s,o)=o−s 。我们可以将编码器定义为

e ‾ i = ∑ j = 1 i ∑ ( s , r , o ) ∈ N j ( e ) f s u b ( r i , o i ) ∑ j = 1 i ∣ N j ( e ) ∣ , (3) {\overline{\mathbf{e}}}_{i} = \frac{\mathop{\sum }\limits_{{j = 1}}^{i}\mathop{\sum }\limits_{{\left( {s,r,o}\right) \in {\mathcal{N}}_{j}\left( e\right) }}{f}_{\mathrm{{sub}}}\left( {{\mathbf{r}}_{i},{\mathbf{o}}_{i}}\right) }{\mathop{\sum }\limits_{{j = 1}}^{i}\left| {{\mathcal{N}}_{j}\left( e\right) }\right| }, \tag{3} ei=j=1∑i∣Nj(e)∣j=1∑i(s,r,o)∈Nj(e)∑fsub(ri,oi),(3)

r ‾ i = ∑ j = 1 i ∑ ( s , r , o ) ∈ N j ( r ) f r e l ( s i , o i ) ∑ j = 1 i ∣ N j ( r ) ∣ , (4) {\overline{\mathbf{r}}}_{i} = \frac{\mathop{\sum }\limits_{{j = 1}}^{i}\mathop{\sum }\limits_{{\left( {s,r,o}\right) \in {\mathcal{N}}_{j}\left( r\right) }}{f}_{\mathrm{{rel}}}\left( {{\mathbf{s}}_{i},{\mathbf{o}}_{i}}\right) }{\mathop{\sum }\limits_{{j = 1}}^{i}\left| {{\mathcal{N}}_{j}\left( r\right) }\right| }, \tag{4} ri=j=1∑i∣Nj(r)∣j=1∑i(s,r,o)∈Nj(r)∑frel(si,oi),(4)

其中 s i , r i , o i {\mathbf{s}}_{i},{\mathbf{r}}_{i},{\mathbf{o}}_{i} si,ri,oi 是在训练期间对 D i . N j ( x ) ⊆ D j {\mathcal{D}}_{i}.{\mathcal{N}}_{j}\left( x\right) \subseteq {\mathcal{D}}_{j} Di.Nj(x)⊆Dj 上的 s , r , o s,r,o s,r,o 的嵌入, D i . N j ( x ) ⊆ D j {\mathcal{D}}_{i}.{\mathcal{N}}_{j}\left( x\right) \subseteq {\mathcal{D}}_{j} Di.Nj(x)⊆Dj 是包含 x x x 的事实集合。

在终身学习中,模型从快照序列中学习。公式(3)和(4)需要来自第一个 i i i 快照的训练样本,这与终身学习不符。为了减少对学习数据的依赖,我们使用 e i − 1 {\mathbf{e}}_{i - 1} ei−1 和 r i − 1 {\mathbf{r}}_{i - 1} ri−1 作为 e e e 和 r r r 在第一个 i − 1 i - 1 i−1 快照中的近似平均嵌入,分别重写编码器为

e ‾ i ≈ ∑ j = 1 i − 1 ∣ N j ( e ) ∣ e i − 1 + ∑ ( s , r , o ) ∈ N i ( e ) f s u b ( r i , o i ) ∑ j = 1 i − 1 ∣ N j ( e ) ∣ + ∣ N i ( e ) ∣ , (5) {\overline{\mathbf{e}}}_{i} \approx \frac{\mathop{\sum }\limits_{{j = 1}}^{{i - 1}}\left| {{\mathcal{N}}_{j}\left( e\right) }\right| {\mathbf{e}}_{i - 1} + \mathop{\sum }\limits_{{\left( {s,r,o}\right) \in {\mathcal{N}}_{i}\left( e\right) }}{f}_{\mathrm{{sub}}}\left( {{\mathbf{r}}_{i},{\mathbf{o}}_{i}}\right) }{\mathop{\sum }\limits_{{j = 1}}^{{i - 1}}\left| {{\mathcal{N}}_{j}\left( e\right) }\right| + \left| {{\mathcal{N}}_{i}\left( e\right) }\right| }, \tag{5} ei≈j=1∑i−1∣Nj(e)∣+∣Ni(e)∣j=1∑i−1∣Nj(e)∣ei−1+(s,r,o)∈Ni(e)∑fsub(ri,oi),(5)

r ‾ i ≈ ∑ j = 1 i − 1 ∣ N j ( r ) ∣ r i − 1 + ∑ ( s , r , o ) ∈ N i ( r ) f r e l ( s i , o i ) ∑ j = 1 i − 1 ∣ N j ( r ) ∣ + ∣ N i ( r ) ∣ . (6) {\overline{\mathbf{r}}}_{i} \approx \frac{\mathop{\sum }\limits_{{j = 1}}^{{i - 1}}\left| {{\mathcal{N}}_{j}\left( r\right) }\right| {\mathbf{r}}_{i - 1} + \mathop{\sum }\limits_{{\left( {s,r,o}\right) \in {\mathcal{N}}_{i}\left( r\right) }}{f}_{\mathrm{{rel}}}\left( {{\mathbf{s}}_{i},{\mathbf{o}}_{i}}\right) }{\mathop{\sum }\limits_{{j = 1}}^{{i - 1}}\left| {{\mathcal{N}}_{j}\left( r\right) }\right| + \left| {{\mathcal{N}}_{i}\left( r\right) }\right| }. \tag{6} ri≈j=1∑i−1∣Nj(r)∣+∣Ni(r)∣j=1∑i−1∣Nj(r)∣ri−1+(s,r,o)∈Ni(r)∑frel(si,oi).(6)

编码器使用涉及旧实体和新实体及关系的知识进行嵌入重建,并为知识迁移建立桥梁。

对于每个快照,为了从新数据中学习知识并更新学习到的参数,我们利用 TransE(Bordes et al. 2013)来训练嵌入模型:

L new = ∑ ( s , r , o ) ∈ D i max ( 0 , γ + f ( s , r , o ) − f ( s ′ , r , o ′ ) ) , (7) {\mathcal{L}}_{\text{new }} = \mathop{\sum }\limits_{{\left( {s,r,o}\right) \in {\mathcal{D}}_{i}}}\max \left( {0,\gamma + f\left( {\mathbf{s},\mathbf{r},\mathbf{o}}\right) - f\left( {{\mathbf{s}}^{\prime },\mathbf{r},{\mathbf{o}}^{\prime }}\right) }\right) , \tag{7} Lnew =(s,r,o)∈Di∑max(0,γ+f(s,r,o)−f(s′,r,o′)),(7)

其中 γ \gamma γ 是边距。 ( s ′ , r , o ′ ) \left( {{\mathbf{s}}^{\prime },\mathbf{r},{\mathbf{o}}^{\prime }}\right) (s′,r,o′) 是负事实的嵌入。对于每个正事实,我们随机替换主体或宾体实体为随机实体 e ′ ∈ E i {e}^{\prime } \in {\mathcal{E}}_{i} e′∈Ei 。

3.4 嵌入迁移

在不断增长的知识图谱的生命周期中,存在大量未见的实体,以及随着新事实出现的一些未见关系。为它们学习有效的嵌入是终身知识图谱嵌入学习的一个基本方面。然而,这些未见部分并未包含在任何学习到的快照中,因此仅仅继承学习到的参数无法将获取的知识迁移到它们的嵌入中。为了避免从头开始学习,我们提出了嵌入迁移方法,旨在利用学习到的嵌入来帮助表示未见实体和关系。具体来说,我们通过聚合每个未见实体的事实来初始化其嵌入:

e i = 1 ∣ N i ( e ) ∣ ∑ ( e , r , o ) ∈ N i ( e ) f s u b ( r i − 1 , o i − 1 ) , (8) {\mathbf{e}}_{i} = \frac{1}{\left| {\mathcal{N}}_{i}\left( e\right) \right| }\mathop{\sum }\limits_{{\left( {e,r,o}\right) \in {\mathcal{N}}_{i}\left( e\right) }}{f}_{\mathrm{{sub}}}\left( {{\mathbf{r}}_{i - 1},{\mathbf{o}}_{i - 1}}\right) , \tag{8} ei=∣Ni(e)∣1(e,r,o)∈Ni(e)∑fsub(ri−1,oi−1),(8)

其中 N i ( e ) ⊆ D i {\mathcal{N}}_{i}\left( e\right) \subseteq {\mathcal{D}}_{i} Ni(e)⊆Di 是包含 e e e 的事实集合。对于没有涉及现有实体的共同事实的新实体,我们随机初始化它们的嵌入。我们还使用这种策略来初始化未见关系的嵌入:

r i = 1 ∣ N i ( r ) ∣ ∑ ( s , r , o ) ∈ N i ( r ) f r e l ( s i − 1 , o i − 1 ) , (9) {\mathbf{r}}_{i} = \frac{1}{\left| {\mathcal{N}}_{i}\left( r\right) \right| }\mathop{\sum }\limits_{{\left( {s,r,o}\right) \in {\mathcal{N}}_{i}\left( r\right) }}{f}_{\mathrm{{rel}}}\left( {{\mathbf{s}}_{i - 1},{\mathbf{o}}_{i - 1}}\right) , \tag{9} ri=∣Ni(r)∣1(s,r,o)∈Ni(r)∑frel(si−1,oi−1),(9)

其中 N i ( r ) ⊆ D i {\mathcal{N}}_{i}\left( r\right) \subseteq {\mathcal{D}}_{i} Ni(r)⊆Di 是包含 r r r 的事实集合。

3.5 嵌入正则化

学习新的快照很可能会覆盖从旧快照中学到的知识。为了避免灾难性遗忘,一些正则化方法限制了对于对旧任务重要的参数的更新。正则化方法的损失函数为

L old = ∑ e ∈ E i − 1 ω ( e ) ∥ e i − e i − 1 ∥ 2 2 + ∑ r ∈ R i − 1 ω ( r ) ∥ r i − r i − 1 ∥ 2 2 , (10) {\mathcal{L}}_{\text{old }} = \mathop{\sum }\limits_{{e \in {\mathcal{E}}_{i - 1}}}\omega \left( e\right) {\begin{Vmatrix}{\mathbf{e}}_{i} - {\mathbf{e}}_{i - 1}\end{Vmatrix}}_{2}^{2} + \mathop{\sum }\limits_{{r \in {\mathcal{R}}_{i - 1}}}\omega \left( r\right) {\begin{Vmatrix}{\mathbf{r}}_{i} - {\mathbf{r}}_{i - 1}\end{Vmatrix}}_{2}^{2}, \tag{10} Lold =e∈Ei−1∑ω(e) ei−ei−1 22+r∈Ri−1∑ω(r) ri−ri−1 22,(10)

其中 ω ( x ) \omega \left( x\right) ω(x) 是 x x x 的正则化权重。

传统的基于正则化的分类任务方法,如(Kirkpatrick等人,2017),基于训练过程中的梯度或参数变化,以高昂的代价建模每个参数的重要性。这个问题对于具有大量嵌入参数(即实体和关系嵌入)的知识图谱嵌入模型更为严重。为了解决这个问题,我们提出了一种轻量级的嵌入正则化方法,该方法通过包含新事实和旧事实的数量来计算每个实体或关系的正则化权重:

ω ( x ) = 1 − ∣ N i ( x ) ∣ ∑ j = 1 i ∣ N j ( x ) ∣ . (11) \omega \left( x\right) = 1 - \frac{\left| {\mathcal{N}}_{i}\left( x\right) \right| }{\mathop{\sum }\limits_{{j = 1}}^{i}\left| {{\mathcal{N}}_{j}\left( x\right) }\right| }. \tag{11} ω(x)=1−j=1∑i∣Nj(x)∣∣Ni(x)∣.(11)

作为一种轻量级技术,它只保留了每个实体或关系涉及的训练事实的总数,并且每个快照只更新一次正则化权重。

3.6 总体学习目标

为了在学习新知识的同时保留已获得的知识,整个终身学习目标 L \mathcal{L} L 定义如下:

L = L new + α L old + β L MAE , (12) \mathcal{L} = {\mathcal{L}}_{\text{new }} + \alpha {\mathcal{L}}_{\text{old }} + \beta {\mathcal{L}}_{\text{MAE }}, \tag{12} L=Lnew +αLold +βLMAE ,(12)

其中 α , β \alpha ,\beta α,β 是用于平衡目标的超参数。

3.7 复杂性分析

与微调相比,所提出的模型需要很少的额外资源。它不会像重演模型那样增加训练样本的大小。除了微调之外,所提出的模型还计算了遮蔽自编码器的损失和嵌入正则化。每次迭代的额外时间复杂度为 O ( ∣ E ∣ + ∣ R ∣ + ∣ D ∣ ) O\left( {\left| \mathcal{E}\right| + \left| \mathcal{R}\right| + \left| \mathcal{D}\right| }\right) O(∣E∣+∣R∣+∣D∣) 。在实践中,我们发现自编码器的损失可以加速学习,其时间消耗接近于微调。微调的空间复杂度为 O ( ( ∣ E ∣ + ∣ R ∣ ) × d ) O\left( {\left( {\left| \mathcal{E}\right| + \left| \mathcal{R}\right| }\right) \times d}\right) O((∣E∣+∣R∣)×d),所提出模型的空间复杂度为 O ( ( ∣ E ∣ + ∣ R ∣ ) × ( d + 1 ) ) O\left( {\left( {\left| \mathcal{E}\right| + \left| \mathcal{R}\right| }\right) \times \left( {d + 1}\right) }\right) O((∣E∣+∣R∣)×(d+1)),其中 d d d 是嵌入的维度。

4 数据集构建

为了模拟知识图谱增长的各种方面,我们基于FB15K-237创建了四个数据集,分别是实体中心、关系中心、事实中心和混合型。我们分别用ENTITY、RELATION、FACT和HYBRID来表示它们。给定一个知识图谱 G = { E , R , T } \mathcal{G} = \{ \mathcal{E},\mathcal{R},\mathcal{T}\} G={E,R,T},我们通过以下步骤构建五个快照:

-

初始化。我们从 T \mathcal{T} T 中随机抽取10个事实,将它们添加到 T 1 {\mathcal{T}}_{1} T1 中进行初始化。这10个事实中的实体和关系分别形成了初始的 E 1 {\mathcal{E}}_{1} E1 和 R 1 {\mathcal{R}}_{1} R1。

-

扩展。为了构建实体(ENTITY)、关系(RELATION)和事实(FACT),我们迭代地采样包含至少一个已见实体的一个事实 E i {\mathcal{E}}_{i} Ei,将其加入 T i {\mathcal{T}}_{i} Ti,并从中提取未见实体和关系以扩展 E i {\mathcal{E}}_{i} Ei 和 R i {\mathcal{R}}_{i} Ri。对于实体(ENTITY),一旦 ∣ E i ∣ ≥ i + 1 5 ∣ E ∣ \left| {\mathcal{E}}_{i}\right| \geq \frac{i + 1}{5}\left| \mathcal{E}\right| ∣Ei∣≥5i+1∣E∣,我们就将所有新的事实 { ( s , r , o ) ∣ s ∈ E i ∧ \{ \left( {s,r,o}\right) \mid s \in {\mathcal{E}}_{i} \land {(s,r,o)∣s∈Ei∧ o ∈ E i } \left. {o \in {\mathcal{E}}_{i}}\right\} o∈Ei} 加入 T i {\mathcal{T}}_{i} Ti,并开始构建下一个快照。同样地,我们构建关系(RELATION)和事实(FACT)。至于混合(HYBRID),我们从 U = E ∪ R ∪ T \mathcal{U} = \mathcal{E} \cup \mathcal{R} \cup \mathcal{T} U=E∪R∪T 中均匀地无放回地采样一个实体、关系或事实以加入 E i {\mathcal{E}}_{i} Ei、 R i {\mathcal{R}}_{i} Ri 和 T i {\mathcal{T}}_{i} Ti。需要注意的是,当采样的事实包含一个未见实体或关系时,我们重新采样一个只包含已见实体和关系的事实来替换它。在每次迭代后,我们以概率 5 ∣ U ∣ \frac{5}{\left| \mathcal{U}\right| } ∣U∣5 终止此快照的扩展。因此,混合(HYBRID)的扩展是不均匀的,使其更加真实和具有挑战性。对于所有数据集,我们将整个知识图谱作为最后一个快照,即 T 5 = T {\mathcal{T}}_{5} = \mathcal{T} T5=T,和 E 5 = E , R 5 = R {\mathcal{E}}_{5} = \mathcal{E},{\mathcal{R}}_{5} = \mathcal{R} E5=E,R5=R。

-

划分。对于每个快照,我们随机地将新的事实集 T Δ i {\mathcal{T}}_{\Delta i} TΔi 划分为训练集 D i {\mathcal{D}}_{i} Di、验证集 V i {\mathcal{V}}_{i} Vi 和测试集 Q i {\mathcal{Q}}_{i} Qi,划分比例为 3 : 1 : 1 3 : 1 : 1 3:1:1。

四个数据集的统计信息如表1所示。

5 实验结果

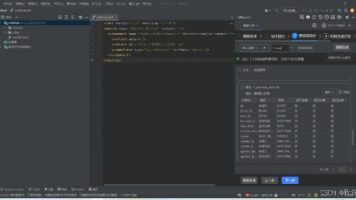

我们进行了关于链接预测准确性、知识迁移能力和学习效率的实验,以验证所提出的模型LKGE。数据集和源代码可在 https://github.com/nju-websoft/LKGE 获取。

5.1 实验设置

竞争对手。我们将我们的模型与12个竞争对手进行了比较,包括(i)三个基线模型:仅快照,重新训练和微调;(ii)两个归纳模型:MEAN(Ham-aguchi等人,2017年)和LAN(Wang等人,2019b);(iii)两个动态架构模型:PNN(Rusu等人,2016年)和CWR(Lomonaco和Maltoni,2017年);(iv)两个基于正则化的模型:SI(Zenke、Poole和Ganguli,2017年)和EWC(Kirkpatrick等人,2017年);以及(v)三个基于复习的模型:GEM(Lopez-Paz和Ranzato,2017年)、EMR(Wang等人,2019a)和DiCGRL(Kou等人,2020年)。

评估指标。遵循惯例,我们在链接预测上进行了实验。给定一个快照 S i {\mathcal{S}}_{i} Si,对于每个测试事实 ( s , r , o ) ∈ Q i \left( {s,r,o}\right) \in {\mathcal{Q}}_{i} (s,r,o)∈Qi,我们构建两个查询 ( s , r , ? ) \left( {s,r,?}\right) (s,r,?) 和 ( ? , r , t ) \left( {?,r,t}\right) (?,r,t)。在评估 Q i {\mathcal{Q}}_{i} Qi 时,我们将 E i {\mathcal{E}}_{i} Ei 中所有已见的实体设置为候选实体。我们选择了七个指标来评估所有模型,包括(i)四个链接预测准确度指标:平均倒数排名(MRR)和Hits@ k k k( k = 1 , 3 , 10 k = 1,3,{10} k=1,3,10 和 H @ k \mathrm{H}@k H@k 对于射击)。我们在最后一个快照上训练的模型 M 5 {\mathcal{M}}_{5} M5 评估所有快照测试集的并集。 (ii)两个关于知识迁移能力的指标:向前迁移(FWT)和向后迁移(BWT)(Lopez-Paz和Ranzato,2017年)。FWT是学习一个任务对未来任务性能的影响,而BWT是学习对以前任务的影响:

F W T = 1 n − 1 ∑ i = 2 n h i − 1 , i , B W T = 1 n − 1 ∑ i = 1 n − 1 ( h n , i − h i , i ) , (13) \mathrm{{FWT}} = \frac{1}{n - 1}\mathop{\sum }\limits_{{i = 2}}^{n}{h}_{i - 1,i},\mathrm{{BWT}} = \frac{1}{n - 1}\mathop{\sum }\limits_{{i = 1}}^{{n - 1}}\left( {{h}_{n,i} - {h}_{i,i}}\right) , \tag{13} FWT=n−11i=2∑nhi−1,i,BWT=n−11i=1∑n−1(hn,i−hi,i),(13)

其中 n n n 是快照的数量, h i , j {h}_{i,j} hi,j 是在模型 M i {\mathcal{M}}_{i} Mi 训练完第 i i i 个快照后的 MRR 分数。分数越高表示性能越好。(iii)时间成本:每个快照上学习的累积时间成本。

实现细节。我们使用 TransE(Bordes et al. 2013)作为基础模型,并修改竞争者以完成我们的任务:

-

仅快照。对于第 i i i 个快照,我们重新初始化并在训练集 D i {\mathcal{D}}_{i} Di 上仅训练一个模型。

-

重新训练。对于第 i i i 个快照,我们重新初始化并在累积的训练数据 ∪ j = 1 i D j { \cup }_{j = 1}^{i}{\mathcal{D}}_{j} ∪j=1iDj 上训练一个模型。

-

微调。对于第 i i i 个快照,模型继承之前快照上训练的模型的学到的参数,并且我们在此基础上对其进行增量训练 D i {\mathcal{D}}_{i} Di。

-

归纳模型。我们在第一个快照上训练每个模型,并通过邻域聚合获得在后续快照中未见实体的嵌入。

-

动态架构模型。对于 PNN,遵循(Daruna et al. 2021)的实现,我们冻结在之前快照上学习的参数并更新新参数。对于 CWR,在 D 1 {\mathcal{D}}_{1} D1 上训练后,我们复制一个模型作为整合模型。对于接下来的第 i i i 个快照,我们重新初始化并在 D i {\mathcal{D}}_{i} Di 上训练一个时态模型,并通过复制新参数或平均旧参数将时态模型合并到整合模型中。

-

正则化模型。由于基础模型参数随着未见实体和关系的出现而增加,我们只使用从上一个快照学习到的参数来计算正则化损失。

演练模型。我们从之前的快照中存储了5000个训练事实,并将它们添加到当前的第 i i i 个快照的训练集中。在学习之后,我们随机替换这些事实的一半,用 D i {\mathcal{D}}_{i} Di 中的事实替代。

为了公平比较,我们首先使用网格搜索调整基模型的超参数:学习率在 {0.0005, 0.0001 , 0.001 } {0.0001},{0.001}\} 0.0001,0.001} } 中选择,批量大小在 { 1024 , 2048 } \{ {1024},{2048}\} {1024,2048} 中选择,嵌入维度在 { 100 , 200 } \{ {100},{200}\} {100,200} 中选择。然后,我们使用相同的基模型进行LKGE和所有竞争者的实验,并调整其他超参数。对于正则化模型,正则化损失的 α \alpha α 在 { 0.01 , 0.1 , 1.0 } \{ {0.01},{0.1},{1.0}\} {0.01,0.1,1.0} 范围内。对于我们的模型,MAE损失的 β \beta β 在 { 0.01 , 0.1 , 1.0 } \{ {0.01},{0.1},{1.0}\} {0.01,0.1,1.0} 范围内。对于所有竞争者,我们使用Adam优化器,并将早停的耐心值设置为3。

5.2 链接预测精度

在表2中,我们对所有模型在数据集上进行了5种子实验,并报告了平均值。结果显示:(i)我们的模型在所有数据集上始终表现出最佳性能。我们的模型在FACT上的一些结果甚至超过了重新训练的效果。这是因为我们的遮蔽知识图谱自动编码器有效地基于新旧嵌入向量提高了信息传播,而嵌入正则化避免了灾难性遗忘。大多数竞争者在ENTITY上表现良好,而我们的模型在这些数据集上显示出稳定且有希望的结果。(ii)在RELATION和HYBRID上,重新训练远远优于大多数基线模型,而在ENTITY和FACT上的差距较小。这是因为知识图谱嵌入模型学习了知识的两个方面:关系模式和实体嵌入。在ENTITY和FACT中,关系模式是稳定的,而在RELATION和HYBRID中,由于未见过的关系,它们的关系模式不断变化。这些现象说明,关系模式的变异性对终身知识图谱嵌入更具挑战性。(iii)归纳模型只训练在第一个快照上,无法将知识迁移到未见过的关系。因此,它们的结果低于其他模型,特别是在具有许多未见关系的RELATION和HYBRID上。(iv)由于学习到的参数没有更新,PNN很好地保留了学习到的知识。但在FACT上,由于一些未见的实体,它缺乏新的可学习参数,性能不佳。CWR平均了新旧模型参数,这在嵌入学习任务上效果不佳。(v)EWC表现良好,因为它可以使用Fisher信息矩阵对学习到的快照中每个参数的重要性进行建模。(vi)与分类任务不同,大多数知识图谱嵌入模型的参数对应于特定的实体,因此训练数据不能分为几种类型,我们不能使用5000个旧样本重放所有实体的学习事实。GEM、EMR和DiCGRL的性能受限。

为了展示LKGE在学习过程中的性能演变,我们使用前一个快照的测试数据来评估为第 i i i 个快照训练的模型 M i {\mathcal{M}}_{i} Mi。MRR结果在图 3 中。LKGE能够在终身学习过程中保持已学习的知识。在一些如实体快照 3 的快照上,知识更新提高了在旧测试数据上的性能,这表明旧知识的更新具有向后知识转移的潜力。

5.3 知识转移能力

为了评估所有模型的知识转移和保持能力,我们在图 4 中报告了MRR结果的FWT和BWT。由于嵌入转移,LKGE的FWT高于所有终身学习竞争对手。即使在关系和混合快照中,KG模式发生变化,LKGE仍然保持良好的FWT能力。MEAN和LAN被设计为将知识向前转移以嵌入新实体。因此,它们在实体上表现良好。然而,由于它们无法更新旧嵌入以适应新快照,在其他数据集上它们的FWT能力受限。

由于学习知识的覆盖,BWT通常是负数。PNN、MEAN和LAN不更新旧参数。它们的BWT得分是“不可用”。CWR的得分较差,显示了平均操作的有害影响。重演模型的得分也不好,因为它们无法存储足够的事实。LKGE获得了良好的BWT得分,因为嵌入正则化可以很好地保持已学习的知识。

5.4 学习效率

我们展示了在 FACT 上的训练时间,因为 FACT 的所有快照都具有相同的训练集大小。图 5 展示了结果。不出所料,重新训练是最耗时的。快照也很昂贵,因为它不能继承之前快照的知识。相比之下,我们的模型效率最高,在最终快照中的优势更为显著。这是因为嵌入迁移可以使用学到的知识来加速新事实的学习。

5.5 消融研究

我们通过设计 LKGE 的四种变体进行消融研究:不进行微调(“w/o fine-tuning”)、不使用自动编码器(“w/o autoencoder”)、不进行嵌入迁移(“w/o embedding transfer”)和不进行正则化(“w/o regularization”)。“w/o fine-tuning” 变体在 D 1 {\mathcal{D}}_{1} D1 上进行训练,并在其他 D i {\mathcal{D}}_{i} Di 上执行嵌入迁移。后三种变体禁用了 LKGE 中的特定组件。结果如表 3 所示。我们发现:(i)尽管禁用了微调,但 “w/o fine-tuning” 只使用第一个快照的知识仍然可以表现良好,表明嵌入迁移可以有效地将学到的知识迁移到未见过的实体和关系。(ii)“w/o autoencoder” 和 “w/o regularization” 都显著下降,显示了遮蔽知识图谱自动编码器和知识保留的效果。(iii)嵌入迁移使模型能够在接近最优参数的起点上进行训练,并稳定嵌入空间。在 ENTITY 上使用嵌入迁移时会出现下降。这是因为 ENTITY 包含大量新实体,需要更多的可塑性而不是稳定性。但在 RELATION 和 HYBRID 上,“w/o embedding transfer” 的结果低于完整模型,表明嵌入迁移可以减少由知识图谱模式变化引起的干扰。在 FACT 上,“w/o embedding transfer” 的结果与完整模型相似。这表明,即使在没有嵌入迁移的情况下,模型仍然可以捕捉知识。

6 结论与未来工作

本文研究了针对不断增长的知识图谱(KGs)的终身嵌入学习。为了更好的知识迁移和保持,我们提出了一种终身知识图谱嵌入模型,该模型包括遮蔽知识图谱自动编码器、嵌入迁移和嵌入正则化。在新数据集上的实验表明,我们的模型在链接预测准确性、知识迁移能力和学习效率方面都有更好的表现。在未来,我们计划研究在长尾和资源匮乏环境下的终身嵌入学习。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)