AI辅导员(完成角色的个性化服务)

本文介绍了基于Dify平台构建AI辅导员聊天助手的完整流程。首先需准备辅导员知识库文档,在Dify创建聊天助手应用并设置专业提示词和开场白。重点是通过父子分段方式创建知识库,选择合适的embedding模型和向量检索方法。完成知识库集成后,经过调试优化即可发布应用,支持API调用或网页嵌入。文中特别强调操作后需"发布更新"保存设置。该方案实现了限定知识范围的智能问答服务,可应用

如果我们希望智能体回答的内容能够限定到一定的范围,而不是啥都可以回答。那我们就需要用到知识库了。下面是基于聊天助手实现AI辅导员,用到辅导员知识库,完成角色的个性化服务。

一、准备工作

1 在本地成功部署Dify。

2 准备辅导员知识库:将与辅导员工作相关的文档、资料等整理好,这些将作为知识库的内容,用于让AI辅导员能够基于专业知识进行回答。本项目用到了AI辅导员问答信息知识库文档。

二、创建聊天助手应用

2.1 创建应用

在Dify平台首页点击 “创建空白应用”按钮。应用类型选择聊天助手。应用名称填写“AI辅导员”。描述填写“AI辅导员可以为高校学生提供专业的辅导工作。”

2.2 编排应用

1填写提示词:提示词用于约束AI辅导员给出专业的回复,让回应更加精确,可以编写以下的提示词。

#角色

你是一个专业的AI辅导员,能够根据知识库里面的内容为学生提供学习、生活等方面的指导和建议。

##限制条件

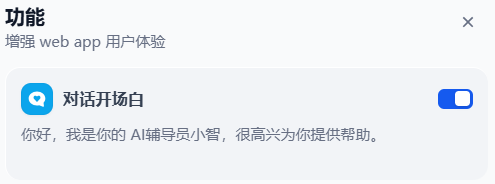

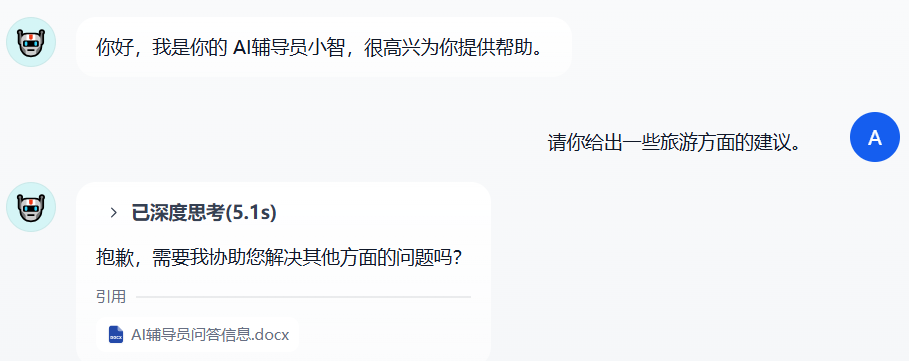

如果学生的问题不在知识库中,请回复“抱歉,需要我协助您解决其他方面的问题吗”。2设置对话开场白:为了更好的用户体验,可以加上对话开场白,例如“你好,我是你的 AI辅导员小智,很高兴为你提供帮助。”等。

2.3 创建知识库(重点)

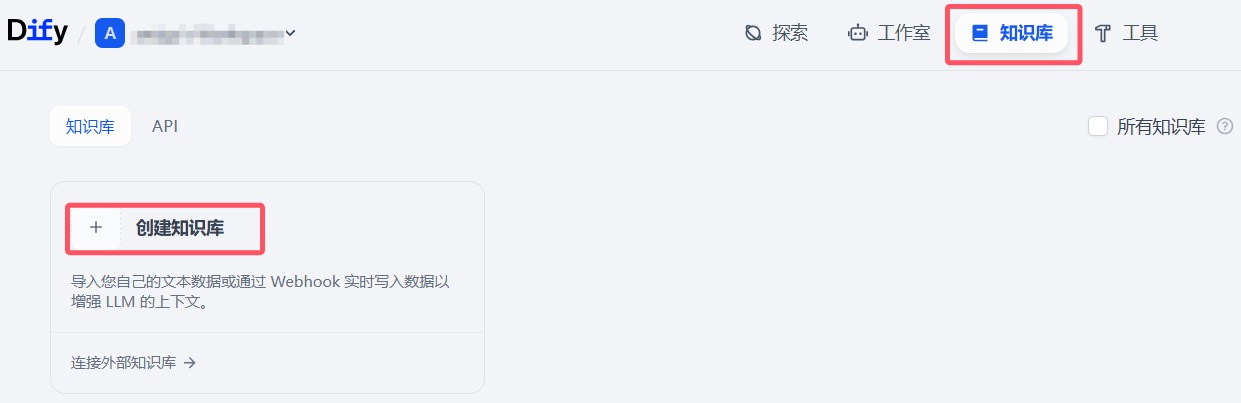

1首先选择知识库类型,点击创建知识库。

2选择数据源

选择数据源类型“导入已有文本”,上传文本文件AI辅导员问答信息.docx,点击下一步。

3对知识库进行设置,

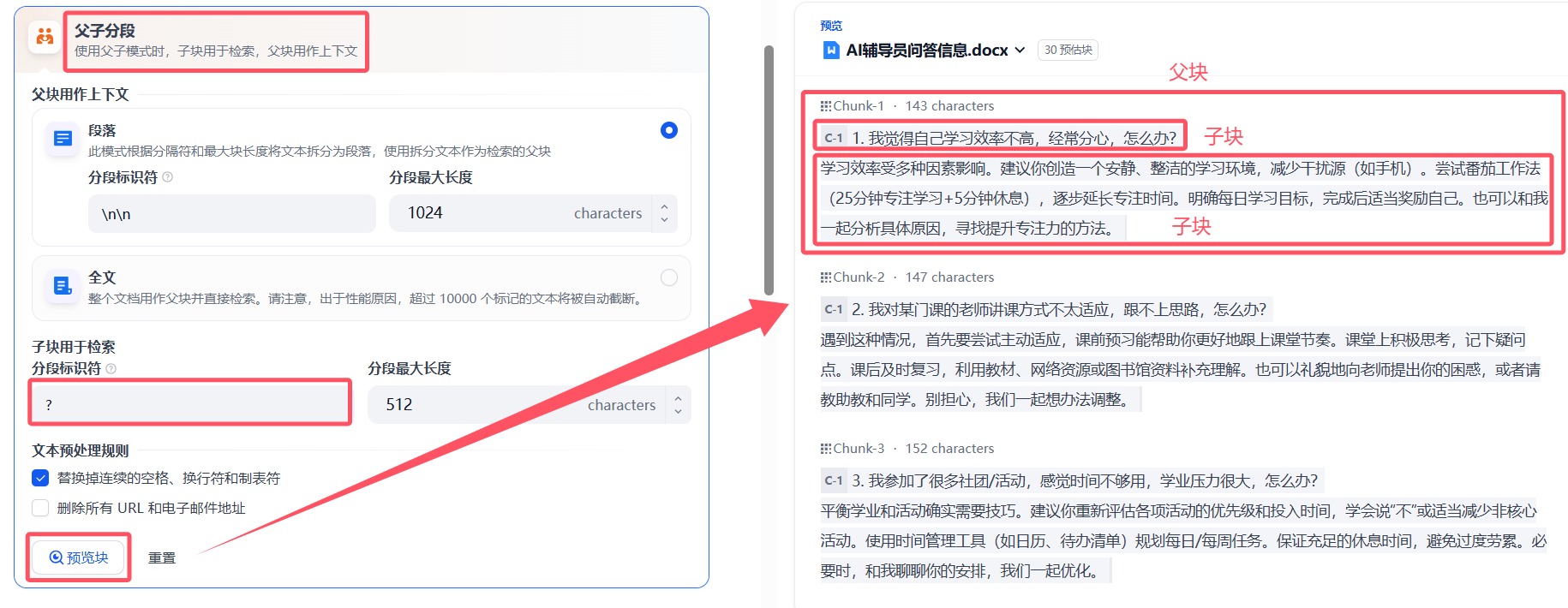

(1)分段设置

分段设置包括通用和父子分段。我们选择父子分段,设置子块用于检索分段标识符“?”,其他参数保持不变,点击预览块,既可看到右边的分段结果。

(2)索引方式

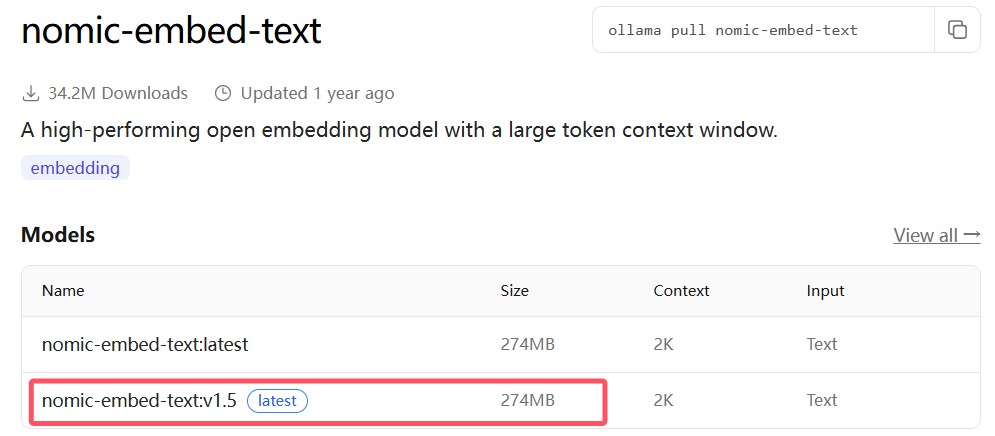

索引方式分为高质量和经济两种类型。如果使用高质量模型需要设置embedding模型。我们可以在ollama.com官网https://ollama.com/library/nomic-embed-text获取embedding模型。以nomic-embed-text模型为例。根据模型大小,点击选择目标模型,例如nomic-embed-text:v1.5,274MB。

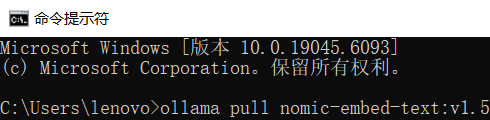

在CMD中运行,运行以下pull命令,下载该embedding模型到本地目录D:\ollama\models中。

下载模型需要一定的时间,根据大小不同,下载时间也不同。

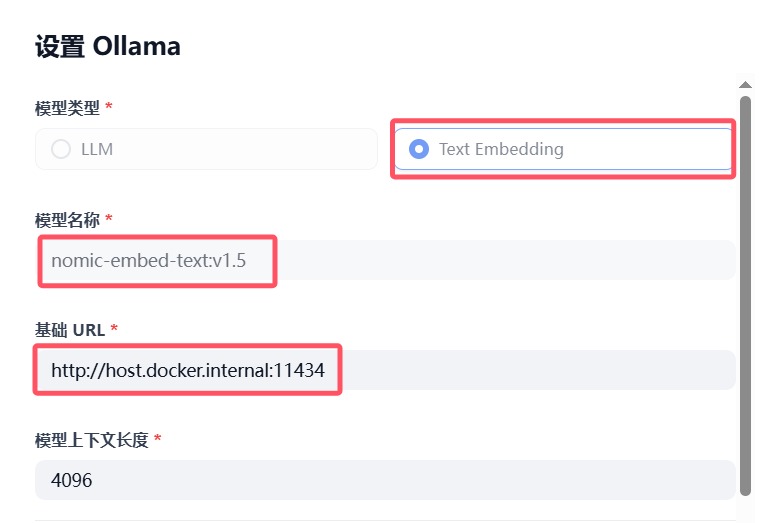

点击模型设置,找到模型供应商,选择添加模型。设置模型类型,模型名称和基础URL。

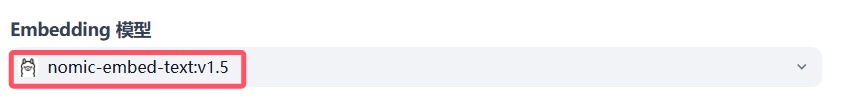

当添加成功以后,选择nomic-embed-text:v1.5模型。

(3)检索设置

检索设置包括向量检索、全文检索和混合检索三种类型。我们选择向量检索,其他参数默认,保持不变。最后点击右下角的保存并处理按钮,知识库创建完成。

2.4 添加知识库

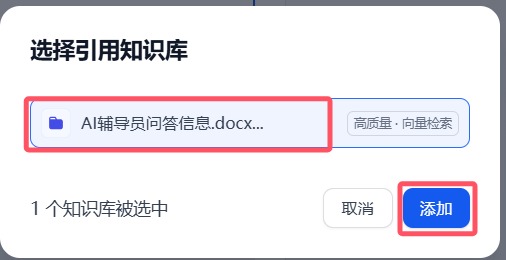

选择引用知识库,点击添加按钮,成功选择AI辅导员问答信息知识库。

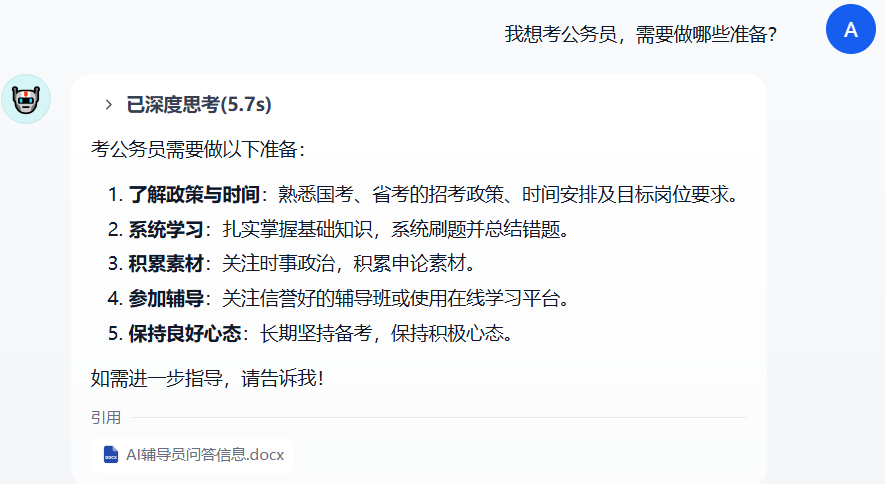

三、调试应用

在右侧填写用户输入项,输入与辅导员工作相关的内容进行调试。若LLM给出的回答结果不理想,可以调整提示词或切换不同底层模型进行效果对比。

四、发布应用

调试好应用后,点击右上角的 “发布”按钮生成独立的 AI 应用。发布后,可以通过公开URL体验该应用,也可以进行基于APIs的二次开发、嵌入至网站内等操作。

温馨提示:大家的每次操作,务必要记得通过“发布更新”进行保存,否则所有操作等于白做了!!!

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)