机器学习-PCA降维、去噪(4.2)

目录一.高维数据向低维数据映射二.实现自己封装的PCA三.scikit-learn中的PCA四.降噪手写识别的例子一.高维数据向低维数据映射m个样本,映射到k维主成分分析得到前k个方向的矩阵Wk,W第一行是最重要的,第二行是次重要,以此类推。高维向低维映射低维数据恢复到高维寻找一个坐标表示原来的样本,即主成分。找出前k个主成分,就可以将所有的样本映射...

·

目录

一.高维数据向低维数据映射

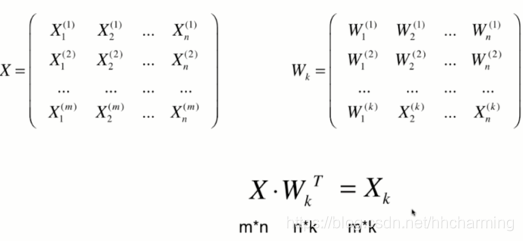

m个样本,映射到k维

主成分分析得到前k个方向的矩阵Wk,W第一行是最重要的,第二行是次重要,以此类推。

- 高维向低维映射

- 低维数据恢复到高维

寻找一个坐标表示原来的样本,即主成分。找出前k个主成分,就可以将所有的样本映射到这k个轴上。

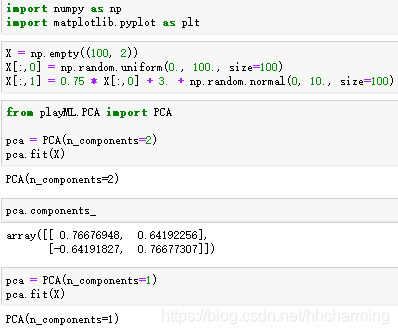

二.实现自己封装的PCA

PCA类:

先把w存到components_中去,其次是利用上面的计算公式,完成transform(高维向低维映射)

以及inverse_transform(低维向高维)

import numpy as np

class PCA:

def __init__(self, n_components):

"""初始化PCA"""

assert n_components >= 1, "n_components must be valid"

self.n_components = n_components

self.components_ = None

def fit(self, X, eta=0.01, n_iters=1e4):

"""获得数据集X的前n个主成分"""

assert self.n_components <= X.shape[1], \

"n_components must not be greater than the feature number of X"

def demean(X):

return X - np.mean(X, axis=0)

def f(w, X):

return np.sum((X.dot(w) ** 2)) / len(X)

def df(w, X):

return X.T.dot(X.dot(w)) * 2. / len(X)

def direction(w):

return w / np.linalg.norm(w)

def first_component(X, initial_w, eta=0.01, n_iters=1e4, epsilon=1e-8):

w = direction(initial_w)

cur_iter = 0

while cur_iter < n_iters:

gradient = df(w, X)

last_w = w

w = w + eta * gradient

w = direction(w)

if (abs(f(w, X) - f(last_w, X)) < epsilon):

break

cur_iter += 1

return w

X_pca = demean(X)

self.components_ = np.empty(shape=(self.n_components, X.shape[1]))

for i in range(self.n_components):

initial_w = np.random.random(X_pca.shape[1])

w = first_component(X_pca, initial_w, eta, n_iters)

self.components_[i,:] = w

X_pca = X_pca - X_pca.dot(w).reshape(-1, 1) * w

return self

def transform(self, X):

"""将给定的X,映射到各个主成分分量中"""

assert X.shape[1] == self.components_.shape[1]

return X.dot(self.components_.T)

def inverse_transform(self, X):

"""将给定的X,反向映射回原来的特征空间"""

assert X.shape[1] == self.components_.shape[0]

return X.dot(self.components_)

def __repr__(self):

return "PCA(n_components=%d)" % self.n_components

jupter中实现示例

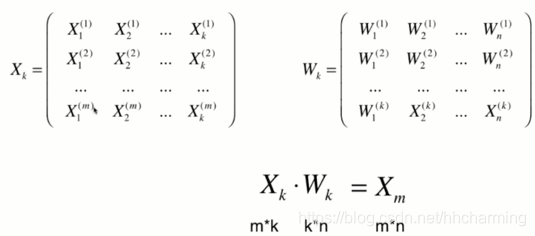

三.scikit-learn中的PCA

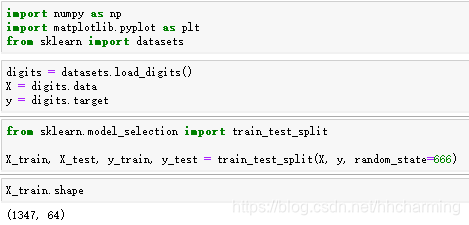

使用真实数据

先使用对原始数据做一下分类,这里我们应用KNN算法

再对数据降维,用KNN分类

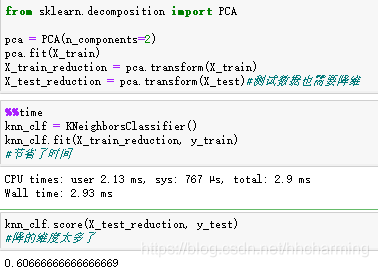

通过观察,如果选取降维的维数成为需要探索的问题。

pca.explained_variance_ratio_可查看成分依次可以解释的方差是多少

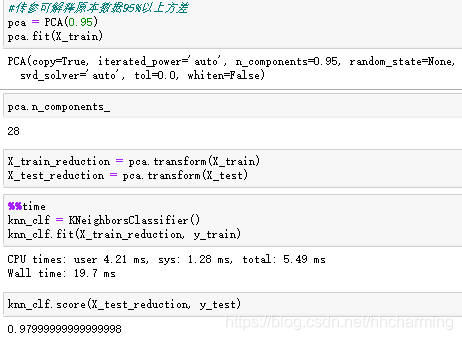

使用PCA对数据进行降维可视化,可以看出来,二维空间特征挺明显,降到二维有明显区分度。

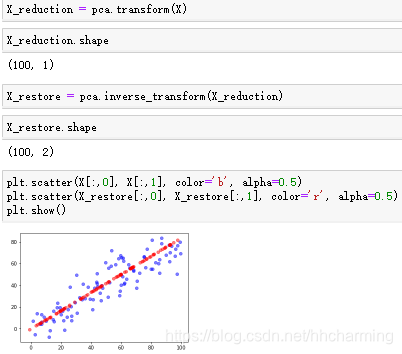

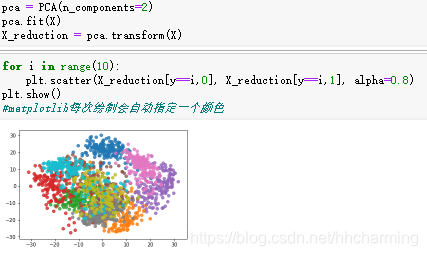

四.降噪

降维的过程可以理解成是去噪。

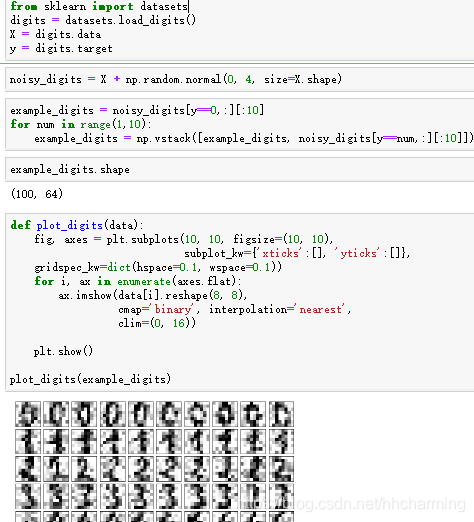

手写识别的例子

去噪之前

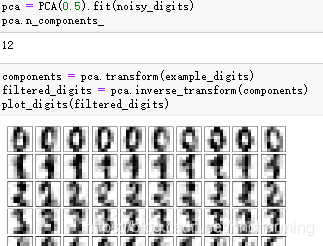

使用pca去噪,保留成分解释的50%

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)