AM-Softmax Loss

《Additive Margin Softmax for Face Verification》2018,Feng Wang et al.引言:本文提出一个概念上简单且几何上可解释的目标函数:additive margin Softmax (AM-Softmax),用于深度人脸验证,使得人脸特征具有更大的类间距和更小的类内距。同时,本文强调和讨论了特征归一化的重要性。实验表明AM-Soft...

- 《Additive Margin Softmax for Face Verification》

2018,Feng Wang et al.

引言:

本文提出一个概念上简单且几何上可解释的目标函数:additive margin Softmax (AM-Softmax),用于深度人脸验证,使得人脸特征具有更大的类间距和更小的类内距。同时,本文强调和讨论了特征归一化的重要性。实验表明AM-Softmax在LFW和MegaFace得到了比之前方法(L-Softmax, A-Softmax引入了角间距的概念,用于改进传统的softmax loss函数)更好的效果。

开源代码: https://github.com/happynear/AMSoftmax

深度人脸识别主要基于广泛使用的softmax loss。Softmax loss通常擅长优化类间差异(即,分离不同的类),但是不善于减少类内的变化(即,使相同类的特征紧凑)。本文提出了一种新颖、更可解释的方法将角度间距(angular margin)引入到softmax中,来最小化类内变化。

算法流程:

1. 预备知识

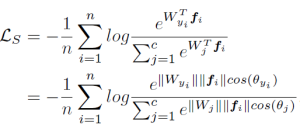

原始的softmax loss:

2. Additive Margin Softmax(AM-softmax )

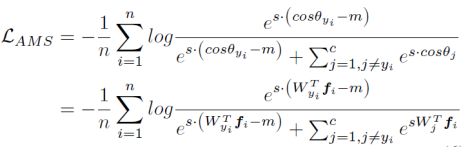

本文提出的方法将cos(mθ)更改为cosθ-m,将sphereface中的倍乘更改为加法。增加类间距,并减小类内距。为了提高收敛速度,引进了一个超参数s,这里s设置为固定值30。

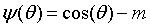

L-Softmax和A-Softmax均是引入了一个参数因子m 将权重W和f的cos距离变为cos(mθ),通过m 来调节特征间的距离。与前两者类似,AM-Softmax将cos(θ)的式子改写为:

上式是一个单调递减的函数,且比L-Softmax/A-Softmax所用的 Ψ(θ)在形式和计算时更为简单。

除了将b=0, ||W||=1,作者进一步将||x||=1,最终的AM-Softmax写为:

其中s是一个缩放因子,论文中固定为30。

3.讨论

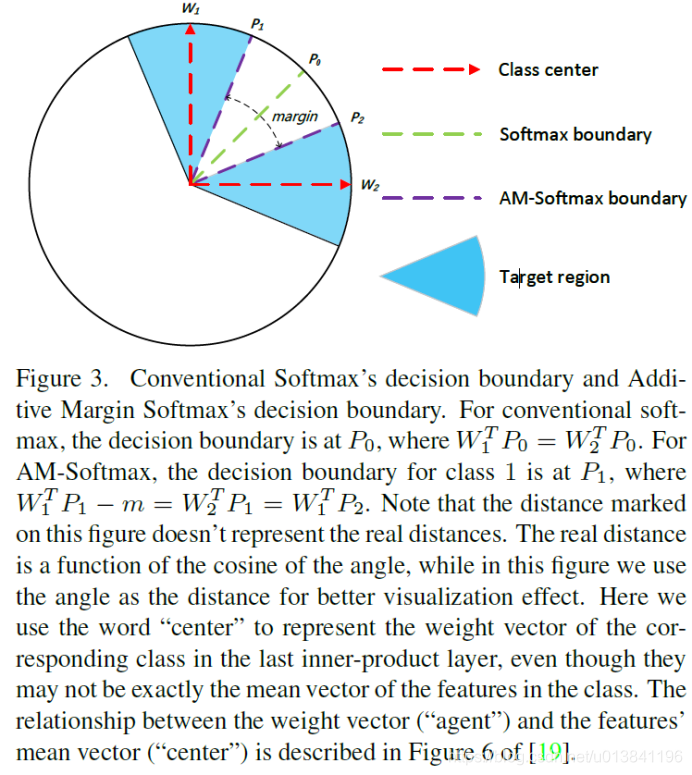

1)几何解释

与L-Softmax/A-Softmax类似,作者也讨论了AM-Softmax的几何解释。同样的,mm的取值大小也在控制着了分类边界的大小。两分类,对于1类的分类边界从 W 1 T P 0 = W 2 T P 0 W_{1}^{T}P_{0}=W_{2}^{T}P_{0} W1TP0=W2TP0变为了 W 1 T P 0 − m = W 2 T P 0 W_{1}^{T}P_{0}-m=W_{2}^{T}P_{0} W1TP0−m=W2TP0。

2)特征归一化

在SphereFace模型中,作者在Large Margin Softmax基础上对权重进行归一化,但特征仍然没有归一化。

本篇论文与NormFace一样,||x||=1。在论文【1】中提到,质量较差的人脸图片的feature norm越小。在进行了feature normalizaiton后,这些质量较差的图片特征会产生更大的梯度,导致网络在训练过程中将更多的注意力集中在这些样本上。因此,对于数据集图片质量较差时,更适合采用feature normalization。后续的实验也将证明这一点。

【1】Ranjan R, Castillo C D, Chellappa R. L2-constrained softmax loss for discriminative face verification[J]. arXiv preprint arXiv:1703.09507, 2017.

给出了特征归一化起作用的一种解释:归一化之后,范数小的特征算出来的梯度会更大;而范数小的特征一般对应的是质量较差的图片。因此,特征归一化起到类似于难例挖掘的作用。

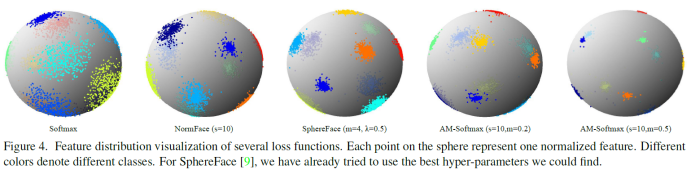

3)几种loss函数的特征分布可视化结果如下:

4.实验

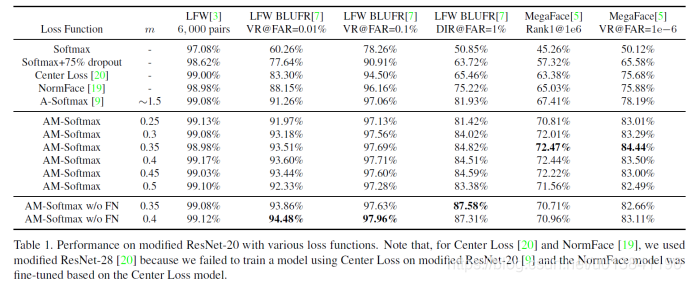

与SphereFace的实验的数据设置相同,本文与其它Loss函数进行了比较sphereface中只对w进行了归一化,本文对w和x都进行了归一化处理。其中w/o FN表示没有进行特征归一化处理。

实验结果表明,在高质量图片集(lfw)中,不使用特征归一化结果更好。在很多低质量的图片集(megaface)中,使用特征归一化结果更好。

总结:

本文在特征和权值正则化的情况下,提出了一种 additive margin Softmax,更直观也更易解释,同时也取得了比A-Softmax更好的实验结果。

注:博众家之所长,集群英之荟萃。

更多推荐

已为社区贡献25条内容

已为社区贡献25条内容

所有评论(0)