数据挖掘2023年2月春季期末考试复习资料

➊ 通过计算每个训练数据到待分类数据到距离,选择与待分类数据距离最近的k个训练数据,k个训练数据中哪个类别的训练数据占多数,则待分类数据就属于哪个类别。➌ 当样本不平衡的(例如,一个类的样本容量很大,而其他类的样本容量很小)时,有可能导致以下情况:当输入一个新样本时,该样本的k个近邻中大容量类的样本占大多数,影响分类结果。➌ 数据变换:将数据统一成适合挖掘的形式,主要策略包括对数据进行简单数学变换

简答题

描述数据探索和数据预处理的主要工作

- 数据探索简介:

➊ 数据探索就是对调查、观测所得到的一些原始的、杂乱无章的数据,在尽可能少的先验假设下进行处理,通过检验数据集的数据质量、绘制图表、计算某些特征量等手段,对样本数据集的结构和规律进行分析的过程。数据探索是从数据质量和数据特征两个角度进行的分析。

➋ 在通过数据探索发现数据中存在上述“脏数据”后,需要对数据进行预处理,提高数据的质量,以提高数据挖掘的效率。

- 数据预处理的主要步骤:

➊ 数据清洗:主要工作有填写缺失值,处理异常值。

➋ 数据集成:将多个数据源合并存放在一个数据储存中的过程。通过实体识别解决数据格式不同、主键不一致等问题。对于数值数据使用相关系数和协方差消除数据冗余。

➌ 数据变换:将数据统一成适合挖掘的形式,主要策略包括对数据进行简单数学变换,规范化,属性构造、聚集,将连续属性属性离散化,概念分层等。

➍ 数据归约:保持原始数据完整性的前提下减少 数据的特征或数据量。

KNN算法的基本思想和优缺点

- 基本思想:

➊ 通过计算每个训练数据到待分类数据的距离,选择与待分类数据距离最近的k个训练数据,k个训练数据中哪个类别的训练数据占多数,则待分类数据就属于哪个类别。knn算法中的基本要素有距离计算和k值确定。

- knn算法的优点:

➊ 简单,易于理解,易于实现,无须估计参数,无须训练。

➋ 适合对稀有事件进行分类。

➌ 特别适用于多分类问题。

- knn算法的缺点:

➊ 对每一个待分类样本都需要计算它到全体训练样本的距离,才能求得它的k个最近邻。对测试样本进行分类时计算量大,内存开销大。

➋ 可解释性较差,无法给出像决策树那样的规则。

➌ 当样本不平衡的(例如,一个类的样本容量很大,而其他类的样本容量很小)时,有可能导致以下情况:当输入一个新样本时,该样本的k个近邻中大容量类的样本占大多数,影响分类结果。

决策树的三种算法的比较

➊ ID3算法和C4.5算法在每个节点上可以产生多个分支,而CART算法在每个节点上只会产生两个分支。

➋ C4.5算法通过引入信息增益率,弥补了ID3算法在特征取值比较多时由于过度拟合而使泛化能力变弱的缺陷。

➌ ID3算法只能处理离散型属性,而C4.5算法和CART算法可以处理连续型属性。

➍ ID3算法和C4.5算法只能用于分类任务,而CART算法可以用于分类和回归任务。

➎ CART算法通过基尼系数进行划分,C4.5算法通过信息增益率进行划分,ID3算法通过信息增益 进行划分。

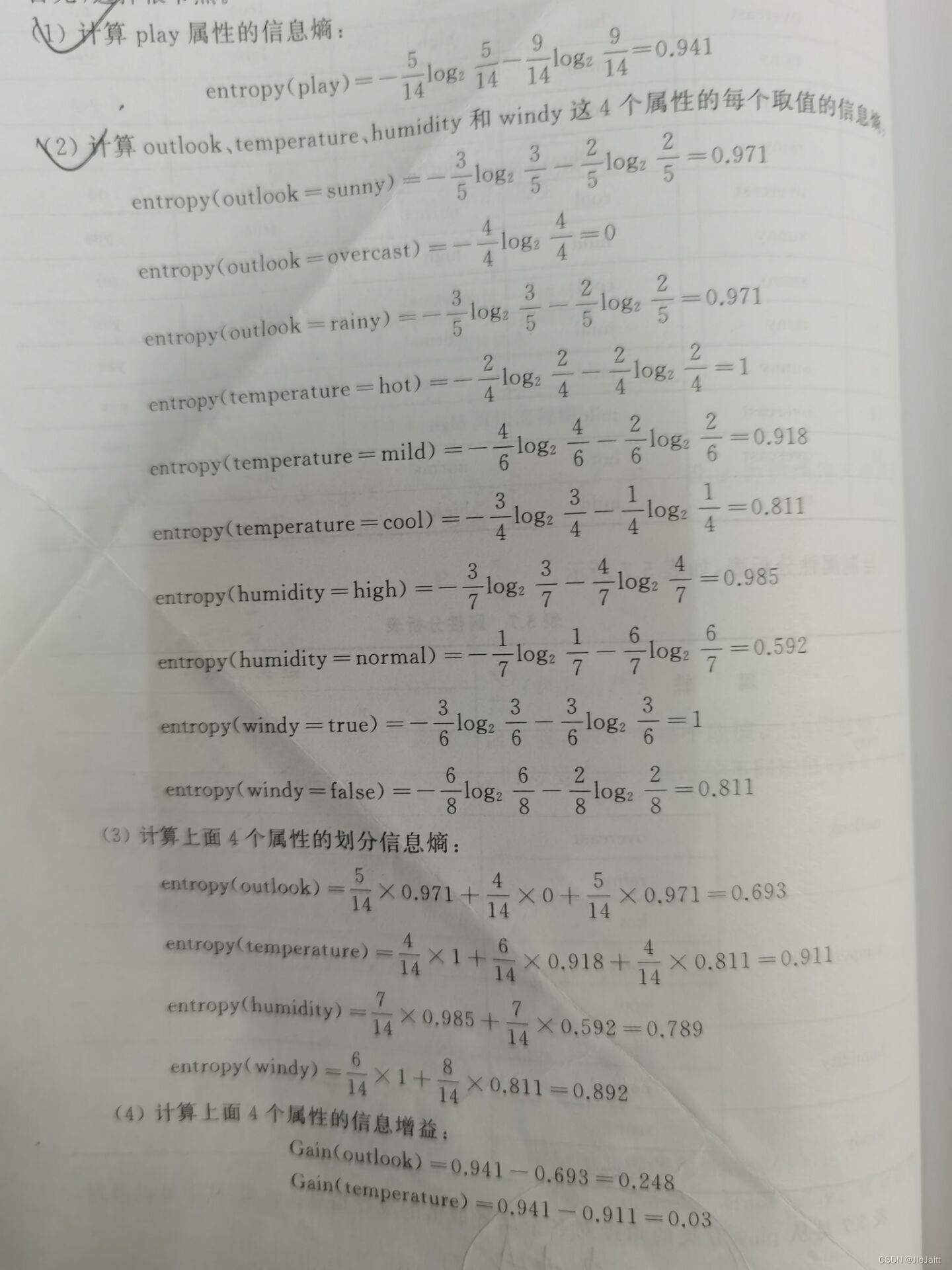

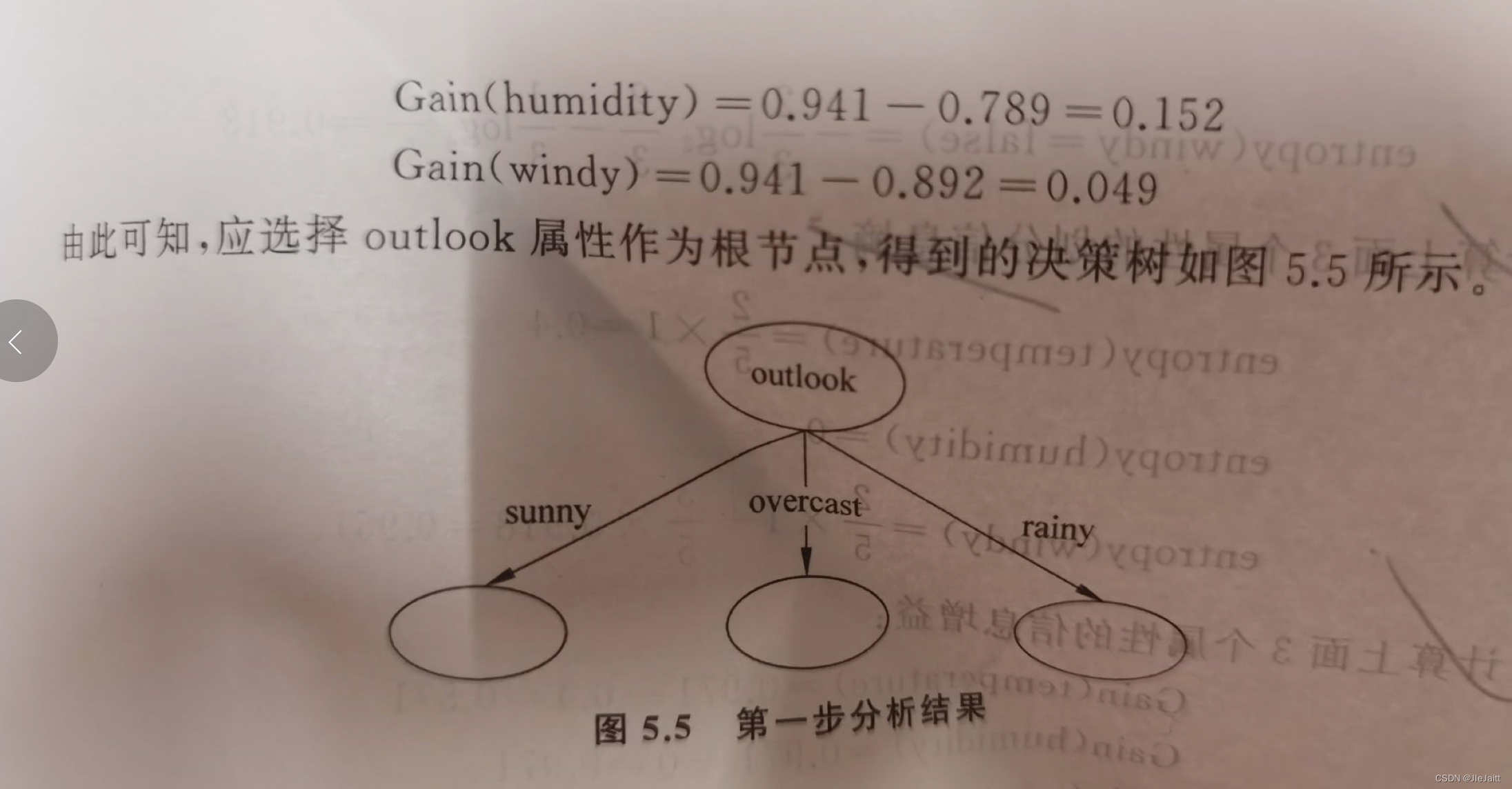

ID3算法

➊ 计算信息熵:H(Y)=−∑i=1npilog2piH(Y) = -\sum_{i=1}^{n} p_i \log_2 p_iH(Y)=−∑i=1npilog2pi

其中,pip_ipi是类别iii在数据集中出现的频率,nnn是类别的数量。信息熵H(Y)H(Y)H(Y)越小,代表数据集合中的样本越趋向于同一类别,即纯度越高。

➋ 计算划分信息熵:H(Y∣X)=∑i=1mNiNH(Yi)H(Y|X) = \sum_{i=1}^{m} \frac{N_i}{N} H(Y_i)H(Y∣X)=∑i=1mNNiH(Yi)

其中,NiN_iNi是在特征XXX上取值为xix_ixi的样本数量,NNN是数据集合的样本总数,H(Yi)H(Y_i)H(Yi)是在特征XXX上取值为xix_ixi的样本的信息熵。划分信息熵H(Y∣X)H(Y|X)H(Y∣X)越小,代表在特征XXX的作用下,数据集合的纯度越高。

➌ 计算信息增益:Gain(Y,X)=H(Y)−H(Y∣X)Gain(Y, X) = H(Y) - H(Y|X)Gain(Y,X)=H(Y)−H(Y∣X)

信息增益Gain(Y,X)Gain(Y, X)Gain(Y,X)越大,代表在特征XXX的作用下,数据集合的纯度提高得越多,即该特征对于分类任务的贡献越大。

➍ 选择信息增益最大的特征作为根节点,将数据集合按照该特征值划分成多个子集,每个子集对应一个分支。

选填题

知识点:数据属性类型有标称属性、序数属性、数值属性、离散属性与连续属性。

- 常见标称属性之一是二元属性又称布尔属性,只有两个类别或者状态,如阴阳,男女,正反等。

- 非对称属性,两个状态不是同等重要的。如0和1只看重1或者只看重0就是非对称属性。

- 序数属性是什么?如学生成绩可以分为优良中及格、餐厅供应有大份中份和小份则为序数属性。

- 标签属性、二元属性和序数属性都是

定性的,而数值属性是定量的。

数据的统计描述

- 数据中心趋势度量有:均值、中位数和众数,需要都知道怎么计算。

- 度量数据散布的有极差、分位数、四分位数和四分位间距, 重点掌握四分位间距怎么算。

四分位间距(interquartile range,IQR)是描述数据集合中数据分布离散程度的一种统计量,通常用于描述数据的变异程度。

计算四分位间距需要先找出数据集合的中位数(即第二个四分位数),然后将数据集合分成两部分:一部分包括所有小于或等于中位数的数据,另一部分包括所有大于或等于中位数的数据。接下来,分别在这两部分中计算各自的中位数,这两个中位数就是数据集合的第一个四分位数和第三个四分位数,四分位间距等于这两个数值的差值。

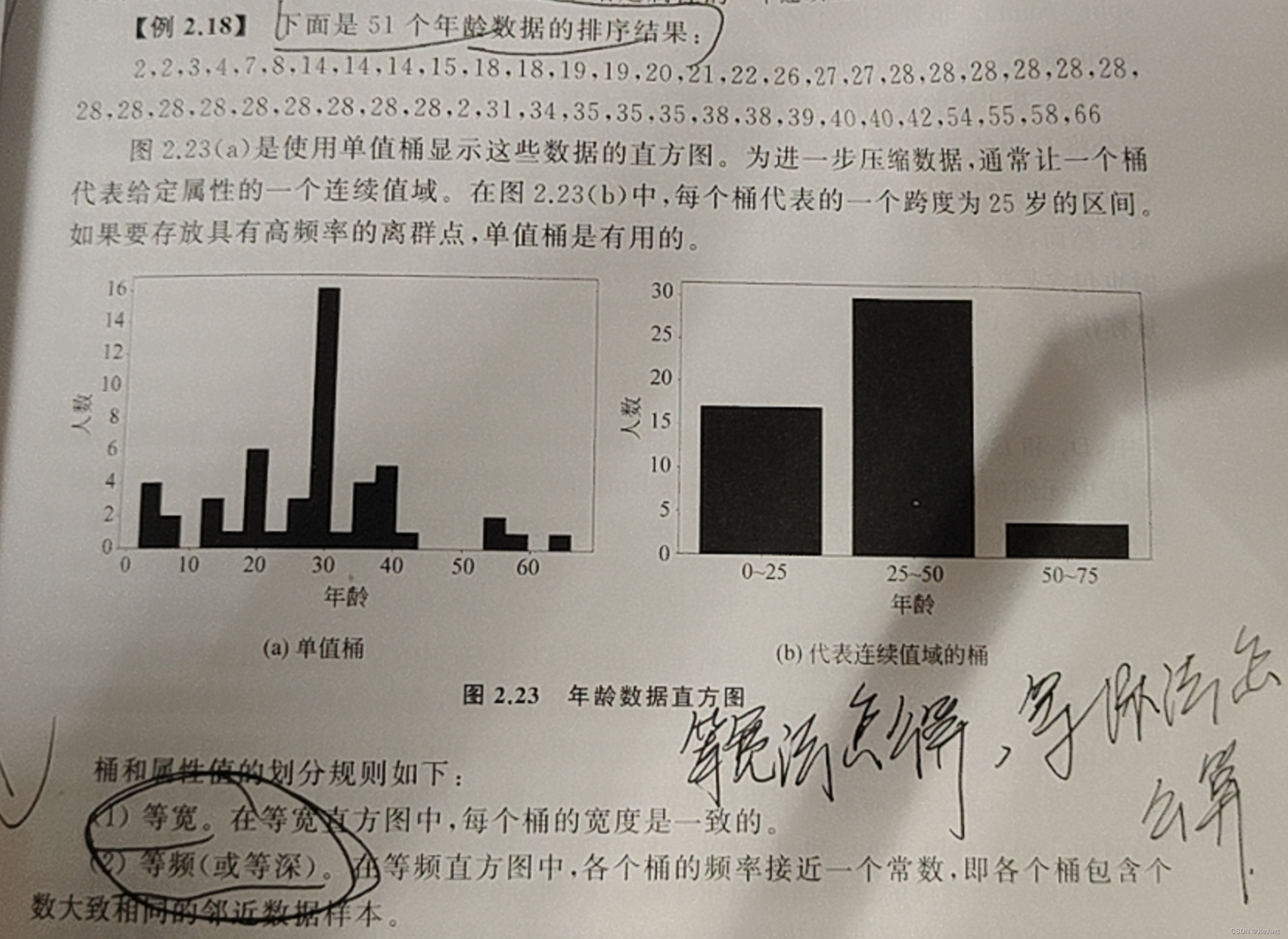

统计描述图形显示

包括直方图、散点图、箱型图和小提琴图。小提琴图不重要。

- 直方图反映不同数据出现的频率。可以直观、快速地观察数据的分散程度和中心趋势。

- 散点图的特点是能以图形方式直观的表现出影响因素和预测对象之间的总体关系趋势。

- 箱形图可以用来比较若干个可比较的数据集。箱形图能够有效地帮助识别数据集中的异常值(离群点),判断数据集的数据分散程度和偏向(盒子的高度以及whisker的长度)。

- 欧几里得距离和曼哈顿距离

- 汉明距离(Hamming distance)是指两个等长字符串在相同位置上不同字符的个数。例如,字符串 A = “10101”,字符串 B = “11100”,则字符串 A 和字符串 B 的汉明距离为 3,因为它们在第 1、3、5 个位置上的字符不同。注意两个字符串的长度是否相等。如果不相等,则它们的汉明距离为无穷大。

(填空)数据清洗就是把脏数据洗掉,即发现并纠正数据文件中可识别的错误数据,包括检查数据的一致性和完整性、处理噪声(异常数据)等。

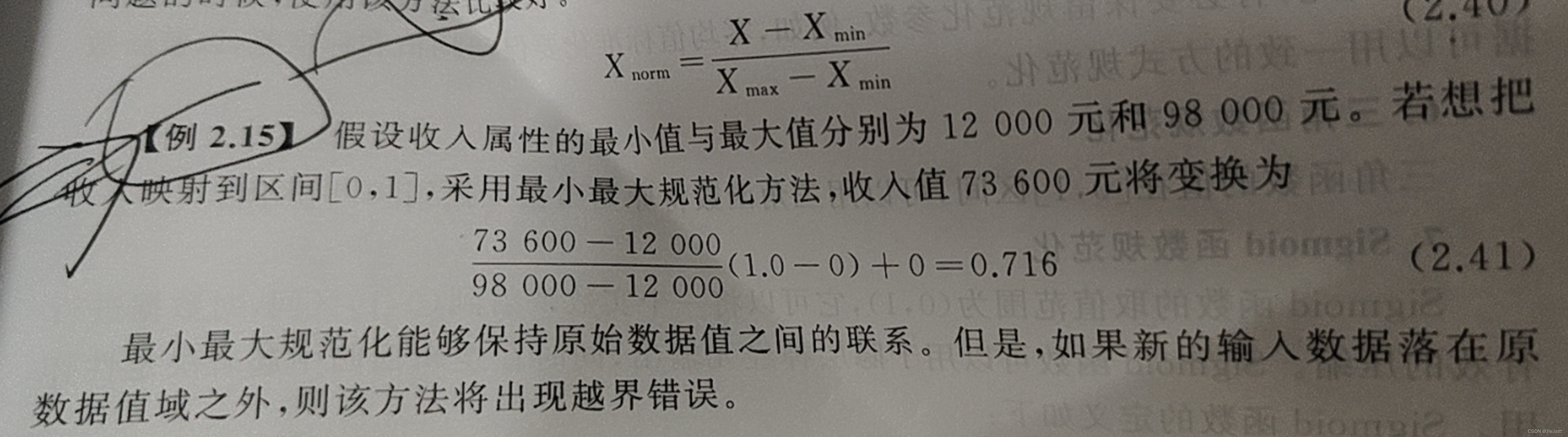

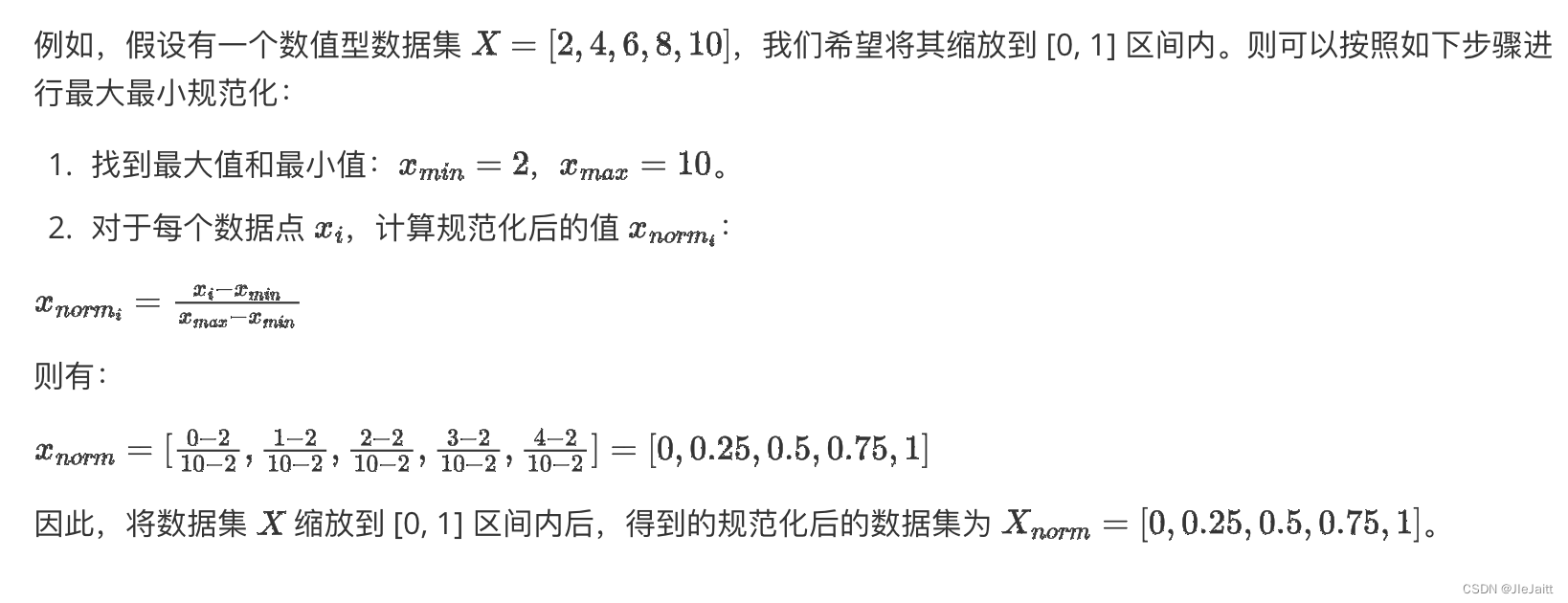

最大最小规范化

- 例1

- 例2

等宽法怎么算,等深法怎么算

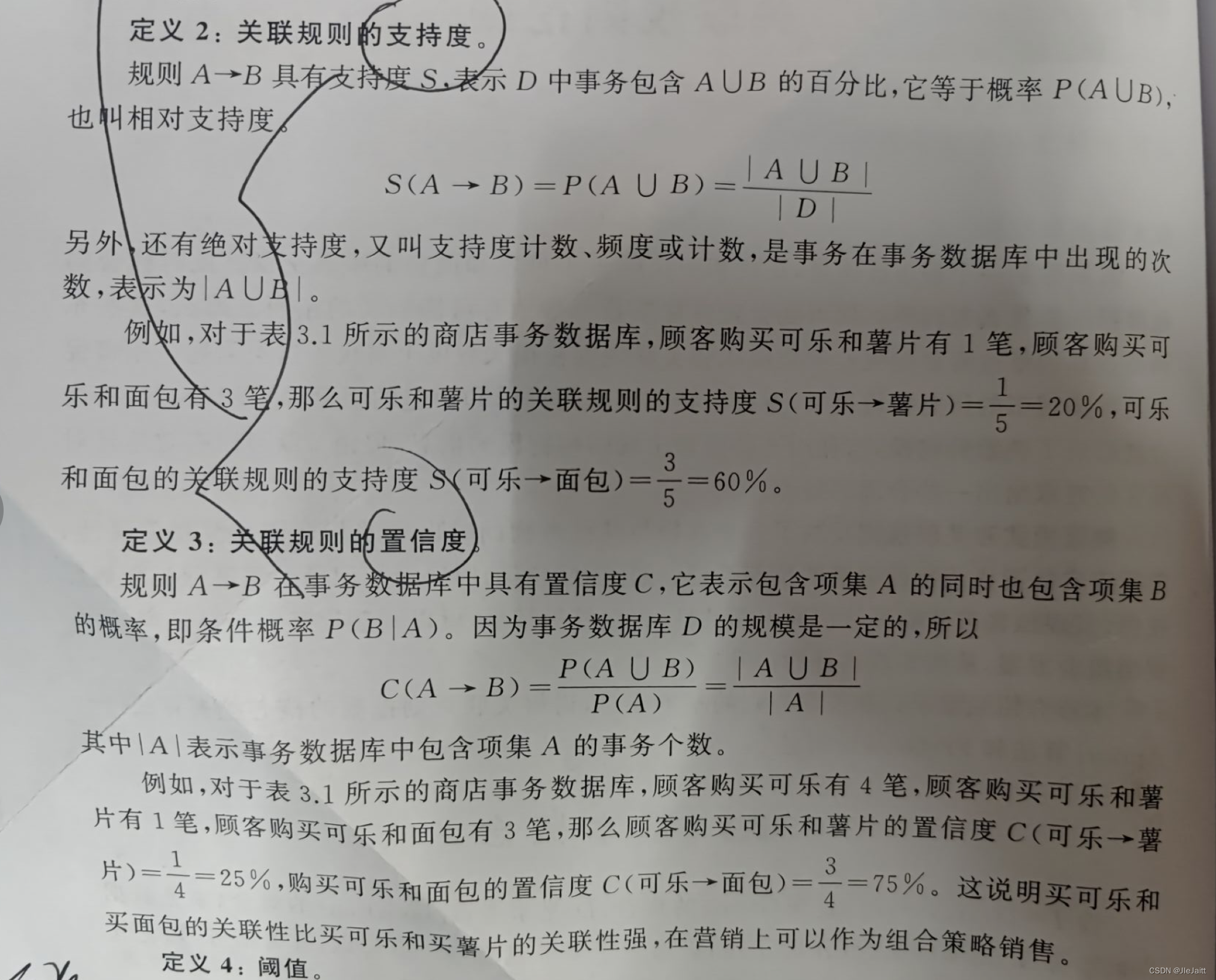

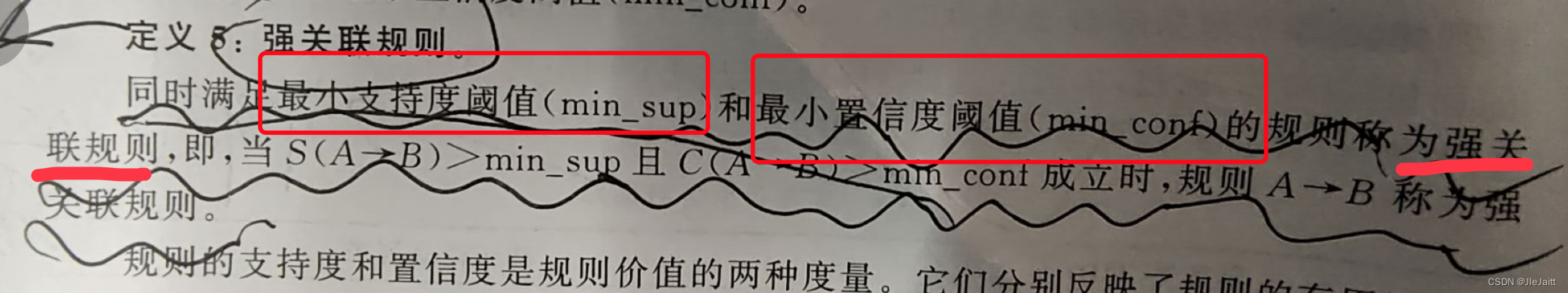

关联规则支持度和置信度的计算

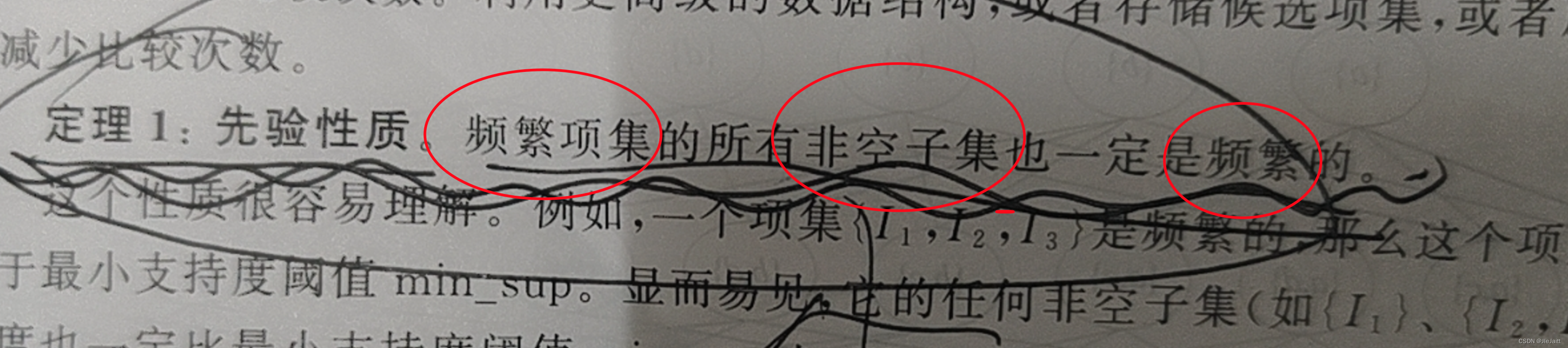

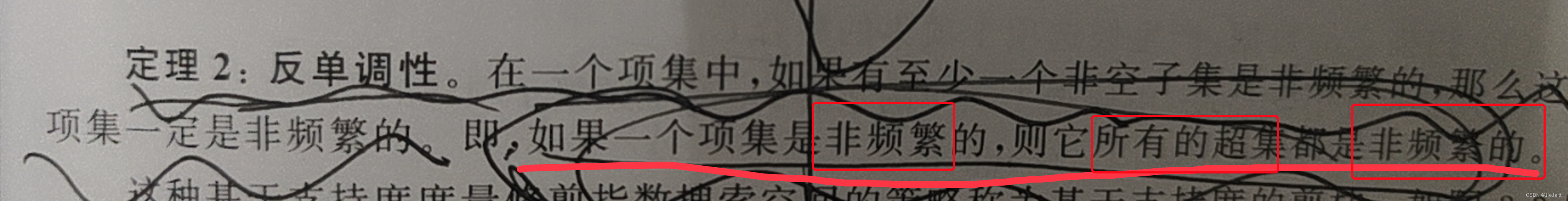

Apriori算法中有关频繁项集的问题

基于层次的方法

根据层次的形成是自底向上(合并)还是自顶向下(分裂),可以将层次聚类方法分为凝聚式和分裂式两类。两种代表算法分别是AGNES和DIANA。

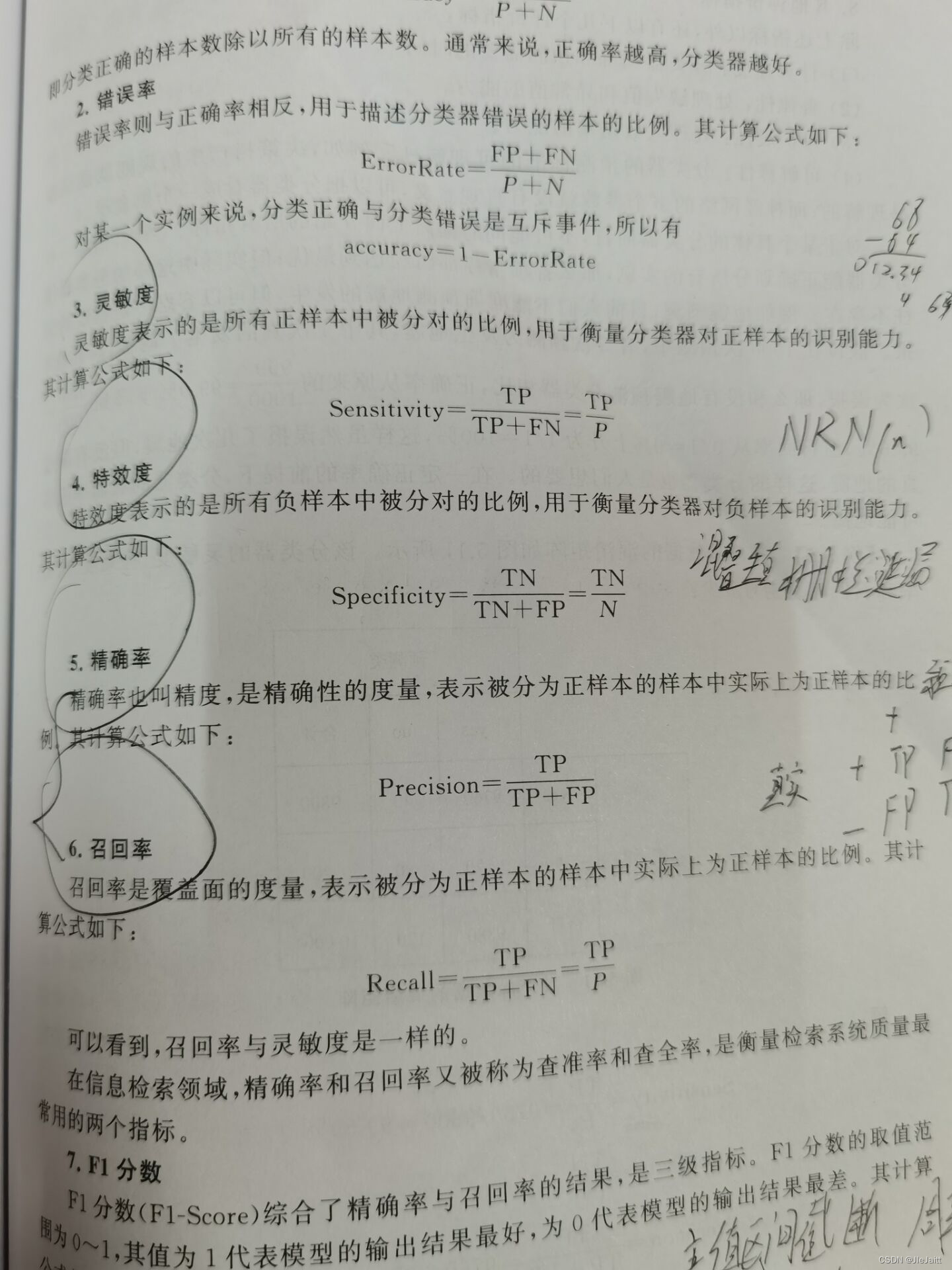

评价指标

分类器性能的表示

➊ 如果一个模型好于另一个模型,则前者的AUC值较大。AUC可以直观的评价分类器的好坏,其值越大越好。

➋ ROC曲线图面积越大,模型越好。

支持向量机分类算法

➊ 监督式学习算法

➋ 能处理多元线性问题和非线性问题

➌ 比较适合小样本问题

提升算法

提升(boosting)算法以弱分类器为基学习器,而且各个基学习器之间有相互依赖的串联关系。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)