Scikit-learn超参数调优终极指南:从暴力搜索到贝叶斯优化深度解析(八)

超参数是模型外部的配置参数,与模型内部通过训练得到的参数(如线性回归的权重)不同,需要人工设定。SVM的惩罚系数C随机森林的树数量(n_estimators)神经网络的学习率(learning rate)return 0.5*fp + 2*fn # 自定义损失权重greater_is_better=False, # 指定优化方向小参数空间优先GridSearch中等维度使用HalvingGrid高

·

一、超参数调优的本质与挑战

1.1 什么是超参数?

超参数是模型外部的配置参数,与模型内部通过训练得到的参数(如线性回归的权重)不同,需要人工设定。常见示例包括:

- SVM的惩罚系数C

- 随机森林的树数量(n_estimators)

- 神经网络的学习率(learning rate)

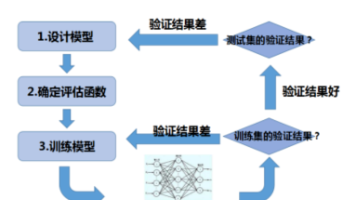

1.2 调优的核心数学原理

超参数优化的本质是寻找使目标函数最优的参数组合:

θ∗=argminθ∈ΘL(fθ,Dvalid)\theta^* = \arg\min_{\theta \in \Theta} \mathcal{L}(f_\theta, D_{valid})θ∗=argθ∈ΘminL(fθ,Dvalid)

其中:

- Θ\ThetaΘ 表示参数空间

- L\mathcal{L}L 是损失函数

- DvalidD_{valid}Dvalid 是验证集数据

二、四大自动调参方法深度解析

2.1 GridSearchCV(网格搜索)

算法原理

穷举所有参数组合,通过交叉验证选择最优解。假设有n个参数,每个参数有k个候选值,时间复杂度为O(kⁿ)

关键参数详解

GridSearchCV(

estimator,

param_grid,

scoring=None,

n_jobs=None,

refit=True,

cv=None,

verbose=0,

pre_dispatch='2*n_jobs',

error_score=nan,

return_train_score=False

)

param_grid:支持字典或列表格式,实现多参数网格n_jobs:-1表示使用所有处理器核心refit:是否用最优参数在整个数据集上重新训练

进阶用法示例

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import GridSearchCV

param_grid = [

{'n_estimators': [100, 200], 'max_depth': [5, 10]},

{'bootstrap': [False], 'n_estimators': [50, 100]}

]

grid = GridSearchCV(

RandomForestClassifier(),

param_grid,

cv=5,

scoring='f1_macro',

verbose=2

)

grid.fit(X_train, y_train)

2.2 RandomizedSearchCV(随机搜索)

概率采样原理

对于连续参数,推荐使用scipy.stats中的分布:

expon:指数分布uniform:均匀分布loguniform:对数均匀分布

数学期望分析

当参数空间维度D>5时,随机搜索效率比网格搜索高约5倍(Bergstra & Bengio, 2012)

实战代码

from sklearn.model_selection import RandomizedSearchCV

from scipy.stats import loguniform

param_dist = {

'C': loguniform(1e-3, 1e3),

'gamma': loguniform(1e-5, 1e1),

'kernel': ['linear', 'rbf']

}

random_search = RandomizedSearchCV(

SVC(),

param_distributions=param_dist,

n_iter=200,

cv=5,

random_state=42

)

random_search.fit(X_train, y_train)

2.3 HalvingGridSearchCV(资源优化搜索)

Successive Halving算法流程

- 初始阶段:分配少量资源(如部分样本)评估所有候选参数

- 淘汰阶段:保留表现最好的前1/η的参数

- 资源倍增:对保留参数增加资源(η为淘汰率,默认3)

- 迭代直到资源耗尽

数学表达式

- 候选参数数量:nk=⌊nk−1/η⌋n_k = \lfloor n_{k-1} / \eta \rfloornk=⌊nk−1/η⌋

- 资源分配量:rk=rk−1×ηr_k = r_{k-1} \times \etark=rk−1×η

关键参数

HalvingGridSearchCV(

estimator,

param_grid,

*,

factor=3,

resource='n_samples',

max_resources='auto',

aggressive_elimination=False,

cv=5,

scoring=None,

refit=True,

error_score=nan,

return_train_score=True

)

resource:可指定为样本数或迭代次数aggressive_elimination:强制进行最大次数迭代

资源分配可视化

import matplotlib.pyplot as plt

results = halving_search.cv_results_

plt.plot(results['iter'], results['n_resources'], 'o-')

plt.xlabel('Iteration')

plt.ylabel('Resources')

plt.title('Resource Allocation in Successive Halving')

2.4 BayesSearchCV(贝叶斯优化)

高斯过程回归原理

使用高斯过程(GP)作为代理模型:

f(x)∼GP(m(x),k(x,x′))f(x) \sim \mathcal{GP}(m(x), k(x, x'))f(x)∼GP(m(x),k(x,x′))

其中:

- 均值函数m(x)m(x)m(x)

- 协方差函数k(x,x′)k(x, x')k(x,x′)(常用Matern核)

Acquisition函数

选择下一个评估点的策略:

- Expected Improvement (EI):

EI(x)=E[max(f(x)−f(x+),0)]EI(x) = \mathbb{E}[\max(f(x) - f(x^+), 0)]EI(x)=E[max(f(x)−f(x+),0)]

实现代码

from skopt import BayesSearchCV

from skopt.space import Real, Categorical, Integer

search_spaces = {

'learning_rate': Real(0.001, 0.1, prior='log-uniform'),

'max_depth': Integer(3, 10),

'subsample': Real(0.5, 1.0),

'colsample_bytree': Real(0.5, 1.0)

}

bayes_search = BayesSearchCV(

xgb.XGBClassifier(),

search_spaces,

n_iter=50,

cv=5,

optimizer_kwargs={'base_estimator': 'GP'},

scoring='roc_auc'

)

bayes_search.fit(X_train, y_train)

三、自定义评分函数开发指南

3.1 创建自定义评分器

from sklearn.metrics import make_scorer

def custom_loss(y_true, y_pred):

fp = np.sum((y_pred == 1) & (y_true == 0))

fn = np.sum((y_pred == 0) & (y_true == 1))

return 0.5*fp + 2*fn # 自定义损失权重

custom_scorer = make_scorer(

custom_loss,

greater_is_better=False, # 指定优化方向

needs_proba=False

)

3.2 多类别评分处理

from sklearn.metrics import f1_score

# Macro-F1评分

macro_f1 = make_scorer(

f1_score,

average='macro',

labels=[0, 1, 2], # 指定类别

zero_division=0

)

3.3 集成业务指标

def business_metric(y_true, y_pred):

profit_matrix = np.array([

[0, -5, 10], # 实际类别0

[-10, 0, 5], # 实际类别1

[5, -2, 0] # 实际类别2

])

return np.sum(profit_matrix[y_true, y_pred])

business_scorer = make_scorer(

business_metric,

greater_is_better=True

)

四、性能优化与工程实践

4.1 并行计算加速

GridSearchCV(

estimator,

param_grid,

n_jobs=4, # 设置并行进程数

pre_dispatch='2*n_jobs', # 控制任务分发

verbose=10 # 显示进度

)

4.2 内存缓存机制

from joblib import Memory

memory = Memory(location='./cachedir')

GridSearchCV(

estimator,

param_grid,

memory=memory, # 缓存转换器

cv=5

)

4.3 早停策略集成

from xgboost import XGBClassifier

from sklearn.model_selection import GridSearchCV

param_grid = {

'n_estimators': [1000],

'early_stopping_rounds': [50]

}

grid = GridSearchCV(

XGBClassifier(),

param_grid,

fit_params={

'eval_set': [(X_val, y_val)],

'verbose': False

}

)

五、方法对比与选型矩阵

| 维度 | GridSearch | RandomizedSearch | HalvingGrid | BayesSearch |

|---|---|---|---|---|

| 时间复杂度 | O(kⁿ) | O(n_iter) | O(n√k) | O(n log n) |

| 空间效率 | 低 | 中 | 高 | 高 |

| 并行能力 | 优秀 | 优秀 | 良好 | 中等 |

| 参数空间适应性 | 小规模离散 | 中等规模 | 大规模 | 超大规模 |

| 需要先验知识 | 无 | 部分 | 少量 | 需要 |

| 最优解保证 | 全局最优 | 概率最优 | 近似最优 | 近似最优 |

六、调优结果深度分析

6.1 结果可视化

import pandas as pd

import seaborn as sns

results = pd.DataFrame(grid_search.cv_results_)

sns.heatmap(

results.pivot('param_C', 'param_gamma', 'mean_test_score'),

annot=True,

fmt=".3f"

)

6.2 参数重要性分析

from sklearn.inspection import permutation_importance

final_model = grid_search.best_estimator_

result = permutation_importance(

final_model,

X_test,

y_test,

n_repeats=10,

random_state=42

)

sorted_idx = result.importances_mean.argsort()

plt.boxplot(

result.importances[sorted_idx].T,

vert=False,

labels=X.columns[sorted_idx]

)

七、常见陷阱与解决方案

7.1 数据泄漏问题

- 错误做法:在调优前进行特征选择

- 正确做法:将特征选择嵌入Pipeline

from sklearn.pipeline import make_pipeline

pipe = make_pipeline(

SelectKBest(f_classif),

RandomForestClassifier()

)

param_grid = {

'selectkbest__k': [10, 20, 50],

'randomforestclassifier__n_estimators': [100, 200]

}

7.2 类别不平衡处理

GridSearchCV(

estimator,

param_grid,

scoring='roc_auc',

cv=StratifiedKFold(5),

class_weight='balanced'

)

7.3 超参数交互效应

使用PairGrid分析参数组合效应:

g = sns.PairGrid(results, vars=['param_C', 'param_gamma'])

g.map_upper(sns.scatterplot)

g.map_lower(sns.kdeplot)

g.map_diag(sns.histplot)

八、扩展应用场景

8.1 多指标优化

GridSearchCV(

estimator,

param_grid,

scoring={

'accuracy': 'accuracy',

'precision': 'precision_macro',

'recall': 'recall_macro'

},

refit='accuracy',

cv=5

)

8.2 多模型对比

from sklearn.linear_model import LogisticRegression

from sklearn.svm import SVC

param_grid = [

{

'model': [LogisticRegression()],

'model__C': [0.1, 1, 10]

},

{

'model': [SVC()],

'model__C': [0.1, 1, 10],

'model__kernel': ['linear', 'rbf']

}

]

grid = GridSearchCV(

Pipeline([('model', DummyClassifier())]),

param_grid,

cv=5

)

九、前沿技术展望

- Meta-Learning:基于历史调优结果的参数推荐

- Neural Architecture Search:自动神经网络架构搜索

- Multi-Fidelity Optimization:多精度资源优化

- Transfer Learning for HPO:跨任务的参数迁移学习

# 示例:使用Optuna进行高级优化

import optuna

from optuna.samplers import TPESampler

def objective(trial):

params = {

'C': trial.suggest_float('C', 1e-5, 1e5, log=True),

'gamma': trial.suggest_float('gamma', 1e-5, 1e1, log=True)

}

model = SVC(**params)

return cross_val_score(model, X, y).mean()

study = optuna.create_study(sampler=TPESampler())

study.optimize(objective, n_trials=100)

十、总结

10.1 核心要点回顾

- 小参数空间优先GridSearch

- 中等维度使用HalvingGrid

- 高维连续空间选择BayesSearch

- 快速原型开发用RandomizedSearch

10.2 项目模板

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.pipeline import Pipeline

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import HalvingGridSearchCV

# 数据准备

data = pd.read_csv('dataset.csv')

X = data.drop('target', axis=1)

y = data['target']

# 数据拆分

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

# 构建Pipeline

pipe = Pipeline([

('scaler', StandardScaler()),

('clf', RandomForestClassifier())

])

# 参数网格

param_grid = {

'clf__n_estimators': [100, 200, 500],

'clf__max_depth': [None, 5, 10],

'clf__min_samples_split': [2, 5, 10]

}

# 优化器配置

search = HalvingGridSearchCV(

pipe,

param_grid,

resource='n_samples',

factor=2,

aggressive_elimination=True,

cv=5,

n_jobs=-1,

verbose=1

)

# 执行搜索

search.fit(X_train, y_train)

# 结果分析

print(f"Best params: {search.best_params_}")

print(f"Test score: {search.score(X_test, y_test):.4f}")

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)