CFMW~

硬刚恶劣天气!Mamba 引领目标检测新风向跨模态图像融合了可见光-红外光谱线索,可以为目标检测提供更丰富的互补信息。尽管如此,现有的可见光-红外目标检测方法在恶劣天气条件下严重退化。这种失败源于可见图像对环境扰动的显著敏感性,如雨、雾和雪,这些常常导致检测中的假阴性和假阳性。为了解决这个问题,作者引入了一项新颖且具有挑战性的任务,称为恶劣天气条件下的可见光-红外目标检测。为了促进这一任务,作者构

硬刚恶劣天气!Mamba 引领目标检测新风向

跨模态图像融合了可见光-红外光谱线索,可以为目标检测提供更丰富的互补信息。尽管如此,现有的可见光-红外目标检测方法在恶劣天气条件下严重退化。这种失败源于可见图像对环境扰动的显著敏感性,如雨、雾和雪,这些常常导致检测中的假阴性和假阳性。

为了解决这个问题,作者引入了一项新颖且具有挑战性的任务,称为恶劣天气条件下的可见光-红外目标检测。为了促进这一任务,作者构建了一个新的恶劣天气可见光-红外数据集(SWVID),其中包含了多样化的恶劣天气场景。

此外,作者提出了带有天气去除(CFMW)的跨模态融合曼巴,以增强恶劣天气条件下的检测准确性。

得益于所提出的天气去除扩散模型(WRDM)和跨模态融合曼巴(CFM)模块,CFMW能够挖掘跨模态融合中行人特征的更基本信息,从而能够高效地转移到其他更罕见的场景,并在计算能力较低的平台上有足够的可用性。

据作者所知,这是首次针对改进并在跨模态目标检测中同时集成扩散和曼巴模块的研究,成功提高了这类模型的实用性和更先进的架构。

在公认的和作者自行创建的数据集上的大量实验都明确证明了作者的CFMW达到了最先进的检测性能,超越了现有的基准。

数据集和源代码将在https://github.com/lhy-zjut/CFMW上公开提供。

1. Introduction

在开放和动态的环境中,目标检测面临如雨、雾和雪等具有挑战性的天气条件。基于深度学习的目标检测方法的快速发展显著提高了识别和分类物体的能力。得益于先进的特征提取和融合策略,跨模态目标检测方法已达到高精度,例如CFT(杨等人,2017年)、GAFF(杨等人,2017年)和CFR(杨等人,2017年)。

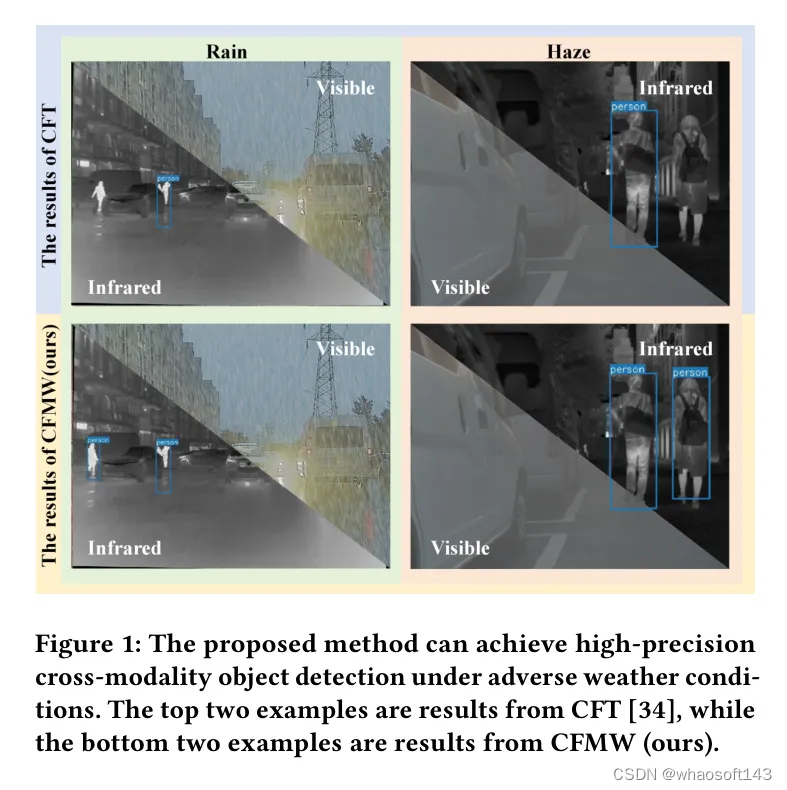

然而,如图1所示,这些方法的表现往往受到不利天气条件的挑战,这会严重影响视觉数据的可见性和质量。尽管红外图像在一定程度上可以提供补充线索,但它无法修复视觉图像的外观扭曲或信息丢失。因此,在不利天气条件下,传统的跨模态目标检测方法仍然面临严重的性能下降。

现有方法不能直接应用于不利天气条件,因为环境干扰削弱了可见图像的色彩范围,而现有的融合方法难以充分融合可见光和红外光谱,也没有在相应的数据集上进行充分的训练。为了填补这一研究领域的空白,作者构建并发布了一个名为严重天气可见-红外数据集(SWVID)的新数据集,并提出了一种名为带天气消除的跨模态融合曼巴(CFMW)的新框架。

为了促进该领域的研究,作者提出了一种新的可见-红外数据集,名为SWVID,它通过在图像上数学形式化各种天气现象的影响,旨在涵盖多样化的严重天气场景。具体来说,SWVID包含了对齐的可见-红外图像对,涵盖了三种天气条件和两种场景,每种条件和场景均匀分布。

受到图1中强调的关键研究缺口的启发,即在不利天气条件下,当前方法表现不佳,作者引入了CFMW,用于在不利天气条件下的多光谱目标检测。作者的CFMW利用天气消除扩散模型(WRDM)和跨模态融合曼巴(CFM)来提高不利天气条件下的检测精度。

图1。作者提出的方法可以在不利天气条件下实现高精度的跨模态目标检测。顶部两个示例来自CFT(杨等人,2017年),而底部两个示例来自CFMW(作者的)。

在最小化计算负担的同时。具体来说,在融合红外对应图像之前,使用WRDM来恢复受影响的可见图像,为图像融合网络提供即插即用的兼容性。基于学习逆转来增加噪声的顺序并破坏数据样本的过程,WRDM模型有利于最小化不利天气条件的影响。此外,CFM可以集成到特征提取的主干中,有效地整合来自不同模态的全局上下文信息。最近的研究表明,曼巴(Mamba,2019年)比等效规模的 Transformer 实现了更高的推理速度和整体指标。据作者所知,本研究代表首次尝试将扩散模型和曼巴用于多光谱目标检测。

在既有的和自创的数据集上的大量实验表明,作者的CFMW方法与现有基准相比,取得了卓越的检测性能。具体来说,与当前的图像恢复方法相比,作者实现了大约17%的性能提升。与CFT(杨等人,2019年)这种最先进的跨模态目标检测方法相比,作者提出的方法在节省51.2% GPU内存的同时,实现了大约8%的准确度提升。

概而言之,作者总结以下主要贡献:

-

作者引入了一个关注不利天气条件下可见-红外目标检测的新任务,并开发了一个名为严重天气可见-红外数据集(SWVID)的新数据集,该数据集模拟现实世界条件。SWVID包含了对可见-红外图像和标签,涵盖了如雨、雾和雪等天气条件;

-

作者提出了一种新方法,带天气消除的跨模态融合曼巴(CFMW),用于不利天气条件下的多光谱目标检测;

-

作者引入了天气消除扩散模型(WRDM)和跨模态融合曼巴(CFM)模块,以同时解决图像去天气化和可见-红外目标检测任务;

-

大量实验表明,这种整合实现了最佳的任务迁移能力,为这两个任务带来了最先进的性能。

2. Related Work

在本节中,作者简要回顾了关于跨模态目标检测、状态空间模型和多天气图像恢复的先前相关研究。

跨模态目标检测 现有的跨模态目标检测方法可分为两类:特征级和像素级融合,通过特征融合方法和时机来进行区分。最近,基于卷积神经网络的 双流目标检测模型在提高识别性能方面取得了很大进展(Chen等人,2019;Wang等人,2019;Wang等人,2019;Wang等人,2019;Wang等人,2019),而像素级融合方法也取得了良好的性能(Chen等人,2019;Wang等人,2019;Wang等人,2019)。其他采用诸如GAN等方法进行有效融合的工作也取得了良好结果(Wang等人,2019;Wang等人,2019;Wang等人,2019)。这些工作可以整合到如下游目标检测等任务中。传统的卷积神经网络具有有限的感受野,在使用卷积运算符时,信息只集成到局部区域,而 Transformer 的自注意力运算符可以学习长距离依赖(Wang等人,2019)。因此,提出了一种基于 Transformer 的名为Cross-Modality Fusion Transformer(CFT)(Yang等人,2019)的方法,并取得了最先进的检测性能。与这些工作不同,作者首先将Mamba引入跨模态目标检测中,通过门控机制学习长距离依赖,同时实现高准确度和低计算开销。

状态空间模型 状态空间模型的概念最初在S4模型(Shen等人,2017)中引入,提出了一种与传统卷积神经网络和 Transformer 相比能更有效建模全局信息的独特架构。基于S4,S5模型(Wang等人,2019)将复杂性降低到线性水平,而H3(Wang等人,2019)将其引入语言模型任务中。Mamba(Mamba,2019)引入了输入激活机制以增强状态空间模型,与同等规模的 Transformer 相比,实现了更高的推理速度和整体指标。随着Vision Mamba(Wang等人,2019)和Vnamba(Vnamba,2019)的引入,状态空间模型的应用已扩展到视觉任务中。目前,现有研究尚未考虑将状态空间模型有效地泛化到跨模态目标检测中。

多天气图像恢复 最近,一些尝试已经在一个单一的深度学习框架中统一了多个恢复任务,包括生成建模解决方案以恢复叠加噪声类型(Chen等人,2019),在未知测试时间恢复叠加噪声或天气损害,尤其是多天气图像退化(Chen等人,2019;Wang等人,2019;Wang等人,2019)。All in One(Wang等人,2019)采用多编码器和解码器架构统一了天气恢复方法。值得注意的是,基于扩散的条件生成模型在各种任务中显示出最先进的表现,例如带分类器引导的类条件数据合成(Chen等人,2019),图像超分辨率(Wang等人,2019),图像去模糊(Wang等人,2019)。针对一般线性逆图像恢复问题,提出了去噪扩散恢复模型(DDRM)(Dwork等人,2019),利用预训练的去噪扩散模型进行无监督后验采样。总的来说,到目前为止,扩散模型尚未被考虑在跨模态图像融合领域泛化到不利天气场景中。与现有工作不同,作者将多天气恢复扩展到跨模态融合领域。

3. Proposed Framework

Overview

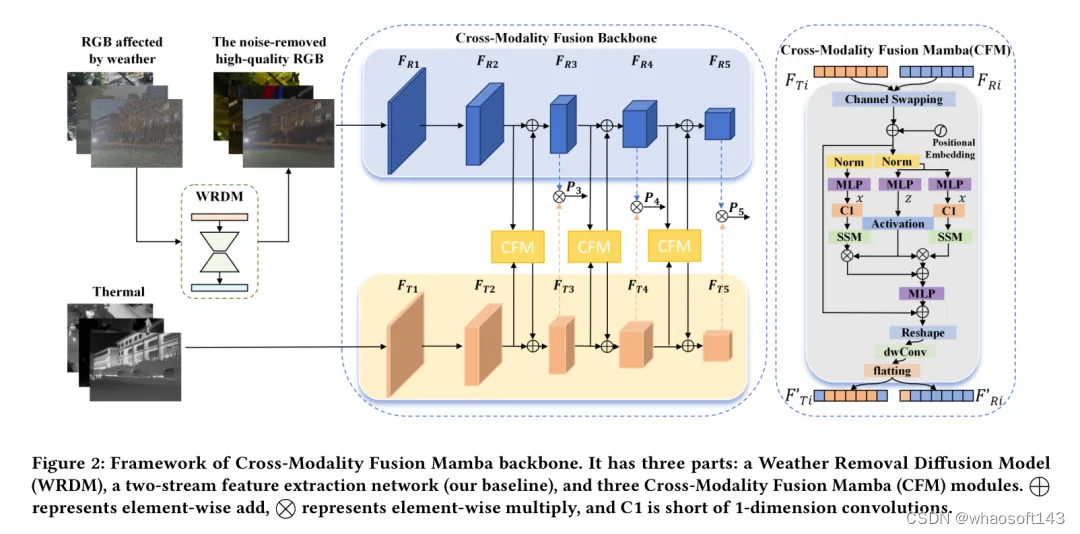

如图2所示,CFMW包括两个主要阶段。在多天气图像恢复阶段,作者的目标是实现三种不利天气条件(雨、雪、雾)的图像恢复,并使用只有一个预训练权重的统一框架来实现。在跨模态融合阶段,作者旨在整合不同模态的独特特征。受到CFT(Yang等人,2019)的启发,为了展示作者提出的CFM融合模型的有效性,作者将YOLOv5的框架扩展到支持多光谱目标检测。作者在最后一个子节中介绍了为WRDM和CFM精心设计的损失函数和训练过程。

Weather Removal Diffusion Model (WRDM)

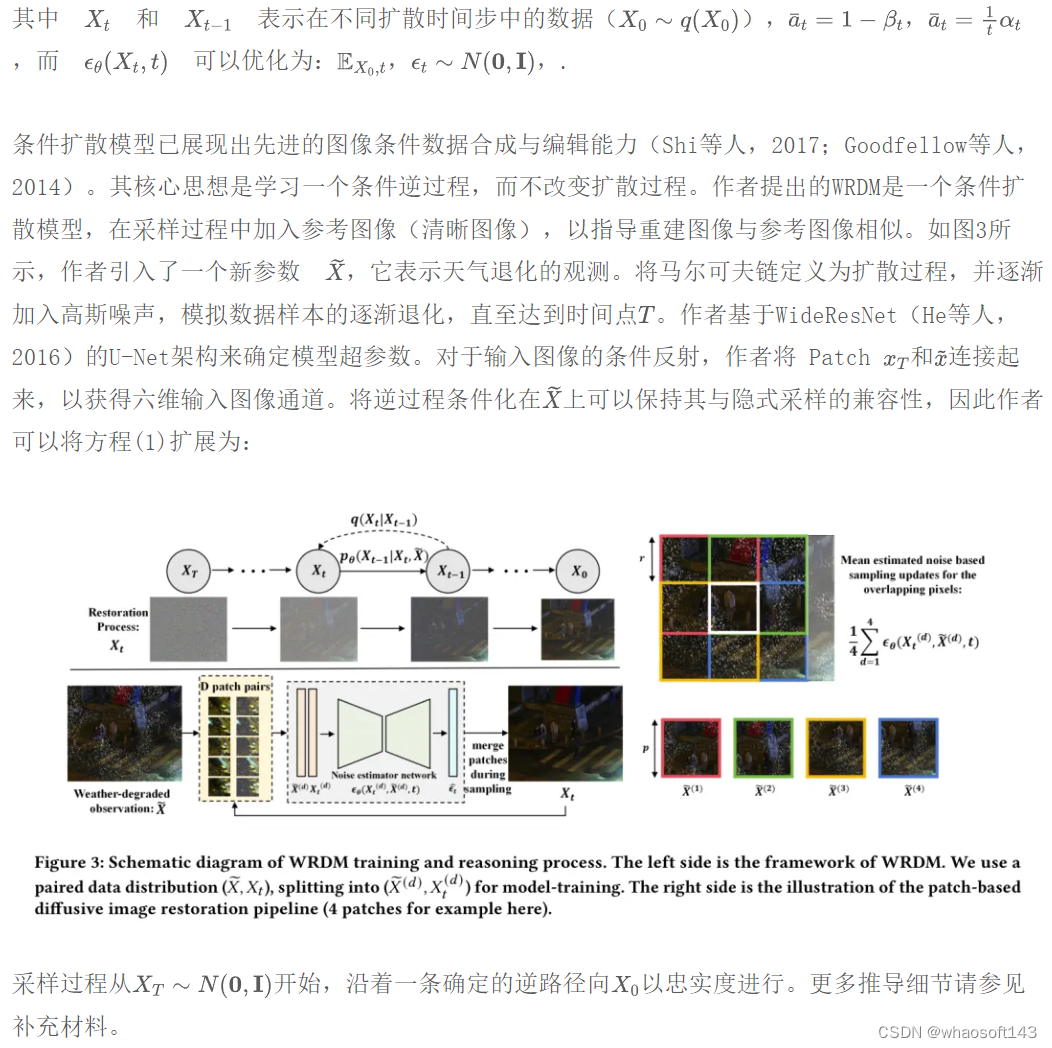

去噪扩散模型(Denoising, 1983; Wang et al., 2019)是一类生成模型,它们学习一个马尔可夫链,逐渐将高斯噪声分布转化为由模型训练的数据分布。最初的去噪扩散概率模型(DDPMs)(Shi et al., 2017) 的扩散过程(数据到噪声)和生成过程(噪声到数据)基于一个马尔可夫链过程,导致步骤繁多且耗时巨大。因此,提出了去噪扩散隐式模型(DDIMs)(Shi et al., 2017) 以加速采样,提供了一类更高效的迭代隐式概率模型。DDIMs 通过一类非马尔可夫扩散过程定义生成过程,这些过程与DDPMs具有相同的训练目标,但可以产生确定的生成过程,从而加快样本生成速度。在DDIMs中,隐式采样指的是以确定性的方式从模型的潜在空间生成样本。使用噪声估计网络进行隐式采样可以通过以下方式执行:

此外,WRDM可以被视为一个插件,嵌入到其他工作中,例如可见光与红外图像融合中,以消除多天气条件的影响,这在图5的实验中得到了证明。 whaosoft aiot http://143ai.com

Cross-modality Fusion Mamba (CFM)

关于CFMW的损失函数细节在补充材料中阐明。

4. Experiments

-

实验部分的开头。

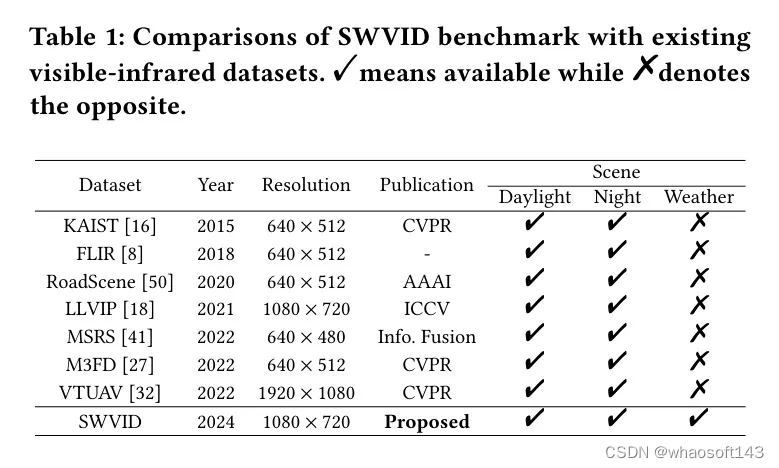

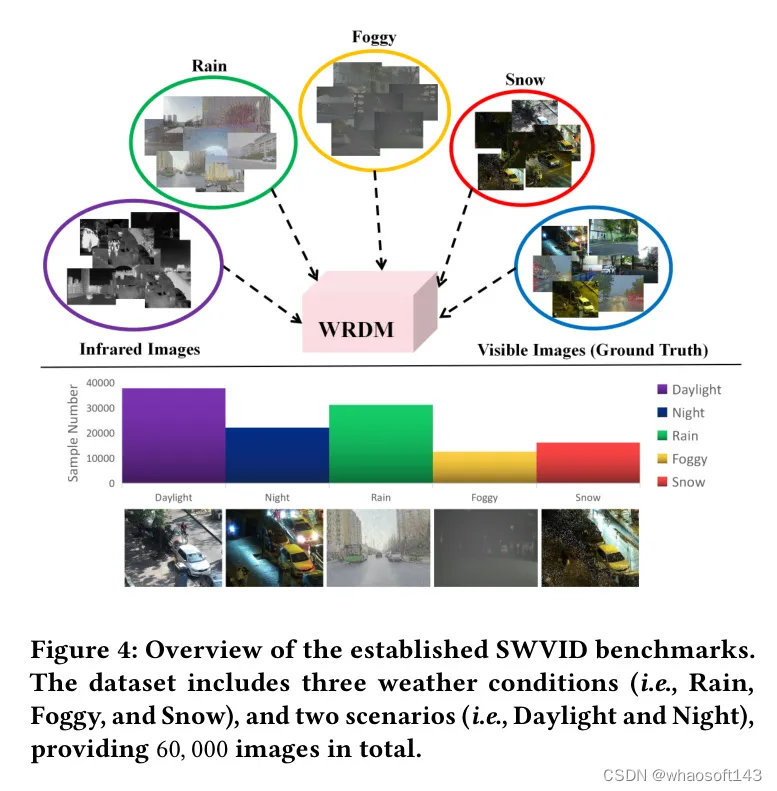

Established SWVID benchmark

数据集。在动态环境中,可见图像的色彩范围受到环境干扰的影响而减弱,现有的融合方法由于在相应数据集下缺乏足够的训练,难以充分融合可见光与红外光谱。如图4所示,作者建立了基准数据集SWVID,它是从真实场景中收集的公共数据集(即LLVIP(Kumar等人,2017年)、M3FD(Zhu等人,2017年)、MSRS(Zhu等人,2017年))构建的。它包含了多种均匀分布的场景(白天、夜晚、雨天、雾天和雪天),通过结合不同场景模拟真实环境。此外,作者为受到恶劣天气条件影响的每个可见图像提供了相应的 GT 图像,用于图像融合和图像恢复网络的训练。如表1所示,与先前的可见光-红外数据集相比,SWVID是第一个考虑天气条件的数据集。具体来说,作者从公共的可见光-红外数据集中构建了以下数据集:

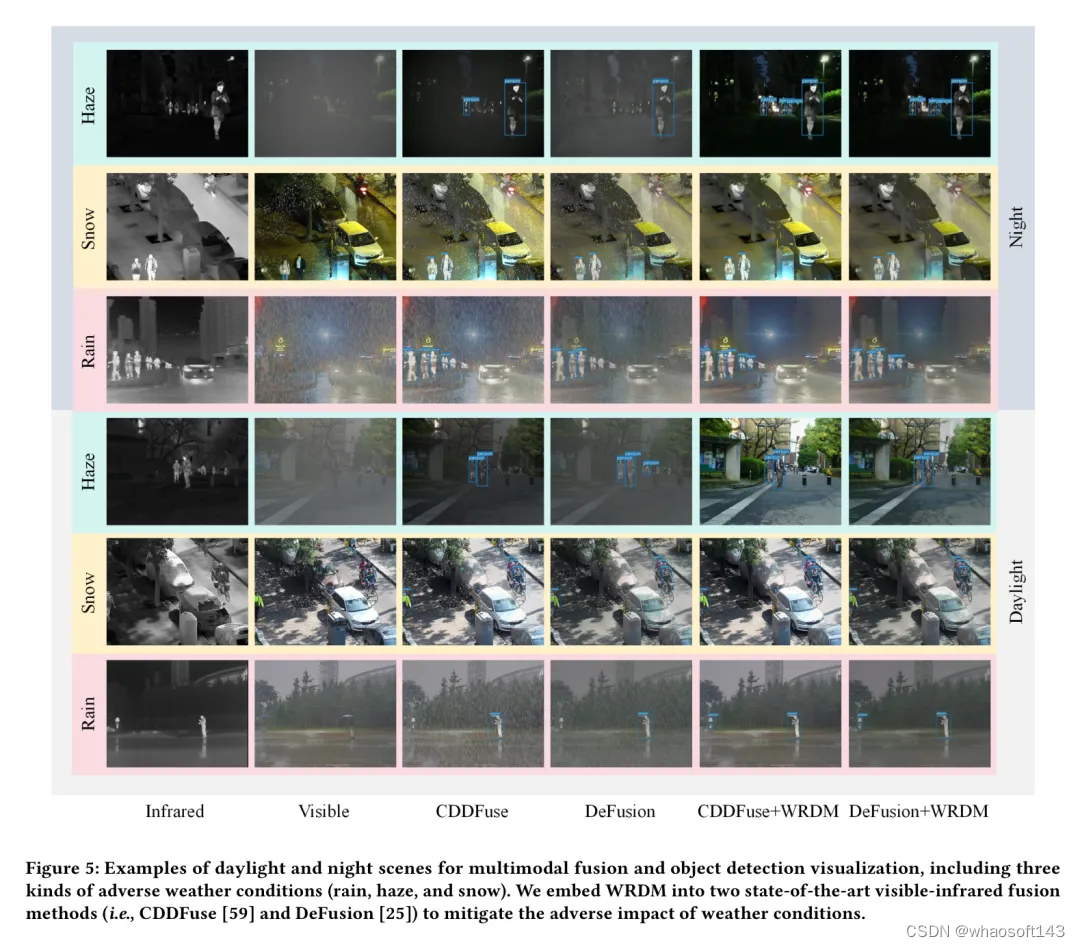

图5:多模态融合与目标检测可视化的白天和夜间场景示例,包括三种不利天气条件(雨、雾和雪)。作者将WRDM嵌入到两种最先进的可见光-红外融合方法中(即 CDDFuse [59] 和 DeFusion [25]),以减轻天气条件的不利影响。

评估指标。作者采用常规的峰值信噪比(PSNR)[15] 和结构相似性(SSIM)[47] 对 GT 和恢复图像之间的量化评估。PSNR 主要用于评估图像处理后失真的程度,而SSIM 更关注图像的结构信息和视觉质量。

在目标检测定量实验方面,作者引入了三种目标检测指标:平均精度均值(mAP、mAP50 和 mAP75)以评估目标检测模型的准确性。有关更多计算细节,请参阅补充材料。

Implantation Details

Comparative Experiments

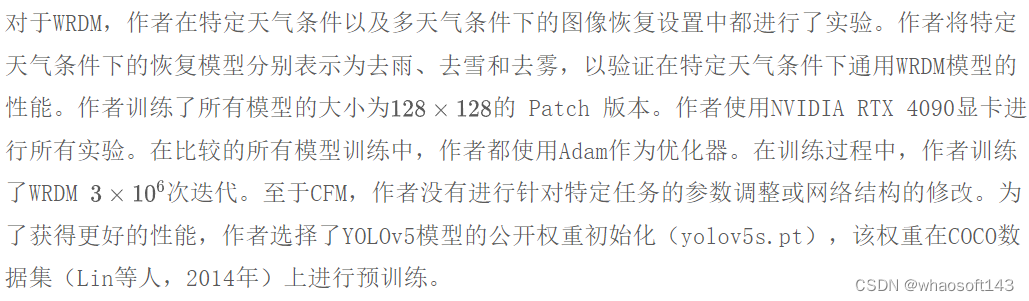

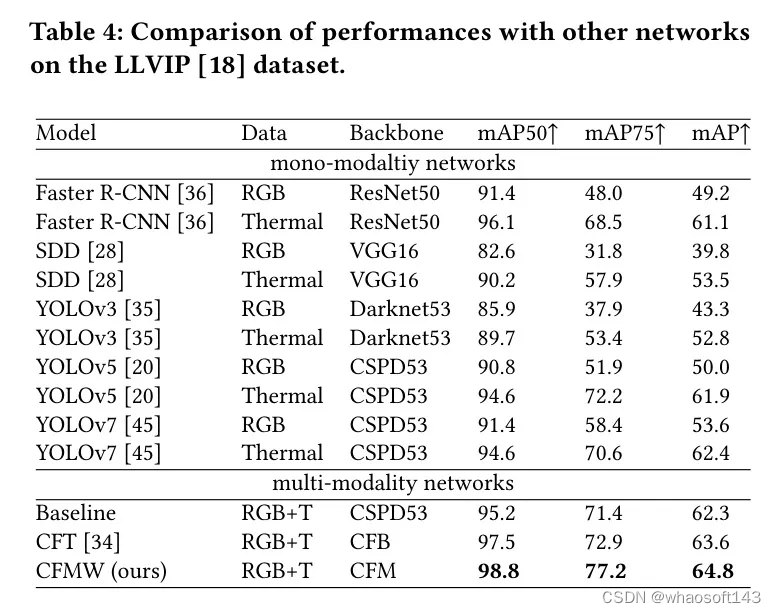

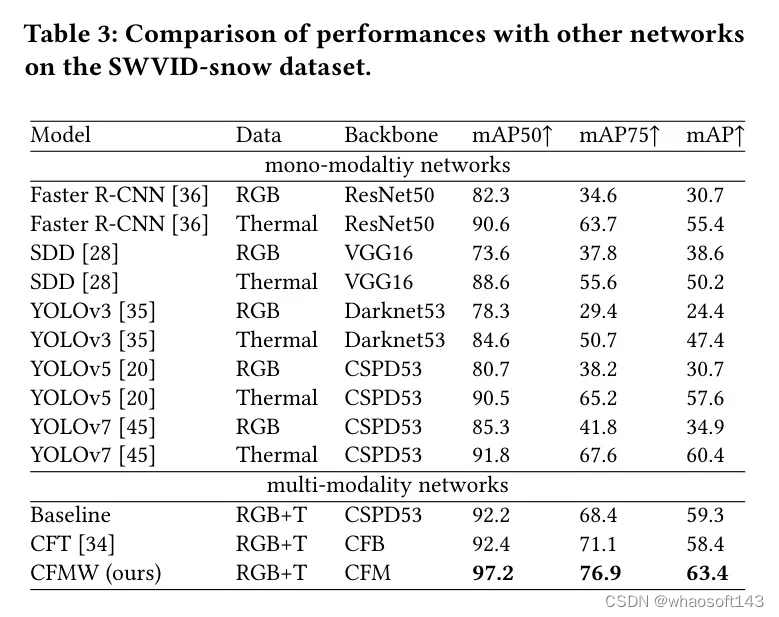

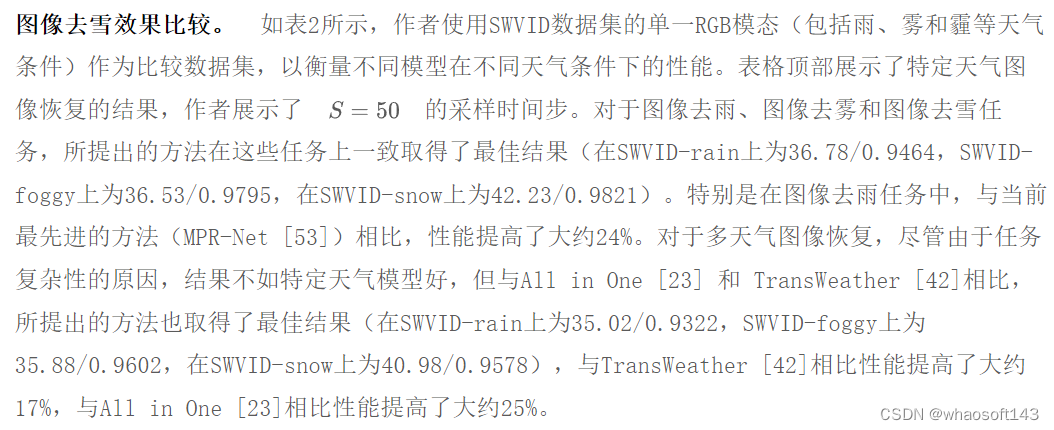

在本节中,作者分别与几种最先进的图像去雪、去雨和去雾方法以及跨模态目标检测方法进行比较。在表2中,作者进行了与以下图像去雪方法(如SPANet (Yang et al., 2017),DDMSNet (Chen et al., 2017),DesnowNet (Chen et al., 2017),RESCAN (Liu et al., 2017))的比较,去雨(如pix2pix (Liu et al., 2017),CycleGAN (Liu et al., 2017),PCNet (Liu et al., 2017),MPRNet (Wang et al., 2017)),以及去雾(如pix2pix (Liu et al., 2017),DuRN (Liu et al., 2017),Attentive-GAN (Liu et al., 2017),IDT (Liu et al., 2017))方法的比较,同时还与两种最先进的多天气图像恢复方法:All in One (Huang et al., 2016)和TransWeather (Liu et al., 2017)进行了比较。在表3和表4中,为了证明CFMW的持续改进,作者与几种基础的单一模态目标检测方法(例如,Faster R-CNN (Ren et al., 2015),SDD (Ren et al., 2015),YOLOv3 (Liu et al., 2017),YOLOv5 (Liu et al., 2017),YOLOv7 (Liu et al., 2017))以及几种多模态目标检测方法(例如,作者的 Baseline ,标准的双流YOLOv5目标检测网络,以及CFT (Liu et al., 2017))进行了比较。

表4. 在LLVIP (Liu et al., 2017)数据集上与其他网络的性能比较。

表2. 在PSNR和SSIM(越高越好)方面与最先进的图像去雨、去雾和去雪方法的定量比较。为了公平起见,作者统一使用建立的SWVID数据集的可见光部分作为评估数据集。

表3. 在SWVID-snow数据集上与其他网络的性能比较。

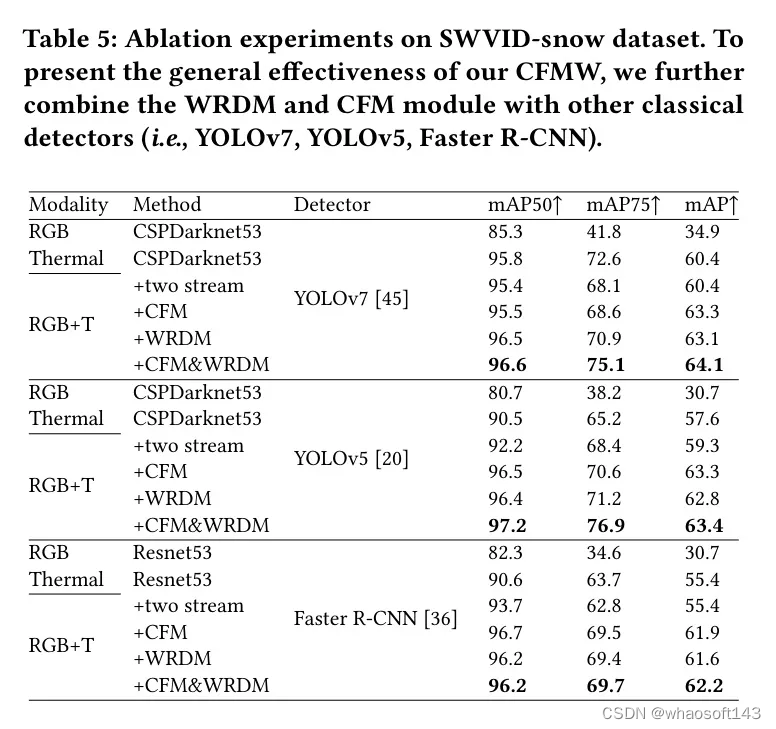

跨模态目标检测比较。如表3和表4所示,作者使用LLVIP [18] 和 SWVID-snow 作为比较数据集。与 SWVID-rain 和 SWVID-foggy 相比,这两个数据集中行人的大小更符合一般目标检测标准。这两个数据集中行人重叠的复杂情况更多,这可以更好地衡量目标检测网络的准确性。表格顶部展示了单模态网络的检测结果,每个网络使用 RGB 模态或热成像模态进行检测。表格底部显示了多模态网络的检测结果,包括作者的 Baseline 模型 CFT [34] 和所提出的 CFMW。根据表3,可以观察到,通过集成 WRDM 和 CFM,CFMW 在每个指标(mAP50:2.3↑, mAP75:4.3↑, mAP:3.0↑)上相对于每种指标上现有的最佳网络在 SWVID-snow 上都取得了压倒性的性能提升,这表明在恶劣天气条件下它具有更好的适应性。同时,如表4所示,CFMW 可以在较低的计算消耗下实现更准确的检测(mAP50:98.8, mAP75:77.2, mAP:64.8),这表明 CFWM 的普遍性。

Ablation Study

在本节中,作者分析了CFMW的有效性。首先通过详细的消融实验以参数形式验证了WRDM和CFM模块在性能改进中的重要性,然后从视觉上展示了WRDM在跨模态融合和目标检测任务中的作用,以突出其作为天气恢复插件的通用性。

消融实验 为了理解作者方法中每个组件的影响,作者进行了一系列全面的消融实验。如表5所示,作者将CFM和WRDM与其他经典检测器结合使用,例如YOLOv7 [45],YOLOv5 [20]和Faster R-CNN [36],以展示作者CFMW的普遍有效性。在复杂天气条件下,所提出的CFMW改进了一阶段或两阶段检测器进行跨模态目标检测的性能。具体来说,CFM在mAP50上实现了11.3%的提升,在mAP75上实现了81.6%的提升,在mAP(基于YOLOv5 [20])上实现了78.3%的提升。在加入WRDM后,作者在mAP50上实现了12.1%的提升,在mAP75上实现了88.2%的提升,在mAP上实现了80.4%的提升。CFM和WRDM为所有考虑的评价指标提供了不可忽视的提升。

视觉解释 为了直观地验证WRDM作为插件的适用性,作者从视觉上展示了WRDM在可见光-红外图像融合和目标检测领域的应用场景。如图5所示,作者与可见光-红外图像融合方法(例如CDDFuse [59],DeFusion [25])进行了比较。从图中可以看出,与原始图像相比,使用WRDM前后两种方法的图像融合效果相差很大,经过去天气处理后,可以成功检测到图像远端更多的人。在跨模态目标检测中,丰富的图像细节可以为特征提取和融合提供极大的帮助,直接融合而不去除天气影响会导致图像细节的损失和干扰。

5. Conclusion

在本工作中,作者提出了一种在恶劣天气条件下进行可见光-红外目标检测的新方法,即严重天气可见光-红外数据集(SWVID)。作者为在真实和具有挑战性的环境中训练和评估模型提供了宝贵资源。具有天气消除的跨模态融合Mamba(CFMW)模型,在提高检测准确性的同时,也能很好地管理计算效率。作者的大量实验表明,CFMW在多天气图像恢复和跨模态目标检测两项任务上都超过了现有基准,达到了最先进水平。这项工作为在恶劣天气下的跨模态目标检测开辟了新的可能性。

表5. 在SWVID-snow数据集上进行消融实验。为了展示作者CFMW的普遍有效性,作者进一步将WRDM和CFM模块与其他经典检测器(例如,YOLOv7, YOLOv5, Faster R-CNN)结合。

Appendix A Derivation of Denoising Diffusion Models

去噪扩散隐式模型提供了一种加速预训练扩散模型的确定性采样的新方法,该方法可以生成一致且质量更高的图像样本。接下来的隐式采样利用了广义非马尔可夫前向过程公式:

Appendix B More Details of Loss Functions

Appendix C More Details of Metrics Calculation

PSNR 可以按如下方式计算:

mAP50 在 IoU=0.50 的条件下计算所有类别所有 AP 值的平均值,而 mAP75 在 IoU=0.75 的条件下进行计算,同理。

更多推荐

已为社区贡献89条内容

已为社区贡献89条内容

所有评论(0)