论文阅读:Learning quadrupedal locomotion over challenging terrain(SCIENCE ROBOTICS 2020)

项目链接:https://leggedrobotics.github.io/rl-blindloco/像LiDAR和相机等外部传感器无法感知地面的诸如摩擦和顺应性等物理特性,在雪地、覆满植被的具有挑战性的地形下,需要将机器人的本体感受作为输入,控制器快速产生针对如保持平衡,避免自我碰撞等等多个目标的全身轨迹规划。读的第一篇Anymal相关的论文,没太搞清楚问题的formulation呜呜,几乎ge

·

简介

项目链接:https://leggedrobotics.github.io/rl-blindloco/

像LiDAR和相机等外部传感器无法感知地面的诸如摩擦和顺应性等物理特性,在雪地、覆满植被的具有挑战性的地形下,需要将机器人的本体感受作为输入,控制器快速产生针对如保持平衡,避免自我碰撞等等多个目标的全身轨迹规划。

材料与方法

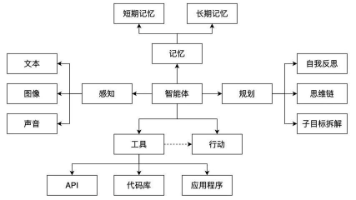

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-hqUUFGLf-1690442752847)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20230727123615443.png)]](https://i-blog.csdnimg.cn/blog_migrate/0565e9e72a49fdecddfda89440463afa.png)

- 策略训练:首先利用特权信息XtX_tXt包括机器人的当前状态、地形信息以及机器人和地面的接触信息,通过强化学习训练teacher policy。

- 策略训练:训练好teacher policy之后,将其用于监督训练只有本体感觉的student policy,它基于时序卷积网络(TCN),接收NNN个本体感受观测作为输入。student policy通过imitation的方式训练,由教师策略给出预期向量I‾t\overline{I}_tIt以及行动a‾t\overline{a}_tat,学生策略从本体感受到预期向量的映射。

- 自主地形课程:通过采样的方法为不同难度的训练课程采用不同的地形。

- 控制架构:使用策略调制轨迹生成器(PMTG)提供运动生成的先验。神经网络通过综合残差位置来调节腿部相位和运动原语。仿真使用带有关节位置PD控制器的动力学模型,这使得促进从仿真转化到现实,可以直接在真机上部署。

总结

读的第一篇Anymal相关的论文,没太搞清楚问题的formulation呜呜,几乎get不到方法的巧妙,感觉得往前追溯。还有补充强化学习的基础。

论文先是呈现了结果再讲方法和分析,核心结果就是一个鲁棒的通用运动控制器,可以使得机械狗适应各种复杂地形,方法主要分为在仿真环境下的策略训练和自主课程学习(ACL),两者相辅相成。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)