篇1-多尺度注意力论文总结,看多尺度注意力如何提升模型性能?

头部将第2、3、4阶段的输出(P2、P3和P4)通过1x1 卷积和标准上采样操作匹配空间和通道大小后,采用加法融合,然后经过几个 MBConv 块和输出层进行预测和上采样。:由通道注意力和空间注意力模块组成。编码器基于MobileNet,去除全连接层,使用多尺度卷积核(1×1、3×3和5×5)替代原有的3×3卷积核,扩大卷积感受野,增强特征提取能力;CSPDarkNet 生成多尺度特征图,PAFP

深度学习时代,良好的特征表达至关重要,我们围绕数据增强、模型结构、损失函数等进行创新,其中注意力机制因其即插即用、简单高效等特点,被工业界和科研界广泛使用。

本文收集了4篇多尺度注意力相关的文章,并对其进行简单解读,希望对您有启发。

Multi-scale coupled attention for visual object detection

论文简介

作者来自中国铁塔、中国地质大学。论文发表在nature旗下子刊。提出一种多尺度耦合注意力(MSCA)网络提升目标检测性能。

方法

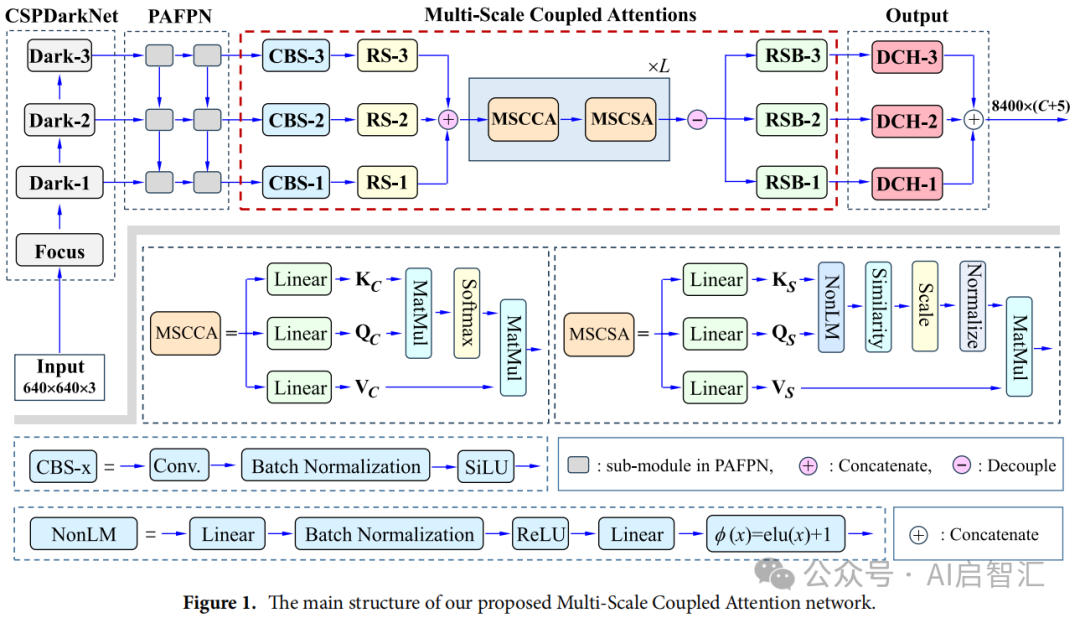

网络架构:基于YOLOX框架构建,由CSPDarkNet、PAFPN、MSCA和输出层组成。CSPDarkNet 生成多尺度特征图,PAFPN实现特征融合,MSCA作为颈部网络,通过多尺度耦合注意力对特征图进行处理,最后由输出层完成目标分类和定位 。

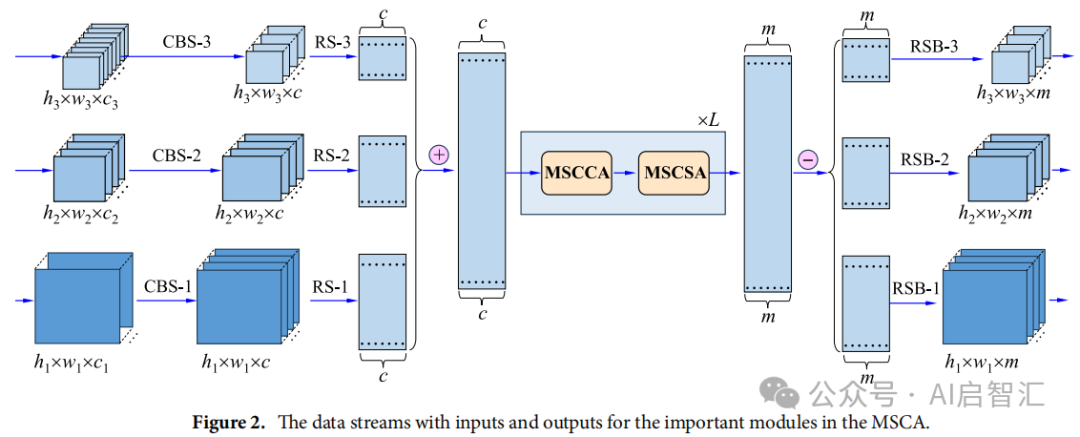

MSCCA 模块:对PAFPN输出的多尺度特征图,经CBS模块对齐通道后,用RS模块重塑为二维矩阵并拼接。通过线性自注意力机制,计算查询、键和值矩阵,经归一化和Softmax操作得到通道注意力,进而得到输出结果,提取重要通道特征 。

MSCSA 模块:以MSCCA输出为输入,通过线性投影得到查询、键和值矩阵。引入NonLM计算跨Gram矩阵的相似性,基于此进行自注意力操作,对不同尺度特征进行加权融合,最后经RSB模块将结果重塑为三维张量。

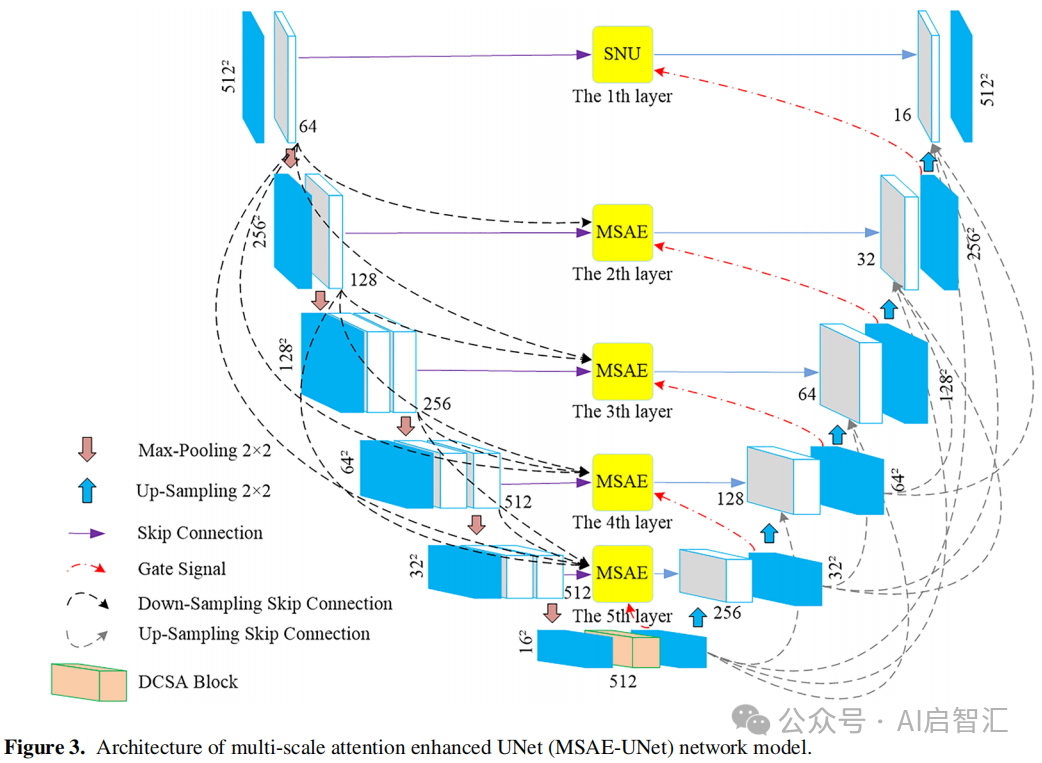

Multi-Scale Attention‐Enhanced Deep Learning Model for Ionogram Automatic Scaling

论文简介

作者来自湘潭大学,论文发表在《Radio Science》,提出了一种多尺度注意力增强的深度学习模型用于电离图自动标度。

方法

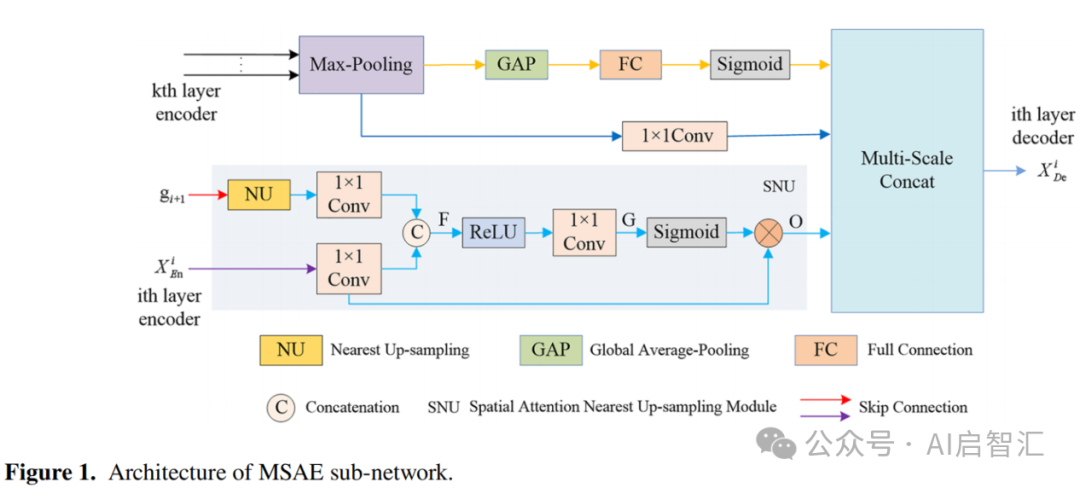

多尺度注意力增强(MSAE)子网络:由通道注意力和空间注意力模块组成。包含多个多尺度残差通道注意力模块,通过残差结构获取多尺度上下文信息。在第i层编码器和解码器间添加空间注意力最近邻上采样(SNU)模块。其输入分别来自第i层编码器和更高层解码器输出。SNU模块通过一系列卷积、激活等操作,将高低层特征结合,学习目标物体上下文和位置信息。最终,特征图拼接后传输给解码器,实现多尺度特征融合。

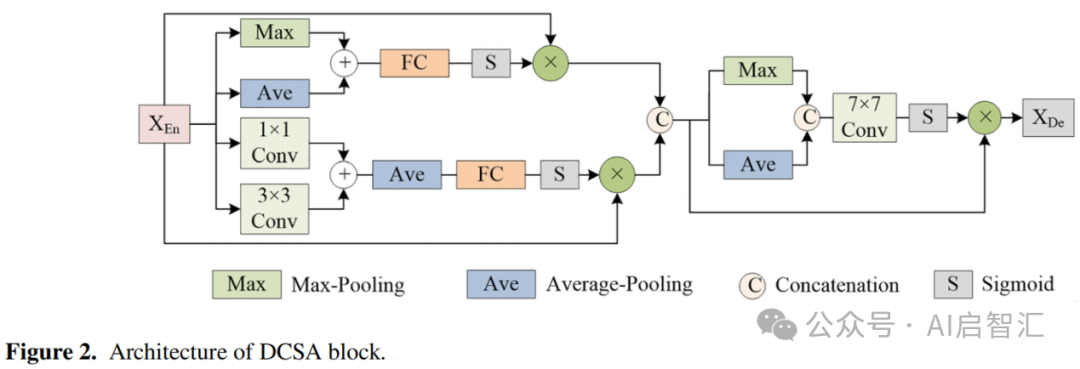

双通道空间注意力(DCSA)块:添加在编码器和解码器之间。由并行的双注意力通道和一个空间注意力门组成,基于位置维度处理输入特征图。通过最大池化、平均池化以及不同卷积核操作获取不同特征信息,再经过一系列操作优化深度特征提取。

基于MSAE-UNet的电离图自动标度方法:以MSAE子网络、DCSA块和原始UNet网络为基础。VGG16作为编码器骨干网络。解码器使用2×2双线性上采样和双3×3卷积核。采用多尺度跳跃连接。网络中每个编码器-解码器层都有一个MSAE子网络。

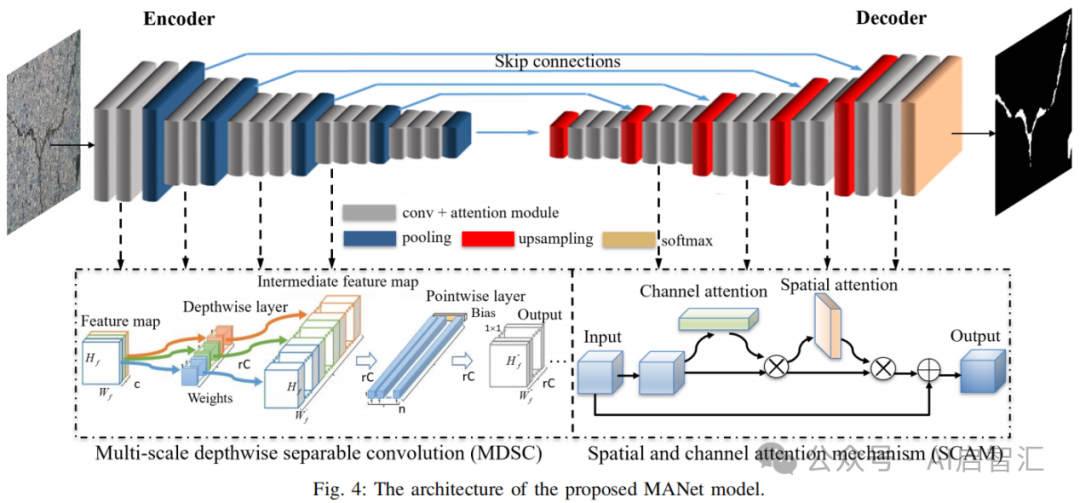

Multi-scale attention networks for pavement defect detection

论文简介

作者来自查普曼大学、厦门大学等,论文发表在《IEEE Transactions on Instrumentation and Measurement》中科院2区。论文提出多尺度移动注意力网络(MANet)用于路面缺陷检测。

方法

MANet模型:采用编码器-解码器架构。编码器基于MobileNet,去除全连接层,使用多尺度卷积核(1×1、3×3和5×5)替代原有的3×3卷积核,扩大卷积感受野,增强特征提取能力;包含输入卷积层和12个深度可分离卷积块,输出14×14×512的特征图。解码器用于恢复图像细节,嵌入混合注意力模块,去除冗余信息,准确定位裂缝并恢复缺陷细节;由4个卷积块组成,每个卷积块后嵌入注意力模块,融合高低层特征输出结果。使用增强的焦点损失函数(EFL)。EFL 函数通过引入加权因子和调制因子,调整不同类别样本的损失权重。

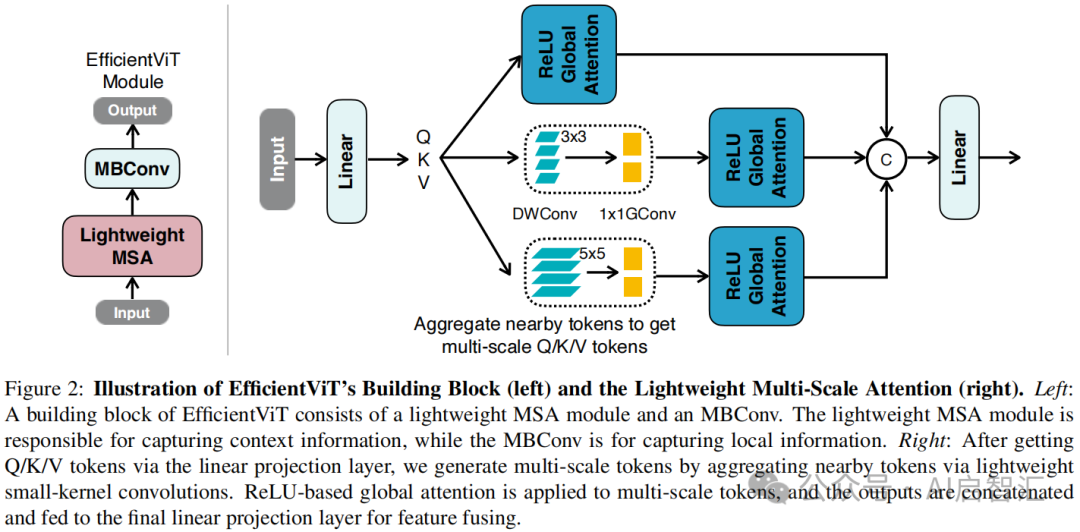

EfficientViT: Lightweight Multi-Scale Attention for High-Resolution Dense Prediction

论文简介

作者来自麻省理工学院、浙江大学等,论文发表在ICCV,CCFA类顶级会议。论文提出EfficientViT模型,一种轻量级多尺度注意力模块实现高效的高分辨率密集预测。

方法

轻量级多尺度注意力模块(LMSA):使用基于ReLU的全局注意力替代传统的自注意力来获得全局感受野,通过深度卷积增强其局部信息提取能力。利用小核卷积聚合附近的 Q/K/V 令牌来生成多尺度令牌,信息聚合过程对每个头中的Q、K 和 V 独立进行,且仅使用小核卷积以避免影响硬件效率。实际实现中,将所有深度卷积(DWConv)融合为单个DWConv,所有1x1卷积合并为单个1x1分组卷积,减少总操作数。

EfficientViT 架构:由轻量级MSA模块和MBConv组成。轻量级MSA模块负责捕捉上下文信息,MBConv用于捕捉局部信息。骨干网络包含输入Stem和四个阶段,在第3和第4阶段插入EfficientViT模块,下采样使用步长为2的 MBConv。头部将第2、3、4阶段的输出(P2、P3和P4)通过1x1 卷积和标准上采样操作匹配空间和通道大小后,采用加法融合,然后经过几个 MBConv 块和输出层进行预测和上采样。

以上4篇就是关于多尺度注意力的论文,希望对您有启发。

仅供学习交流参考,感谢阅读!

如果需要论文pdf文件,可微信搜索公众号【AI启智汇】关注并回复【多尺度注意力】获取以上所有论文,感谢阅读!

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)