6.ComfyUI的ControlNet实操

今日分享ComfyUI之ControlNet使用。

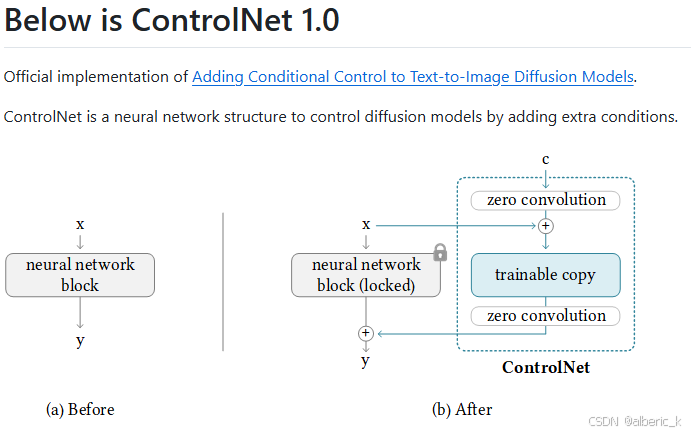

1. 概念

ControlNet 是一种神经网络算法,其作用在于控制预训练的图像扩散模型(如 Stable Diffusion)进行图像生成。它允许输入诸如涂鸦、边缘图、姿势关键点、深度图、法线图、分割图等多种类型的调节图像,这些输入条件能够作为条件输入以指导生成图像的内容。需明确的是,ControlNet 是一种用于控制预训练图像扩散模型生成图像的算法,可与 Stable Diffusion 模型搭配使用,但并非只能用于 Stable Diffusion 中,且在使用ControNet的时候需要模型与之对应。

2. 使用场景

ControlNet 的使用场景极为丰富。若想控制生成图像中人物的姿势,可给定一张参考图,借助姿势控制模型提取人物姿势进行控制;在生成室内装修设计图时,能根据给定的法线图进行控制;还可以简单绘制涂鸦草图,让 AI 依据此草图进行绘制等等。鉴于 AI 绘图属于创造性工作,无法穷尽所有场景。大家可先形成初步印象,接着尝试不同的 ControlNet 模型,充分发挥想象,将其运用到合适的需求场景中。

3. 官方网址

链接:lllyasviel/ControlNet: Let us control diffusion models! (github.com)

介绍:ControlNet是一种神经网络结构,通过添加额外的条件来控制扩散模型。

4. 基础使用

ControlNet的使用首先就需要注意一点,ControlNet需要与模型及模型的版本一一对应。

4.1 ControlNet插件安装及使用

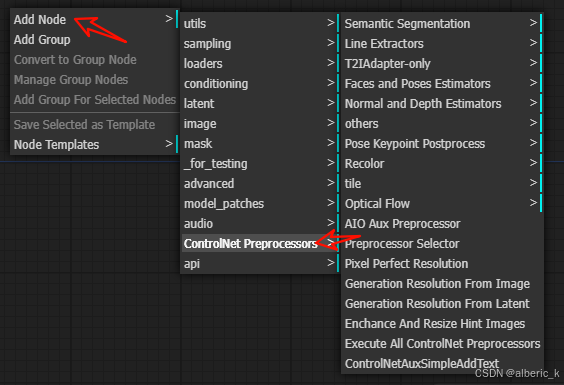

ComfyUI_controlNet_aux:一个ControlNet的预处理器。

网址:comfyui_controlnet_aux

说明:这个只是一个预处理器,在ComfyUI界面提供了丰富的处理节点,但是节点使用的模型还是需要下载。(这个时候就需要配置网络,也可以先进行下载再放在对应的文件夹。)

插件网盘链接:

安装方式:将下载的插件解压到ComfyUI/custom_nodes文件夹下面。再点击其中的install.bat,重新打开ComfyUI之后就可以看到如下节点:

使用:在使用的时候不需要自己安装具体的模型,但是需要配置科学网络。

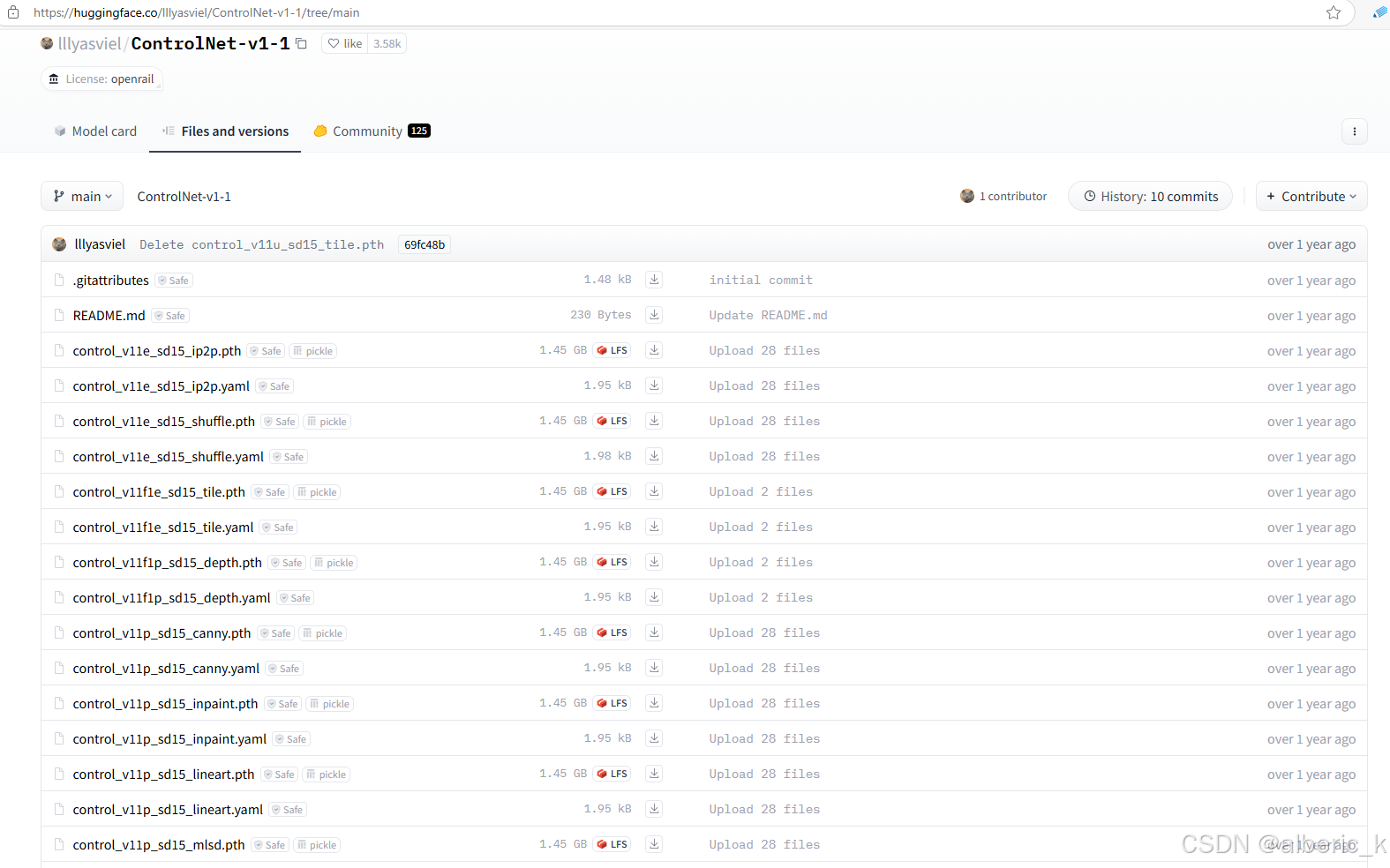

4.2 模型安装

目前ControNet的使用已经非常丰富了,阿里、字节、腾讯等团队都开源了很多厉害的产品,后期会对这些优秀的产品进行实操演示。这里想讲的是,对于ControlNet模型的使用,需要根据具体的产品来,而一些经典的模型尤其是SD生态的产品在Huggingface上能找到其对应的ControlNet模型。

网址:lllyasviel/ControlNet-v1-1 at main (huggingface.co)

4.3 ControlNet使用

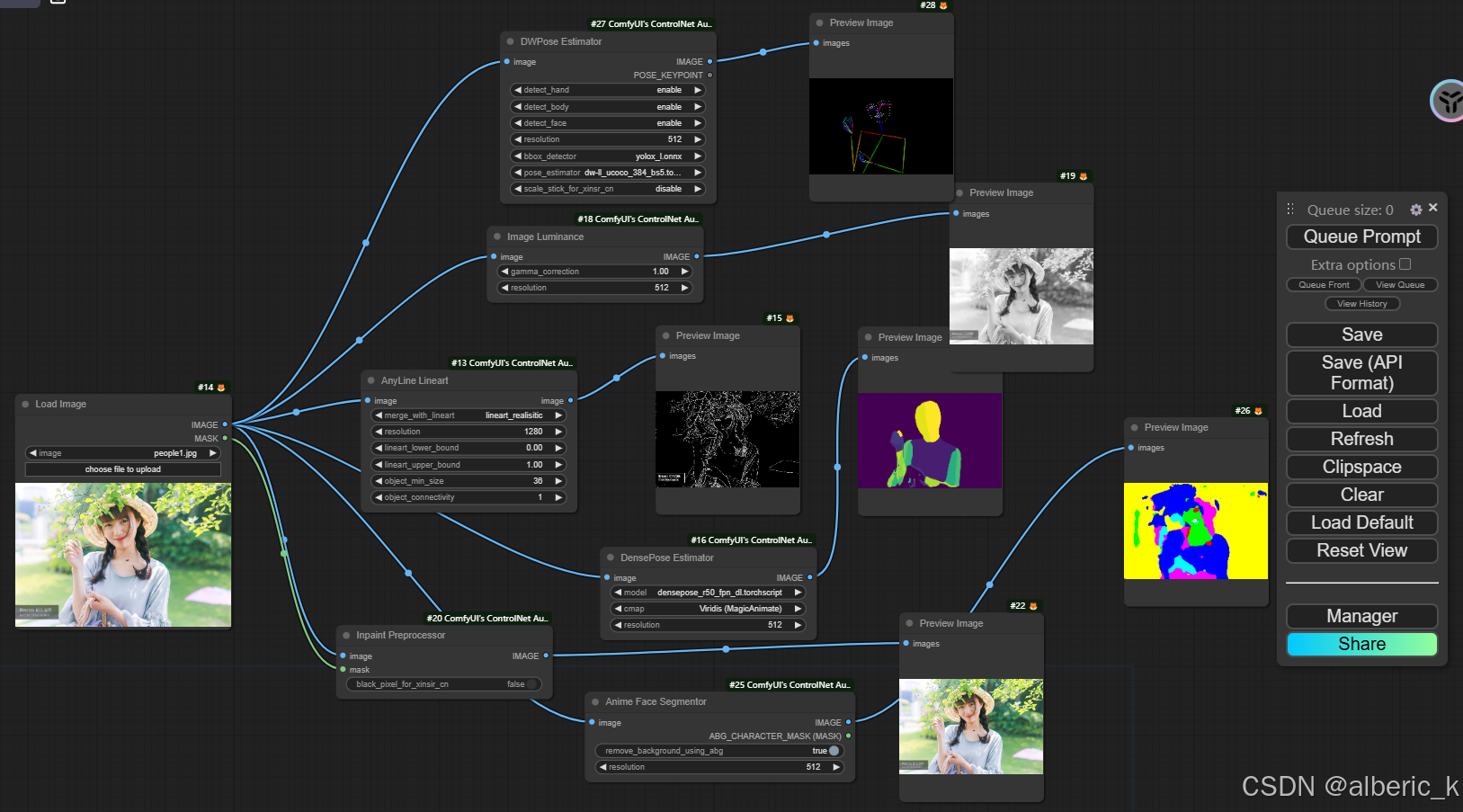

上面的插件预处理器是通过计算获取图片人物姿态、图片颜色分布、图片线条等内容的。如果想要将上面的内容与图片生成结合,就需要用到上面的ControlNet模型。

具体怎么使用需要结合ComfyUI的出图逻辑,可以将其看作一种提示控制图片的生成,所以它应该要和提示词连接起来。(本质上是一段tocken元组,用于控制图片的生成)

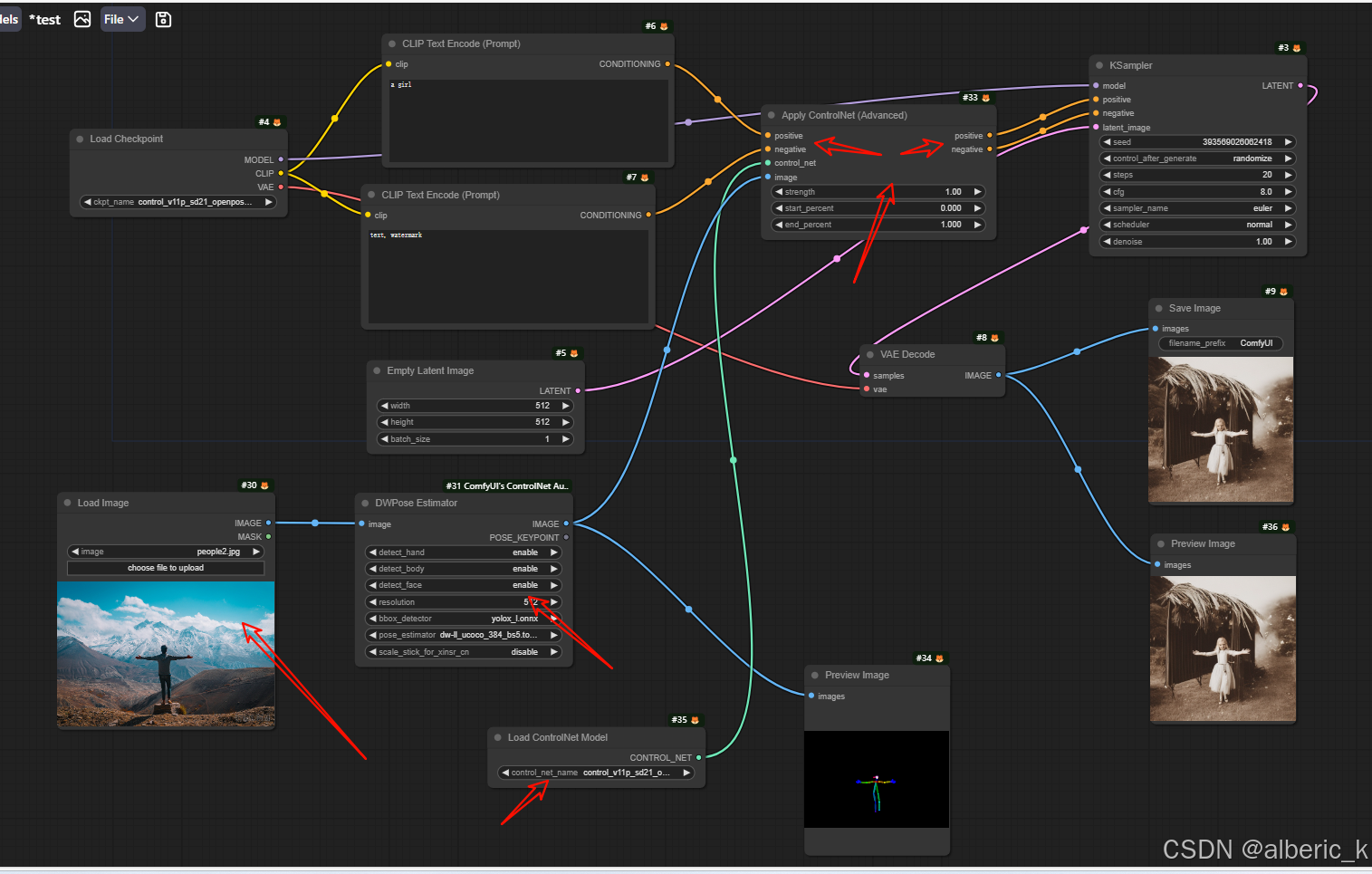

4.3.1单个ControlNet使用

使用思路:ControlNet本质上就是通过调节参数的方式,更精确的控制图像的输出,所以其效果和应用方式和提示词是有点像的。在应用上也是将其放在提示词后面,抽样器前面。

可以看到,这里就是通过预处理器插件提取图片的人物姿势,然后将其链接到正向、方向提示词后面,然后形成新的正向、反向提示词输入到抽样器中。

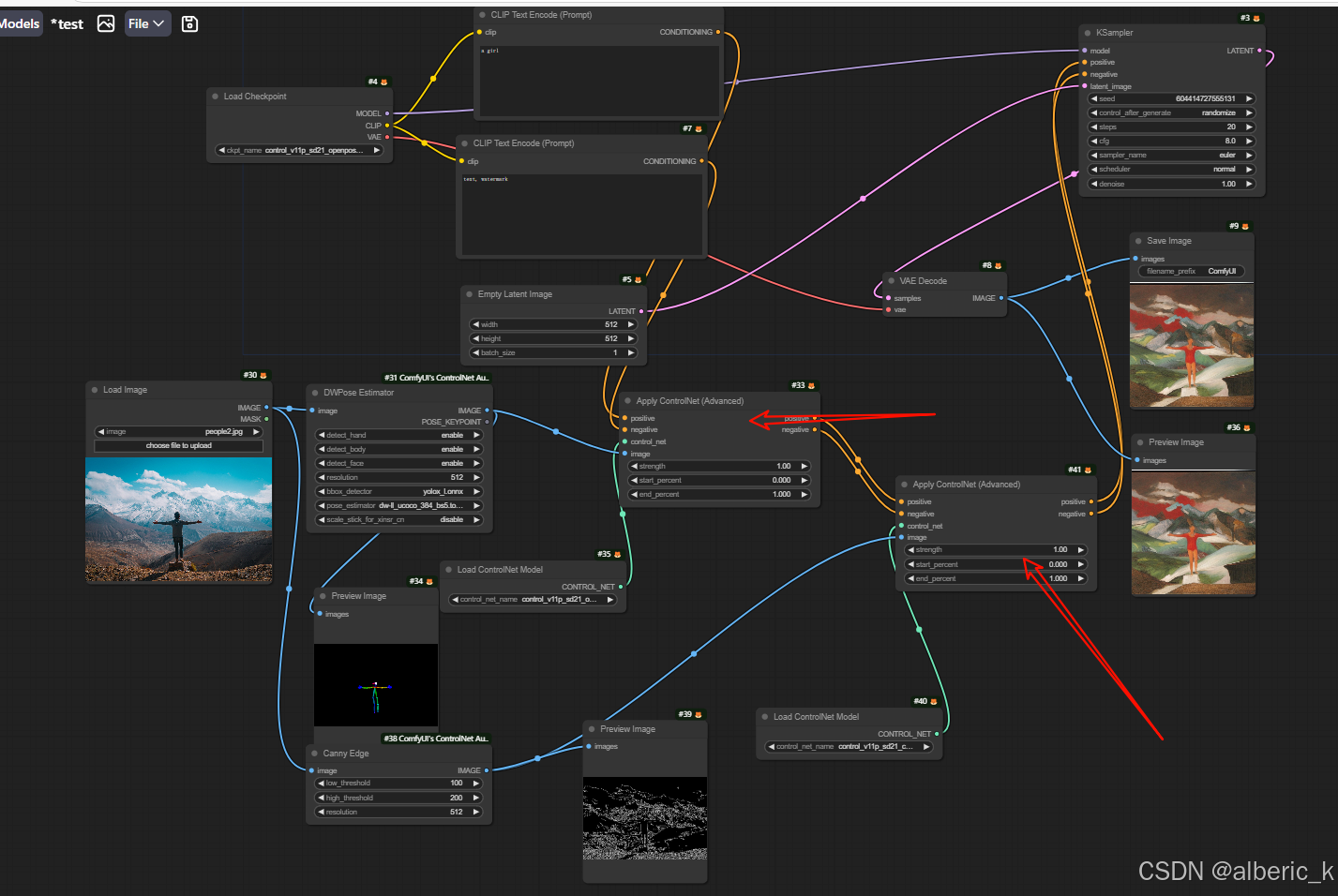

4.3.2多个ControlNet使用

使用思路:将多个ControlNet进行串联。

此处因为初始图像比较复杂,新生成的图像效果较差。

5.链接

ControlNet v1.1 模型支持stable diffusion 1.5 或2.0 – ComfyUI-WIKI

上面的网址中可以查看模型及对应的ControlNet模型。

6. 网盘

本文主要作为一个学习使用,展示了ControlNet在控制图像生成方面的效果。

如果想要尝试上面的内容,可以从下面的网盘下载对应的模型。

网盘链接:https://pan.quark.cn/s/54b3a200681d

感谢阅读,如果你喜欢我的内容,欢迎点赞关注。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)