nltk.sent_tokenize() nltk.word_tokenize()利用分句子,分词,

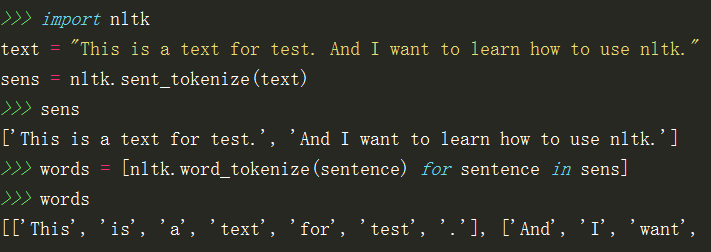

分词nltk.sent_tokenize(text) #按句子分割nltk.word_tokenize(sentence) #分词nltk的分词是句子级别的,所以对于一篇文档首先要将文章按句子进行分割,然后句子进行分词:http://www.pythontip.com/blog/post/10012/...

·

分词

nltk.sent_tokenize(text) #按句子分割

nltk.word_tokenize(sentence) #分词

nltk的分词是句子级别的,所以对于一篇文档首先要将文章按句子进行分割,然后句子进行分词:

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)