分类问题——判别分析(LDA、QDA)

每天进步一点点——分类问题之判别分析

·

一、前言

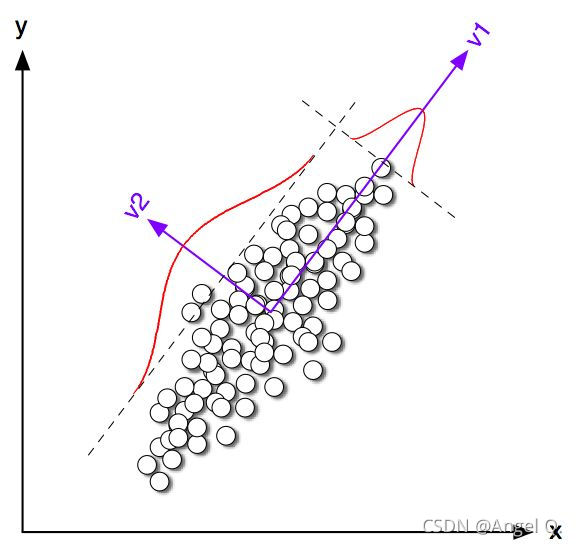

1.理解方差最大法

在PCA(主成分)里,该方法经常被使用。在一个正交坐标系下使PCA1(即V1)的方差最大,而PCA2(V2)的方差最小,实现了降维(二维降成了一维)

2.均值实际上就是重心

我们可以想象在计算杠杆时,使得两边相等的时候,中间那个点就是均值。

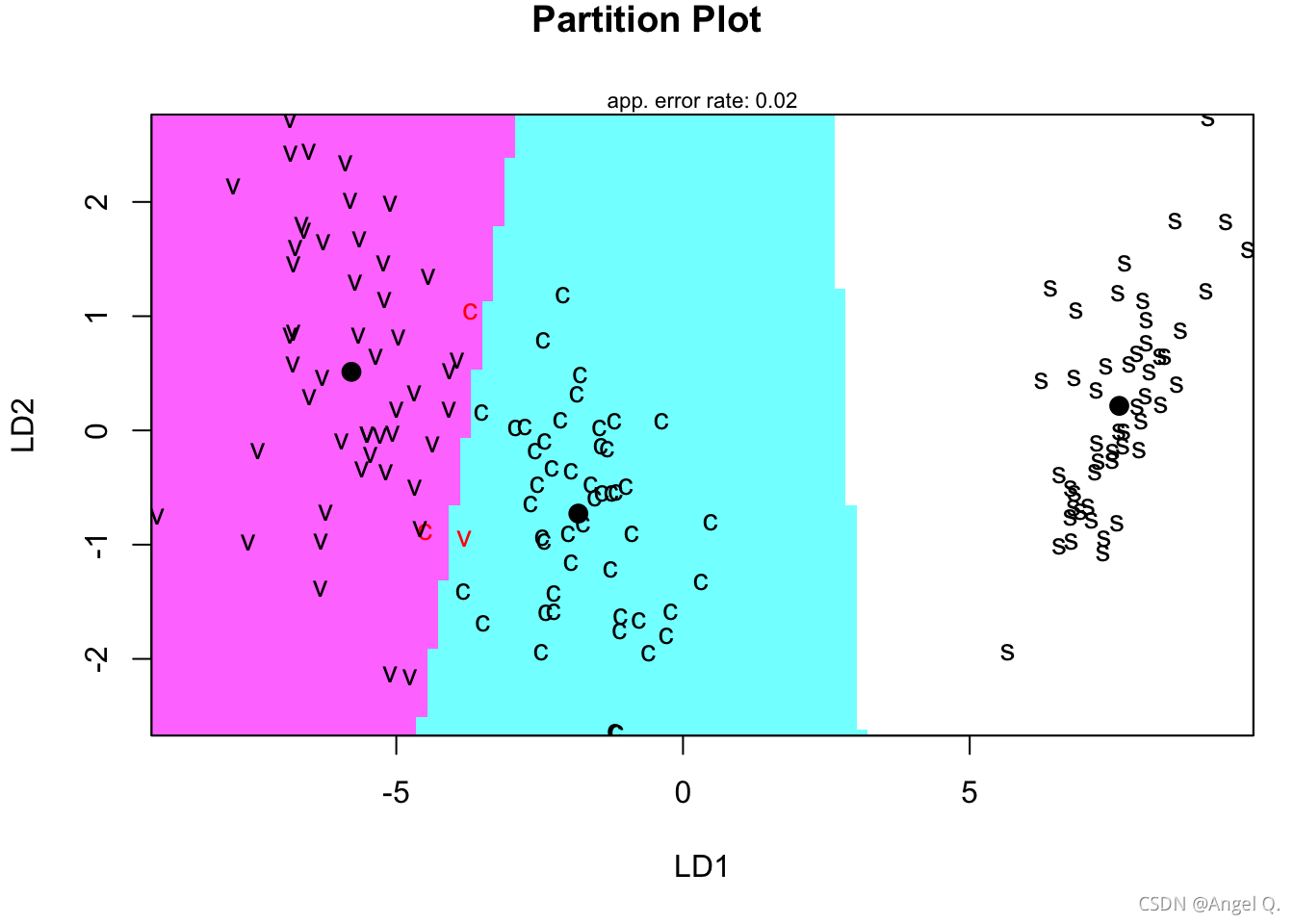

二、LDA(线性判别)的直观理解

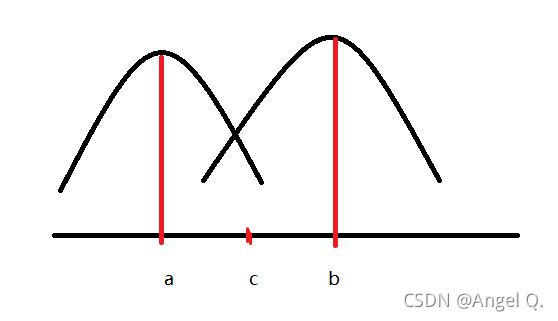

二分类问题——直线:

一维:找到各自均值a,b,取中点作为c,即从c点向x轴作垂线,即可把a与b类分开。

二维:每个椭圆,找在轴上的投影,与一维同理,最终都可转为直线的中点

三维:每个椭球,找在轴上的投影,与一维同理,最终也都可转为直线的中点

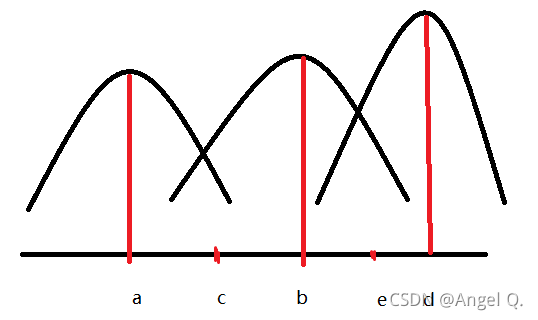

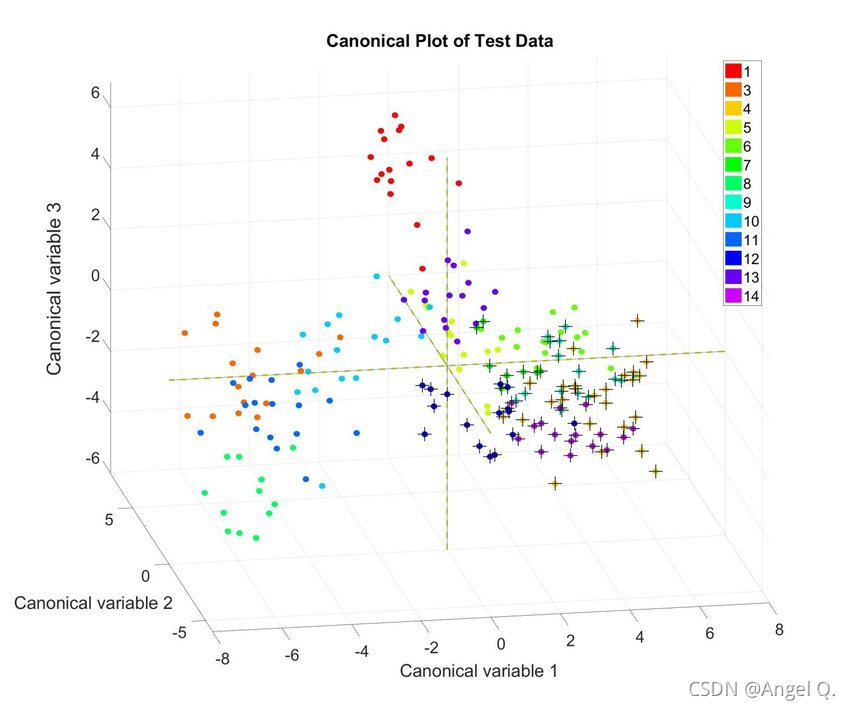

三分类问题——平面:

一维:以c,e为轴画两条线分开,两条线也就组成了一个平面

二维:

三维:

所以,我们可以发现这些聚类维度都是由分类个数决定的,而不是预测变量。比如我们有1000个预测变量,但我们是三分类,所以维度最高还是3。

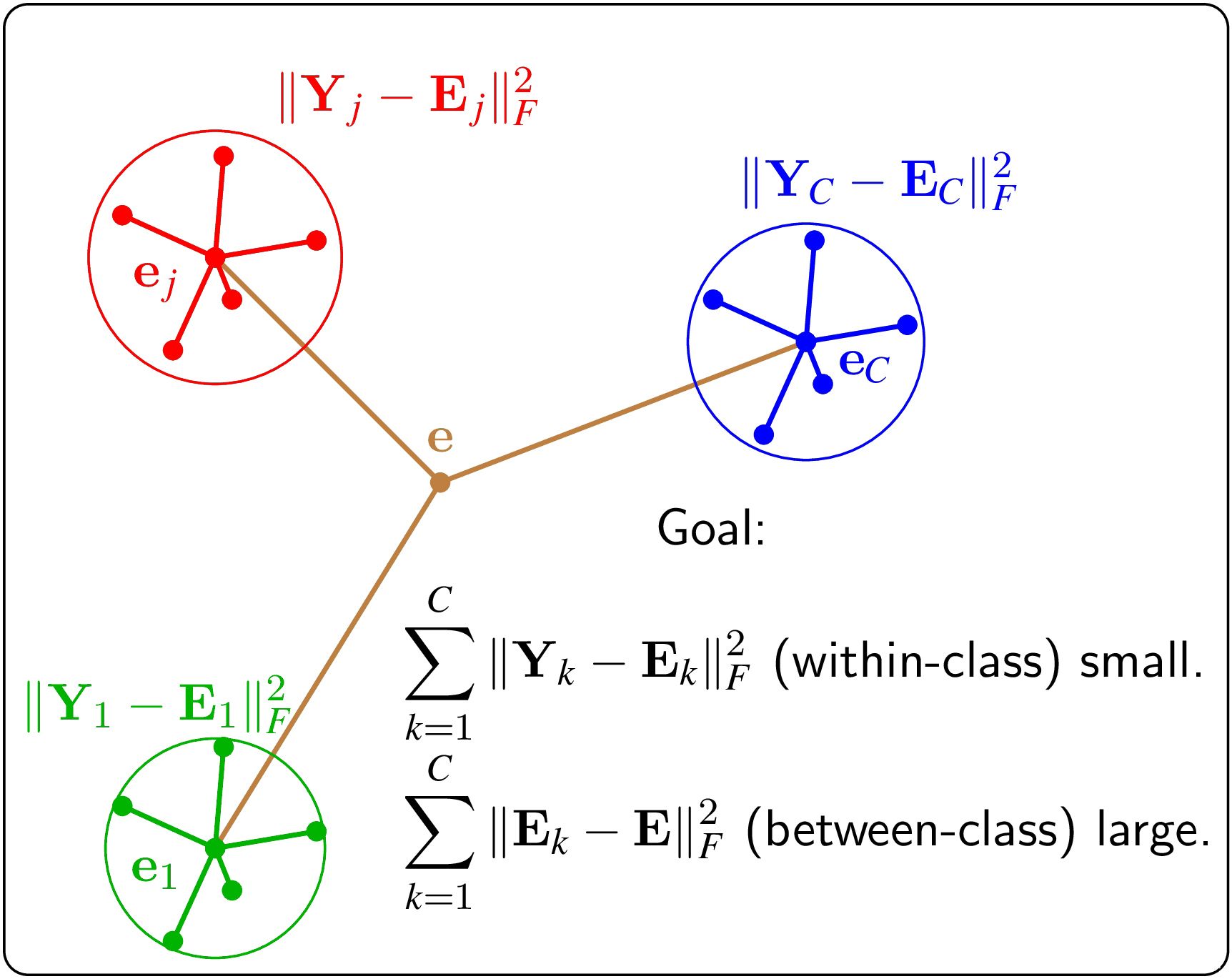

三、判别分析分类原则

1.各类别均值之间的距离最大

2.组内方差最小

其他原则一致的方法举例:

LCA潜类别分析(网格方法,找阈值)

聚类(虽然是无监督学习,但R中提供了轮廓系数来反映聚类效果)

方差分析中的F统计量

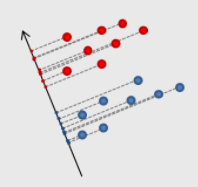

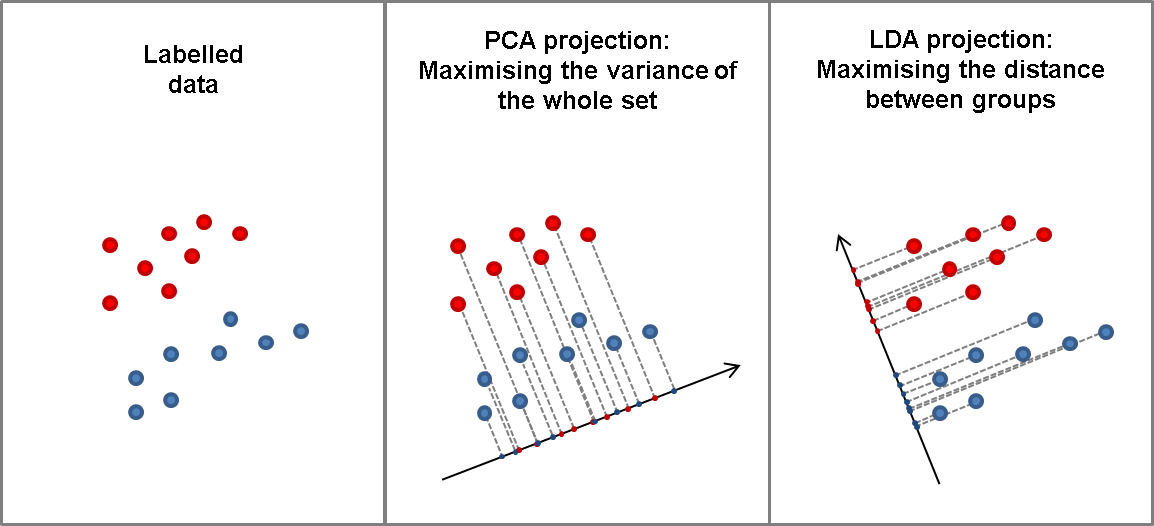

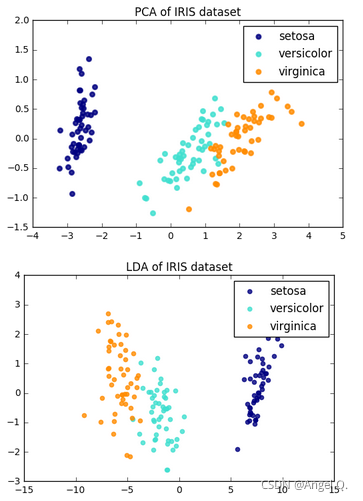

四、LDA与PCA的区别

| 方法 | 目的 |

|---|---|

| LDA | 把不同类别分开,为了解决分类问题 |

| PCA | 最大程度地解释数据的变异,用尽可能少的主成分来表示,为了降维 |

例子:

五、改进先验分布的LDA

LDA本质上是一个贝叶斯模型,在默认情况下,是以频数作为先验概率,可以通过调整先验概率来改进模型,但改变先验不可脱离实际。

六、QDA(二次判别分析)

假设每一类观测都服从一个高斯分布,与LDA不同的是,这里假设每一类观测都有自己的协方差矩阵,也就是方差不在相同,所以就不再是线性的了。

经过一些实例我们可以发现它相比于LDA更真实但也更容易产生过拟合。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)