认识大模型--什么是“温度系数”

它通过调整模型输出概率分布的“平滑程度”,直接影响生成内容的创造性与稳定性。若模型本身缺乏某些知识,降低温度也无法“创造”正确答案。在机器学习(尤其是生成模型,如GPT、LLM等)中,(例如预测下一个词的概率)。温度系数作用于模型的。是一个控制模型生成结果。

·

在机器学习(尤其是生成模型,如GPT、LLM等)中,温度系数(Temperature) 是一个控制模型生成结果随机性和多样性的关键参数。它通过调整模型输出概率分布的“平滑程度”,直接影响生成内容的创造性与稳定性。

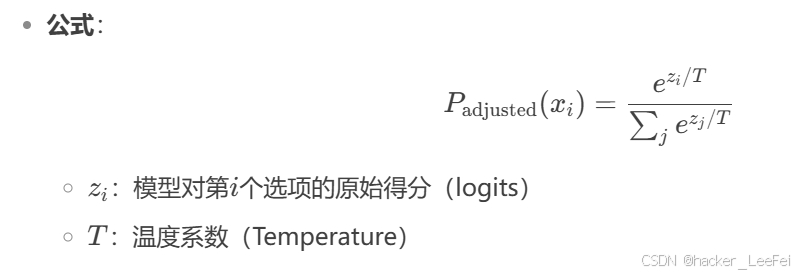

核心原理

模型的输出本质是概率分布(例如预测下一个词的概率)。温度系数作用于模型的Softmax函数,通过缩放概率值改变分布的集中程度:

温度系数的作用

| 温度值 | 对概率分布的影响 | 生成结果特点 | 典型场景 |

|---|---|---|---|

| 高温度 | 概率分布更平缓(接近均匀分布) | 随机性高、多样性丰富,但可能偏离主题 | 创意写作、发散性头脑风暴 |

| 低温度 | 概率分布更尖锐(高概率项更突出) | 结果稳定、保守,但可能重复或呆板 | 技术文档生成、事实性问答 |

| T=0 | 直接选择概率最高的选项(完全确定性) | 输出固定,无随机性 | 调试或需要严格一致的场景 |

直观比喻

将温度系数想象成厨师调味:

- 高温(T>1):厨师喜欢尝试新调料,可能做出惊喜或怪味(高风险高创意)。

- 低温(T<1):厨师严格按菜谱操作,味道稳定但缺乏新意(低风险低惊喜)。

实际应用示例

- 写诗歌(高温度,如T=1.2):

输入: "夜晚的天空" 输出: "夜空洒落星尘的私语,月亮在云隙间编织银色的谜题" - 编程代码补全(低温度,如T=0.3):

输入: "import pandas as pd; df = pd.read_csv(" 输出: "data.csv")" (直接补全标准语法)

使用建议

- 平衡点选择:

- 一般默认值设为 T=1.0(保持原始分布)

- 创意任务尝试 T=0.7~1.5,严谨任务尝试 T=0.1~0.7

- 结合其他参数:

- 与 Top-k 或 Top-p(核采样) 配合使用,进一步控制生成质量。

- 动态调整:

- 部分场景可分段调整温度(例如对话开场用高温,关键信息切回低温)。

注意

温度系数不改变模型的知识或能力,仅调整生成策略。若模型本身缺乏某些知识,降低温度也无法“创造”正确答案。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)