eeg conformer复现(eeg+自注意力)

这是一个端到端的eeg模型,在谷歌学术中获得了四百多的引用,实际上可以使用在eeg的任何任务中,包括但不限于运动想象,情感分类等,他的代码逻辑还算是比较清晰和简洁的,复现难度较低。

EEG Conformer: Convolutional Transformer for EEG Decoding and Visualization

EEG Conformer: 用于脑电解码与可视化的卷积Transformer模型

Y. Song, Q. Zheng, B. Liu and X. Gao, "EEG Conformer: Convolutional Transformer for EEG Decoding and Visualization," in IEEE Transactions on Neural Systems and Rehabilitation Engineering, vol. 31, pp. 710-719, 2023, doi: 10.1109/TNSRE.2022.3230250.

引言

这是一个端到端的eeg模型,在谷歌学术中获得了四百多的引用,实际上可以使用在eeg的任何任务中,包括但不限于运动想象,情感分类等,他的代码逻辑还算是比较清晰和简洁的,复现难度较低。

论文

预处理

使用六阶切比雪夫滤波器(作用就是带通滤波),去除外来的高频和低频噪声,代码中使用的是4-40hz的范围。

接着使用Z 分数标准化以消除个体间差异(如阻抗、设备噪声)

特征提取

作者未进行特征提取。

数据增强

创新性的提出了分割和重建(S&R)的方法。

从同一试次内随机选择相同标签但不同位置的段,按时间顺序拼接为新的数据。

避免降低信噪比(常见的数据增强会影响信号的信噪比),且不会破坏原始的相干性。

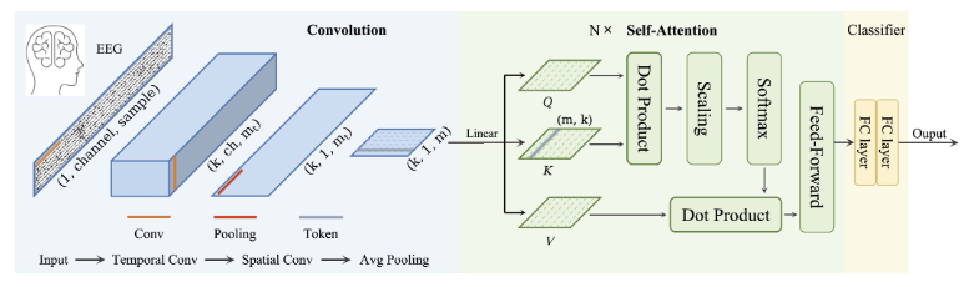

模型

论文作者将模型分为三个模块:卷积模块,自注意力模块,全连接分类模块。使用的是交叉熵损失函数。

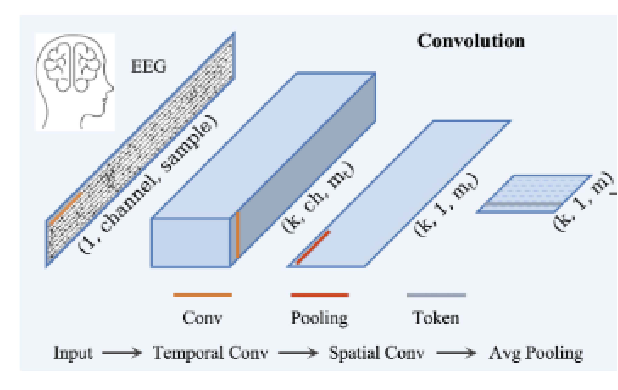

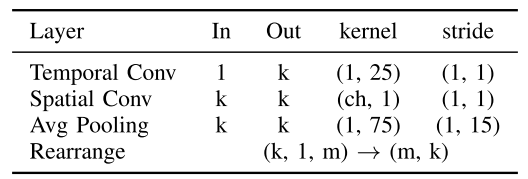

卷积模块

卷积模块先经过两次卷积,分别是时间维度的卷积和电极维度的卷积,这两次卷积模仿了EEGNet的思路。

然后经过一层对时间维度的平均池化来实现降采样和提高鲁棒性,这步作者参考了ViT,同时也为了适配eeg信号而做了改进(原ViT是没有重叠部分)。

具体变化过程:

(1,电极数,时间点数)

通过时间维度的卷积

(通道数,电极数,时间点数)

通过电极维度的卷积(使用了核大小为电极数量的卷积,来使电极维度降为1)

(通道数,1,时间点数)

通过时间维度的平均池化

(通道数,1,时间点数)

调整形状以适配后续模块的输入

(时间点数,通道数)

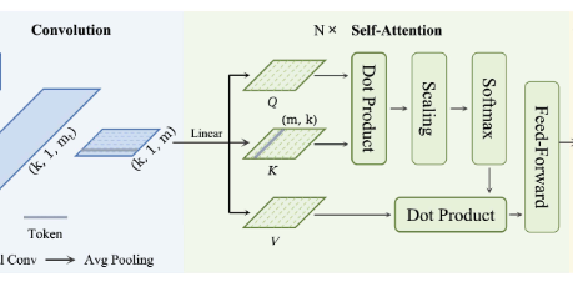

自注意力模块

神经活动是有连贯性的,自注意力模块或许能更好的保留全局特征来提升模型效果。

该模型的话是把每个时间点当成一个token,然后把前面卷积和池化生成的k个数当成该token的特征。也就是形状为 (token数,特征维度) 的特征矩阵。

自注意模块使用的是最经典的形式,也就是经过三份线性变换变成QKV,然后QK通过点积,缩放,softmax归一化生成注意力分数矩阵,再把注意力分数矩阵和V点积,使每个token融合了全局上下文信息。(如果想更详细的理解自注意力的过程,建议专门去搜这块的知识,本文就不详细阐述了)

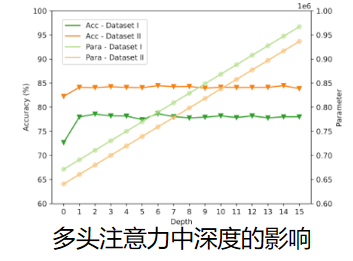

从代码中还能了解到,该模型使用的是多层多头自注意力,每层的自注意力模块中都使用了残差连接。该论文还比较了一下深度和头数的影响,从数据来看几乎没影响,可能是因为eeg信号没有太多太复杂的上下文信息,也可能是因为数据量太小,目前还没有专门的研究来解释这个现象。

全连接分类模块

论文采用了两个全连接层作为最后的分类。

实验

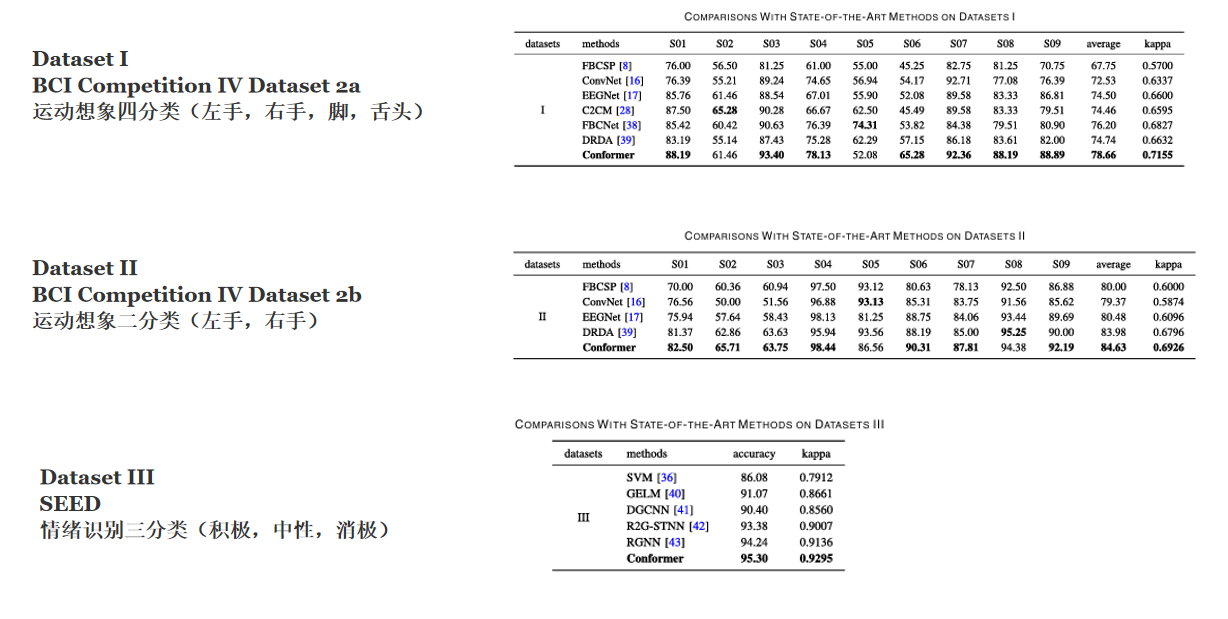

论文在三个著名的数据集上取得了优于其他模型的效果,包括BCI competition IV dataset 2a,competition IV dataset 2b,SEED。

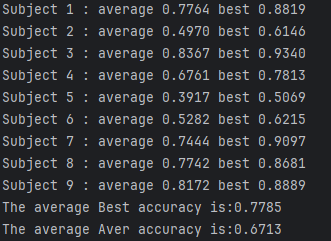

尝试跑了BCI competition IV dataset 2a,取得了与原论文接近的实验结果。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)