集成学习—GBDT(论文研读)

GDBT是与Friedman等人的《Additive logistic regression: a statistical view of boosting》这篇文章有极大的联系,基本上可以说是由这篇文章发展而来的,但是由于GDBT自己有着很好的实践效果,因此对于学习集成学习来说读一读原本的论文也是很必要的。因此这篇博客主要是对GDBT的原论文进行精读和理解。《Greedy function a.

GBDT,全称为梯度提升决策树,即Gradient Boosting Decision Tree,它与Friedman等人的《Additive logistic regression: a statistical view of boosting》这篇文章有极大的联系,基本上可以说是由这篇文章发展而来的,但是由于GBDT自己有着很好的实践效果,因此对于学习集成学习来说读一读原本的论文也是很必要的。因此这篇博客主要是对GBDT的原论文进行精读和理解。

《Greedy function approximation: A gradient boosting machine》是Jerome H. Friedman 于2001年在《Annals of Statistics》(统计四大金刚之一)发表的。下面就是论文的概览以及全文翻译。

文章结构:

- 函数估计:提出了一般的函数估计的概念以及经常使用的损失函数,并给出了问题的解决思路,即把函数优化问题变为参数优化问题,然后再用数值优化算法例如最速下降求解;

- 函数空间中的数值优化:将最速下降法在函数空间中运用,得到增量函数的方向gm(x)g_m(x)gm(x)以及线性搜索的步长ρm\rho_mρm;

- 有限数据:在有限数据样本中,借助参数化的求解方法,用贪婪分步算法求得的h(x;am)h(x;a_m)h(x;am)来替代最速下降中的gm(x)g_m(x)gm(x),并求得相应的线性搜索的步长ρm\rho_mρm,由此得到梯度提升Gradient Boost的一个通用算法框架(算法1);

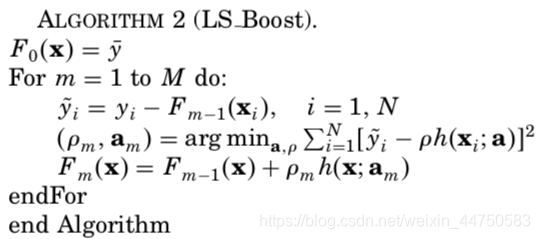

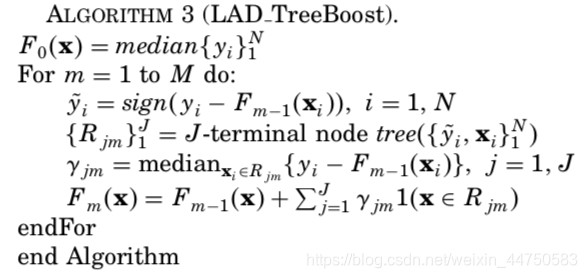

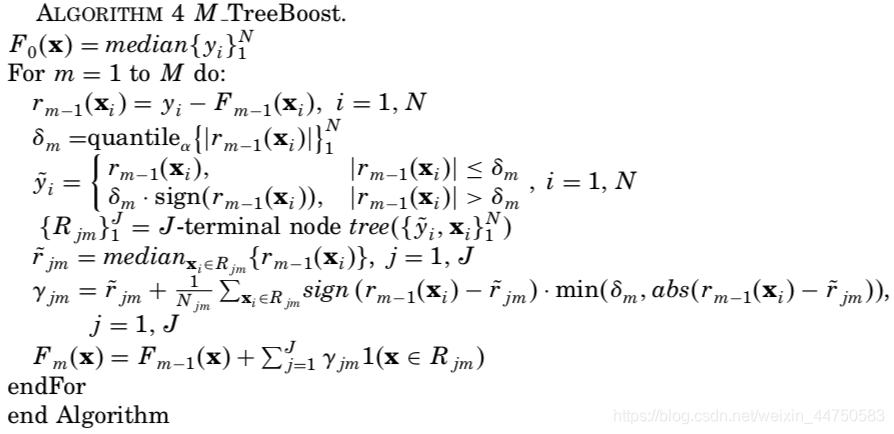

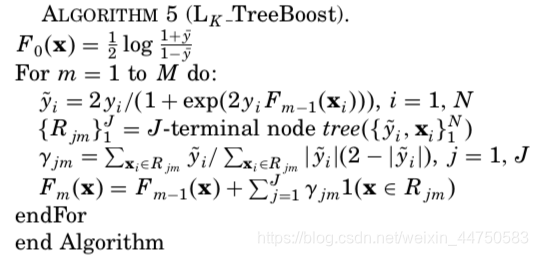

- 应用:加性模型:将Gradient Boost应用于几种常用的损失准则:运用到最小二乘(LS)得到算法2的LSLSLS_Boost;后面分析了回归树的特性,将它作为基学习器,再运用到最小绝对偏差(LAD),这样得到了算法3的LADLADLAD_TreeBoost;再运用到Huber(M)损失函数就得到了MMM_TreeBoost;运用到logistic二项对数似然(L)得到了LKL_KLK_TreeBoost(二分类和多分类)。然后再讨论了权重修剪,即删除那些wiw_iwi值小于阈值的所有样本,由此达到减少计算量但不损失精度的目的;

- 正则化:讨论了两种防止过拟合的参数,即学习速率ν\nuν和迭代次数MMM,通过模拟实验来阐述这样的ν−M\nu-Mν−M之间的权衡,说明降低学习速率可以显著地提高性能,但迭代次数可能会上升,但实际中迭代次数应该在计算方便或者可行的时候尽可能大;

- 模拟研究:通过蒙特卡罗模拟评估算法在许多不同情况下的表现,即产生100个随机生成的目标函数,并设定误差分布。这样对比了LSLSLS_TreeBoost、MMM_TreeBoost和LADLADLAD_TreeBoost三种算法,在正常误差和误差极端情况中MMM_TreeBoost都表现较好;对比了LSLSLS_TreeBoost与MARS,MMM_TreeBoost对于正态误差几乎与LSLSLS_TreeBoost一样准确,而且对输出yyy的离群值具有很强的抵抗力;对比了LkL_kLk_TreeBoost、K分类LogitBoost和Adaboost.MH,当对这三种方法中的每一种都仔细调整收缩参数时,它们之间的性能差别可能很小;

- 提升树:树的大小JJJ是基学习器的主要的超参数,它表示输入变量中占主导的交互作用的最高阶数,在实践中,这可以通过使用独立的测试集来调整;

- 解释:利用输入变量的相对重要性以及部分依赖图(可视化的解释)定量地翻译了目标函数F∗(x)F^*(x)F∗(x)的性质,提供了关于输入变量xxx和输出变量yyy的潜在关系的信息;

- 真实数据:将上述几种提升树回归算法将在两个实际数据集上进行说明,并分析了变量的相对重要性以及部分依赖图,结果和之前模拟时类似;

- 数据挖掘:总结了提升树的一些特性,继承了决策树的良好特性,例如不用考虑变量转换、对长尾分布和异常值不敏感、树的内部特征选择导致稳健性好、处理缺失值很方便等,也改善了单一树不准确不稳定的缺点,解释性也有一定的工具,而且在计算方面也有一定优势,可以作为预处理工具,且可以在先前停止的地方重新启动,不会造成计算损失。

1. 函数估计

在函数估计或预测学习的问题中,我们有一个由随机的“输出”或“响应”变量yyy和一组随机的“输入”或“解释”变量x={x1,…,xn}x=\{x_1,\dots,x_n\}x={x1,…,xn}组成的系统。使用已知的训练样本{yi,xi}iN\{y_i,x_i\}_i^N{yi,xi}iN,目标是得到从xxx到yyy的映射函数F∗(x)F^*(x)F∗(x)的一个估计或者近似F^(x)\hat{F}(x)F^(x),这个估计要在所有的样本的联合分布上最小化某些特定的损失函数L(y,F(X))L(y,F(X))L(y,F(X))的期望F∗=argminFEy,xL(y,F(x))=argminFEx[Ey(L(y,F(x)))∣x]F^*=\arg\min_FE_{y,x}L(y,F(x))=\arg\min_FE_{x}\bigg[E_y\bigg(L\big(y,F(x)\big)\bigg)\bigg|x\bigg]F∗=argFminEy,xL(y,F(x))=argFminEx[Ey(L(y,F(x)))∣∣∣∣x]经常使用损失函数L(y,F(x))L(y,F(x))L(y,F(x))包括平方误差(y−F(x))2(y-F(x))^2(y−F(x))2、对y∈R1y\in R^1y∈R1(回归)时的绝对误差∣y−F∣|y-F|∣y−F∣以及当y∈{−1,1}y\in \{-1,1\}y∈{−1,1}(分类)时的负伯努利对数似然log(1+e−2yF)log(1+e^{-2yF})log(1+e−2yF)。

常见的是将F(x)F(x)F(x)限制为参数类函数F(x;P)F(x;P)F(x;P)中的一个,其中P={P1,P2,… }P=\{P_1,P_2,\dots\}P={P1,P2,…}是一个有限的参数集,其联合值标识各个类成员。本文中我们关注以下加性展式F(x;{βm,am}1M)=∑m=1Mβmh(x;am)(2)F(x;\{\beta_m,a_m\}_1^M)=\sum_{m=1}^M\beta_mh(x;a_m)\tag{2}F(x;{βm,am}1M)=m=1∑Mβmh(x;am)(2)

上式中生成函数h(x;a)h(x;a)h(x;a)通常是一个输入变量xxx的简单的参数函数,特征参数为a={a1,a2,… }a=\{a_1,a_2,\dots\}a={a1,a2,…}。每一项在为这些参数选择的联合值ama_mam上有所不同。诸如此类的扩展是对诸如神经网络[Rumelhart, Hinton, and Williams(1986)]、径向基函数[Powell(1987)]、MARS [Friedman(1991)]、小波[Donoho(1993)]和支持向量机[Vapnik(1995)]等许多函数逼近方法的验证。这里有趣的是每个函数h(x;am)h(x;a_m)h(x;am)都是一个小的回归树,例如CART决策树[Breiman, Friedman, Olshen and Stone (1983)]。对于回归树来说,参数ama_mam是单个树的分裂变量、分裂位置和终端节点均值。

1.1 数值优化

一般来说,选择一个参数模型F(x;P)F(x;P)F(x;P)把函数优化问题变为参数优化问题P∗=argminPΦ(P)P^*=\arg\min_P\Phi(P)P∗=argPminΦ(P)其中Φ(P)=Ey,xL(y,F(x;P))\Phi(P)=E_{y,x}L(y,F(x;P))Φ(P)=Ey,xL(y,F(x;P))则F∗(x)=F(x;P∗)F^*(x)=F(x;P^*)F∗(x)=F(x;P∗)

对大部分的F(x;P)F(x;P)F(x;P)和LLL,求解上式一定会用到数值优化方法。这通常涉及用下式表示参数的解P∗=∑m=0MpmP^*=\sum_{m=0}^Mp_mP∗=m=0∑Mpm其中p0p_0p0是初始化猜测,{pm}1M\{p_m\}_1^M{pm}1M是连续的增量(“步骤”或“提升”),每个步骤基于前面步骤的顺序。利用优化方法确定了计算各步pmp_mpm的方法。

1.2 最速下降

最速下降是常用的数值最小化方法中最简单的一种。它如下定义了增量{pm}1M\{p_m\}_1^M{pm}1M。首先计算当前梯度gmg_mgm:gm={gjm}={[∂Φ(P)∂Pj]P=Pm−1}g_m=\{g_{jm}\}=\bigg\{\bigg[{\partial\Phi(P)\over\partial P_j}\bigg]_{P=P_{m-1}}\bigg\}gm={gjm}={[∂Pj∂Φ(P)]P=Pm−1}这里Pm−1=∑i=1m−1piP_{m-1}=\sum_{i=1}^{m-1}p_iPm−1=i=1∑m−1pi然后每步取为pm=−ρmgmp_m=-\rho_mg_mpm=−ρmgm其中ρm=argminρΦ(Pm−1−ρgm)\rho_m=\arg\min_\rho\Phi(P_{m-1}-\rho g_m)ρm=argρminΦ(Pm−1−ρgm)负梯度−gm-g_m−gm称为最速下降方向,且上式的ρ\rhoρ称为沿着这个方向的线性搜索。

2. 函数空间中的数值优化

在此,我们采取“非参”的方法,并将数值优化应用于函数空间。即我们将在每个点xxx估计的F(x)F(x)F(x)作为一个“参数”,并最小化Φ(F)=Ey,xL(y,F(x))=Ex[Ey(L(y,F(x)))∣x]\Phi(F)=E_{y,x}L(y,F(x))=E_x\bigg[E_y\bigg(L\big(y,F(x)\big)\bigg)\bigg|x\bigg]Φ(F)=Ey,xL(y,F(x))=Ex[Ey(L(y,F(x)))∣∣∣∣x]或等价地,在每个点xxx直接关于F(x)F(x)F(x)最小化ϕ(F(x))=Ey[L(y,F(x))∣x]\phi(F(x))=E_y\bigg[L\bigg(y,F(x)\bigg)\bigg|x\bigg]ϕ(F(x))=Ey[L(y,F(x))∣∣∣∣x]在函数空间中有无数这样的参数,但在(下面讨论的)数据集中只有有限个{F(xi)}1N\{F(x_i)\}_1^N{F(xi)}1N。按照数值优化的范例,我们把解取为F∗(x)=∑m=1Mfm(x)F^*(x)=\sum_{m=1}^Mf_m(x)F∗(x)=m=1∑Mfm(x)其中f0(x)f_0(x)f0(x)是初始化猜测,{fm(x)}1M\{f_m(x)\}_1^M{fm(x)}1M是由优化方法定义的增量函数(“步骤”或“提升”)。

对于最速下降fm(x)=−ρmgm(x)(6)f_m(x)=-\rho_mg_m(x)\tag{6}fm(x)=−ρmgm(x)(6)其中gm(x)=[∂ϕ(F(x))∂F(x)]F(x)=Fm−1(x)=[∂Ey[L(y,F(x))∣x]∂F(x)]F(x)=Fm−1(x)g_m(x)=\bigg[{\partial\phi(F(x))\over\partial F(x)}\bigg]_{F(x)=F_{m-1}(x)}=\bigg[{\partial E_y\big[L\big(y,F(x)\big)\big|x\big]\over\partial F(x)}\bigg]_{F(x)=F_{m-1}(x)}gm(x)=[∂F(x)∂ϕ(F(x))]F(x)=Fm−1(x)=[∂F(x)∂Ey[L(y,F(x))∣∣x]]F(x)=Fm−1(x)且Fm−1(x)=∑i=0m−1fi(x)F_{m-1}(x)=\sum_{i=0}^{m-1}f_i(x)Fm−1(x)=i=0∑m−1fi(x)

假设有充分的正则性可以交换微分和积分,它就变成了gm(x)=Ey[∂L(y,F(x))∂F(x)∣x]F(x)=Fm−1(x)(7)g_m(x)=E_y\bigg[{\partial L\big(y,F(x)\big)\over\partial F(x)}\bigg|x\bigg]_{F(x)=F_{m-1}(x)}\tag{7}gm(x)=Ey[∂F(x)∂L(y,F(x))∣∣∣∣x]F(x)=Fm−1(x)(7)由线性搜索给出乘数ρm\rho_mρmρm=argminρEy,xL(y,Fm−1(x)−ρgm(x))(8)\rho_m=\arg\min_\rho E_{y,x}L\big(y,F_{m-1}(x)-\rho g_m(x)\big)\tag{8}ρm=argρminEy,xL(y,Fm−1(x)−ρgm(x))(8)

3. 有限数据

这种非参数方法在用有限数据样本{yi,xi}1N\{y_i,x_i\}_1^N{yi,xi}1N来估计(y,x)(y,x)(y,x)的联合分布时失效,在这种情况下Ey[⋅∣x]E_y[\cdot|x]Ey[⋅∣x]无法通过每个样本点xxx的数据值来准确估计,即使可能,我们也希望在xxx值处估计F∗(x)F^*(x)F∗(x)而不是在训练样本上。必须从附近的数据点得到一些帮助,通过在解上施加平滑度。一种方法是采用参数化形式,如(2),并进行1.1节中讨论的参数优化,以最小化相应的数据的期望损失估计,{βm,am}1M=argmin{βm′,am′}1M∑i=1NL(yi,∑m=1Mβm′h(xi;am′))\{\beta_m,a_m\}_1^M=\arg\min_{\{\beta'_m,a'_m\}_1^M}\sum_{i=1}^NL\bigg(y_i,\sum_{m=1}^M\beta'_mh(x_i;a'_m)\bigg){βm,am}1M=arg{βm′,am′}1Mmini=1∑NL(yi,m=1∑Mβm′h(xi;am′))在这种不可行的情况下我们可以试着用“贪婪分步”方法,对m=1,2,…,Mm=1,2,\dots,Mm=1,2,…,M(βm,am)=argminβ,a∑i=1NL(yi,Fm−1(xi)+βh(xi;a))(9)(\beta_m,a_m)=\arg\min_{\beta,a}\sum_{i=1}^NL\big(y_i,F_{m-1}(x_i)+\beta h(x_i;a)\big)\tag{9}(βm,am)=argβ,amini=1∑NL(yi,Fm−1(xi)+βh(xi;a))(9)则Fm(x)=Fm−1(x)+βmh(x;am)(10)F_m(x)=F_{m-1}(x)+\beta_mh(x;a_m)\tag{10}Fm(x)=Fm−1(x)+βmh(x;am)(10)

注意,这个分步策略与逐步方法不同,后者在添加新项时重新调整先前输入的项。

在信号处理中这样的分步策略被称为“匹配的追求”(Mallat和张(1993)),其中L(y,F)L(y,F)L(y,F)是均方误损失,且{h(x,am)}1M\{h(x,a_m)\}_1^M{h(x,am)}1M被称为基函数,通常是从一个过完备的类小波字典取得。在机器学习中,(9)、(10)被称为“boosting”,其中y∈{−1,1}y\in\{-1,1\}y∈{−1,1}且L(y,F)L(y,F)L(y,F)要么是一个指数损失准则e−yFe^{−yF}e−yF[Freund and Schapire (1996), Schapire and Singer (1998)]要么是负二项对数似然[Friedman, Hastie and Tibshirani (2000)]。函数h(x;a)h(x;a)h(x;a)被称为“弱学习器”或“基学习器”,通常是一个分类树。

假设对于一个特定的损失L(y,F)L(y,F)L(y,F)和/或基学习器h(x;a)h(x;a)h(x;a),(9)式的解很难求。给定任意逼近Fm−1(x)F_{m-1}(x)Fm−1(x),(9)式βmh(x,am)\beta_mh(x,a_m)βmh(x,am)和(10)式可以看做是在步方向h(x;am)h(x;a_m)h(x;am)为参数化的函数类h(x;a)h(x;a)h(x;a)中的一个这样的限制下,对(1)式中基于数的估计F∗(x)F^*(x)F∗(x)的最佳贪婪的步骤。因此它可以看做是在这个限制下(6)式中的最速下降步。通过限制,基于数据的无约束负梯度(7)模拟−gm(xi)=−[∂L(yi,F(xi))∂F(xi)]F(x)=Fm−1(x)-g_m(x_i)=-\bigg[{\partial L\big(y_i,F(x_i)\big)\over\partial F(x_i)}\bigg]_{F(x)=F_{m-1}(x)}−gm(xi)=−[∂F(xi)∂L(yi,F(xi))]F(x)=Fm−1(x)给出了在Fm−1(x)F_{m-1}(x)Fm−1(x)的N维数据空间中最佳的最速下降步方向−gm={−gm(xi)}1N-g_m=\{-g_m(x_i)\}_1^N−gm={−gm(xi)}1N。然而,这种梯度只有在数据点{xi}1N\{x_i\}^N_1{xi}1N上定义,不能推广到其他的xxx值。推广的可能性是选择参数化的类的成员h(x,am)h(x,a_m)h(x,am),它产生最平行于−gm∈RN-g_m\in R^N−gm∈RN的hm={h(x,am)}1Nh_m=\{h(x,a_m)\}_1^Nhm={h(x,am)}1N。这是在数据分布上和−gm(x)-g_m(x)−gm(x)最高度相关的h(x,a)h(x,a)h(x,a)。它可以由解下式得到am=argmina,β∑i=1N[−gm(xi)−βh(xi;a)]2(11)a_m=\arg\min_{a,\beta}\sum_{i=1}^N[-g_m(x_i)-\beta h(x_i;a)]^2\tag{11}am=arga,βmini=1∑N[−gm(xi)−βh(xi;a)]2(11)

这个约束的负梯度h(x;am)h(x;a_m)h(x;am)用来替代最速下降策略中无约束的(7)−gm(x)-g_m(x)−gm(x)。特别地,线性搜索(8)为ρm=argminρ∑i=1NL(yi,Fm−1(xi)+ρh(xi;am))(12)\rho_m=\arg\min_\rho\sum_{i=1}^NL(y_i,F_{m-1}(x_i)+\rho h(x_i;a_m))\tag{12}ρm=argρmini=1∑NL(yi,Fm−1(xi)+ρh(xi;am))(12)且更新的近似为Fm(x)=Fm−1(x)+ρmh(x;am)F_m(x)=F_{m-1}(x)+\rho_mh(x;a_m)Fm(x)=Fm−1(x)+ρmh(x;am)

基本上,都是通过用h(x;a)h(x;a)h(x;a)拟合“伪响应”{y~i=−gm(xi)}1N\{\tilde{y}_i=-g_m(x_i)\}_1^N{y~i=−gm(xi)}1N将约束应用于无约束(粗糙)的解,而不是平滑约束下获得解(9)。通过最小二乘函数的最小化(11),这允许替换比较难的最小化问题(9)的函数,这样就只有一个基于最初的标准(12)的参数优化。因此,对于任意求解(11)存在可行的最小二乘算法的h(x;a)h(x;a)h(x;a),可以使用这种方法结合前向分步加性模型来最小化任何可微的损失L(y,F)L(y,F)L(y,F)。这就引出了下面使用最速下降的(通用)算法。

算法1(梯度提升Gradient Boost)

- F0(x)=argminρ∑i=1NL(yi,ρ)F_0(x)=\arg\min_\rho\sum_{i=1}^NL(y_i,\rho)F0(x)=argminρ∑i=1NL(yi,ρ)

- 对m=1m=1m=1到MMM执行:

- y~i=−[∂L(yi,F(xi))∂F(xi)]F(x)=Fm−1(x), i=1,N\tilde{y}_i=-\bigg[{\partial L\big(y_i,F(x_i)\big)\over\partial F(x_i)}\bigg]_{F(x)=F_{m-1}(x)},\ \ i=1,Ny~i=−[∂F(xi)∂L(yi,F(xi))]F(x)=Fm−1(x), i=1,N

- am=argmina,β∑i=1N[y~i−βh(xi;a)]2a_m=\arg\min_{a,\beta}\sum_{i=1}^N[\tilde{y}_i-\beta h(x_i;a)]^2am=argmina,β∑i=1N[y~i−βh(xi;a)]2

- ρm=argminρ∑i=1NL(yi,Fm−1(xi)+ρh(xi;am))\rho_m=\arg\min_\rho\sum_{i=1}^NL(y_i,F_{m-1}(x_i)+\rho h(x_i;a_m))ρm=argminρ∑i=1NL(yi,Fm−1(xi)+ρh(xi;am))

- Fm(x)=Fm−1(x)+ρmh(x;am)F_m(x)=F_{m-1}(x)+\rho_mh(x;a_m)Fm(x)=Fm−1(x)+ρmh(x;am)

- 结束循环,结束算法

注意,任何估计条件期望(给定xxx)的拟合准则原则上都可以用来估计算法1中第4步的(平滑的)负梯度(7)。由于许多最小二乘算法具有优越的计算性能,因此最小二乘(11)是一种自然选择。

在y∈{−1,1}y\in\{-1,1\}y∈{−1,1}以及只通过乘积L(y,F)=L(yF)L(y,F)=L(yF)L(y,F)=L(yF)取决于yyy和FFF的损失函数L(y,F)L(y,F)L(y,F)的特殊情况下,(9)、(10)类似的用最速下降最小化的boosting已经在机器学习文献中指出[Ratsch, Onoda and Muller (1998), Breiman (1999)]。Duffy和Helmbold(1999)巧妙地利用这个类似来激发他们的GeoLev和GeoArc程序。yFyFyF称为“边界”(margin),并在边界值的空间而不是在函数值FFF的空间内进行最速下降。后一种方法允许应用于更一般的损失函数,在这种损失函数中不出现边界。Drucker(1997)在AdaBoost算法的背景下采用了一种不同的将回归转换为到分类框架的策略[FreundandSchapire(1996)]。

4. 应用:加性模型

在本节中,梯度增强方法应用于几种常用的损失准则:最小二乘(LS)、最小绝对偏差(LAD)、Huber(M)和logistic二项对数似然(L)。第一个是作为“实现验证”,而其他得到了新的boosting算法。

4.1 最小二乘回归

这里L(y,F)=(y−F)2/2L(y,F)=(y-F)^2/2L(y,F)=(y−F)2/2,算法1中第3行的伪响应为y~i=yi−Fm−1(xi)\tilde{y}_i=y_i-F_{m-1}(x_i)y~i=yi−Fm−1(xi)。所以,第4行只是拟合了当前的残差,并且第5行中的线性搜索得到ρm=βm\rho_m=\beta_mρm=βm,这里βm\beta_mβm是第4行中最小化的β\betaβ。因此,在均方误差损失上的梯度提升产生了一个通常的分步算法,它迭代地拟合了当前的残差。

4.2 最小绝对偏差(LAD)回归

对于损失函数L(y,F)=∣y−F∣L(y,F)=|y-F|L(y,F)=∣y−F∣,有y~i=−[∂L(yi,F(xi))∂F(xi)]F(x)=Fm−1(x)=sign(yi−Fm−1(xi))(13)\tilde{y}_i=-\bigg[{\partial L\big(y_i,F(x_i)\big)\over\partial F(x_i)}\bigg]_{F(x)=F_{m-1}(x)}=sign(y_i-F_{m-1}(x_i))\tag{13}y~i=−[∂F(xi)∂L(yi,F(xi))]F(x)=Fm−1(x)=sign(yi−Fm−1(xi))(13)这意味着h(x;a)h(x;a)h(x;a)通过最小二乘来拟合算法1中的第4行的当前误差的sign函数。线性搜索变为ρm=argminρ∑i=1N∣yi−Fm−1(xi)−ρh(xi;am)∣=argminρ∑i=1N∣h(xi;am)∣⋅∣yi−Fm−1(xi)h(xi;am)−ρ∣=medianw{yi−Fm−1(xi)h(xi;am)}1N , wi=∣h(xi;am)∣(14) \begin{aligned} \rho_m&=\arg\min_\rho\sum_{i=1}^N|y_i-F_{m-1}(x_i)-\rho h(x_i;a_m)|\\ &=\arg\min_\rho\sum_{i=1}^N|h(x_i;a_m)|\cdot |{y_i-F_{m-1}(x_i)\over h(x_i;a_m)}-\rho |\\ &=median_w\bigg\{{y_i-F_{m-1}(x_i)\over h(x_i;a_m)}\bigg\}_1^N\ ,\ \ \ w_i=|h(x_i;a_m)|\\ \end{aligned}\tag{14}ρm=argρmini=1∑N∣yi−Fm−1(xi)−ρh(xi;am)∣=argρmini=1∑N∣h(xi;am)∣⋅∣h(xi;am)yi−Fm−1(xi)−ρ∣=medianw{h(xi;am)yi−Fm−1(xi)}1N , wi=∣h(xi;am)∣(14)

这里medianw{⋅}median_w\{\cdot\}medianw{⋅}表示关于权重wiw_iwi的加权中位数。将(13)、(14)的结果带入算法1,再使用基学习器h(x;a)h(x;a)h(x;a)就得到了对于最小绝对偏差的boosting算法。

4.3 回归树

这里我们考虑一个特殊的情况,即每个基学习器是一个J个叶结点的回归树[Breiman, Friedman, Olshen andStone(1983)]。每一个回归树模型都有自己的加性形式h(x;{bj,Rj}1J)=∑j=1Jbj1(x∈Rj)(15)h(x;\{b_j,R_j\}_1^J)=\sum_{j=1}^Jb_j1(x\in R_j)\tag{15}h(x;{bj,Rj}1J)=j=1∑Jbj1(x∈Rj)(15)

这里{Rj}1J\{R_j\}_1^J{Rj}1J不相交的区域,共同覆盖了预测变量xxx的所有联合取值空间。这些区域由对应的决策树的叶结点来表示。示性函数1(⋅)1(\cdot)1(⋅)表示为真时取1,否则取0。(15)中这些基学习器的参数为系数{bj}1J\{b_j\}_1^J{bj}1J以及定义了区域边界的量{Rj}1J\{R_j\}_1^J{Rj}1J。这些是分裂变量和代表树的非终端节点上的分裂的那些变量的值。因为这些区域是不相交的,(15)等价于这样的预测规则:若x∈Rjx\in R_jx∈Rj,则h(x)=bjh(x)=b_jh(x)=bj

对于一个回归树,算法1中的第6行的更新就变成了Fm(x)=Fm−1(x)+ρm∑j=1Jbjm1(x∈Rjm)(16)F_m(x)=F_{m-1}(x)+\rho_m\sum_{j=1}^Jb_{jm}1(x\in R_{jm})\tag{16}Fm(x)=Fm−1(x)+ρmj=1∑Jbjm1(x∈Rjm)(16)这里的{Rjm}1J\{R_{jm}\}_1^J{Rjm}1J是在mmm次迭代中由树的叶结点定义的区域。通过第4行中的最小二乘来构建这些区域去得到预测的伪响应{y~i}1N\{\tilde{y}_{i}\}_1^N{y~i}1N,{bjm}\{b_{jm}\}{bjm}为对应的最小二乘的系数bjm=avexi∈Rjmy~ib_{jm}=ave_{x_i\in R_{jm}}\tilde{y}_{i}bjm=avexi∈Rjmy~i比例因子ρm\rho_mρm为第5行中的线性搜索的解。

(16)式的更新可以等价的表示为Fm(x)=Fm−1(x)+∑j=1Jγjm1(x∈Rjm)(17)F_m(x)=F_{m-1}(x)+\sum_{j=1}^J\gamma_{jm}1(x\in R_{jm})\tag{17}Fm(x)=Fm−1(x)+j=1∑Jγjm1(x∈Rjm)(17)其中γjm=ρjmbjm\gamma_{jm}=\rho_{jm}b_{jm}γjm=ρjmbjm。我们可以将(17)式看做是在每步{1(x∈Rjm)}1J\{1(x\in R_{jm})\}_1^J{1(x∈Rjm)}1J增加了J个独立的基函数,而不是像(16)式中单独的一个加性函数。因此,在这种情况下,可以通过使用这些独立基函数(17)的最优系数进一步提高拟合的质量。这些最优系数是{γjm}1J=argmin{γj}1J∑i=1NL(yi,Fm−1(xi)+∑j=1Jγj1(x∈Rjm))\{\gamma_{jm}\}_1^J=\arg\min_{\{\gamma_{j}\}_1^J}\sum_{i=1}^NL\bigg(y_i,F_{m-1}(x_i)+\sum_{j=1}^J\gamma_j 1(x\in R_{jm})\bigg){γjm}1J=arg{γj}1Jmini=1∑NL(yi,Fm−1(xi)+j=1∑Jγj1(x∈Rjm))由于回归树产生的区域具有不相交的性质,这就简化为γjm=argminγ∑xi∈RjmL(yi,Fm−1(xi)+γ)(18)\gamma_{jm}=\arg\min_{\gamma}\sum_{x_i\in R_{jm}}L\bigg(y_i,F_{m-1}(x_i)+\gamma \bigg)\tag{18}γjm=argγminxi∈Rjm∑L(yi,Fm−1(xi)+γ)(18)这只是在给定当前近似Fm−1(x)F_{m-1}(x)Fm−1(x)的情况下,根据损失函数LLL,每个终端节点区域进行的最优常数更新。

对于LAD回归,(18)式变为γjm=medianxi∈Rjm{yi−Fm−1(xi)}\gamma_{jm}=median_{x_i\in R_{jm}}\{y_i-F_{m-1}(x_i)\}γjm=medianxi∈Rjm{yi−Fm−1(xi)}即第mmm次迭代时第jjj个终端节点的当前残差的中位数。在每次迭代,回归树基于最小二乘准则来构建当前残差yi−Fm−1(xi)y_i-F_{m-1}(x_i)yi−Fm−1(xi)的sign函数的最佳预测。然后通过在每个派生的终端节点中添加残差的中位数来更新这个近似。

这个算法高度地稳健,决策树只使用了每一个输入变量xjx_jxj的阶数信息,伪响应y~i\tilde{y}_iy~i只有两个值y~i∈{−1,1}\tilde{y}_i\in\{-1,1\}y~i∈{−1,1},终端结点的更新是基于中位数。另一种方法是建立一个树来直接最小化损失准则treem(x)=argminJ−node tree∑i=1N∣yi−Fm−1(xi)−tree(xi)∣tree_m(x)=\arg\min_{J-node\ tree}\sum_{i=1}^N|y_i-F_{m-1}(x_i)-tree(x_i)|treem(x)=argJ−node treemini=1∑N∣yi−Fm−1(xi)−tree(xi)∣Fm(x)=Fm−1(x)+treem(x)F_m(x)=F_{m-1}(x)+tree_m(x)Fm(x)=Fm−1(x)+treem(x)然而,算法3要快得多,因为它使用最小二乘来诱导树。当构建树的过程中搜索分割时,平方误差损失比平均绝对偏差更新得快得多。

4.4 M回归

M回归技术试图抵抗长尾误差分布和异常值,同时保持对正态分布误差的高效率。考虑Huber损失函数[Huber (1964)]L(y,F)={12(y−F)2,∣y−F∣⩽δδ(∣y−F∣−δ/2),∣y−F∣>δ(19)L(y,F)=\begin{cases} {1\over2}(y-F)^2, & |y-F|\leqslant\delta\\ \delta(|y-F|-\delta/2), & |y-F|>\delta \end{cases}\tag{19}L(y,F)={21(y−F)2,δ(∣y−F∣−δ/2),∣y−F∣⩽δ∣y−F∣>δ(19)这里的伪响应为y~i=−[∂L(yi,F(xi))∂F(xi)]F(x)=Fm−1(x)={yi−Fm−1(xi),∣yi−Fm−1(xi)∣⩽δδ⋅sign(yi−Fm−1(xi)),∣yi−Fm−1(xi)∣>δ \begin{aligned} \tilde{y}_i&=-\bigg[{\partial L\big(y_i,F(x_i)\big)\over\partial F(x_i)}\bigg]_{F(x)=F_{m-1}(x)}\\ &=\begin{cases} y_i-F_{m-1}(x_i), & |y_i-F_{m-1}(x_i)|\leqslant\delta\\ \delta\cdot sign(y_i-F_{m-1}(x_i)), & |y_i-F_{m-1}(x_i)|>\delta \end{cases} \end{aligned}y~i=−[∂F(xi)∂L(yi,F(xi))]F(x)=Fm−1(x)={yi−Fm−1(xi),δ⋅sign(yi−Fm−1(xi)),∣yi−Fm−1(xi)∣⩽δ∣yi−Fm−1(xi)∣>δ线性搜索变为ρm=argminρ∑i=1NL(yi,Fm−1(xi)+ρh(xi;am))(20)\rho_m=\arg\min_\rho\sum_{i=1}^NL(y_i,F_{m-1}(x_i)+\rho h(x_i;a_m))\tag{20}ρm=argρmini=1∑NL(yi,Fm−1(xi)+ρh(xi;am))(20)这里的LLL由(19)式给出。(19)、(20)式得解可以由标准的迭代方法得到[see Huber (1964)]。

边界点δ\deltaδ的值受绝对损失函数而不是平方误差损失控制,定义了这些被认为是“离群点”的残差值。最优值将取决于y−F∗(x)y-F^*(x)y−F∗(x)的分布,其中F∗F^*F∗是真正的目标函数(1)。选择δ\deltaδ值的常见的做法是选为分布∣y−F∗(x)∣|y-F^*(x)|∣y−F∗(x)∣的α\alphaα分位数,这里(1−α)(1-\alpha)(1−α)控制了程序的断点。这个“断点”把样本分为一部分,这部分可以任意修改而不会降低结果的质量。因为F∗(x)F^*(x)F∗(x)是未知的,我们在第mmm次迭代中使用当前估计Fm−1(x)F_{m-1}(x)Fm−1(x)作为近似。∣y−Fm−1(x)∣|y-F_{m-1}(x)|∣y−Fm−1(x)∣的分布由当前残差来估计,这样δm=quantileα{∣yi−Fm−1(xi)∣}1N\delta_m=quantile_\alpha\{|y_i-F_{m-1}(x_i)|\}_1^Nδm=quantileα{∣yi−Fm−1(xi)∣}1N

使用回归树作为基学习器,我们使用4.3节的策略,即在每个终端节点RjmR_{jm}Rjm中单独更新(18)。对于Huber损失(19),(18)的解可以近似为从中位数开始的标准迭代过程[Huber(1964)]单个步骤r~jm=medianxi∈Rjm{rm−1(xi)}\tilde{r}_{jm}=median_{x_i\in R_{jm}}\{r_{m-1}(x_i)\}r~jm=medianxi∈Rjm{rm−1(xi)}其中{rm−1(xi)}1N\{r_{m-1}(x_i)\}_1^N{rm−1(xi)}1N为当前残差rm−1(xi)=yi−Fm−1(xi)r_{m-1}(x_i)=y_i-F_{m-1}(x_i)rm−1(xi)=yi−Fm−1(xi)近似为γjm=r~jm+1Njm∑xi∈Rjmsign(rm−1(xi)−r~jm)⋅min(δm,abs(rm−1(xi)−r~jm))\gamma_{jm}=\tilde{r}_{jm}+{1\over N_{jm}}\sum_{x_i\in R_{jm}}sign(r_{m-1}(x_i)-\tilde{r}_{jm})\cdot \min(\delta_m,abs(r_{m-1}(x_i)-\tilde{r}_{jm}))γjm=r~jm+Njm1xi∈Rjm∑sign(rm−1(xi)−r~jm)⋅min(δm,abs(rm−1(xi)−r~jm))这里的NjmN_{jm}Njm是在第jjj个终端结点中的样本数。这样就给出了以下基于Huber损失的boosting回归树算法。

根据稳健回归背后的动机,该算法应该具有与正态分布误差的最小二乘boosting算法(Algorithm2)相似的性质,与极长尾分布的最小绝对偏差回归(算法3)相似的性质。对于只有中等长度尾部的误差分布,它的性能可能优于两者(参见第6.2节)。

4.5 二分类逻辑回归和分类

这里的损失函数为负二项对数似然(FHT00)L(y,F)=log(1+exp(−2yF)), y∈{−1,1}L(y,F)=log(1+exp(-2yF)),\ \ y\in\{-1,1\}L(y,F)=log(1+exp(−2yF)), y∈{−1,1}其中F(x)=12log[Pr(y=1∣x)Pr(y=−1∣x)](21)F(x)={1\over2}log\bigg[{Pr(y=1|x)\over Pr(y=-1|x)}\bigg]\tag{21}F(x)=21log[Pr(y=−1∣x)Pr(y=1∣x)](21)伪响应为y~i=−[∂L(yi,F(xi))∂F(xi)]F(x)=Fm−1(x)=2yi/(1+exp(2yiFm−1(x)))(22)\tilde{y}_i=-\bigg[{\partial L(y_i,F(x_i))\over \partial F(x_i)}\bigg]_{F(x)=F_{m-1}(x)}=2y_i\big/\bigg(1+exp\big(2y_iF_{m-1}(x)\big)\bigg)\tag{22}y~i=−[∂F(xi)∂L(yi,F(xi))]F(x)=Fm−1(x)=2yi/(1+exp(2yiFm−1(x)))(22)线性搜索变为ρm=argminρ∑i=1Nlog(1+exp(−2yi(Fm−1(xi)+ρh(xi;am))))\rho_m=\arg\min_\rho\sum_{i=1}^Nlog\bigg(1+exp\big(-2y_i(F_{m-1}(x_i)+\rho h(x_i;a_m))\big)\bigg)ρm=argρmini=1∑Nlog(1+exp(−2yi(Fm−1(xi)+ρh(xi;am))))用回归树作为基学习器,我们再次使用4.3节中的办法,单独更新每个终端结点RjmR_{jm}Rjm:γjm=argminγ∑xi∈Rjmlog(1+exp(−2yi(Fm−1(xi)+γ)))(23)\gamma_{jm}=\arg\min_\gamma\sum_{x_i\in R_{jm}}log\bigg(1+exp\big(-2y_i(F_{m-1}(x_i)+\gamma)\big)\bigg)\tag{23}γjm=argγminxi∈Rjm∑log(1+exp(−2yi(Fm−1(xi)+γ)))(23)(23)式没有闭式解。在负二项对数似然的损失函数下,我们用一个Newton–Raphson迭代步来替代,即γjm=∑xi∈Rjmy~i/∑xi∈Rjm∣y~i∣(2−∣y~i∣)\gamma_{jm}=\sum_{x_i\in R_{jm}}\tilde{y}_i\bigg/\sum_{x_i\in R_{jm}}|\tilde{y}_i|(2-|\tilde{y}_i|)γjm=xi∈Rjm∑y~i/xi∈Rjm∑∣y~i∣(2−∣y~i∣)其中y~i\tilde{y}_iy~i由(22)式给出。这就给出了下面用回归树的似然梯度boosting算法。

最后的近似FM(x)F_M(x)FM(x)通过(21)式和对数几率联系起来,这样可以转化得到概率估计p+(x)=Pr^(y=1∣x)=1/(1+e−2FM(x))p−(x)=Pr^(y=−1∣x)=1/(1+e2FM(x))p_+(x)=\hat{Pr}(y=1|x)=1/(1+e^{-2F_M(x)})\\ p_-(x)=\hat{Pr}(y=-1|x)=1/(1+e^{2F_M(x)})p+(x)=Pr^(y=1∣x)=1/(1+e−2FM(x))p−(x)=Pr^(y=−1∣x)=1/(1+e2FM(x))这些反过来又可以用于分类y^(x)=2⋅1[c(−1,1)p+(x)>c(1,−1)p−(x)]−1\hat{y}(x)=2\cdot1[c(-1,1)p_+(x)>c(1,-1)p_-(x)]-1y^(x)=2⋅1[c(−1,1)p+(x)>c(1,−1)p−(x)]−1其中c(y^,y)c(\hat y,y)c(y^,y)是当真实值为yyy预测值为y^\hat yy^时有关的损失。

4.5.1 影响修剪(权重修剪)

对于二分类的逻辑回归问题在mmm次迭代时的经验损失函数为ϕm(ρ,a)=∑i=1Nlog[1+exp(−2yiFm−1(xi))⋅exp(−2yiρh(xi;a))](24)\phi_m(\rho,a)=\sum_{i=1}^Nlog[1+exp(-2y_iF_{m-1}(x_i))\cdot exp(-2y_i\rho h(x_i;a))]\tag{24}ϕm(ρ,a)=i=1∑Nlog[1+exp(−2yiFm−1(xi))⋅exp(−2yiρh(xi;a))](24)

若yiFm−1(xi)y_iF_{m-1}(x_i)yiFm−1(xi)非常大,则对于接近于零的很小到一般的数(24)式都几乎不相关于ρh(xi;a)\rho h(x_i;a)ρh(xi;a)。这意味着第iii个样本(yi,xi)(y_i,x_i)(yi,xi)对损失函数几乎没有影响,因此在其解也没有影响(ρm,am)=argminρ,aϕm(ρ,a)(\rho_m,a_m)=\arg\min_{\rho,a}\phi_m(\rho,a)(ρm,am)=argρ,aminϕm(ρ,a)这表明可以从第mmm次迭代的所有计算中删除所有的那些yiFm−1(xi)y_iF_{m-1}(x_i)yiFm−1(xi)相对很大的样本(yi,xi)(y_i,x_i)(yi,xi),而不会对结果产生实质性的影响。因此wi=exp(−2yiFm−1(xi))(25)w_i=exp(-2y_iF_{m-1}(x_i))\tag{25}wi=exp(−2yiFm−1(xi))(25)可以看作是第iii个样本在估计ρh(x;am)\rho h(x;a_m)ρh(x;am)上的影响或者权重的一种度量。

更一般地,从第2节的非参数函数空间角度来看,参数为样本函数值{F(xi)}1N\{F(x_i)\}_1^N{F(xi)}1N。对于“参数”值F(xi)F(x_i)F(xi)(保持所有其他参数固定)的变化,估计的影响可以用损失函数关于这个参数求二阶导数来衡量。这里在第mmm次迭代中的二阶导数为∣y~i∣(2−∣y~i∣)|\tilde{y}_i|(2-|\tilde{y}_i|)∣y~i∣(2−∣y~i∣),其中∣y~i∣|\tilde{y}_i|∣y~i∣由(22)给出。因此,另一种衡量第mmm次迭代中第iii个样本在估计ρh(x;am)\rho h(x;a_m)ρh(x;am)上的影响或者权重的方法为wi=∣y~i∣(2−∣y~i∣)w_i=|\tilde{y}_i|(2-|\tilde{y}_i|)wi=∣y~i∣(2−∣y~i∣)

影响修剪就是删除那些wiw_iwi值小于wl(α)w_{l(\alpha)}wl(α)的所有样本,这里l(α)l(\alpha)l(α)是下式的解∑i=1l(α)wi=α∑I=1Nwi(27)\sum_{i=1}^{l(\alpha)}w_i=\alpha\sum_{I=1}^Nw_i\tag{27}i=1∑l(α)wi=αI=1∑Nwi(27)这里{w(i)}1N\{w_{(i)}\}_1^N{w(i)}1N是将权重{wi}1N\{w_{i}\}_1^N{wi}1N以升序排列,特殊值是α∈[0.05,0.2]\alpha\in[0.05,0.2]α∈[0.05,0.2]。注意,基于(25)、(27)的影响修剪与Real AdaBoost使用的“权重修剪”策略相同,而(26)、(27)与FHT00中使用的LogitBoost相同。在那里可以看到,使用任何一种影响度量,90%到95%的样本常被删除,而不牺牲估计的准确性。这使得计算量相应减少了10到20倍。

4.6 多分类逻辑回归和分类

这里我们得到了一个KKK分类问题的梯度下降boosting算法。损失函数为L({yk,Fk(x)}1K)=−∑k=1Kyklogpk(x)(28)L(\{y_k,F_k(x)\}_1^K)=-\sum_{k=1}^Ky_k\log p_k(x)\tag{28}L({yk,Fk(x)}1K)=−k=1∑Kyklogpk(x)(28)其中yk=1(class=k)∈{0,1}y_k=1(class=k)\in\{0,1\}yk=1(class=k)∈{0,1}且pk(x)=Pr(yk=1∣x)p_k(x)=Pr(y_k=1|x)pk(x)=Pr(yk=1∣x)。在FHT00之后,我们使用对称的多重逻辑变换Fk(x)=logpk(x)−1K∑l=1Klogpl(x)(29)F_k(x)=\log p_k(x)-{1\over K}\sum_{l=1}^K\log p_l(x)\tag{29}Fk(x)=logpk(x)−K1l=1∑Klogpl(x)(29)或者等价地pk(x)=exp(Fk(x))/∑l=1Kexp(Fl(x))(30)p_k(x)=\exp(F_k(x))\bigg/\sum_{l=1}^K\exp(F_l(x))\tag{30}pk(x)=exp(Fk(x))/l=1∑Kexp(Fl(x))(30)将(30)代入(28),求一阶导数得到y~ik=−[∂L({yil,Fl(xi)}l=1K)∂Fk(xi)]{Fl(x)=Fl,m−1(x)}1K=yik−pk,m−1(xi)(31)\tilde{y}_{ik}=-\bigg[{\partial L(\{y_{il},F_l(x_i)\}_{l=1}^K)\over \partial F_k(x_i)}\bigg]_{\{F_l(x)=F_{l,m-1}(x)\}_1^K}=y_{ik}-p_{k,m-1}(x_i)\tag{31}y~ik=−[∂Fk(xi)∂L({yil,Fl(xi)}l=1K)]{Fl(x)=Fl,m−1(x)}1K=yik−pk,m−1(xi)(31)这里pk,m−1(x)p_{k,m-1}(x)pk,m−1(x)是通过(30)式从Fk,m−1(x)F_{k,m-1}(x)Fk,m−1(x)中推得。因此,在每个迭代mmm中引入KKK树来预测每个类在概率尺度上的相应的当前残差。这些树每个都有JJJ个终端结点,对应区域为{Rjkm}j=1J\{R_{jkm}\}_{j=1}^J{Rjkm}j=1J。模型更新γjkm\gamma_{jkm}γjkm相当于这些区域是下式的解{γjkm}=argmin{γjk}∑i=1N∑k=1Kϕ(yik,Fk,m−1(xi)+∑j=1Jγjk1(xi∈Rjm))\{\gamma_{jkm}\}=\arg\min_{\{\gamma_{jk}\}}\sum_{i=1}^N\sum_{k=1}^K\phi\bigg(y_{ik},F_{k,m-1}(x_i)+\sum_{j=1}^J\gamma_{jk}1(x_i\in R_{jm})\bigg){γjkm}=arg{γjk}mini=1∑Nk=1∑Kϕ(yik,Fk,m−1(xi)+j=1∑Jγjk1(xi∈Rjm))其中由(28)式ϕ(yk,Fk)=−yklogpk\phi(y_k,F_k)=-y_k\log p_kϕ(yk,Fk)=−yklogpk,FkF_kFk由(30)式和pkp_kpk有关。它没有闭式解,此外,不同类别的树所对应的区域是重叠的,这样解就不会像(18)那样,在每棵树的每个区域中进行单独的计算。在FHT00之后,我们用单个Newton–Raphson步骤来近似解,使用对海森的对角近似。这将问题分解为每个树的每个终端节点的单独计算。结果为γjkm=K−1K∑xi∈Rjkmy~ik∑xi∈Rjkm∣y~ik∣(1−∣y~ik∣)(32)\gamma_{jkm}={K-1\over K}{\sum_{x_i\in R_{jkm}}\tilde{y}_{ik}\over\sum_{x_i\in R_{jkm}}|\tilde{y}_{ik}|(1-|\tilde{y}_{ik}|)}\tag{32}γjkm=KK−1∑xi∈Rjkm∣y~ik∣(1−∣y~ik∣)∑xi∈Rjkmy~ik(32)

这样就得到了下面的KKK分类问题的逻辑梯度下降boosting算法。

最后的估计{FkM(x)}1K\{F_{kM}(x)\}_1^K{FkM(x)}1K可以通过(30)式用来得到对应的概率估计{pkM(x)}1K\{p_{kM}(x)\}_1^K{pkM(x)}1K。这些反过来又可以用于分类k^(x)=argmin1⩽k⩽K∑k′=1Kc(k,k′)pk′M(x)\hat k(x)=\arg\min_{1\leqslant k\leqslant K}\sum_{k'=1}^Kc(k,k')p_{k'M}(x)k^(x)=arg1⩽k⩽Kmink′=1∑Kc(k,k′)pk′M(x)这里c(k,k′)c(k,k')c(k,k′)表示当真实是k′k'k′预测为kkk类时的损失。注意对K=2K=2K=2,算法6等价于算法5。

算法6与FHT00的KKK分类的LogitBoost过程相似,该过程是基于Newton–Raphson而不是函数空间中的梯度下降。在该算法中,KKK棵树被诱导,每棵树都对每个样本(y~ik,xi)(\tilde{y}_{ik},x_i)(y~ik,xi)使用相应的伪响应y~ik=K−1Kyik−pk(xi)pk(xi)(1−pk(xi))(33)\tilde{y}_{ik}={K-1\over K}{y_{ik}-p_k(x_i)\over p_k(x_i)(1-p_k(x_i))}\tag{33}y~ik=KK−1pk(xi)(1−pk(xi))yik−pk(xi)(33)以及权重wk(xi)=pk(xi)(1−pk(xi))(34)w_k(x_i)=p_k(x_i)(1-p_k(x_i))\tag{34}wk(xi)=pk(xi)(1−pk(xi))(34)终端结点的更新为γjkm=∑xi∈Rjkmwk(xi)y~ik∑xi∈Rjkmwk(xi)\gamma_{jkm}={\sum_{x_i\in R_{jkm}}w_k(x_i)\tilde{y}_{ik}\over \sum_{x_i\in R_{jkm}}w_k(x_i)}γjkm=∑xi∈Rjkmwk(xi)∑xi∈Rjkmwk(xi)y~ik这和(32)式等价。这两种算法的区别在于用于诱导树和最终区域的分裂准则{Rjkm}1J\{R_{jkm}\}_1^J{Rjkm}1J。

用于评估一个当前终端区域RRR可能分裂为两个子区域(Rl,Rr)(R_l,R_r)(Rl,Rr)的最小二乘改进准则为i2(Rl,Rr)=wlwrwl+wr(yˉl−yˉr)2(35)i^2(R_l,R_r)={w_lw_r\over w_l+w_r}(\bar y_l-\bar y_r)^2\tag{35}i2(Rl,Rr)=wl+wrwlwr(yˉl−yˉr)2(35)其中yˉl,yˉr\bar y_l,\bar y_ryˉl,yˉr分别为左、右两边的子响应均值,wl,wrw_l,w_rwl,wr为对应的权重之和。对于一个给定的分裂,利用带单位权重的(31)式或者带权重(34)式的(33)式,得到yˉl,yˉr\bar y_l,\bar y_ryˉl,yˉr有相同的值。然而,权重之和wl,wrw_l,w_rwl,wr是不同的。单位权重(LKL_KLK_TreeBoost)偏向在每个子节点中关于样本数对称的分裂,然而(34)(LogitBoost)偏向使得当前估计的响应方差var(yik)=pk(xi)(1−pk(xi))var (y_{ik})=p_k(x_i)(1-p_k(x_i))var(yik)=pk(xi)(1−pk(xi))之和更相等的分裂。

在数值稳定性上LKL_KLK_TreeBoost具有实际优势,当对于任何样本xix_ixi,(34)的值接近于0时,LogitBoost在数值上变得不稳定,这种现象经常发生。这是Newton–Raphson所面临的二阶导数消失的困难的结果。它的性能受到处理这个问题的方式的强烈影响(参见FHT00)。LKL_KLK_TreeBoost只有当(34)对一个终端节点的所有样本值接近于0时才会出现这种困难。这种情况发生的频率要低得多,发生时也更容易处理。

多分类过程的影响修剪与第4.5.1节中概述的二分类情况的影响修剪的实现方法相同。与每个“样本”(yik,xi)(y_{ik},x_i)(yik,xi)有关的是一个影响wik=∣y~ik∣(1−∣y~ik∣)w_{ik}=|\tilde{y}_{ik}|(1-|\tilde{y}_{ik}|)wik=∣y~ik∣(1−∣y~ik∣),当诱导第kkk颗树时它用于在当前迭代mmm中删除样本(27)。

5. 正则化

在预测问题中,过于紧密地拟合训练数据可能会适得其反。将除了一些点的训练数据上的期望损失减少,将导致分布的期望损失停止下降,并常常开始增加。正则化方法试图通过约束拟合过程来防止这种“过拟合”。对于加性展式(2),一个自然的正则化参数是项的数量MMM,这类似于分步回归,其中{h(x;am)}1M\{h(x;a_m)\}_1^M{h(x;am)}1M被认为是依次加入的解释变量。控制MMM的值可以调节训练数据上期望损失最小化的程度。MMM的最佳值可以通过一些模型选择方法来估计,比如使用一个独立的“测试”集,或者交叉验证。

通过控制展式中的项的数量来进行正则化,这就隐含了一种先验信念,即“稀疏”近似的项数越少,预测效果越好。然而,人们经常发现,通过收缩实现的正则化比通过限制项的数量实现的正则化效果更好[Copas(1983)]。在以前向分步规则(9)(10)构造的可加性模型(2)中,一个简单的收缩策略是将通用算法(算法1)的第6行替换为Fm(x)=Fm−1(x)+ν⋅ρmh(x;am), 0<ν⩽1(36)F_m(x)=F_{m-1}(x)+\nu\cdot\rho_mh(x;a_m),\ \ \ 0<\nu\leqslant 1\tag{36}Fm(x)=Fm−1(x)+ν⋅ρmh(x;am), 0<ν⩽1(36)且在所有特定的算法(算法2-6)中作相应的等价变化。每次更新都是简单地根据“学习率”参数ν\nuν的值进行缩放。

以这种方式引入收缩到梯度提升(36),提供了两种正则化参数,学习速率ν\nuν和项的数量MMM。任何一个都可以控制拟合的程度,从而影响到另一个的最佳值。减少ν\nuν的值会增加MMM的最佳值。理想地,我们应该同时最小化关于这两个参数的模型选择准则来估计这两个的最优值。这里还有计算方面的考虑,增加MMM的大小会使计算量按比例增加。

我们通过模拟实验来阐述这样的ν−M\nu-Mν−M之间的权衡。训练集有5000个样本{yi,xi}\{y_i,x_i\}{yi,xi}组成,其中yi=F∗(xi)+ϵiy_i=F^*(x_i)+\epsilon_iyi=F∗(xi)+ϵi目标函数F∗(xi), x∈R10F^*(x_i),\ x\in R^{10}F∗(xi), x∈R10是由6.1节中描述那样随机生成的,噪音ϵ\epsilonϵ是由零均值的正态分布生成,方差调整以满足在给定2/1的信噪比下E∣ϵ∣=12Ex∣F∗(x)−medianxF∗(x)∣E|\epsilon|={1\over2}E_x|F^*(x)-median_xF^*(x)|E∣ϵ∣=21Ex∣F∗(x)−medianxF∗(x)∣对于这个阐述,基学习器h(x;a)h(x;a)h(x;a)取为11个终端节点的以最佳优先的方式诱导(FHT00)的回归树。关于树大小选择的一般性讨论在第7节。

图1显示了对于不同的收缩参数ν∈{1.0,0.25,0.125,0.06}\nu\in\{1.0,0.25,0.125,0.06\}ν∈{1.0,0.25,0.125,0.06},LSLSLS_TreeBoost、LADLADLAD_TreeBoost和L2L_2L2_TreeBoost的拟合损失(LOF)作为项的数量(迭代次数)MMM的函数。对前两种方法,LOF是由估计F^M(x)\hat F_M(x)F^M(x)相对于最优常数解的平均绝对误差来度量的A(F^M(x))=Ex∣F∗(x)−F^M(x)∣Ex∣F∗(x)−medianxF∗(x)∣A(\hat F_M(x))={E_x|F^*(x)-\hat F_M(x)|\over E_x|F^*(x)-median_xF^*(x)|}A(F^M(x))=Ex∣F∗(x)−medianxF∗(x)∣Ex∣F∗(x)−F^M(x)∣对于逻辑回归的yyy值,是在xxx值的分布上把F∗(x)F^*(x)F∗(x)的中位数作为阈值来得到的;F∗(xi)F^*(x_i)F∗(xi)的值比中位数大则yi=1y_i=1yi=1,比中位数小则yi=−1y_i=-1yi=−1。因此贝叶斯错误率为零,但是决策边界相当的复杂。对L2L_2L2_TreeBoost有两种LOF计算方法;负二倍对数似然(偏差)和分类错误率Ex[1(y≠sign(F^M(x)))]E_x[1(y\neq sign(\hat F_M(x)))]Ex[1(y=sign(F^M(x)))]。所有LOF测量值都是通过使用一个包含10,000个观测值的独立验证集来计算的。

如图1所示,小的收缩参数ν\nuν(收缩)被认为导致更好的性能,尽管存在收益递减的最小值。对于较大的值,可以观察到过拟合的行为特征;性能达到MMM的某个值时达到最优,之后随着MMM的增加而降低。这种效果在LADLADLAD_TreeBoost和L2L_2L2_TreeBoost的错误率标准下不太明显。对较小的ν\nuν,可以减少过度拟合,正如所预期的那样。

尽管除了ν=1\nu=1ν=1很难看到分类错误率(右下)在逻辑似然可能已经达到最佳(左下)继续减少。因此,通过过拟合来降低似然实际上改善了分类错误率。尽管这可能违反直觉,但这并不矛盾;似然和错误率度量了拟合质量的不同方面。错误率只取决于F^M(x)\hat F_M(x)F^M(x)的符号而似然受其符号和量级的影响。显然,过拟合降低了量级估计的质量而不影响(有时改进)符号。因此,分类错误率对过度拟合的敏感性要小得多。

表1总结了包括如图1所示的几个ν\nuν值的模拟结果。显示了每个ν\nuν值(行)到达最低LOF的的迭代次数和相应的最小值(双列)。

ν−M\nu-Mν−M之间的权衡一览无遗;ν\nuν的较小产生较大的最佳MMM值,他们还提供更高的精度,ν<0.125\nu<0.125ν<0.125时收益递减。分类错误率当M≳200M\gtrsim200M≳200非常平缓,因此最佳MMM值不稳定。

虽然这里只阐述了一个目标函数和基学习器(11个终端节点树),但这些结果的定性性质是相当普遍的,其他的目标函数和树的大小(未显示)会导致相同的行为。这表明ν\nuν的最佳值取决于迭代次数MMM。后者应该在计算方便或者可行的时候尽可能大。ν\nuν值应该调整使得LOF达到其最小值,接近选择的MMM值。如果LOF在最后迭代时仍在减小,ν\nuν值或迭代次数MMM应该增加,最好是后者。考虑到算法的顺序性,它可以很容易地在以前完成的地方重新启动,因此不需要重复计算。LOF作为迭代次数的函数,最方便的估计方法是使用遗漏的测试样本。

如这里所示,降低学习速率可以明显地提高性能,通常是显著地提高性能。其原因尚不清楚。在每次迭代中收缩模型更新(36)产生的效果比整个模型的成比例收缩更复杂F^ν(x)=yˉ+ν⋅(F^M(x)−yˉ)\hat F_\nu(x)=\bar y+\nu\cdot(\hat F_M(x)-\bar y)F^ν(x)=yˉ+ν⋅(F^M(x)−yˉ)其中F^M(x)\hat F_M(x)F^M(x)是没有收缩的模型得到的。每个迭代中的更新ρmh(x;am)\rho_mh(x;a_m)ρmh(x;am)取决于前一个迭代的特定更新序列。增量收缩(36)产生的模型与全量收缩(38)非常不同。经验证据(未显示)表明,全量收缩(38)在没有收缩的情况下最多只能提供边际改善,远远达不到增量收缩的显著效果。增量收缩成功背后的神秘目前正在研究中。

6. 模拟研究

任何函数估计方法的性能取决于它所应用的特定问题。重要的影响性能的问题的特征包括训练样本大小NNN,真正的潜在的“目标”函数F∗(x)F^*(x)F∗(x)(1)以及来自F∗(x)F^*(x)F∗(x)的y∣xy|xy∣x的ϵ\epsilonϵ的分布。对于任何给定的问题,NNN总是知道,有时ϵ\epsilonϵ的分布也是知道的,例如当yyy是二元(伯努利)。当yyy是一个广义的实值变量ϵ\epsilonϵ的分布很少可知。在几乎所有情况下,F∗(x)F^*(x)F∗(x)的本质是未知的。

为了评估任何一种估计方法,有必要准确地评估它在许多不同情况下的表现。这是通过蒙特卡罗模拟最方便的实现,在蒙特卡罗模拟中,根据惯例的种类和精确计算的结果性能来生成数据。在本节中,描述了这样的几种研究,以试图理解前面几节中介绍的梯度增强程序的特性。尽管这样的研究远比仅仅通过几个选定的例子来评价这些方法要深入,但真实的或模拟的结果都具有一定的启发性。

6.1 随机函数生成器

任何问题影响性能的最重要的特征之一是真正的潜在目标函数F∗(x)F^*(x)F∗(x)(1),每种方法都有特定的目标,它是最合适的而其他就不是。由于目标函数的性质在不同的问题上可能有很大的不同,而且很少可知,所以我们比较了回归树梯度增强算法在各种随机生成目标函数上的优点。每个都有自己的形式F∗(x)=∑l=120algl(zl)(39)F^*(x)=\sum_{l=1}^{20}a_lg_l(z_l)\tag{39}F∗(x)=l=1∑20algl(zl)(39)系数{al}120\{a_l\}_1^{20}{al}120是从均匀分布中随机生成的,即al∼U[−1,1]a_l\sim U[-1,1]al∼U[−1,1]。每个gl(zl)g_l(z_l)gl(zl)都是一个大小为nln_lnl,有nnn个输入变量xxx的随机选择的子集的函数。特别地,zl={xPl(j)}j=1nlz_l=\{x_{P_l(j)}\}_{j=1}^{n_l}zl={xPl(j)}j=1nl这里PlP_lPl是一个独立的随机排列的整数{1,2,…,n}\{1,2,\dots,n\}{1,2,…,n},子集的大小nl{n_l}nl也是一个随机数,nl=⌊1.5+r⌋{n_l}=\lfloor1.5+r\rfloornl=⌊1.5+r⌋,rrr是从均值λ=2\lambda=2λ=2的指数分布中抽取的。因此,对每个gl(zl)g_l(z_l)gl(zl)的输入变量的预期数目在3到4之间。然而,大多数情况下会更少。这反映了对强的非常高阶交互作用影响的偏见。然而,对于已实现的F∗(x)F^*(x)F∗(x),20个函数gl(zl)g_l(z_l)gl(zl)中很大可能至少有几个将涉及高阶交互作用。在任何情况下F∗(x)F^*(x)F∗(x)都会是所有,或者几乎所有输入变量的函数。

每个gl(zl)g_l(z_l)gl(zl)都是一个nl{n_l}nl维的高斯函数gl(zl)=exp(−12(zl−μl)TVl(zl−μl))g_l(z_l)=\exp\big(-{1\over2}(z_l-\mu_l)^TV_l(z_l-\mu_l)\big)gl(zl)=exp(−21(zl−μl)TVl(zl−μl))其中每个均值向量{μl}120\{\mu_l\}_1^{20}{μl}120是和输入变量xxx相同的分布中随机生成的。nl×nln_l\times n_lnl×nl的协方差矩阵VlV_lVl也是随机生成的。特别地,Vl=UlDlUlTV_l=U_lD_lU_l^TVl=UlDlUlT这里UlU_lUl是随机正交矩阵(均匀或者Haar测度下)且Dl=diag{d1l…dnll}D_l=diag \{d_{1l}\dots d_{n_ll}\}Dl=diag{d1l…dnll},特征根的平方根是从均匀分布中随机生成的,即djl∼U[a,b]\sqrt{d_{jl}}\sim U[a,b]djl∼U[a,b],其中a,ba,ba,b取决于输入变量xxx的分布。

对于这里提出的所有研究,输入变量的数量取为n=10n = 10n=10,且他们的联合分布取为标准正态分布x∼N(0,I)x\sim N(0,I)x∼N(0,I)。特征值的限制为a=0.1,b=2.0a=0.1,b= 2.0a=0.1,b=2.0。虽然正态分布的尾端往往比实际遇到的数据尾端要短,但仍然比模拟研究中常用的均匀分布输入更具有真实感。此外,回归树不受长尾输入变量分布的影响,因此短尾在比较中具有相对优势。

在下面的模拟研究中,根据上述规则(39),(40)随机生成100个目标函数F∗(x)F^*(x)F∗(x)。性能是根据这些不同目标的近似误差分布[相对近似误差(37)或误分类风险]来评估的。这种方法允许在十维输入空间中根据轮廓的形状生成各种不同的目标函数。虽然低阶交互作用是有利的,但这些函数并不特别适合加性回归树。决策树生成的是张量积基函数,但目标函数F∗(x)F^*(x)F∗(x)的组成gl(zl)g_l(z_l)gl(zl)不是张量积函数。使用第8节中描述的方法,第一个随机生成的函数对一些更重要的参数的相关关系的可视化显示在第8.3节中。

虽然只有10个输入变量,但每个目标都是它们的函数。在许多数据挖掘应用程序中,有许多超过10个输入。然而,相关的维度是输入空间的内在维度以及实际影响输出响应变量yyy的输入的数量。在许多输入变量的问题中,通常存在很多变量之间的共线性度高的问题,并且独立变量的大致数量(近似内在维度)要小得多。而且,目标函数通常只依赖于所有输入的一小部分。

6.2 误差分布

在本节中,LSLSLS_TreeBoost、LADLADLAD_TreeBoost和MMM_TreeBoost在100个目标函数上通过两种不同的误差分布对它们的性能进行了比较。所有的算法都使用了拥有11个终端节点的最佳优先回归树。MMM_TreeBoost的参数分解设置为默认值α=0.9\alpha=0.9α=0.9,学习速率参数(36)在这里的模拟中都设置为ν=0.1\nu=0.1ν=0.1。

根据下式生成一百个数据集{yi,xi}1N\{y_i,x_i\}_1^N{yi,xi}1Nyi=F∗(xi)+ϵiy_i=F^*(x_i)+\epsilon_iyi=F∗(xi)+ϵi其中F∗(x)F^*(x)F∗(x)表示100个6.1节中描述的随机生成的每一个目标函数。对第一个实验,误差有一个零均值的正态分布生成,方差调整以满足给定1/1的信噪比下E∣ϵ∣=Ex∣F∗(x)−medianxF∗(x)∣E|\epsilon|=E_x|F^*(x)-median_xF^*(x)|E∣ϵ∣=Ex∣F∗(x)−medianxF∗(x)∣对第二个实验,误差由一个slash分布生成,ϵi=s⋅(u/v)\epsilon_i=s\cdot(u/v)ϵi=s⋅(u/v),这里u∼N(0,1), v∼U[0,1]u\sim N(0,1),\ v\sim U[0,1]u∼N(0,1), v∼U[0,1]。尺度因子sss调整得到1/1的信噪比(41)。slash分布有非常厚的尾常被用来测试稳健性。训练集大小取为N=7500N=7500N=7500,其中5000个作为训练,2500个剩下来作为测试样本估计最优的项目数量MMM。对100次试验的每次试验都生成额外5000个的验证样本(没有错误的)用来评估该试验的近似误差(37)。

图2中的左边显示了三种方法的两种误差分布在100个目标上近似误差(37)的箱形图。每个箱形图的阴影部分显示了四分位范围内的分布,其中白色条是中位数。外部链条表示距离(上/下)四分位数最近的点(±)1.5个四分位范围单位的点。孤立的条代表了这个范围之外的个别点(离群值)。

这些图允许对总体分布进行比较,但是没有提供关于单个目标函数的相对性能的信息。图2的右侧两个图像尝试提供这样的总结。它们显示了错误率的分布,而不是错误本身。对于每个目标函数和方法,该目标上方法的误差除以该目标上获得的最小误差,所有方法(这里有三种)都进行比较。因此,对于100个试验中的每一个,最佳方法的值为1.0,其他方法的值更大。如果一个特定的方法对于所有100个目标函数来说是最好的(误差最小),那么它的结果分布(箱线图)将是1.0的点质量。请注意,此比率的对数在右下角的图像中绘制。

从图2的左侧图像可以看出,100个目标对于所有三种方法来说都代表了相当广泛的难度范围;近似值误差相差两倍以上。对于正态分布误差,LSLSLS_TreeBoost的性能更好,这是可以预料到的。在73次试验中,它的误差最小,而在另外27次试验中,MMM_TreeBoost最好。平均LSLSLS_TreeBoost比最佳组差0.2%,MMM_TreeBoost差0.9%,LADLADLAD_TreeBoost比最佳组差7.4%。

对于slash分布的误差,情况正好相反。LSLSLS_TreeBoost的平均近似误差为0.95,因此只能解释5%的目标变化。然而在单个试验中,情况可能更好,也可能更糟。无论是LADLADLAD_TreeBoost还是MMM_TreeBoost,两者的性能都要好得多,具有可比性。LADLADLAD_TreeBoost最好32次,MMM_TreeBoost最好68次。平均来说,LADLADLAD_TreeBoost比最佳的差4.1%,MMM_TreeBoost差1.0%,LSLSLS_TreeBoost比best差364.6%,超过100个目标。

在这三种情况中,建议选择MMM_TreeBoost方法。在表现很好的(正常)和表现很差的(slash)误差的极端情况中,它的表现都非常接近最好的情况。相比之下,LADLADLAD_TreeBoost在正常误差情况下略有损失,LSLSLS_TreeBoost在slash误差情况下损失惨重。

6.3 LSLSLS_TreeBoost与MARS

所有的梯度提升树算法都会产生分段常数逼近。尽管这种分段的数量通常比由单独的一颗树生成的更大,这方面的近似函数F^M(x)\hat F_M(x)F^M(x)可能关于提供连续近似的方法存在缺点,特别是当真正的潜在目标函数F∗(x)F^*(x)F∗(x)(1)是连续和相当光滑时。所有随机生成的目标函数(39)、(40)都是连续且非常平滑的。在这一节中,我们在100个以上的目标函数中通过对比梯度树提升和MARS的精确度[Friedman (1991)] ,以此来研究分段常数的劣势。和TreeBoost一样,MARS也推出了一个基于张量积的近似。然而,它使用连续函数作为乘积因子,从而产生一个连续的近似。它还使用了一个更复杂的(逐步的)策略来得到张量积。

由于MARS基于最小二乘拟合,我们使用正态分布误差将其与LSLSLS_TreeBoost进行比较,同样采用1/1信噪比(41)。实验设置与6.2节相同。值得注意的是,在这里,MARS的性能通过使用2500个观察测试集进行模型选择而大大提升,而不是使用默认的广义交叉验证(GCV)准则[Friedman(1991)]。

图3的左上角图像在100个随机生成的目标函数(39)和(40)中比较了MARS的平均绝对近似误差的分布,与图2中的LSLSLS_TreeBoost的平均绝对近似误差分布。MARS的分布范围要大得多,变化幅度几乎是三分之一。在许多目标上,MARS做得比LSLSLS_TreeBoost好得多,而在许多目标上,MARS做得比LSLSLS_TreeBoost差得多。这进一步说明了目标函数的性质对不同方法的相对性能有很大的影响。图3的右上角图像显示了误差的分布,相对于每个目标的最佳情况。基于平均绝对误差,两种方法具有相似的性能。在许多目标函数中,每个目标的表现都明显优于另一个目标。

图3的底部两个图像显示了基于均方根误差的结果。在评估性能缺陷时,这给较大的错误增加了相应的权重。对于LSLSLS_TreeBoost来说,这两个误差的度量值对于100个目标来说都接近于相同的值。然而对于MARS,均方根误差通常比平均绝对误差高30%。这表明MARS的预测要么非常接近目标,要么离目标很远。LSLSLS_TreeBoost进行的误差分布更加均匀。它有更少的非常大的错误或非常小的错误。后者可能是由于分段逼近的结果,使得用有限大小的逼近法很难任意地接近非常平滑变化的目标函数。如图3所示,相对性能对用于度量它的标准非常敏感。

这些结果表明,提升树近似的分段常数方面不是一个严重的缺点。在正态误差和正态输入变量分布相当原始的环境中,它与MARS是竞争的。分段常数法的优点是鲁棒性;具体来说,它对宽尾和输入变量xxx中存在异常值这些负面影响免疫。产生连续近似的方法,比如MARS,对这类问题非常敏感。同样,如6.2节所示,MMM_TreeBoost(算法4)对于正态误差几乎与LSLSLS_TreeBoost一样准确,而且对输出yyy的离群值具有很强的抵抗力。因此,在数据挖掘应用中,如果数据的清洁度不能保证且xxx和/或yyy存在离群值,那么MMM_TreeBoost的相对较高的精度、一致的性能和鲁棒性可能是一个很大的优势。

6.4 LkL_kLk_TreeBoost、K分类LogitBoost和Adaboost.MH

在本节中,将LkL_kLk_TreeBoost的性能与K分类LogitBoost (FHT00)和Adaboost.MH [Schapire和Singer(1998)]在100个随机生成的目标(第6.1节)上进行了比较。这里K=5K = 5K=5个类是通过对输入xxx值分布上每个目标的0.2、0.4、0.6和0.8分位数进行阈值化而生成的。这里有N=7500N=7500N=7500个训练样本,其中每次试验(每个类1500)分5000个作为训练样本和2500样本用来模型选择(迭代次数,M)。使用独立生成的5000个验证样本来估计每个目标函数的错误率。

对于所有的目标函数,贝叶斯错误率为零,但诱导的策边界可以变得相当复杂,取决于每个目标函数F∗(x)F^*(x)F∗(x)的性质。每个方法使用11个终端节点的回归树。

图4显示了这三种方法在100个目标函数上的错误率分布(左)和除以最小值的比率(右)。三种方法的误差率在这些目标上有实质性的不同。LkL_kLk_TreeBoost被认为是普遍表现最好的。在78个试验中,它的误差最小,平均误差比每次实验中最好的高0.6%。LogitBoost在21个目标中表现最好,有一个并列。它的错误率比最好的平均高出3.5%。Adaboost.MH从来都不是最好的,平均比最好的还要差15%。

图5显示了与LogitBoost和Adaboost.MH对应的比较。Adaboost.MH程序修改为增量收缩(36),与LkL_kLk_TreeBoost一样收缩参数设置为相同的(默认)值ν=0.1\nu= 0.1ν=0.1。在这里,我们看到的是有些区别的画面。LogitBoost和AdaBoost.MH都大大得益于收缩。这三种程序的性能现在几乎相同,LogitBoost可能有一点优势,平均来说,它的错误率比最好的差0.5%;LKL_KLK_TreeBoost和AdaBoost.MH的对应值分别为2.3%和3.9%。这些结果表明,这些方法的相对性能更依赖于它们的aggressiveness,例如以学习率作为参数,而不是它们的结构差异。当分母接近0时,LogitBoost有一个额外的内部收缩,以稳定其伪响应(33)(FHT00),这也许可以解释为什么它在这种比较中略胜一筹。事实上,和图5所示的LogitBoost一样,当收缩增加应用于LKL_KLK_TreeBoost(ν=0.05\nu= 0.05ν=0.05)它的性能改善。当对这三种方法中的每一种都仔细调整收缩参数时,它们之间的性能差别可能很小。

7. 提升树

梯度提升算法(算法1)有两个主要的超参数,迭代次数MMM和学习速率ν\nuν(36)。这些都在第5节中有讨论。除了这些以外,还有一些和估计基学习器h(x;a)h(x;a)h(x;a)有关的超参数。本文的主要研究的重点是使用JJJ个终端节点数量固定的最佳优先回归树,因此,JJJ是基学习器的主要的超参数,它的最佳值十分依赖于目标函数的性质,换句话说,就是在这些变量中占主导的交互作用的最高阶数。

考虑函数的方差分析展式F(x)=∑jfj(xj)+∑j,kfjk(xj,xk)+∑j,k,lfjkl(xj,xk,xl)+⋯(42)F(x)=\sum_jf_j(x_j)+\sum_{j,k}f_{jk}(x_j,x_k)+\sum_{j,k,l}f_{jkl}(x_j,x_k,x_l)+\cdots\tag{42}F(x)=j∑fj(xj)+j,k∑fjk(xj,xk)+j,k,l∑fjkl(xj,xk,xl)+⋯(42)第一个和称为F(x)F(x)F(x)的“主效应”,它是由一些函数的和组成,这些函数每个都只依赖于一个输入变量。特殊的函数{fj(xj)}1N\{f_j(x_j)\}_1^N{fj(xj)}1N是那些在这种加性限制下提供了最近的F(x)F(x)F(x)的逼近。这有时候被称为加性模型,因为每个xj,fj(xj)x_j,f_j(x_j)xj,fj(xj)的贡献都会其他的加在一起。这是一个与(2)不同的、限制性更强的“加性”定义。第二个加和是由一对输入变量的函数组成,它们被称为双变量的“交互作用效应”。这样选择是在主效应下,不超过两个变量的限制下提供最接近F(x)F(x)F(x)的近似。第三个加和表示三变量交互作用效果,等等。

最高的交互阶数可能由输入变量的个数nnn限制。然而,特别是对很大的nnn,许多在实际中遇到的目标函数F∗(x)F^*(x)F∗(x)可以通过很低阶数的方差分析模型来很好地近似。(42)中只有前几项需要捕捉到F∗(x)F^*(x)F∗(x)的主要变化。事实上,相当大的成功往往是通过单独的加性项实现的[Hastie and Tibshirani(1990)]。纯粹的加性近似也可由“朴素”贝叶斯方法产生[Warner, Toronto, Veasey and Stephenson(1961)],这种方法通常在分类上非常成功。这些考虑激发了用于模拟研究的随机生成目标函数(第6.1节)中对低阶交互的偏向。

函数估计的目的是产生一个非常匹配目标函数F∗(x)F^*(x)F∗(x)的近似F^(x)\hat F(x)F^(x)。这通常要求F^(x)\hat F(x)F^(x)的主要交互阶数要和F∗(x)F^*(x)F∗(x)的相似。在boosting回归树中,交互阶数可以通过限制每次迭代生成的单颗树的大小来控制。一个有着JJJ个终端结点的树产生交互阶数最多为min(J−1,n)\min(J-1,n)min(J−1,n)的函数,boosting程序是加性的,因此整个近似的交互阶数应该不超过单颗树的最大交互阶数。因此,对于任何一种提升树程序,树的最佳大小JJJ都是被目标函数F∗(x)F^*(x)F∗(x)的有效交互阶数控制。这通常是未知的,因此JJJ就变成了需要用模型选择准则例如交叉验证或者留出法来调整的超参数。然而,正如上面所讨论的,我们不太需要或者想要很大的树。

图6显示了对于100个(6.1节)用来模拟研究的随机生成的函数,树的大小对于逼近精确性的影响。实验的初始设置和6.2节的一样,对于J∈{2,3,6,11,21}J\in\{2,3,6,11,21\}J∈{2,3,6,11,21},绝对误差(37)的分布(左图)以及对于每个目标误差相对于最小误差(右图)给出。第一个J=2J=2J=2只生成了加性的主效应部分;J=3J=3J=3生成了加性的和双变量的交互项,等等。一个JJJ个终端结点的树可以产生的交互阶数最大为min(J−1,n)\min(J-1,n)min(J−1,n),一般来说都小于这个值,特别是当J−1≲nJ-1\lesssim nJ−1≲n。

图6可以看出,最小的树J∈{2,3}J\in\{2,3\}J∈{2,3}平均产生了较低的精度,但是他们的分布比其他的宽很多,这意味着它们会产生更精确,甚至更不准确的近似。较小的树被限制在低阶交互中,因此能够更好地利用低交互阶数低的目标函数。然而,当他们尝试近似高阶交互作用的目标时表现就十分不好。J∈{6,11,21}J\in\{6,11,21\}J∈{6,11,21}的较大的树会更一致,他们牺牲了在低阶交互目标上的精度,但是在高阶函数中做得更好。在这些较大的树中也有一些差异,对J=21J=21J=21来说可能有轻微的退化。J=2J=2J=2的树产生了8次最精确的近似;J∈{3,6,11,21}J\in\{3,6,11,21\}J∈{3,6,11,21}分别对应产生了2、30、31、29次。平均上,J=2J=2J=2的树比每个目标函数的最低误差要高23.2%,而其他的分别对应16.4%、2.4%、2.2%和3.7%。当对每个目标分别估计最佳树大小JJJ时,应获得更高的精度。在实践中,这可以通过使用独立的测试集来评估不同树大小的使用情况来实现,如第9节所示。

8. 解释

在许多应用中,能够解释推导出来的近似F^(x)\hat F(x)F^(x)是非常有用的,这包括增加对于那些最影响变化的特定的输入变量的理解,以及在这些有影响的输入上F^(x)\hat F(x)F^(x)的独立性。某种程度上F^(x)\hat F(x)F^(x)至少定量地翻译了目标函数F∗(x)F^*(x)F∗(x)(1)的性质,这样的工具能够提供关于输入变量xxx和输出变量yyy的潜在关系的信息。在本节中,将会用一些工具来解释提升树逼近。尽管他们被用来解释单颗决策树,但是他们似乎在提升树(特别是很小的树)中更有效。这些解释工具在第9节的实际数据的例子中阐述。

8.1 输入变量的相对重要性

在一个逼近F^(x)\hat F(x)F^(x)中最重要的描述就是单个输入变量xjx_jxj在联合输入变量的分布上,对F^(x)\hat F(x)F^(x)变化的相对影响IjI_jIj。我们这样定义Ij=(Ex[∂F^(x)∂xj]2⋅varx[xj])1/2(43)I_j=\bigg(E_x\bigg[{\partial \hat F(x)\over \partial x_j}\bigg]^2\cdot var_x[x_j]\bigg)^{1/2}\tag{43}Ij=(Ex[∂xj∂F^(x)]2⋅varx[xj])1/2(43)对于由决策树产生的分段常数近似,(43)并不严格存在,它必须由反映其性质的替代度量来近似。Breiman、Friedman、Olshen和Stone(1983)提出I^j2(T)=∑t=1J−1l^t21(vt=j)(44)\hat I_j^2(T)=\sum_{t=1}^{J-1}\hat l_t^21(v_t=j)\tag{44}I^j2(T)=t=1∑J−1l^t21(vt=j)(44)其中这个和是对JJJ个终端结点的决策树TTT上的非终端节点ttt求和,vtv_tvt是和结点ttt有关的分裂变量,l^t2\hat l_t^2l^t2是作为分裂结果对应的平方误差的经验改进(35)。(44)式右端是和平方误差影响有关,因此它的单位对应了(43)的部分。Breiman、Friedman、Olshen和Stone(1983)直接使用(44)作为影响的度量,而不是平方影响。对于一个由boosting得到的决策树集{Tm}1M\{T_m\}_1^M{Tm}1M,(44)可以用序列中所有树的平均值来推广,即I^j2=1M∑m=1MI^j2(Tm)(45)\hat I_j^2={1\over M}\sum_{m=1}^{M}\hat I_j^2(T_m)\tag{45}I^j2=M1m=1∑MI^j2(Tm)(45)

(44)、(45)的动机纯粹是基于启发式的论证。作为部分的证明,我们证明了在最简单的环境中使用它会产生预期的结果。考虑一个线性目标函数F∗(x)=a0+∑j=1najxj(46)F^*(x)=a_0+\sum_{j=1}^na_jx_j\tag{46}F∗(x)=a0+j=1∑najxj(46)其中输入变量的协方差矩阵是单位矩阵的倍数Ex[(x−xˉ)(x−xˉ)T]=cInE_x\big[(x-\bar x)(x-\bar x)^T\big]=cI_nEx[(x−xˉ)(x−xˉ)T]=cIn在这种情况下,影响度量(43)得到Ij=∣aj∣(47)I_j=|a_j|\tag{47}Ij=∣aj∣(47)表2显示了与第六节类似的一个小的模拟实验的结果,但由于系数的取值aj=(−1)jj(48)a_j=(-1)^jj\tag{48}aj=(−1)jj(48)以及1/1的信噪比,F∗(x)F^*(x)F∗(x)(46)是线性的。在10个随机样本上给出了(44)和(45)的均值和标准差,F∗(x)F^*(x)F∗(x)由(46)(48)给出。估计出的最优影响的变量的影响xj∗x_{j^*}xj∗人为地赋予值Ij∗=100I_{j^*}=100Ij∗=100,其他变量的估计值响应地进行放缩。输入变量的估计的重要性排序在10次试验中每一次都是正确的。正如表2所示,估计的相对重要性的值和(47)与(48)式给出的一致。

在Breiman, Friedman, Olshen和Stone1983年的研究中,影响度量(44)被一种涉及替代分割的策略所扩张,该策略旨在发现与影响变量高度相关的其他隐藏的重要变量。这种策略对于单个决策树最有帮助,因为由于(44)中树的大小JJJ的限制,单个决策树参与分裂的变量的机会有限。然而,在boosting中,分裂的机会大大增加了(45),而相应地,用替代方法去揭露就不那么重要了。

在KKK分类的逻辑回归和分类(4.6节)中,存在KKK个逻辑回归函数{FkM(x)}k=1K\{F_{kM}(x)\}_{k=1}^K{FkM(x)}k=1K,每一个都是由一列MMM决策树描述。这样(45)就推广为I^jk2=1M∑m=1MI^j2(Tkm)(49)\hat I_{jk}^2={1\over M}\sum_{m=1}^{M}\hat I_j^2(T_{km})\tag{49}I^jk2=M1m=1∑MI^j2(Tkm)(49)其中TkmT_{km}Tkm是在第mmm次迭代中的第kkk类引导出来的树。I^jk\hat I_{jk}I^jk的值可以解释为预测变量xjx_jxj将kkk类与其他类分隔开来的相关性。xjx_jxj的所以的相关性可以由所有类求平均得到I^j=1K∑k=1KI^jk\hat I_j={1\over K}\sum_{k=1}^K\hat I_{jk}I^j=K1k=1∑KI^jk然而,单个I^jk\hat I_{jk}I^jk也非常有用。通常情况下,不同变量的子集与不同类的子集高度相关。这种更详细的知识可能导致仅通过检查整体相关性无法获得。

8.2 部分依赖图

可视化是最重要的解释工具之一。作为其参数的函数F^(x)\hat F(x)F^(x)的图像描述提供了在输入变量的联合分布上的依赖性的综合总结。但不幸的是,这样的可视化只限制在低维参数中,单个实值变量xxx的函数F^(x)\hat F(x)F^(x)可以用F^(x)\hat F(x)F^(x)的值与xxx的每个对应值的关系图来表示。单个分类变量的函数可以由条形图来表示,每条表示其中一个值,且条形的高表示函数的值。两个实值变量的函数可以用轮廓或透视网格图来画出。一个分类变量和另外一个变量(实值或者分类)最好由一系列图来总结,每一个显示了限制在第一个变量的各自的值上,在第二个变量上F^(x)\hat F(x)F^(x)的依赖性[Becker and Cleveland (1996)]。

观察高维参数的函数更加困难,因此观察逼近F^(x)\hat F(x)F^(x)在选择的输入变量的小的子集上的部分依赖性是很有用的。尽管这样的图像的集合不能提供一个全面的逼近的描述,但是它常常可以提供有用的线索,特别是当F^(x)\hat F(x)F^(x)由一些低阶交互作用主导时(第7节)。

令zlz_lzl表示输入变量xxx的被选中的目标子集,大小为lllzl={z1,…,zl}⊂{x1,…,xn}z_l=\{z_1,\dots,z_l\}\subset \{x_1,\dots,x_n\}zl={z1,…,zl}⊂{x1,…,xn}且z\lz_{\backslash l}z\l表示补集z\l∪zl=xz_{\backslash l}\cup z_l=xz\l∪zl=x逼近F^(x)\hat F(x)F^(x)主要取决于这两个子集的变量F^(x)=F^(zl,z\l)\hat F(x)=\hat F(z_l,z_{\backslash l})F^(x)=F^(zl,z\l)如果我们对z\lz_{\backslash l}z\l里的变量规定一些特殊的值,那么F^(x)\hat F(x)F^(x)可以看做是仅作为所选子集zlz_lzl中变量的函数F^z\l(zl)=F^(zl∣z\l)(50)\hat F_{z_{\backslash l}}(z_l)=\hat F(z_l|z_{\backslash l})\tag{50}F^z\l(zl)=F^(zl∣z\l)(50)

一般地,F^z\l(zl)\hat F_{z_{\backslash l}}(z_l)F^z\l(zl)的函数形式将取决于为z\lz_{\backslash l}z\l所选的特定的值。然而,如果这种依赖性太强,那么平均函数Fˉl(zl)=Ez\l[F^(x)]=∫F^(zl,z\l)p\l(zl)dz\l(51)\bar F_l(z_l)=E_{z_{\backslash l}}[\hat F(x)]=\int\hat F(z_l,{z_{\backslash l}}){p_{\backslash l}}(z_l)d{z_{\backslash l}}\tag{51}Fˉl(zl)=Ez\l[F^(x)]=∫F^(zl,z\l)p\l(zl)dz\l(51)就可以表示在选择的变量子集zlz_lzl上F^(x)\hat F(x)F^(x)的部分依赖的有用的总结。这里p\l(zl){p_{\backslash l}}(z_l)p\l(zl)为zlz_lzl的边际概率密度p\l(zl)=∫p(x)dzl(52){p_{\backslash l}}(z_l)=\int p(x)dz_l\tag{52}p\l(zl)=∫p(x)dzl(52)其中p(x)p(x)p(x)是所有输入xxx的联合密度。根据训练数据估计补集的边际密度(52),则(51)为Fˉl(zl)=Ez\l[F^(x)]=1N∑i=1NF^(zl,zi,\l)(53)\bar F_l(z_l)=E_{z_{\backslash l}}[\hat F(x)]={1\over N}\sum_{i=1}^N\hat F(z_l,{z_{i,\backslash l}})\tag{53}Fˉl(zl)=Ez\l[F^(x)]=N1i=1∑NF^(zl,zi,\l)(53)

在特殊情况下,F^(x)\hat F(x)F^(x)在zlz_lzl上的依赖是加性的F^(x)=F^l(zl)+F^\l(z\l)(54)\hat F(x)=\hat F_l(z_l)+\hat F_{\backslash l}(z_{\backslash l})\tag{54}F^(x)=F^l(zl)+F^\l(z\l)(54)或者乘性的F^(x)=F^l(zl)⋅F^\l(z\l)(55)\hat F(x)=\hat F_l(z_l)\cdot\hat F_{\backslash l}(z_{\backslash l})\tag{55}F^(x)=F^l(zl)⋅F^\l(z\l)(55)(50)式F^z\l(zl)\hat F_{z_{\backslash l}}(z_l)F^z\l(zl)的形式不依赖于补变量z\lz_{\backslash l}z\l的联合值。则(51)式Fˉl(zl)\bar F_l(z_l)Fˉl(zl)给出了在选择的输入变量子集zlz_lzl上F^(x)\hat F(x)F^(x)变化的性质的完整描述。

在子集zlz_lzl上F^(x)\hat F(x)F^(x)的依赖性的另外一种总结方式是直接将F^(x)\hat F(x)F^(x)作为训练数据上zlz_lzl的函数模型F~l(zl)=Ex[F^(x)∣zl]=∫F^(x)p(z\l∣zl)dz\l(56)\tilde F_l(z_l)=E_x[\hat F(x)|z_l]=\int\hat F(x){p}(z_{\backslash l}|z_l)d{z_{\backslash l}}\tag{56}F~l(zl)=Ex[F^(x)∣zl]=∫F^(x)p(z\l∣zl)dz\l(56)然而,在条件密度(56)而不是边际密度(51)上取平均,导致F~l(zl)\tilde F_l(z_l)F~l(zl)不仅反映在选择的输入变量子集zlz_lzl上F^(x)\hat F(x)F^(x)的依赖性,此外,还有仅仅通过它们和补变量z\lz_{\backslash l}z\l之间的联系诱导的明显的依赖性。例如,如果zlz_lzl恰好是加性的(54)或乘性的(55),(56)F~l(zl)\tilde F_l(z_l)F~l(zl)不会估计对应的项或因子F^l(zl)\hat F_l(z_l)F^l(zl),除非联合密度p(x)p(x)p(x)碰巧是乘积p(x)=pl(zl)⋅p\l(z\l)(57)p(x)=p_l(z_l)\cdot p_{\backslash l}(z_{\backslash l})\tag{57}p(x)=pl(zl)⋅p\l(z\l)(57)

部分依赖函数(51)可用于解释任何“黑盒”预测方法生成的模型,如神经网络、支持向量机、最近邻、径向基函数等。当有大量的预测变量时,有一个依赖性度量是非常有用的(第8.1节),以减少潜在的大量变量和要考虑的变量组合。同样,需要对数据进行一次传递(53),以便为参数的每一组联合值zlz_lzl对每个Fˉl(zl)\bar F_l(z_l)Fˉl(zl)求值。对于大型数据集来说,这可能非常耗时,不过子集抽样可能会有所帮助。

然而对于基于单变量分裂的回归树,F^(x)\hat F(x)F^(x)在特定目标变量子集zlz_lzl(51)上的部分依赖性直接计算给定的树,而不参考数据本身(53)。对变量zlz_lzl的一组特定值,将执行树的加权遍历。在树的根节点,赋值为1。对于所访问的每个非终端节点,如果其分割变量位于目标子集zlz_lzl中,则访问适当的左子节点或右子节点,并且不修改权重。如果节点的分类变量在补子集z\lz_{\backslash l}z\l中,则访问两个子节点,并将当前权重乘以在该节点分别向左或向右移动的训练样本的比例。

遍历过程中访问的每个终端节点都被赋予当前的权值。当树遍历完成,Fˉl(zl)\bar F_l(z_l)Fˉl(zl)的值是在树遍历访问的终端结点上F^(x)\hat F(x)F^(x)相应值的加权平均。对于通过boosting得到的MMM个回归树的集合,对每个树的结果进行简单平均。

通过图的展示来达到解释的目的,如果输入变量子集是低势的(l⩽2l\leqslant 2l⩽2),大部分情况下是有用的。这样的包含信息最多的子集可能由那些被认为是导致F^(x)\hat F(x)F^(x)变化的最具影响力的(44),(45)的输入变量组成,第8.3节和第9节中提供了依赖说明。

在子集zlz_lzl上F^(x)\hat F(x)F^(x)的依赖性越是加性(54)或者乘性(55)的,那么部分依赖函数Fˉl(zl)\bar F_l(z_l)Fˉl(zl)(51)在推导出来的逼近F^(x)\hat F(x)F^(x)上就越是能捕捉到zlz_lzl中变量的影响的性质。因此,将有影响的输入组成起来的子集zlz_lzl提供了最真实的部分依赖图像。作为诊断,Fˉl(zl)\bar F_l(z_l)Fˉl(zl)和Fl(z\l)F_l(z_{\backslash l})Fl(z\l)都可以分别计算候选子集。在训练集上F^(x)\hat F(x)F^(x)和{Fˉl(zl),Fl(z\l)}\{\bar F_l(z_l),F_l(z_{\backslash l})\}{Fˉl(zl),Fl(z\l)}之间,或者和Fˉl(zl)⋅Fl(z\l)\bar F_l(z_l)\cdot F_l(z_{\backslash l})Fˉl(zl)⋅Fl(z\l)之间的多种依赖系数的值都可以用来衡量F^(x)\hat F(x)F^(x)关于一个选择的子集zlz_lzl的加性或者因子可分解性的程度。作为加性诊断,(50)式F^z\l(zl)\hat F_{z_{\backslash l}}(z_l)F^z\l(zl)可以用来计算从训练集中随机选择的比较少的z\lz_{\backslash l}z\l值。zlz_lzl的结果函数可以比作Fˉl(zl)\bar F_l(z_l)Fˉl(zl)来判断在zlz_lzl上关于z\lz_{\backslash l}z\l的改变值的部分依赖性。

在KKK分类逻辑回归和分类(4.6节)中,存在KKK个逻辑回归函数{Fk(x)}k=1K\{F_k(x)\}_{k=1}^K{Fk(x)}k=1K,由(29)式每个都是和pk(x)=Pr(y=k∣x)p_k(x)=Pr(y=k|x)pk(x)=Pr(y=k∣x)对数依赖。Fk(x)F_k(x)Fk(x)的较大值意味着更高的在xxx处观察到kkk类的概率。每个Fk(x)F_k(x)Fk(x)在变量子集zlz_lzl上对最依赖的那个类的部分依赖图(49)提供了输入变量如何影响各自的类概率的信息。

8.3 随机生成的函数

在本节中,前面两节中描述的解释工具适用于第6节蒙特卡罗研究中使用的第一个(100个)随机生成的函数(第6.1节)。

图7显示了10个输入预测变量的估计相对重要性(44)、(45)。有些变量被认为比其他的更有影响力,但似乎没有一个小的子集占主导地位。这与用来生成这些函数的机制是一致的。

图8显示了在6个最具影响力的变量上的单变量(l=1l = 1l=1)部分依赖图(53)。每个图底部的散列标记表示相应预测变量分布的十分位数。近似的分段常数性质是明显的。与大多数近似方法不同,TreeBoost模型没有明确的平滑度约束。任意尖锐的不连续点可以容纳。这些图中显示的一般平滑趋势表明,平滑近似最能描述这个目标。这与生成这些函数的方式是一致的。

图9显示了两个变量(l=2l = 2l=2)对一些更有影响力的变量的部分依赖图。这些变量对之间存在不同程度的交互作用。这与这些目标函数实际生成的方式一致(39),(40)。

考虑到这些生成的目标作为其参数的函数的一般复杂性,不太可能通过一系列这样的部分依赖图来揭示它们完整的详细的函数形式。我们的目标是获得对函数关系的一些重要方面的可理解的描述。在本例中,目标函数是由已知的设定生成的,因此至少我们可以定性地验证这里的情况。

9. 真实数据

在本节中,提升树回归算法将在两个中等大小的数据集上进行说明。6.4节的结果表明,分类算法LkL_kLk_TreeBoost的性质和LogitBoost的很像,都是把FHT00广泛应用于数据。第一个(科学)数据集包含对岩石样本的化学浓度测量,第二个(人口统计学)数据集是样本调查问卷数据。两个数据集都被分割为一个占三分之二的学习样本,剩下的作为测试样本来选择模型大小(迭代次数MMM)。收缩参数(36)设置为ν=0.1\nu=0.1ν=0.1。

9.1石榴石数据

这个数据集包含N=13317N=13317N=13317个从世界各地收集的石榴石样本 [Griffin, Fisher, Friedman, Ryan and O’ Reilly (1997)]。石榴石是一种复杂的钙-镁-铁-铬硅酸盐复合物,通常作为组成地幔的岩石中的一个小相位出现。与每一个石榴石相关的变量是各种化学物质的浓度和岩石收集的构造板块环境:(TiO2,Cr2O3,FeO,MnO,MgO,CaO,Zn,Ga,Sr,Y,Zr,tec)(TiO_2, Cr_2O_3, FeO, MnO, MgO, CaO, Zn, Ga, Sr, Y, Zr, tec)(TiO2,Cr2O3,FeO,MnO,MgO,CaO,Zn,Ga,Sr,Y,Zr,tec)

代表浓度的前11个变量是实值。最后一个变量(tec)有三个分类值:“古代稳定盾构”、“元古代盾构区”和“年轻造山带”。这些数据中没有缺失的值,但是许多变量的分布倾向于更大的值,有许多异常值。

本实验的目的是估计钛(TiO2TiO_2TiO2)的浓度作为其他化学物质的联合浓度和构造板块指数的函数。

表3是基于测试样本,对几个不同大小值(终端结点数)JJJ个构成树的LSLSLS_TreeBoost、LADLADLAD_TreeBoost以及MMM_TreeBoost的输出变量yyy相对于最优常数预测的平均绝对误差A(y,F^(x))=Ey,x∣y−F^(x)∣Ey∣y−median(y)∣(58)A(y,\hat F(x))={E_{y,x}\big|y-\hat F(x)\big|\over E_y\big|y-median(y)\big|}\tag{58}A(y,F^(x))=Ey∣∣y−median(y)∣∣Ey,x∣∣y−F^(x)∣∣(58)注意,这个预测误差(58)包括关于潜在(未知的)目标函数F∗(x)F^*(x)F∗(x)加性的不可约的错误。这不可约错误在表3所有条目中增加相同的数量。因此,这些项的差异反映了对目标函数本身的近似误差(37)按比例更大的改进。

对于这三种方法,加法(J = 2)近似明显不如使用更大的树,这表明输入变量之间存在交互作用(第7节)。六个终端节点树被认为是足够的,而仅使用三个终端节点树被认为提供了最好的10%的准确率。LADLADLAD_TreeBoost和MMM_TreeBoost的误差比LSLSLS_TreeBoost的小,且彼此相似,可能MMM_TreeBoost有微弱的优势。这些结果与模拟研究结果一致,如图2和图6所示。

图10显示了用六个终端结点树基于MMM_TreeBoost逼近来预测TiO2TiO_2TiO2浓度的11个输入变量的相对重要性(44)和(45)。对于表3中的其他模型,结果非常相似,并且有类似的错误。Ga和Zr被认为是最有影响力的,而MnO则不那么重要。图11的上面三个小图展示了在这三个最优影响的变量上,近似F^(x)\hat F(x)F^(x)的部分相关性(51) 。下面三个底部的图像显示了这些变量三个配对上的F^(x)\hat F(x)F^(x)的部分相关性(51) 。Ga与Zr之间存在明显的强交互作用。当其他变量取值很小时,F^(x)\hat F(x)F^(x)几乎和这些变量没有相关性。随着他们其中之一的值增加,F^(x)\hat F(x)F^(x)在其他变量上的相关性也相应地增大。MnO与Zr之间的交互效应较小。

9.2 人口统计数据

该数据集由旧金山湾区的购物中心的顾客填写的N=9409N = 9409N=9409份问卷组成[Impact Resources, Inc, Columbus, Ohio(1987)]。在这里,我们使用前14个问题的答案来举例说明,这些问题与人口统计学有关。这些问题列在表4中。这些数据由若干个连续和分类的变量组成,每个变量有一个小数目的不同的值。有许多缺失的值。

我们通过将收入建模为其他13个变量的函数来说明提升树。表5显示了三种回归提升树算法在预测收益时相对于最佳常数预测器(58)的平均绝对误差。

这三种方法的性能差别不大。由于这些数据的高度离散性,实值输入或输出yyy之间不存在异常值或长尾分布。随着组成树大小JJJ的增加,误差几乎没有减少,表明输入变量之间缺乏交互作用;在单独的输入变量(J=2J = 2J=2)中添加一个加法逼近似乎是足够的。

图12显示了基于(J=2J = 2J=2)LSLSLS_TreeBoost逼近的输入变量在预测收入中的相对重要性。没有一个小的子集是占主导地位的。图13显示了6个最具影响力的变量的部分依赖图。分类变量用条形图表示,所有的条形图都以数据均值为零为中心。因为逼近只由主要影响组成[(42)中的第一个和],这些图像完全描述了每个输入的相应的贡献fj(xj)f_j(x_j)fj(xj)。

在图13中似乎没有任何令人惊讶的结果。相关性在很大程度上证实了先前的猜测,并表明这种近似在直觉上是合理的。

10. 数据挖掘

作为预测数据挖掘的“现成”工具,提升树程序具有一些吸引人的特性。他们继承了决策树良好的性质,而减轻了一些不好的。所有提升树过程在所有单个输入变量的(严格)单调变换下都是不变的。例如,用xj,logxj,exjx_j,\log x_j,e^{x_j}xj,logxj,exj或xjax^a_jxja作为第jjj个输入变量都会得到相同的结果。因此,考虑输入变量转换的必要性被消除了。作为这种不变性的结果,对长尾分布和异常值的敏感性也被消除了。此外,LADLADLAD_TreeBoost对于输出变量yyy中的异常值也是完全健壮的。MMM_TreeBoost对输出异常值的健壮性也有一定的度量。

决策树诱导的另一个优点是内部特征选择。对于添加不相关的输入变量,树往往非常健壮。此外,基于树的模型以统一而优雅的方式处理缺失的值[Breiman, Friedman, Olshen and Stone(1983)],没有必要考虑额外的处理方案。提升树显然也继承了这些特性。

单一树模型的主要缺点是不准确。这是由于他们的分段常数近似粗糙性(特别是对于较小的树)和不稳定性(特别是对于较大的树),以及他们所涉及的主要是高阶相互作用的事实的结果。所有这些都通过boosting得到了缓解。提升树程序产生分段常数近似,但是间隔尺寸要细得多。提升树通过使用小树和在许多小树上取平均值的效果来提高稳定性。通过限制各组成树的大小,有效地控制了提升树近似的交互水平。

单一树模型的最大优点之一是可解释性,而提升树则被认为缺乏这一特性。小树容易解释,但由于不稳定,这种解释应该谨慎对待。较大的树的可解释性是有问题的[Ripley(1996)]。提升树近似可以与输入变量相对重要性度量一起,使用部分依赖图进行解释,如第8.3节和第9节所示。虽然没有提供一个完整的描述,但至少提供了对输入-输出关系本质的一些了解。虽然这些工具可以用于任何近似方法,但基于树的模型的特殊特性使它们能够快速计算。部分依赖图也可以用于单个回归树,但是如上所述,由于更大的不稳定性,需要更加谨慎。

在对输入变量进行排序之后,回归提升树程序(LSLSLS_,LADLADLAD_和MMM_TreeBoost)的计算量与样本数量NNN、输入变量的数量nnn和迭代次数MMM成线性关系。分类算法LKL_KLK_TreeBoost的规模约为构成树的大小JJJ的对数。此外,分类算法LKL_KLK_TreeBoost的规模与类的数量KKK成线性关系;但是,如果使用影响修整(章节4.5.1),则与迭代次MMM呈高度的亚线性关系。作为一个参考,对第9.1节的石榴石数据(N=13317,n=11,J=6,M=500N = 13317,n = 11,J = 6,M = 500N=13317,n=11,J=6,M=500)应用MMM_TreeBoost,在933Mh奔腾III的电脑上需要20秒。

正如第5节所述,基于小的收缩值参数ν\nuν(36),许多boosting迭代(M≃500M\simeq 500M≃500)可以获得最佳提升树近似。这在一定程度上由于在每次迭代中引入的树非常小而得到缓解。然而,正如图1所示,改进最初非常快,然后逐渐变慢。因此,几乎可以在相当早期(M≃100M\simeq 100M≃100)以及相应的更少的计算来实现最优近似。这些接近最优的近似可用于最初的探索,并表明最终的近似是否具有足够的准确性以保证继续下去。如果在最初的几次迭代中(比如100次),拟合不匹配的改善非常小,那么之后就不太可能有显著的改善。如果判断延续是合理的,则可以在先前停止的地方重新启动过程,这样就不会损失计算的投资。此外,我们还可以使用更大的收缩参数来加速初始化。如图1所示,使用ν=0.25\nu= 0.25ν=0.25在迭代20次后就提供了精度在10%的最优(ν=0.1\nu= 0.1ν=0.1)解。然而,在这种情况下,如果随后使用较小的收缩参数值,则必须重新启动boosting。

提升树程序能够提供潜在可预测性的快速指示,加上其强大的鲁棒性,使其成为一个有用的预处理工具,可以应用于不完美的数据。如果有足够的预指示能力,可以进行进一步的数据清理,使其适合于更复杂、更不健壮的建模过程。

如果在建模完成后有更多的数据可用,则可以从以前的解开始对新数据进行增强。如果使用独立的测试集来监视改进,以防止对新数据的过度拟合,则通常可以提高准确性。虽然精度的提高一般小于对合并数据重新进行整个分析所得到的精度,但是节省了大量的计算。

当随机存取内存不足以存储整个数据集时,可以在连续子集的数据上运用boosting。boosting可以应用于“arcbites”[Breiman(1997)]数据顺序读入内存,每次从当前的解开始,在时间允许的情况下在先前的子集上循环。同样,重要的是使用一个独立的测试集来停止对每个单独子集的训练,此时合并近似的估计精度开始下降。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)