一种语义分割损失函数LovaszSoftmax

论文:The Lovasz-Softmax loss: A tractable surrogate for the optimization of theintersection-over-union measure in neural networksGithub:https://github.com/bermanmaxim/LovaszSoftmaxCVPR2018论文提出了LovaszSof

(在做语义分割的过程中,用到了LovaszSoftmax。针对本人的数据集,多分类时,LovaszSoftmax的效果优于CrossEntropy;二分类时,dice loss相对较好。

仅限本人的数据集,若有更好的方法和结果,欢迎留言讨论。

鉴于此,转载了一篇关于LovaszSoftmax的博客,记录一下心路历程。以下是转载原文,偷个懒 ^_^ )

==================================================================================================

Github:https://github.com/bermanmaxim/LovaszSoftmax

CVPR2018

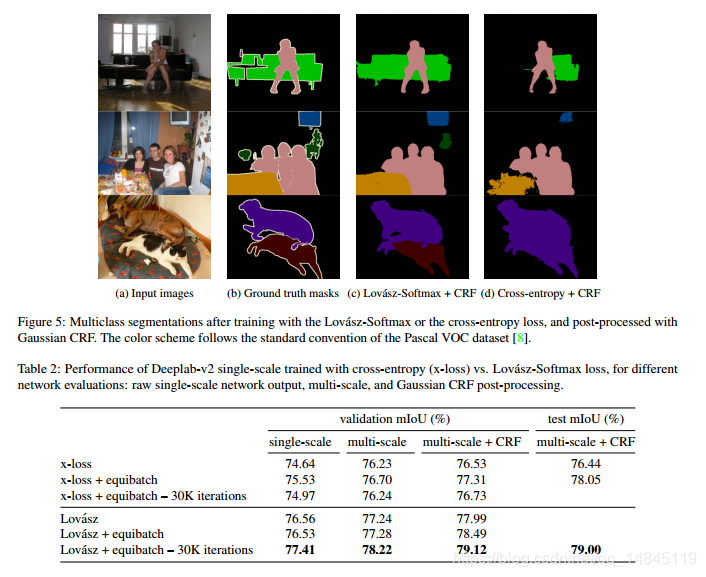

论文提出了LovaszSoftmax,是一种基于IOU的loss,效果优于cross_entropy,可以在分割任务中使用。最终在Pascal VOC和 Cityscapes 两个数据集上取得了最好的结果。

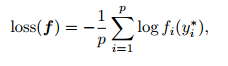

cross_entropy loss:

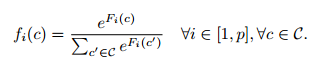

Softmax 函数:

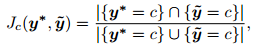

Jaccard index :

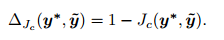

优化的IOU loss:

论文贡献:

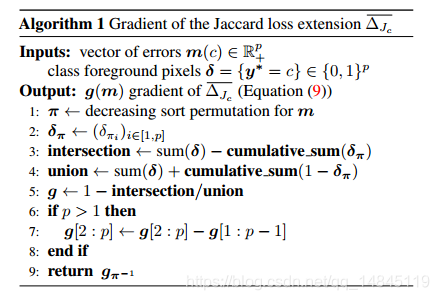

- 结合Lovasz hinge 和Jaccard loss 解决2值图片的分割问题

- 提出了Lovasz-Softmax loss 对多个类别分割的参数设置

- 设计了一个基于batch的IOU作为基于dataset IOU的高效代理

- 分析和对比各种IOU测量方法

- 基于本文的loss,对经典的分割方法的分割效果做出很大的提升

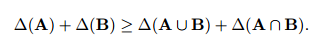

定义1:

定义2:

得出:

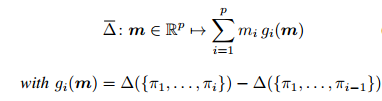

(1)对于前景背景分割的问题,使用Lovasz hinge

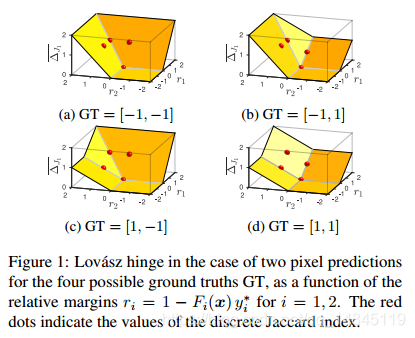

(2)对于多类别分割问题,使用Lovasz-Softmax loss

前景背景分割:

多类别分割:

优化的IOU:

实验结果:

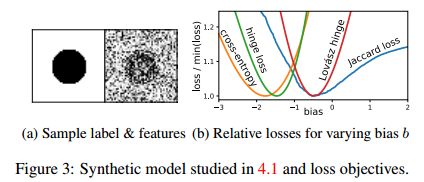

(a)中第一个图为label,第二个图为特征,通过对第一个图进行高斯滤波

fi ∼ N (e; 1) ,e=1/2对于前景,e=-1/2对于背景。

(b)Lovasz hinge 的bias的绝对最小值和Jaccard loss 最接近

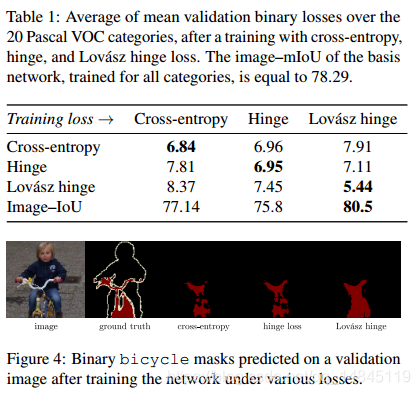

二类分割:

多类分割:

总结:

分割任务可以使用的loss,相比cross entropy具有更好的效果。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)