Python —— jieba库

jieba是一个高效的中文分词库,支持精确模式、全模式、搜索引擎模式等多种分词方式,适用于文本分析、自然语言处理等场景。

·

一、jieba 简介

jieba 是一个高效的中文分词库,支持精确模式、全模式、搜索引擎模式等多种分词方式,适用于文本分析、自然语言处理等场景。

二、安装方法

pip install jieba三、jieba 支持多种分词模式,常用的有以下三种:

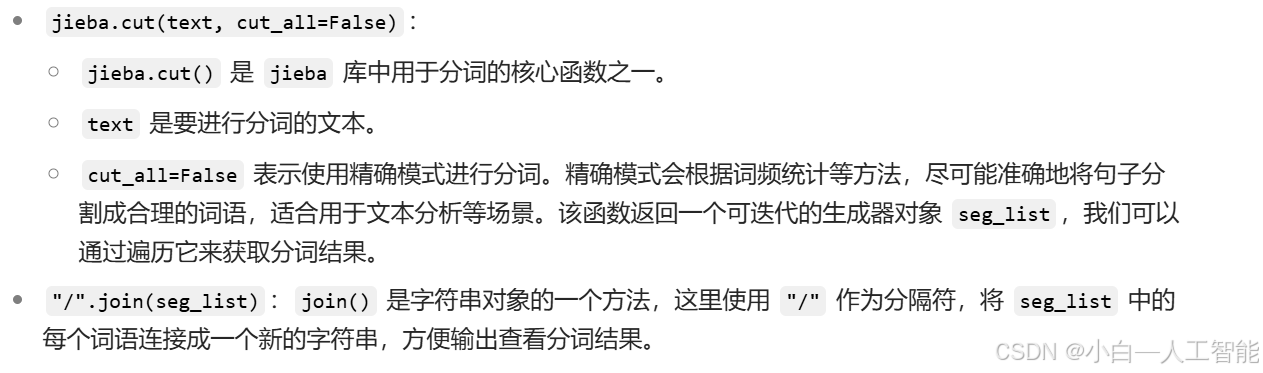

(1)精确模式:基于词频统计,尽可能精确地将句子切开,适合文本分析,是默认分词模式。

import jieba

text = "我爱自然语言处理技术"

seg_list = jieba.cut(text, cut_all=False) # cut_all=False 表示精确模式

print("精确模式:", "/".join(seg_list))

# 输出:我/喜欢/自然语言处理

(2)全模式:扫描出句子中所有可能成词的词语,速度快,但会有冗余和歧义。

import jieba

text = "我爱自然语言处理技术"

seg_list = jieba.cut(text, cut_all=True)

print("/".join(seg_list)) ![]()

(3)搜索引擎模式:在精确模式基础上,对长词再次切分,提供更多关键词,适合搜索引擎构建索引。

import jieba

text = "我爱自然语言处理技术"

seg_list = jieba.cut_for_search(text)

print("/".join(seg_list))

# 输出:我/喜欢/自然/语言/自然语言/处理/语言处理四、转列表

text = "中文分词很重要"

seg_list = jieba.lcut(text) # 直接返回列表

print(seg_list) # ['中文', '分词', '很', '重要']更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)