基于Ollama于D盘安装deepseek-r1到11343漏洞问题

本次使用的Ollama版本为0.5.12,安装是deepseek-r1:8B模型,Ollama后续会持续更新中。本地部署deepseek大模型已经是比较常见的话题,由于官网的deepseek大模型访问量很高,容易出现服务器宕机,需要持续提交问题才能解决,很难及时满足解决用户需求,所以需要本地部署。由于电脑配置的问题,无法部署全版671B需要很高的运算设备,所有基于个人工作和生活使用,32B以下的模

提示:欢迎志同道合朋友一起交流学习,一起探索人工智能应用,一起迈进超级个体时代!

文章目录

一、前言

本次使用的Ollama版本为0.5.12,安装是deepseek-r1:8B模型,Ollama后续会持续更新中。

本地部署deepseek大模型已经是比较常见的话题,由于官网的deepseek大模型访问量很高,容易出现服务器宕机,需要持续提交问题才能解决,很难及时满足解决用户需求,所以需要本地部署。由于电脑配置的问题,无法部署全版671B需要很高的运算设备,所有基于个人工作和生活使用,32B以下的模型参数已经足够使用。

早期版本Ollama版本具有无权访问的漏洞,11343端口的全开放,暴露在公网下可能被用于控制服务器或窃取敏感数据,增加用户使用风险。

提示:以下是本篇文章正文内容,下面案例可供参考

二、Ollama的安装和配置

1、从D盘安装ollama

默认的Ollama按照路径为C盘,由于考虑到后续大模型的储存问题,所以安装在其它盘可以节约C盘空间,特别是我这种红色C盘内存告急情况。

关于Ollama的下载问题,需要关闭防火墙后才能从官网下载Windows的.exe安装包,并将安装包放置在指定的文件夹,然后就是安装路径的配置。首先需要在D盘配置前置文件,使用CMD来执行。

C:\Users\...>d:

D:\>setx OLLAMA_MODELS d:\ollamamodels /M

在D盘执行按照:

D:\ollama>ollamaSetup.exe /dir=d:\ollama

之后会出现安装界面,点击install后就直接安装于D盘:

安装完成后可以执行ollama -v来查看安装的版本号。

2、deepseek-r1:8B的部署

接下来就可以在Ollama官网平台根据自己的要求选择对应的模型,由于我使用的是联想的游戏本,配置大致如下(仅供参考):

CPU:AMD Ryzen 7 4800H (8核16线程)

内存:DDR4 16G (3200MHz)

GPU:NVIDIA GTX 1650TI 4G

该配置跑8B模型完全够用,运算速度在10tokens/s左右。

执行ollama pull deepseek-r1:8B就开始下载,这里没有使用run而是pull,是因为只进行下载,并没有执行启动,同时下载如果遇到网络问题,按crtl+c可以停止下载,同时下载会继续缓存,重新执行下载就可以。提示:确保C盘有足够的缓存空间,避免下载空间不足导致缓存失败,重新下载后会从0开始

完成下载后就可以run该大模型:

3、使用MSI Afterburner对GPU超频测试

虽然该8B模型在跑时,写代码和方案速度都维持在10tokens/s左右,为此我尝试进行超频,是否可以提供5~15%是性能。虽然超频后温度升高了一点,但是对于跑大模型的运算有点鸡肋,看不出太大的变化。

三、大模型UI界面的创建

在实现deepseek大模型的本地部署后,由于只能通过CMD命令启动,不仅麻烦不美观,还不易于操作和设置,所以需要进行UI界面的优化,使其具有真正用户交互使用的界面。

1、Page Assist 浏览器插件

开源地址: https://github.com/n4ze3m/page-assist

插件支持主流浏览器,edge、chrome、firefox

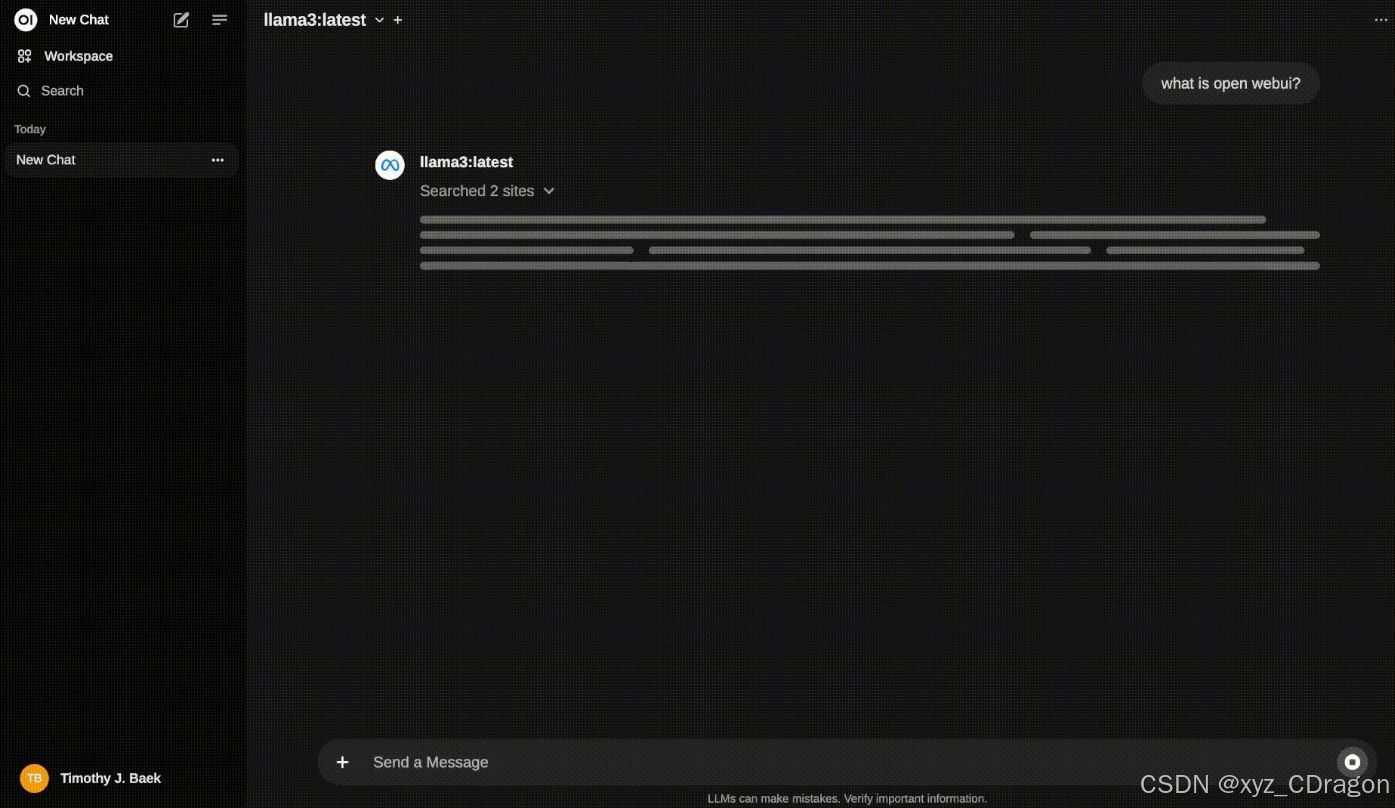

2、Open WebUI

开源地址: https://github.com/open-webui/open-webui

它支持多种 LLM 运行环境,包括 Ollama 和 OpenAI 兼容的 API,并内置了用于 RAG 的推理引擎,是一个强大的 AI 部署解决方案。

3、chatbox

开源地址: https://github.com/Bin-Huang/chatbox

ChatBox是一款开源免费跨平台的 OpenAI API 桌面客户端,支持 Windows、macOS 和 Linux。它支持自定义 KEY 和 API Host 地址,还能帮你在本地保存所有的聊天记录,并且可以管理多个会话,并设置不同的 Prompt,让 AI 化身各种不同用途的多功能助理。

4、cherry studio

开源地址: https://cherry-ai.com/

Cherry Studio AI 是一款强大的多模型 AI 助手,支持 iOS、macOS 和Windows 平台。快速切换多个先进的 LLM 模型,提升工作学习效率。

我使用的是cherry studio,一次性配置添加本地部署的deepseek-r1:8B模型,可以正常运行,之前使用的chatbox,在部署完成后,无法使用,会出现无法访问的问题。可以根据自己的需求选择好UI界面后,添加本地部署的大模型就可以,其它UI界面大家可以测试一下。

四、防火墙规则访问权限设置

1、端口漏洞

如下是CNDV公布的安全公告:

基于该存在的漏洞,后续的Ollama版本在更新时可能解决该漏洞问题,但是为了以防万一,建议还是设置防火墙规则以限制访问权限,或通过其它方式限制端口的访问。对应Ollama的漏洞问题,可以参考该博客: 警惕!你Ollama部署的模型正在被白嫖

2、防火墙规则权限设置

1、添加入站规则,允许 Ollama 端口的流量。

2、添加出站规则,允许 Ollama 访问外部网络。

3、检查规则优先级,确保 Ollama 的规则优先级高于其他冲突规则。

4、验证防火墙规则,确保 Ollama 可以正常运行。

这种方法可以有效提高 Ollama 的安全性,同时确保其正常运行。

当然,还可以测试其它方法,如:网络层隔离限制监听地址,反向代理鉴权等等。

总结

本次的从D盘按照过程,可以根据使用情况设置不同的安装路径,方便Ollama的本地部署,同时可以根据自己的使用情况配置对应deepseek模型,以方便流畅使用,同时也要注意大模型的安全访问,确保正常使用的同时防止数据的泄露和窃取。作为个人智囊团的大模型,不仅提高工作效率,也为我们开辟另外一条学习路径,但是作为工具,始终具有利弊。我们始终还是需要根据自己的想法选择,而不是跟着大模型的方向,这样才可以更好利用大模型提升自己。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)