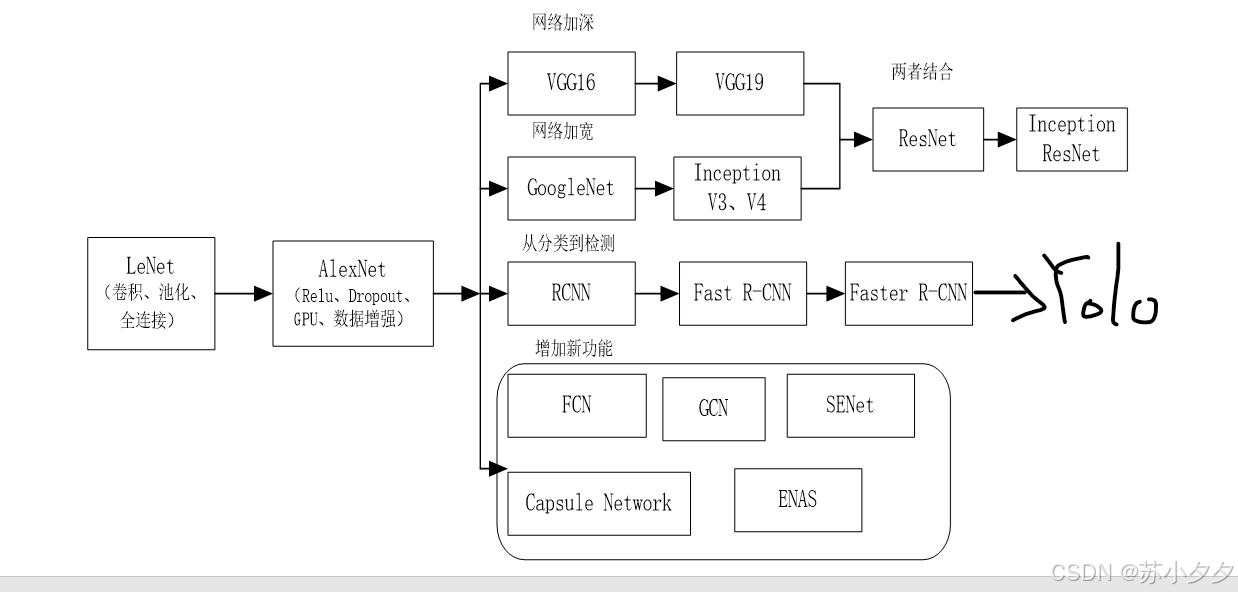

图像识别技术与应用(五)

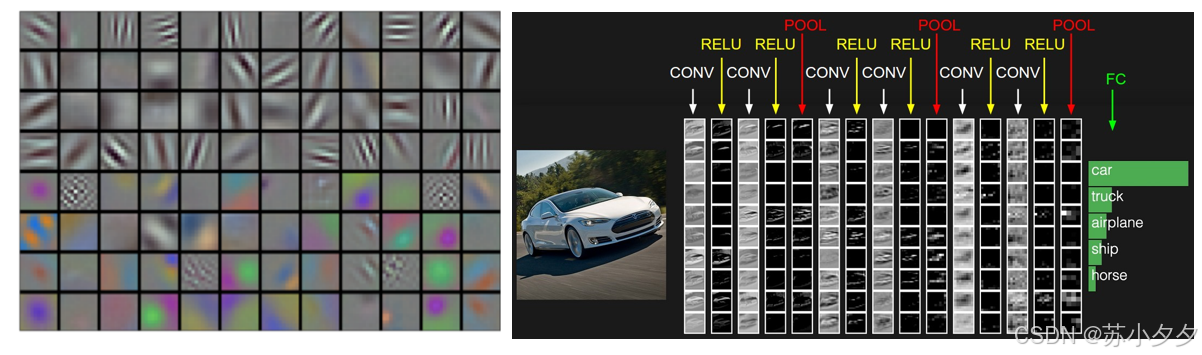

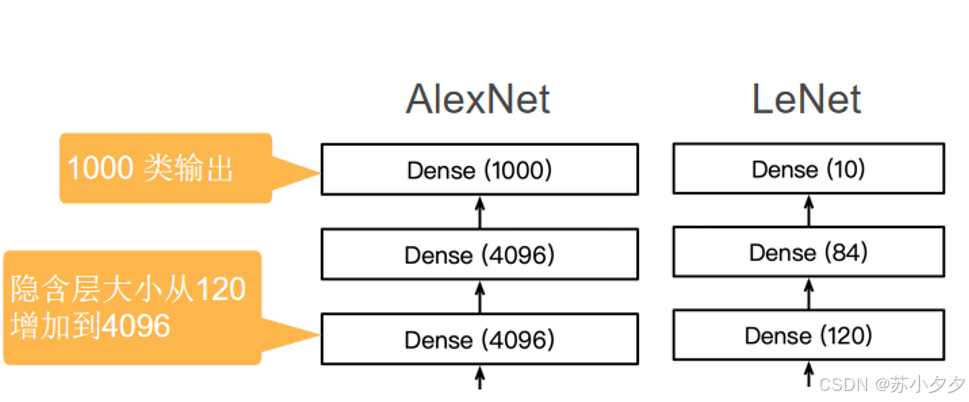

通过构建具有一定“深度”的模型,可以让模型来自动学习好的特征表示(从底层特征,到中层特征,再到高层特征),从而最终提升预测或识别的准确性。全连接层:在卷积层和池化层之后,是3个全连接层,前两个全连接层有4096个神经元,最后一个全连接层的神经元数量根据具体的分类任务而定。可根据数据的复杂度,进行居中和缩放,一共有50000个训练数据,10000个测试数据,图像大小是28*28,一共有10类(0-9

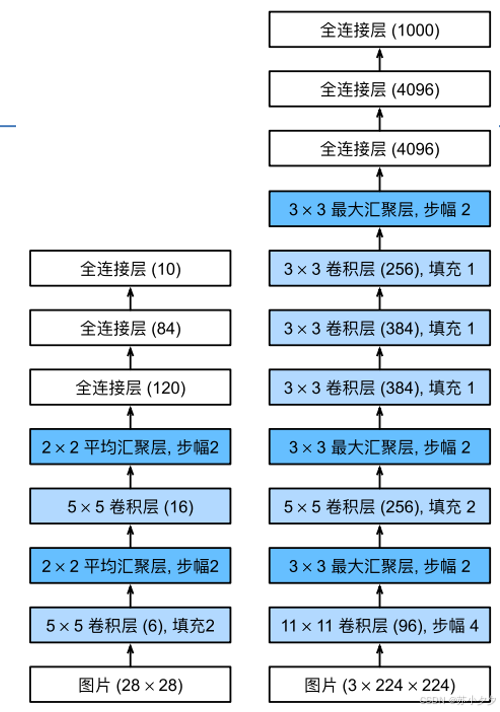

LeNet架构

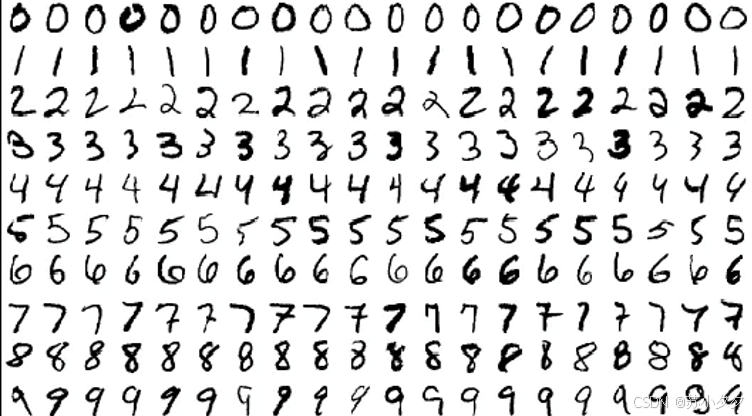

用于手写的数字识别(灰色)

可根据数据的复杂度,进行居中和缩放,一共有50000个训练数据,10000个测试数据,图像大小是28*28,一共有10类(0-9)

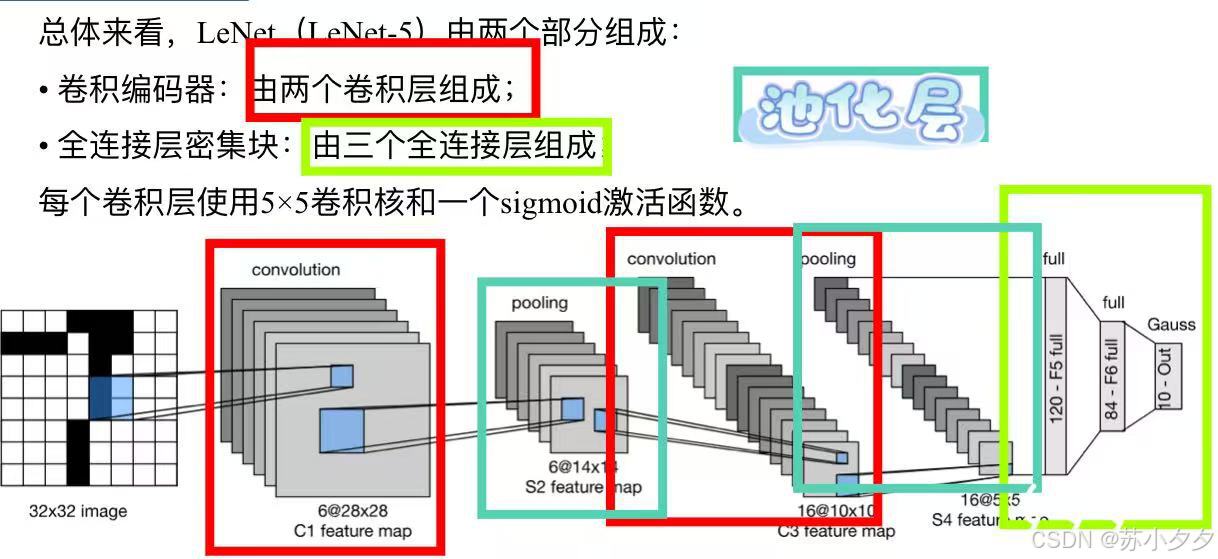

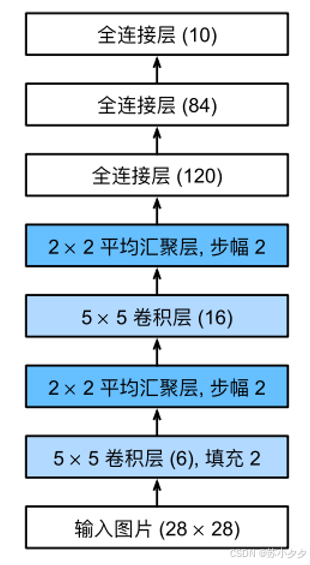

LeNet架构(LeNet-5)

由两部分组成:

卷积编码层:由两个卷积层组成

全连接层密集块:由三个全连接层构成

每个卷积层使⽤5×5卷积核和一个sigmoid激活函数

图像本身像素为32*32

卷积层的像素跟输出的图像像素保持一致,像素为 32-5+1=28,所以像素为28*28

池化层的数量是由前面几个图像,随机删除一些图像后并进行缩小

卷积层数量变成16个,像素为 14-5+1=10 所以像素为10*10

池化层是5层,随机删除一些图像并进行缩小

最后是三个全连接层,三个全连接层是进行整合,运用线性回归的方式进行相连,整合目前所提取的特征,并输出

(注:池化层只是用来删除,这里的池化是平均池化)

网络的深度与网络的模型复杂度成正比,深度是用来衡量网络的复杂度,同时也用来匹配。

学习表征

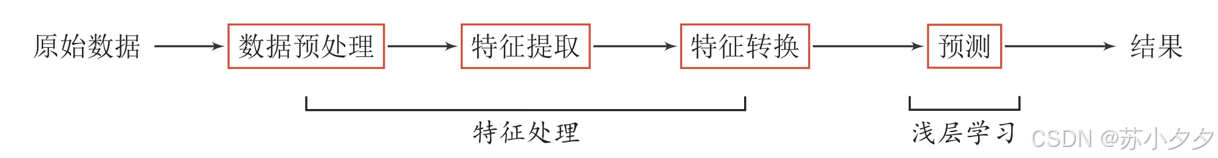

原始数据:获取的三种方式(1爬取数据。2.可以直接使用现有的数据(开源的数据集)。3.可以自己进行采集数据)

数据预处理:表格形式的使用numpy、pandas等进行处理

特征提取:在卷积层进行实现

浅层学习:不涉及特征学习,其特征主要靠人工经验或特征转换方法来抽取

表示学习:如果有一种算法可以自动地学习出有效的特征,并提高最终机器学习模型的性能,那么这种学习就可以叫作表示学习

通常需要从底层特征开始,经过多步非线性转换才能得到。

通过构建具有一定“深度”的模型,可以让模型来自动学习好的特征表示(从底层特征,到中层特征,再到高层特征),从而最终提升预测或识别的准确性。

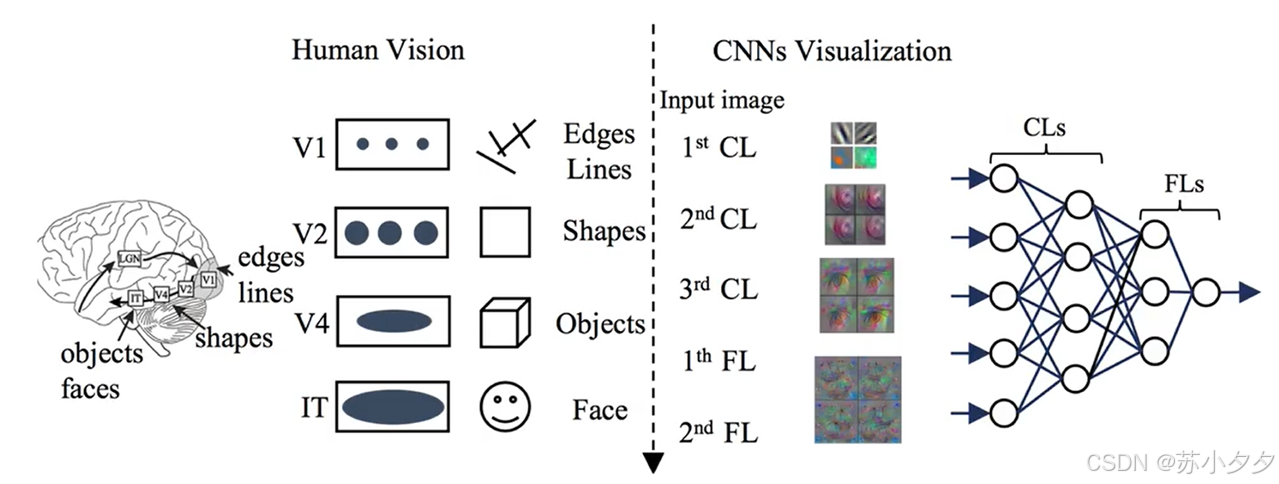

视觉分层理论

从底层到高层的不断抽象

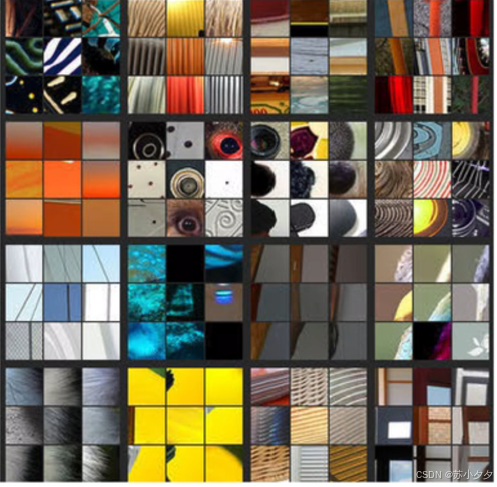

浅层卷积核提取:边缘、颜色、斑块等底层像素特征。

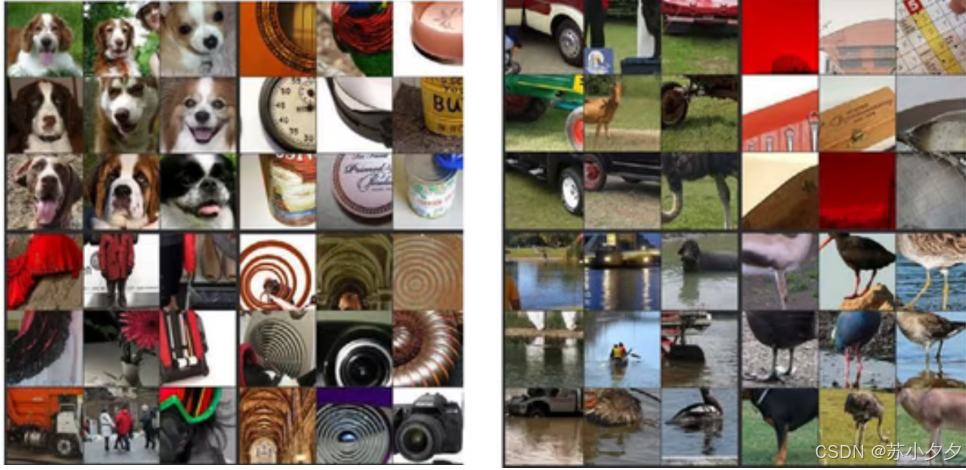

中层卷积核提取:条纹、纹路、形状等中层纹理特征。

高层卷积核提取:眼睛、轮胎、文字等高层语义特征。

在风格方面的图片,选用浅层卷积核提取;在内容方面的图片,浅层中层高层都要提取,但可以自行设置所对应的权重。

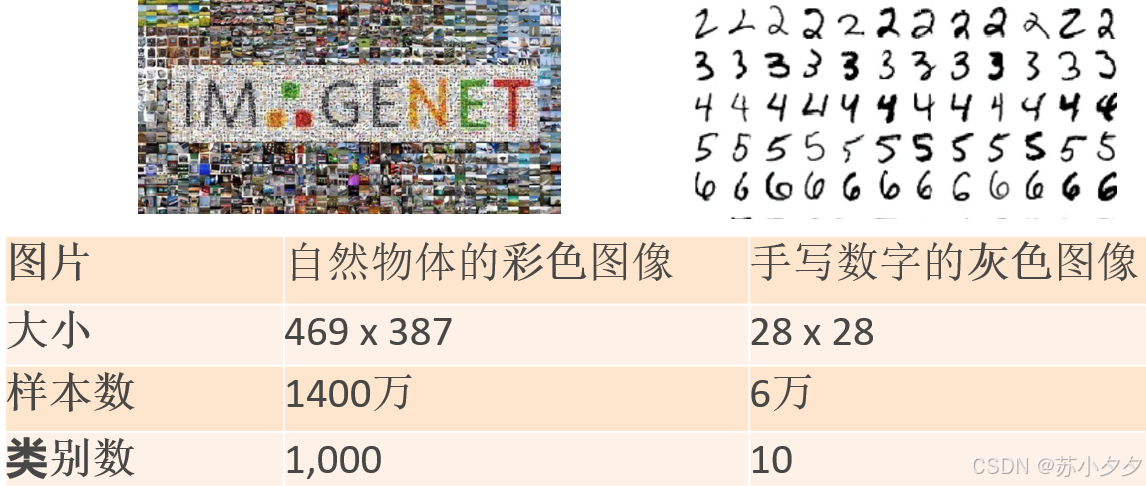

ImageNet 数据集 (2010)

ImageNet数据集相对于LeNet,图片由灰色变为彩色,数据大小、样本数、类别数也相对高出不少。

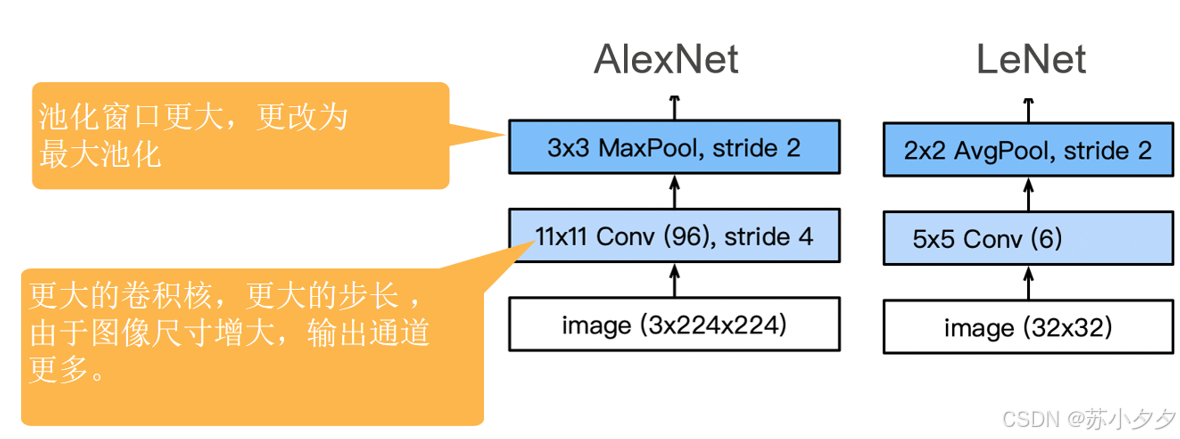

AlexNet

AlexNet 在 2012 年赢得了ImageNet 竞赛,是属于更深更大的 LeNet

主要修改

丢弃法(防止过拟合)(随机丢弃神经元)

ReLu 激活函数(训练)(左边y=0,右边y=x)

最大池化法

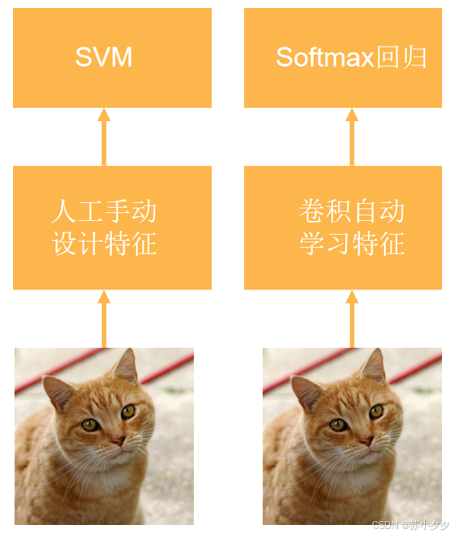

计算机视觉的范式转变

SVM(支持向量机):是一种有监督的机器学习算法。

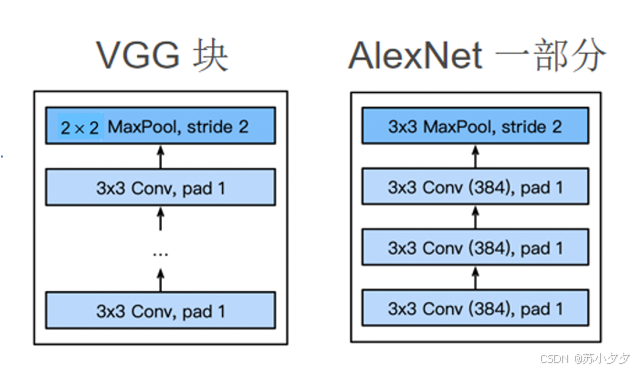

二者对比:AlexNet的池化窗口更大,拥有更大的卷积核、更大的步长、更多的输出通道

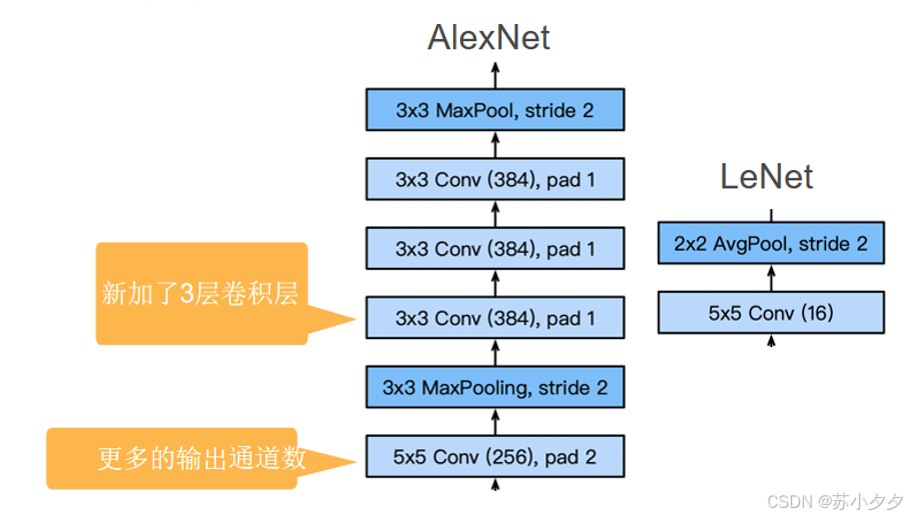

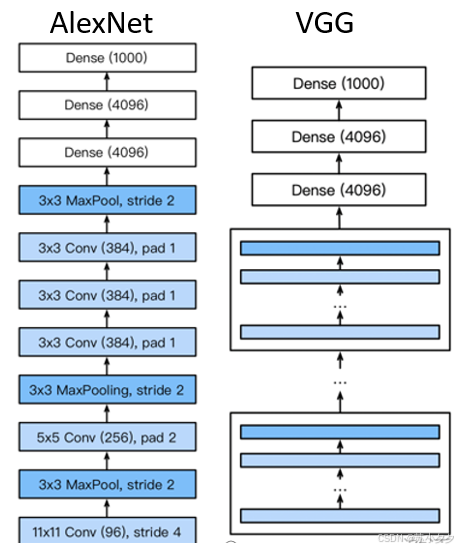

1. AlexNet比相对较小的LeNet5要深得多。AlexNet由⼋层组成:五个卷积层、两个全连接隐藏层和一个全连接输出层。

2. AlexNet使⽤ReLU⽽不是sigmoid作为其激活函数。

更多细节

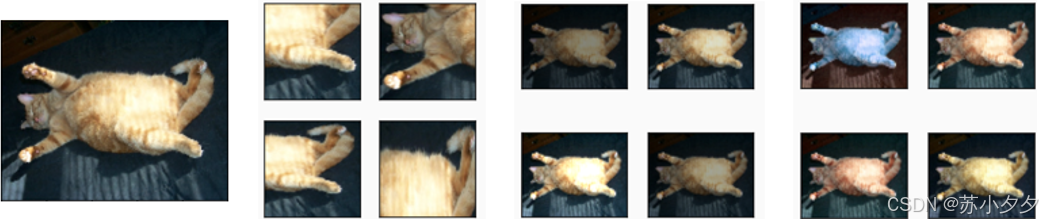

原图 -> 截取部分 -> 调整亮度 -> 调整对比度

1.将激活函数从sigmoid更改为ReLu(减缓梯度消失:参数过小,在每次更新时几乎不会移动,导致模型无法学习)

2.在两个隐含层之后应该使用丢弃法(更好的稳定性/正则化)

3.数据增强

(梯度爆炸:参数更新过大,破坏了模型的稳定收敛)

总结

1.AlexNet的架构与LeNet相似,但使⽤了更多的卷积层和更多的参数来拟合大规模的ImageNet数据集。

2.今天,AlexNet已经被更有效的架构所超越,但它是从浅层⽹络到深层网络的关键一步。

3.新加入了Dropout、ReLU、最大池化层和数据增强

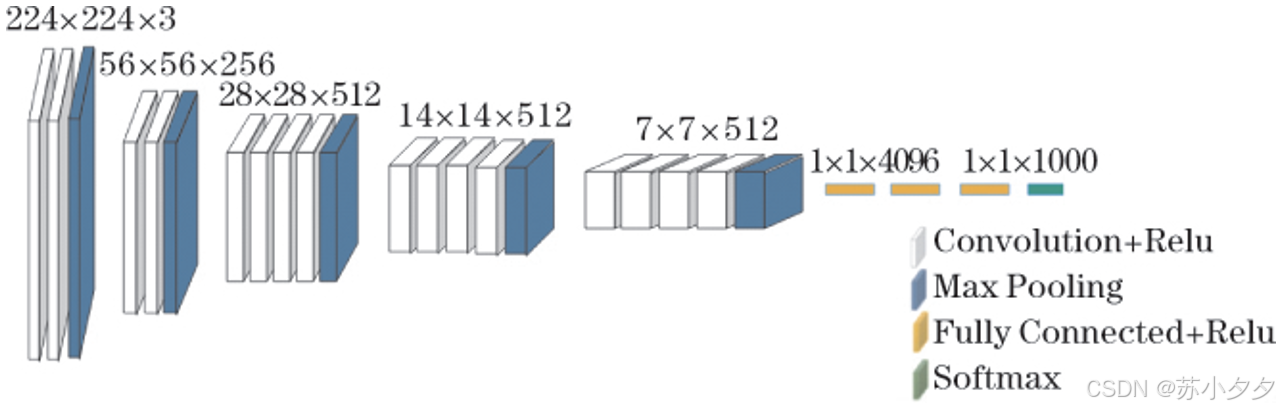

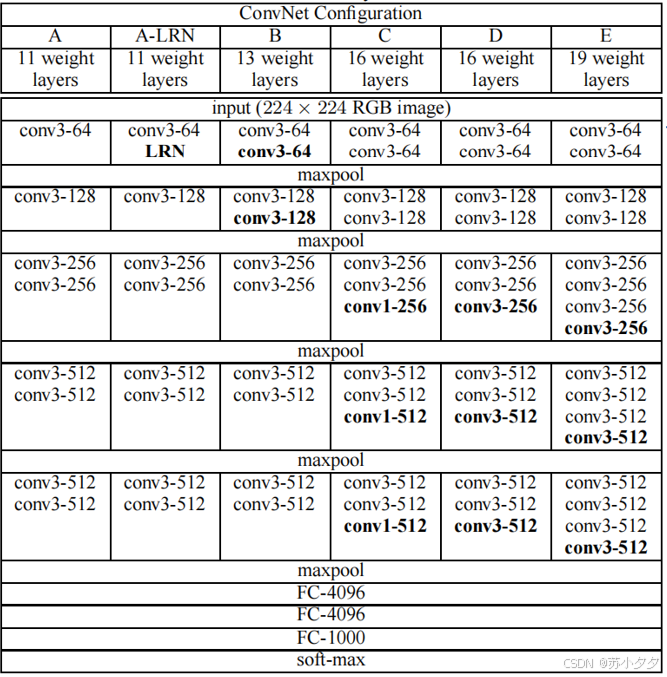

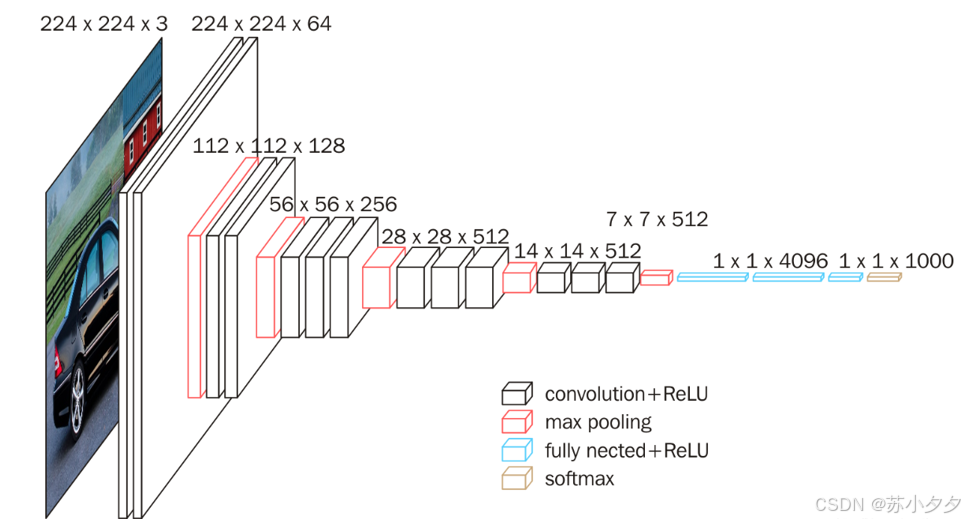

VGG网络

VGG网络分为VGG19、VGG16(以上图为VGG19),VGG19是有16个卷积层和3个全连接层,此外,还有5个最大池化层分布在不同的卷积层中。

VGG块

3*3卷积(填充为1)(n层,m个通道)

2*2最大池化层(步幅为2)

激活函数:ReLu激活函数

VGG架构

多个VGG块后加全连接层

VGG使用可重复使用的卷积块来构建深度卷积神经网络

卷积层:有多个卷积层,每个VGG块包含多个3*3的卷积层

池化层:在卷积层之间或之后,是最大池化层,池化核大小为2*2,步长为2

全连接层:在卷积层和池化层之后,是3个全连接层,前两个全连接层有4096个神经元,最后一个全连接层的神经元数量根据具体的分类任务而定

VGG网络

不同次数的重复VGG块,可获得不同的架构,例如VGG-16,VGG-19,......

例:

VGG16:有13个卷积层和3个全连接层

VGG19:有16个卷积层和3个全连接层

VGG16

发展

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)